Elastic and AWS Serverless Application Repository (SAR): Schneller umsetzbare Einblicke gewinnen mit reibungsloser Log-Ingestion aus Amazon S3

Wenn Unternehmen die Cloud-Plattform und die Dienste von Amazon Web Services (AWS) nutzen, um ihre betriebliche Effizienz zu steigern und Produkte auf den Markt zu bringen, werden die entsprechenden Logs oft in einem Amazon Simple Storage Service (Amazon S3) gespeichert und dann an eine externe Überwachungs- und Analyselösung übermittelt. AWS-Nutzer können ihre in Amazon S3 gespeicherten Logs jetzt mit dem Elastic Serverless Forwarder, einer AWS-Lambda-Anwendung, mühelos ingestieren und anschließend zusammen mit anderen Logs und Metriken als zentralisierte Analyse im Elastic Stack anzeigen.

Überspringen Sie langwierige Prozesse wie etwa das Bereitstellen einer VM oder die Installation von Data Shippers, und reduzieren Sie den Verwaltungsaufwand, indem Sie die Daten direkt aus AWS nach Elastic ingestieren.

In diesem Blogeintrag zeigen wir Ihnen, wie Sie den Elastic Serverless Forwarder, der im AWS Serverless Application Repository (SAR) veröffentlicht wurde, nutzen können, um Ihre Architektur zu vereinfachen und Ihre Logs an Elastic zu senden, um Ihre Multi-Cloud- und lokalen Umgebungen zu überwachen und zu schützen.

Überwachen Sie den Zustand und die Performance Ihrer AWS-Umgebung.

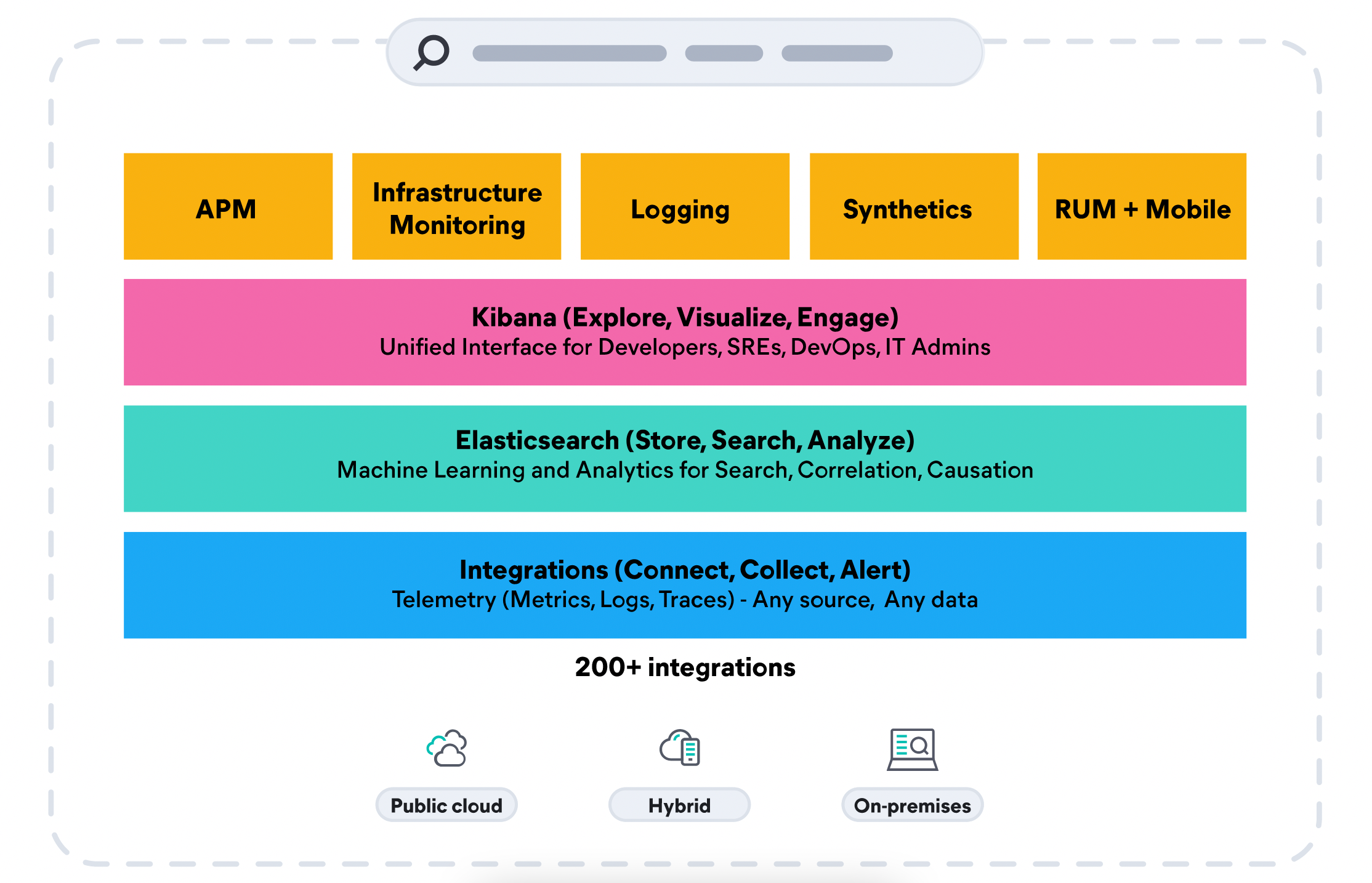

Angesichts zunehmend komplexer hybrider und Multi-Cloud-Ökosysteme ist es wenig überraschend, dass Observability laut einer Studie der Enterprise Management Associates (EMA) Group nach wie vor als kritische Geschäftsinitiative und als wichtigste Herausforderung für DevOps-Teams gilt. Da viele Organisationen Technologien von Containern bis hin zu serverlosem Computing nutzen, um Produkte schneller auf den Markt zu bringen und ihren Mehraufwand zu reduzieren, ist es wichtig, eine Observability-Lösung einzusetzen, die sämtliche Architekturen abdeckt. Laut einer EMA-Studie können Teams, die eine umfassende Observability-Lösung einsetzen, um 70 % kürzere Entwicklungszeiten sowie schnellere Produktzyklen erzielen und das Vierfache an Features unterbringen.

Elastic Observability vereinheitlichet Logs, Metriken und APM-Traces zu einer kompletten, kontextbezogenen Ansicht Ihrer AWS-Hybridumgebungen zusammen mit lokalen Datensätzen in großem Umfang und in einem einzigen Stack. Messen Sie die Performance und überwachen Sie vielfältige AWS-Dienste, wie etwa AWS Lambda, Amazon Elastic Compute Cloud (EC2), Amazon Elastic Container Service (ECS), Amazon Elastic Kubernetes Service (EKS), Amazon S3 und viele weitere Dienste.

Versetzen Sie Ihre Sicherheitsteams in die Lage, Bedrohungen schnell und im Cloud-Maßstab abwehren zu können.

Eine von Forrester in Auftrag gegebene Studie hat gezeigt, dass Kunden mit der Kombination der Elastic Security- und Observability-Lösungen Kosteneinsparungen von bis zu 75 % erzielen, und zwar bis zu zehnmal schneller als mit alternativen Lösungen. Mit dem Elastic Common Schema und einer Architektur mit einem einzigen Repository können dieselben Observability-Daten aus Amazon S3 und andere Datensätze auch für erweiterte Erkennung und Abwehr (eXtended Detection and Response, XDR) verwendet werden, um die Erkennungszeit gegen null zu reduzieren. Elastic Security vereint SIEM und Endpoint-Security, damit Organisationen große Datenbestände aus verschiedenen Quellen ingestieren und aufbewahren, Daten länger speichern und durchsuchen und ihre Bedrohungsabwehr mit Erkennungsregeln und Machine Learning verbessern können. Eliminieren Sie Datensilos, reduzieren Sie die Alarmmüdigkeit und helfen Sie Ihrer Organisation, Bedrohungen in der IT-Umgebung schnell abzuwehren.

Kosteneffektive Datenspeicherung für schnellen Abruf und zukünftige Analysen

Es gibt noch eine weitere Möglichkeit, Ihr Amazon S3 kosteneffizient zu nutzen. Mit Elastic können Organisationen nicht nur ihre in S3 gespeicherten Logs ingestieren, sondern auch große Mengen an historischen Daten vollständig aktiv und durchsuchbar in kostengünstigen Speicherlösungen wie Amazon S3 aufbewahren. Bewahren Sie Ihre AWS- und lokalen Daten mit beliebiger Granularität und über beliebige Zeiträume auf und skalieren Sie später parallel zum Datenwachstum. Datenverwaltung und Tiering werden mit Index-Lifecycle-Management- und automatische Skalierungsfunktionen automatisiert und an die Anforderungen der Organisation im Hinblick auf Datenleistung, Resilienz und Aufbewahrungsdauer angepasst.

Vereinfachte Dateningestion

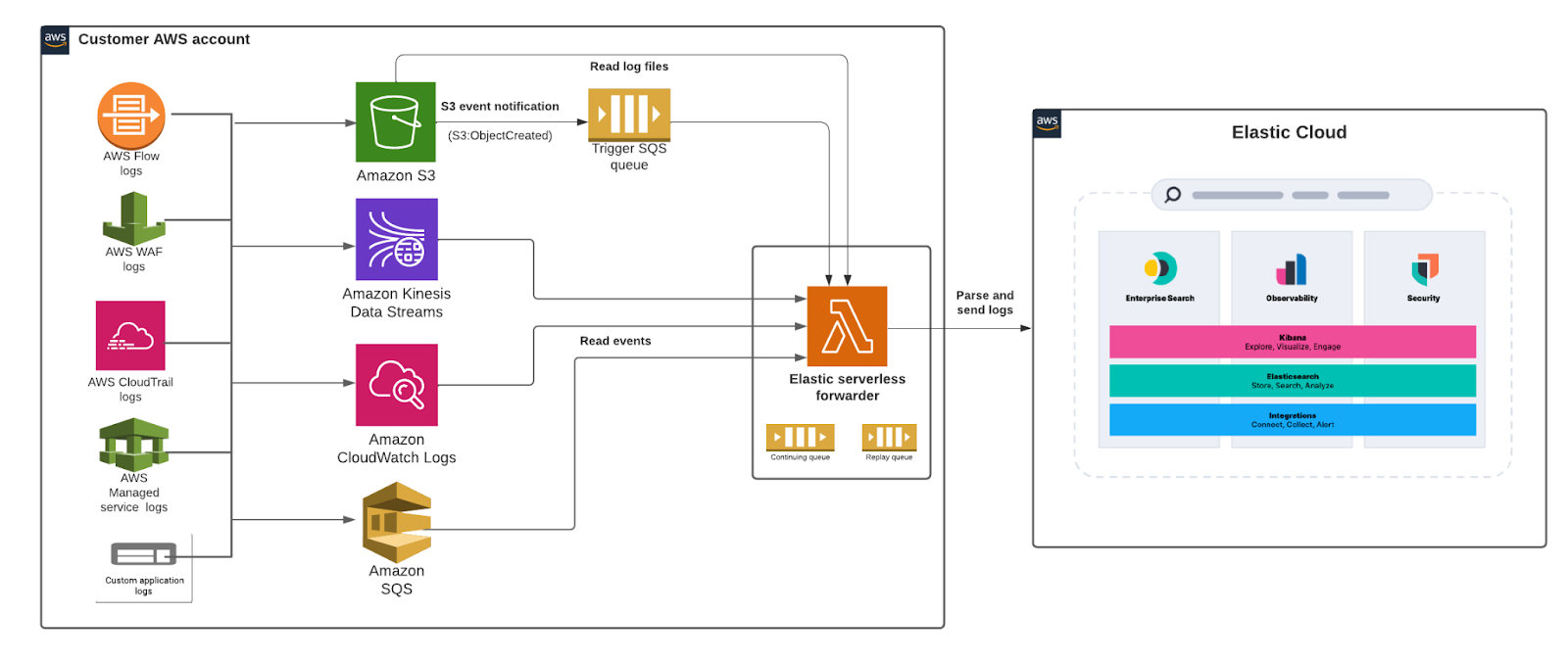

Mit dem als Lambda-Anwendung implementierten Elastic Serverless Forwarder können Sie die im Amazon S3-Bucket enthaltenen Logs ingestieren und an Elastic übermitteln. Die Ereignisbenachrichtigung für die SQS-Warteschlange in Amazon S3 dient als Auslöser für die Lambda-Funktion. Wenn eine neue Log-Datei in einen Amazon S3-Bucket geschrieben wird und die Kriterien erfüllt, wird eine Benachrichtigung generiert, um die Lambda-Funktion auszulösen.

Nutzer können den SQS-Funktionsauslöser in ihrem S3-Bucket einrichten und die Elastic-Verbindungsinformationen angeben, um die Logs zu übermitteln und die vorab erstellten Dashboards sowie sämtliche Analysefunktionen in Kibana zu nutzen und ihren Log-Daten Leben einzuhauchen.

Architekturdiagramm:

Erste Schritte

In diesem Abschnitt sehen wir uns Schritt für Schritt an, wie Sie den Elastic Serverless Forwarder einrichten können, um Ablauf-Logs aus Amazon Virtual Private Cloud (Amazon VPC) im Elastic Stack zu analysieren.

Weitere ausführliche Anweisungen finden Sie in der Dokumentation zum Elastic Serverless Forwarder.

Mit dem Ingestieren Ihrer Ablauf-Logs aus Amazon VPC in Elastic können Sie den Netzwerkverkehr in Ihrem Amazon VPC überwachen und analysieren und fundierte Entscheidungen treffen, indem Sie:

- Daten aus Ablauf-Logs in Kibana analysieren und die Logs mühelos durchsuchen, anzeigen und filtern

- Sicherheitsgruppenregeln bewerten und Sicherheitslücken aufdecken

- Alarmmeldungen einrichten, wenn bestimmte Datenverkehrstypen erkannt werden

- Latenzprobleme identifizieren und Referenzwerte ermitteln, um für eine einheitliche Leistung zu sorgen

Vorbereitung

- Falls Sie noch nicht mit Elastic arbeiten, erstellen Sie ein Deployment in unserem gehosteten Elasticsearch Service in Elastic Cloud. Das Deployment verwendet einen Elasticsearch-Cluster zum Speichern und Durchsuchen Ihrer Daten sowie Kibana, um die Daten zu visualisieren und zu verwalten. Weitere Informationen finden Sie unter Spin up the Elastic Stack (Elastic Stack einrichten, in englischer Sprache).

- Aktivieren Sie die Übermittlung der AWS VPC Ablauf-Logs an einen S3-Bucket. Falls Sie keine solche Umgebung haben, können Sie mühelos einen S3-Bucket erstellen und VPC-Ablauf-Logs an diesen Bucket senden. Führen Sie dazu die folgenden Schritte aus:

- S3-Bucket erstellen (Beispiel: vpc-flow-logs)

- Wählen Sie in der EC2- Konsole bestimmte Netzwerkschnittstellen und im Menü „Action“ die Option „create flow log“ (Ablauf-Log erstellen) aus. Wählen Sie den S3-Bucket, den Sie in den vorherigen Schritten erstellt haben, als Ziel aus. Weitere Informationen finden Sie in der AWS-Dokumentation.

- Im nächsten Schritt erstellen wir eine einfache SQS-Warteschlange (Beispiel: flow-logs-queue) und richten eine passende Zugriffsrichtlinie ein, um die S3-Ereignisbenachrichtigungen aus S3 an die Warteschlange zu senden. Konfigurieren Sie den S3-Bucket (vpc-flow-logs) so, dass Ereignisbenachrichtigungen für alle „create events“-Objekte an die SQS-Warteschlange (flow-logs-queue) gesendet werden. Weitere Informationen finden Sie in der AWS-Dokumentation.

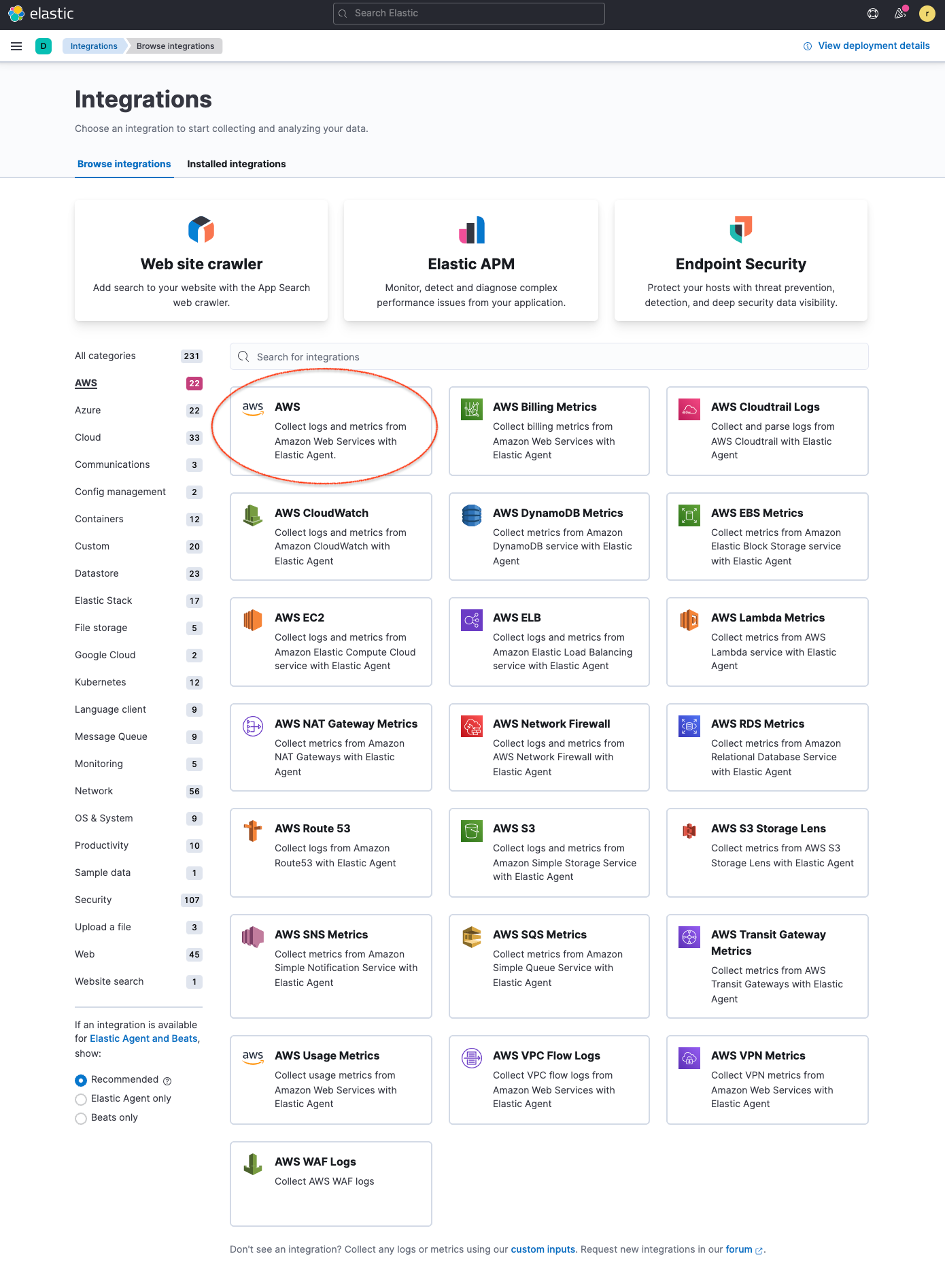

- Anschließend beginnen Sie mit der Installation der Elastic-AWS-Integration direkt in der Kibana-Weboberfläche. Dort finden Sie vordefinierte Dashboards, Ingestions-Knotenkonfigurationen und weitere Assets, mit denen Sie die ingestierten Logs optimal nutzen können. Navigieren Sie in Kibana zu Integrationen und suchen Sie nach AWS. Klicken Sie auf die AWS-Integration, um weitere Details anzuzeigen, wählen Sie Settings (Einstellungen) aus und klicken Sie auf Install AWS assets (AWS-Assets installieren), um die Assets der AWS-Integration zu installieren.

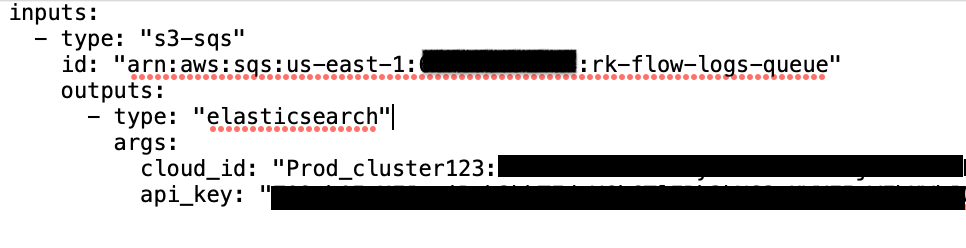

5. Als Nächstes erstellen wir einen neuen S3-Bucket und eine Konfigurationsdatei, die der Elastic Serverless Forwarder nutzen wird, um die Eingabequelle und die Elastic-Verbindung für Zielinformationen auszulesen.

.png)

Hier ist ein Beispiel für eine solche Konfigurationsdatei:

Öffnen Sie Elastic Cloud und kopieren Sie die Cloud ID aus der Elastic Cloud-Konsole in den Parameter „cloud_id“. Navigieren Sie zu Kibana, erstellen Sie einen Base64-kodierten API-Schlüssel für die Authentifizierung und geben Sie ihn im Parameter „api_key“ an. Wir empfehlen, alle sensiblen Daten im AWS Secrets Manager zu speichern und in der Konfigurationsdatei darauf zu verweisen.

6. Stellen Sie den Elastic Serverless Forwarder in AWS SAR bereit und stellen Sie die entsprechenden Konfigurationen für die Lambda-Funktion bereit, um mit dem Ingestieren der VPC-Ablauf-Logs in Elastic zu beginnen.

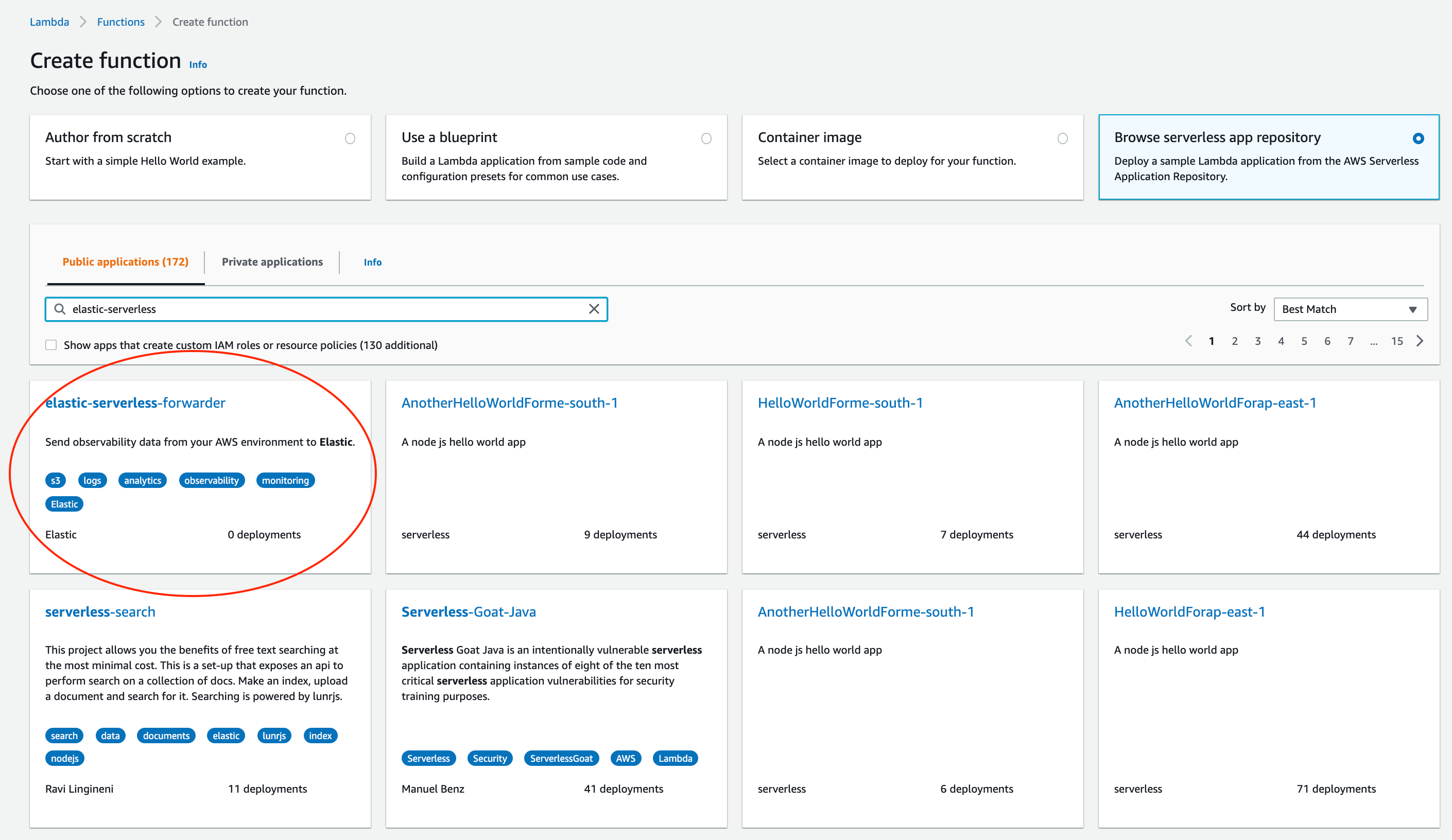

Wählen Sie in der Lambda-Konsole Functions->Create a function (Funktionen->Funktion erstellen) aus, suchen Sie unter Browse serverless app repository (Repository für serverlose Apps durchsuchen) nach elastic-serverless-forwarder und wählen Sie die Anwendung aus.

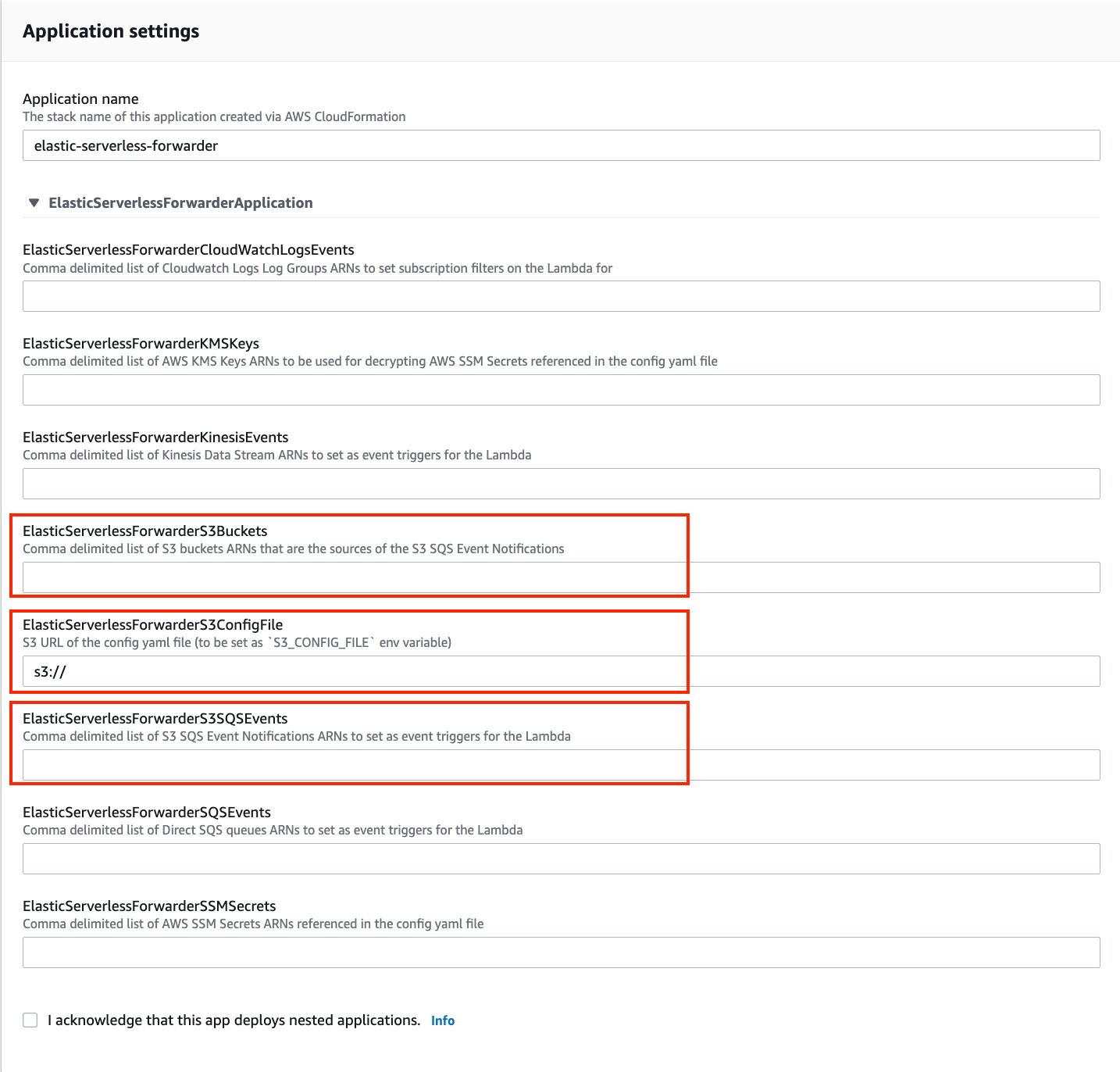

Füllen Sie auf der Seite Review, configure and deploy (Überprüfen, konfigurieren und bereitstellen) für die Anwendung die folgenden Felder aus:

- Geben Sie unter ElasticServerlessForwarderS3Buckets den S3-Bucket an, an den die VPC-Ablauf-Logs gesendet werden. Verwenden Sie den ARN des S3-Buckets, den Sie in Schritt 2 erstellt haben.

- Geben Sie den Pfad der Konfigurationsdatei unter ElasticServerlessForwarderS3ConfigFile an. Verwenden Sie die S3-URL im Format „s3://Bucketname/NamederKonfigurationsdatei“, um auf die Konfigurationsdatei (sarconfig.yaml) zu verweisen, die Sie in Schritt 5 erstellt haben.

- Geben Sie die S3-SQS-Benachrichtigungswarteschlange, die Sie als Auslöser für die Lambda-Funktion verwenden, unter ElasticServerlessForwarderS3SQSEvents an. Verwenden Sie dazu den ARN der SQS-Warteschlange, die Sie in Schritt 3 erstellt haben.

Die oben genannten Werte werden vom Lambda-Deployment verwendet, um minimale IAM-Richtlinien zu erstellen und die Umgebungsvariablen für die ordnungsgemäße Ausführung der Lambda-Funktion zu einzurichten.

Das bereitgestellte Lambda-Deployment liest die VPC-Ablauf-Logs, wenn sie in den S3-Bucket geschrieben werden, und sendet sie an Elastic.

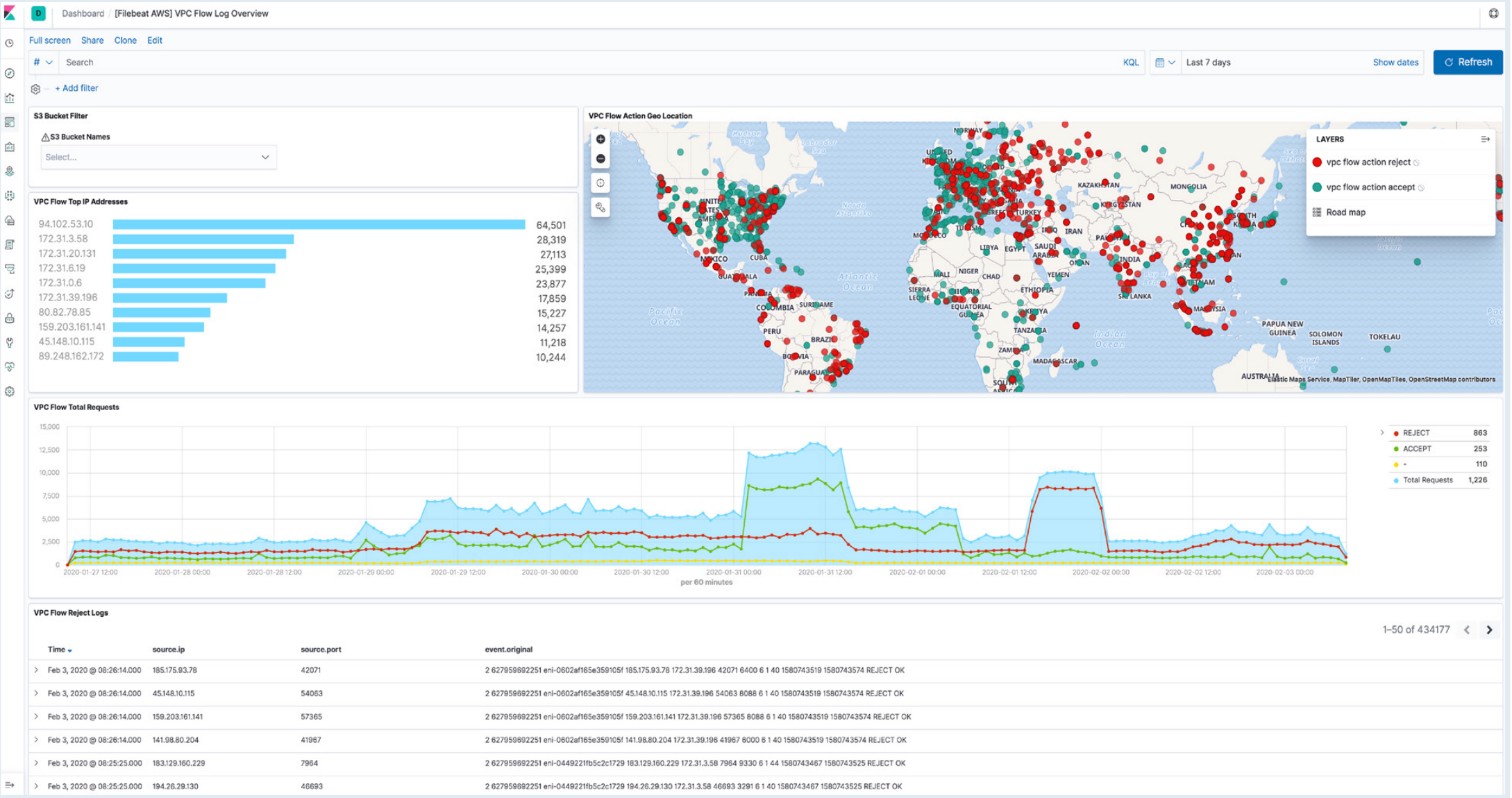

7. Öffnen Sie jetzt Kibana, um sich anzusehen, wie Ihre Logdaten analysiert und im Dashboard [Logs AWS] VPC Flow Log Overview angezeigt werden.

Fazit

Elastic entwickelt ständig neue reibungslose Kundenerlebnisse für ununterbrochenen und ortsunabhängigen Zugriff. Diese optimierte AWS-Integration ist das jüngste Beispiel dafür. Für weitere Informationen besuchen Sie die Dokumentation zum Elastic Serverless Forwarder oder laden Sie die Elastic Observability-Anleitung für AWS herunter.

Jetzt kostenlos ausprobieren

Starten Sie Ihre kostenlose 7-Tage-Testversion, indem Sie sich beim AWS Marketplace anmelden und innerhalb von Minuten ein Deployment in einer der vielen Elastic Cloud-Regionen auf AWS weltweit bereitstellen. Wenn Sie Elastic über den AWS Marketplace erwerben, werden die Kosten über Ihre konsolidierte Monatsabrechnung bei AWS ab- und auf Ihre Mindestabnahmeverpflichtung bei AWS angerechnet.

Die Entscheidung über die Veröffentlichung der in diesem Blogpost beschriebenen Leistungsmerkmale und Funktionen oder deren Zeitpunkt liegt allein bei Elastic. Es ist möglich, dass noch nicht verfügbare Leistungsmerkmale oder Features nicht rechtzeitig oder überhaupt nicht veröffentlicht werden.