Elasticsearch Service로 데이터를 수집하는 방법

Elasticsearch는 데이터 검색과 분석을 위해 보편적으로 사용됩니다. 개발자와 커뮤니티는 애플리케이션 검색과 웹사이트 검색에서부터 로깅, 인프라 모니터링, APM, 보안 분석 등에 이르기까지 가장 다양한 사용 사례를 위해 Elasticsearch를 활용합니다. 현재 이러한 사용 사례를 위해 무료로 제공되는 솔루션이 존재하긴 하지만, 개발자는 우선 데이터를 Elasticsearch로 가져와야 합니다.

이 글에서는 데이터를 Elasticsearch Service로 수집하는 가장 일반적인 방법 몇 가지를 설명해 드립니다. 이것은 Elastic Cloud에서 호스팅되거나 또는 온-프레미스형으로 제공되는 Elastic Cloud Enterprise의 클러스터일 수 있습니다. 이러한 서비스에 중점을 두긴 하지만, 자체관리형 Elasticsearch 클러스터로의 데이터 수집도 거의 동일합니다. 유일하게 다른 점은 클러스터의 주소를 지정하는 방법입니다.

기술적인 세부 사항으로 깊이 들어가기 전에, 이 글을 따라가다가 질문이나 문제가 생기면 주저마시고 discuss.elastic.co를 방문해 주실 것을 부탁드립니다. 활발한 커뮤니티에서 여러 가지 질문에 대한 답변을 찾아보실 수 있을 것입니다.

이제, 다음 방법을 이용한 데이터 수집에 대해 알아보도록 하겠습니다.

- Elastic Beats

- Logstash

- 언어 클라이언트

- Kibana 개발자 도구

Elasticsearch Service로의 수집

Elasticsearch는 클라이언트 애플리케이션과의 통신을 위한 유연한 RESTful API를 제공합니다. 따라서 REST 호출은 데이터를 수집하고, 검색 및 데이터 분석을 수행하고, 클러스터와 그 인덱스를 관리하는 데 사용됩니다. 내부적으로는, 여기에서 설명되는 모든 방법이 이 API에 의지해 데이터를 Elasticsearch로 수집합니다.

이 글의 나머지 부분에서는, 이미 Elasticsearch Service 클러스터를 생성한 상태라고 가정하고 진행하겠습니다. 아직 Elasticsearch Service 클러스터를 생성하지 않으셨다면, Elastic Cloud의 무료 체험판에 등록하세요. 일단 클러스터를 생성하면, Elastic 슈퍼 사용자 계정에 대한 클라우드 ID와 비밀번호를 받게 됩니다. 클라우드 ID는 cluster_name:ZXVy...Q2Zg== 형식입니다. 이제 보시겠지만, 이것은 사용자의 클러스터 URL을 인코딩하고, 클러스터로의 데이터 수집을 간소화합니다.

Elastic Beats

Elastic Beats는 데이터를 편리하게 Elasticsearch Service로 전송할 수 있게 해주는 경량 데이터 수집기 세트입니다. 경량이기 때문에, Beats는 런타임 오버헤드를 많이 발생시키지 않으며, 따라서 IoT 장치, 에지 장치 또는 포함된 장치 등 하드웨어 리소스가 제한되어 있는 장치에서 데이터를 실행하고 수집할 수 있습니다. Beats는 리소스를 많이 사용하는 데이터 수집기를 실행해야 할 필요 없이 데이터를 수집해야 하는 경우 이상적입니다. 네트워크로 연결된 모든 장치에서 이런 종류의 전반적인 데이터 수집을 하면, 예를 들어 시스템 전체에 걸친 문제와 보안 사고를 신속하게 탐지하여 대응할 수 있습니다.

물론 Beats는 리소스에 제약이 있는 시스템에만 국한되지 않으며, 더 많은 하드웨어 리소스가 제공되는 시스템에서도 사용할 수 있습니다.

Beats 제품군: 개요

Beats는 여러 다른 종류의 데이터를 수집하기 위한 다양한 옵션으로 제공됩니다.

- Filebeat는 파일 형식으로 제공되는 소스로부터 데이터를 읽고, 전처리하고, 수집할 수 있게 해줍니다. 대부분의 사용자가 로그 파일을 읽는 데 Filebeat를 사용하긴 하지만, 모든 종류의 넌바이너리 파일 형식이 지원됩니다. 아울러 Filebeat는 TCP/UDP, 컨테이너, Redis, Syslog 등 수많은 다른 데이터 소스를 지원합니다. 풍부한 모듈 덕분에 Apache, MySQL, Kafka 등과 같은 일반적인 애플리케이션을 위한 로그 형식 수집과 구문 분석이 쉬워집니다.

- Metricbeat는 시스템과 서비스 메트릭을 수집하고 전처리합니다. 시스템 메트릭에는 프로세스 실행에 대한 정보와 CPU / 메모리 / 디스크 / 네트워크에 대한 정보가 포함됩니다. 모듈은 Kafka, Palo Alto Networks, Redis 외에도 여러 가지를 포함한 수많은 다른 서비스로부터 데이터를 수집하기 위해 제공됩니다.

- Packetbeat는 라이브 네트워크 데이터를 수집하고 전처리하며, 따라서 애플리케이션 모니터링과 보안, 네트워크 성능 분석 등이 활성화됩니다. 무엇보다도 Packetbeat는 HCP, DNS, HTTP, MongoDB, NFS, TLS 등의 프로토콜을 지원합니다.

- Winlogbeat는 애플리케이션 이벤트, 하드웨어 이벤트, 보안 및 시스템 이벤트 등 Windows 운영 체제로부터 이벤트 로그를 캡처하는 작업을 수행합니다. Windows 이벤트 로그로부터 제공되는 방대한 정보는 수많은 사용 사례에 대해 유용하게 사용될 수 있습니다.

- Auditbeat는 중요한 파일에 이루어지는 변경사항을 탐색하고 Linux Audit Framework로부터 이벤트를 수집합니다. 여러 다른 모듈이 배포를 용이하게 해주며, 이것은 대부분 보안 분석 사용 사례에서 사용됩니다.

- Heartbeat는 검색을 사용해 시스템과 서비스의 가용성을 모니터링합니다. Heartbeat는 따라서 인프라 모니터링과 보안 분석 등과 같은 수많은 시나리오에서 유용합니다. 지원되는 프로토콜은 ICMP, TCP, HTTP입니다.

- Functionbeat는 AWS Lambda와 같은 서버리스 환경 내에서 로그와 메트릭을 수집합니다.

일단 특정 시나리오에서 그러한 Beats 중 어느 것을 사용할지 결정하면, 다음 섹션에서 설명한 대로 쉽게 시작할 수 있습니다.

Beats 시작하기

이 섹션에서는, Metricbeat를 예로 들어 Beats를 시작하는 방법을 소개해 드리려고 합니다. 다른 Beats에 대해서도 이와 아주 비슷한 단계를 실행하면 됩니다. 또한 설명서를 참조하셔서 특정 Beat와 운영 체제에 대한 단계를 따르시기 바랍니다.

- 원하는 Beat를 다운로드하여 설치합니다. Beats를 설치하는 방법은 수없이 많지만, 대부분의 사용자가 운영 체제의 패키지 관리자(DEB/RPM)에 대해 Elastic에서 제공하는 리포지토리를 사용하거나 제공되는 tgz/zip 번들을 그냥 다운로드하여 압축 해제하는 것을 선택합니다.

- Beat를 구성하고 원하는 모듈을 활성화합니다.

- 예를 들어, 시스템에서 실행되는 Docker 컨테이너에 대한 메트릭을 수집하려면, 패키지 관리자를 사용해 설치한 경우,

sudo metricbeat modules enable docker를 이용해 Docker 모듈을 활성화하세요. 대신에 tgz/zip 번들을 압축 해제한 경우,/metricbeat modules enable docker를 사용하세요. - 클라우드 ID는 수집된 데이터를 어디로 전송할지 Elasticsearch Service에 지정해주는 편리한 방법입니다. 클라우드 ID와 인증 정보를 다음과 같이 Metricbeat 구성 파일(metricbeat.yml)에 추가하세요.

cloud.id: cluster_name:ZXVy...Q2Zg==

cloud.auth: "elastic:YOUR_PASSWORD"

- 앞서 언급한 대로, 클러스터를 생성하면

cloud.id가 제공됩니다.cloud.auth는 Elasticsearch 클러스터 내에서 충분한 권한을 부여받은 사용자 이름과 비밀번호가 콜론으로 구분되어 연결된 것입니다. - 신속하게 시작하려면, 클러스터 생성 시에 제공된 Elastic 슈퍼 사용자와 비밀번호를 사용하세요. 패키지 관리자를 사용해 설치한 경우

/etc/metricbeat디렉터리에서, tgz/zip 번들을 사용한 경우 압축 해제된 디렉터리에서 구성 파일을 찾아볼 수 있습니다.

- 미리 패키지된 대시보드를 Kibana에 로드합니다. 대부분의 Beats와 그 모듈은 미리 정의된 Kibana 대시보드와 함께 제공됩니다. 패키지 관리자를 사용하여 설치한 경우 이것을

sudo metricbeat setup을 이용해 Kibana에 로드하고, tgz/zip 번들을 사용한 경우./metricbeat setup을 이용해 압축 해제한 디렉터리에 로드합니다.

- Beat를 실행합니다. 패키지 관리자를 사용해 systemd 기반의 Linux 시스템에 설치한 경우

sudo systemctl start metricbeat를 사용하고 tgz/zip 번들을 사용해 설치한 경우./metricbeat -e를 사용하세요.

모두 예상대로 작동하면, 이제 데이터가 Elasticsearch Service로 흘러가기 시작합니다.

미리 패키지화된 대시보드 탐색

다음과 같이 Elasticsearch Service 내의 Kibana로 이동해 데이터를 검사합니다.

- Kibana Discover 내에서,

metricbeat-*인덱스 패턴을 선택하면 수집했던 개별 문서를 볼 수 있습니다. - Kibana Infrastructure 탭은 시스템 리소스 페이지(CPU, 메모리, 네트워크)에 대한 다른 그래프들을 보여줌으로써 좀더 그래픽적인 방식으로 시스템과 Docker 메트릭을 검사할 수 있게 해줍니다.

- Kibana 대시보드 내에서, [Metricbeat System]이 이름 앞에 붙어있는 대시보드 중 하나를 선택하여 대화형 방식으로 데이터를 탐색합니다.

Logstash

Logstash는 모든 종류의 데이터를 읽고, 처리하고, 전송할 수 있는 강력하고 유연한 도구입니다. Logstash는 외부 데이터 소스에 대한 조회를 수행함으로써 문서를 보강하는 등 현재 제공되지 않는 또는 Beats를 수행하기에 너무 비용이 많이 드는 수많은 기능들을 제공합니다. 그러나, Logstash의 이 기능과 유연성에는 대가가 따릅니다. 또한, Logstash를 위한 하드웨어 요건은 Beats보다 훨씬 더 높습니다. 따라서, Logstash는 리소스가 적은 장치에서는 일반적으로 배포되어서는 안됩니다. Beats의 기능성이 특정 사용 사례에 대해 불충분한 경우, Logstash가 Beats의 대안으로 사용됩니다.

일반적인 아키텍처 패턴은 Beats와 Logstash를 결합하는 것입니다. Beats를 사용해 데이터를 수집하고, Logstash를 사용해 Beats가 할 수 없는 모든 데이터 처리를 수행합니다.

Logstash 개요

Logstash는 이벤트 프로세싱 파이프라인을 실행함으로써 작동하며, 이로써 각 파이프라인은 최소한 다음이 각각 하나씩 포함되어 구성됩니다.

- 입력은 데이터 소스로부터 읽습니다. 파일, http, imap, jdbc, kafka, syslog, tcp, udp 등 수많은 데이터 소스가 공식 지원됩니다.

- 필터는 다양한 방법으로 데이터를 처리하고 보강합니다. 많은 경우, 비구조적 로그 줄은 먼저 좀더 구조적인 형태로 구문 분석되어야 합니다. Logstash는 따라서 수많은 것들 중에도 정규식을 기반으로 CSV, JSON, 키/값 쌍, 분리된 비구조적 데이터, 복잡한 비구조적 데이터를 구문 분석하기 위한 필터(Grok 필터)를 제공합니다. Logstash는 아울러 DNS 조회를 수행하고, IP 주소에 대한 위치 정보를 추가하거나 사용자 정의 사전 또는 Elasticsearch 인덱스에 대한 조회를 수행함으로써 데이터를 보강하는 필터를 제공합니다. 추가 필터는 예를 들어 데이터 필드와 값의 이름 바꾸기, 삭제, 복사 등 데이터의 다양한 변환을 감안합니다(필터 변경).

- 출력은 구문 분석되고 보강된 데이터를 데이터 싱크에 작성하며, Logstash 프로세싱 파이프라인의 최종 단계입니다. 수많은 출력 플러그인이 제공되지만, 여기서는 elasticsearch output을 사용하여 Elasticsearch Service로 수집하는 데 중점을 둡니다.

Logstash 샘플 파이프라인

서로 똑같은 사용 사례는 없습니다. 따라서 바로 그 특정한 데이터 입력과 요건에 맞는 Logstash 파이프라인을 개발해야 할 가능성이 큽니다.

샘플 Logstash 파이프라인을 보여드리겠습니다.

- Elastic 블로그 RSS 피드 읽기

- 필드를 복사하고/이름을 바꾸고 특수 문자와 HTML 태그를 삭제하여 데이터의 가벼운 전처리를 일부 수행

- 문서를 Elaticsearch로 수집

그 단계는 다음과 같습니다.

- 패키지 관리자를 통해 또는 tgz/zip 파일을 다운로드하고 압축 해제하여 Logstash를 설치합니다.

- RSS 데이터 소스를 읽을 수 있게 해주는 Logstash rss 입력 플러그인을 설치합니다.

./bin/logstash-plugin install logstash-input-rss를 이용하면 됩니다. - 다음의 Logstash 파이프라인 정의를 ~/elastic-rss.conf 같은 새 파일에 복사합니다.

input {

rss {

url => "/blog/feed"

interval => 120

}

}

filter {

mutate {

rename => [ "message", "blog_html" ]

copy => { "blog_html" => "blog_text" }

copy => { "published" => "@timestamp" }

}

mutate {

gsub => [

"blog_text", "<.*?>", "",

"blog_text", "[\n\t]", " "

]

remove_field => [ "published", "author" ]

}

}

output {

stdout {

codec => dots

}

elasticsearch {

hosts => [ "https://<your-elsaticsearch-url>" ]

index => "elastic_blog"

user => "elastic"

password => "<your-elasticsearch-password>"

}

}

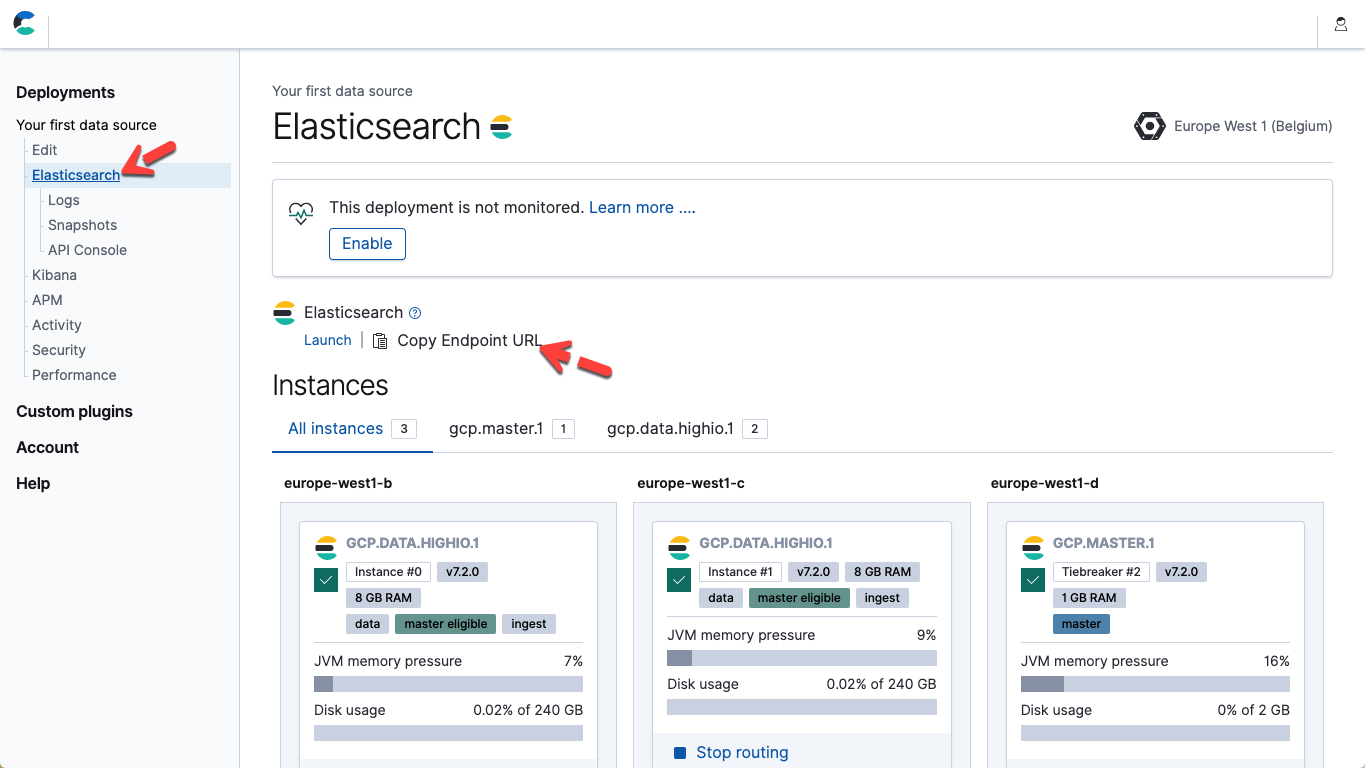

- 위의 파일 내에서, Elasticsearch Service 엔드포인트와 일치하는 매개 변수 호스트 및 비밀번호와 Elastic 사용자를 위한 비밀번호를 수정합니다. Elastic Cloud에서, 배포 페이지의 세부사항으로부터 Elasticsearch 엔드포인트 URL을 얻을 수 있습니다(엔드포인트 URL 복사).

- Logstash를 시작하여 파이프라인을 실행합니다. ./bin/logstash -f ~/elastic-rss.conf를 이용하면 됩니다.

Logstash를 시작하는 데는 몇 초가 걸립니다. 콘솔에 점들(.....)이 인쇄되는 것이 보이기 시작합니다. 각 점은 Elasticsearch로 수집된 하나의 문서를 나타냅니다.

- Kibana를 엽니다. Kibana 개발자 도구 콘솔 내에서, 20개 문서가 수집된 것을 확인하기 위해 POST elastic_blog/_search를 실행합니다.

언어 클라이언트

일부 상황에서는, 사용자 정의 애플리케이션 코드로 데이터 수집을 통합하는 것을 선호합니다. 이를 위해서는 공식적으로 지원되는 Elasticsearch 클라이언트 중 하나를 사용하실 것을 권장합니다. 이러한 클라이언트는 데이터 수집에서 낮은 수준의 세부사항을 추상화하여 사용자가 애플리케이션에 고유한 실제 작업에 집중할 수 있게 해주는 라이브러리입니다. Java, JavaScript, Go, .NET, PHP, Perl, Python, Ruby를 위한 공식 클라이언트가 존재합니다. 모든 세부사항과 코드 사례는 선택하시는 언어를 위한 설명서를 참조하세요. 애플리케이션이 위의 목록에 없는 언어로 되어 있는 경우, 커뮤니티에서 기여한 클라이언트가 있을 가능성이 있습니다.Kibana 개발자 도구

Elasticsearch 개발 및 디버깅 요청을 위해 선택하도록 권장하는 도구는 Kibana 개발자 도구 콘솔입니다. 개발자 도구는 기본 HTTP 요청의 세부사항을 추상화하는 한편 일반 Elasticsearch REST API의 모든 기능과 유연성을 노출시킵니다. 놀랍지 않게도, 개발자 도구 콘솔을 사용하여 원시 JSON 도구를 Elasticsearch로 PUT할 수 있습니다.PUT my_first_index/_doc/1

{

"title" : "How to Ingest Into Elasticsearch Service",

"date" : "2019-08-15T14:12:12",

"description" : "This is an overview article about the various ways to ingest into Elasticsearch Service"

}