Qu'est-ce qu'un robot d'indexation ?

Définition d'un robot d'indexation

Un robot d'indexation est un robot de moteur de recherche numérique qui utilise la copie et les métadonnées pour découvrir et indexer des pages de site. Également connu sous le nom d'araignée, ce robot explore Internet pour apprendre de quoi telle ou telle page traite. Il indexe ensuite les pages et stocke les informations en vue des futures recherches ultérieures.

L'indexation consiste à organiser les données selon un schéma ou une structure spécifique. C'est un processus qui permet au moteur de recherche de faire correspondre des résultats de recherche pertinents à une requête en s'appuyant sur les données indexées. Ainsi, un robot d'indexation est un outil qui facilite l'exploration du web.

Il existe une différence entre les robots d'indexation sur Internet et les robots d'indexation d'entreprise. Un robot d'indexation sur Internet parcourt Internet et repousse de façon continue les frontières de l'exploration en découvrant de nouveaux sites et en les indexant. Un robot d'indexation d'entreprise parcourt le site web d'une entreprise spécifique pour indexer les données de ce site et les rendre consultables dès qu'un utilisateur émet une requête à l'aide de la fonction de recherche du site. Il peut également servir d'outil d'entreprise pour automatiser certaines recherches.

Comment fonctionne un robot d'indexation ?

Un robot d'indexation découvre de nouvelles pages, les indexe, puis stocke les informations en vue d'une utilisation ultérieure. Il peut explorer votre contenu à intervalles réguliers pour s'assurer que les résultats de vos recherches restent à jour et que vous puissiez les consulter.

Découverte et extraction de pages

Pour collecter des informations à partir du plus grand nombre possible de sites ou de pages en ligne, un robot d'indexation passera d'un lien à l'autre sur les pages.

Un robot d'indexation commence avec une URL connue, ou graine, puis découvre de nouveaux sites auxquels il accède à partir des liens qui se trouvent sur cette page. Il répète ce processus encore et encore, cherchant constamment de nouvelles pages. En raison du nombre faramineux de pages en ligne et du fait que les informations soient constamment mises à jour, ce processus peut se poursuivre presque indéfiniment.

Les liens que le robot d'indexation trouve et mémorise pour une future découverte constituent ce qu'on appelle les frontières de l'exploration. Ces liens hypertexte sont ensuite consultés dans un ordre déterminé selon un ensemble de principes ou de règles d'exploration. Parmi ceux-ci, on trouve des principes de sélection, de re-visite, de politesse et de parallélisation.

Un robot d'indexation prendra en compte le nombre d'URL pointant vers une page donnée et le nombre de visites sur cette page, ce dans l'optique de découvrir et d'indexer le contenu important. La logique qu'il applique est la suivante : plus une page est consultée et citée, plus les informations qu'elle contient sont fiables et de haute qualité. Il est donc primordial que le moteur de recherche ait connaissance du site et qu'il puisse en permettre la découverte.

Rendu, téléchargement et indexation des pages

Lorsqu'un robot d'indexation découvre une nouvelle page, il effectue un rendu des informations qu'elle contient, que ce soit au moyen d'une copie du site ou de balises méta, puis il télécharge ces informations et les indexe. Certains robots d'indexation peuvent accéder ou lire uniquement les pages publiques, tandis que d'autres sont autorisés à indexer des pages authentifiées. Ils se conforment également aux exigences des fichiers robots.txt et des balises méta noindex. Un fichier robots.txt est un grand livre de règles pour les pages en ligne, qui détermine les liens qu'un robot doit suivre et définit les informations qu'il peut indexer. Une balise méta noindex indique les éléments qui ne doivent pas être indexés.

Nettoyage et répétition

Le but des robots d'indexation est d'indexer et de télécharger les informations sur des sites spécifiques. Les robots d'indexation repoussent toujours plus les frontières de l'exploration, en recherchant d'autres sites, d'autres pages et des mises à jour. Par conséquent, ils continuent à augmenter le volume de données indexées des moteurs de recherche.

Avec l'aide des araignées, les algorithmes des moteurs de recherche peuvent trier les index créés par les robots d'indexation afin qu'ils puissent être extraits et classés dans les résultats lors d'une requête.

En quoi l'exploration du web est-elle importante ?

L'exploration du web est importante pour les entreprises car elle joue un rôle clé dans la fonctionnalité des moteurs de recherche. En effet, elle permet aux moteurs de recherche d'indexer les informations, en sachant quels sites et pages existent, afin de pouvoir y faire référence lorsque ceux-ci sont pertinents pour une requête.

Capacité de découverte

L'exploration du web contribue à la réussite des stratégies en matière de SEO et de recherche, en particulier parce qu'elle facilite la découverte des sites web et informations des entreprises. Sans exploration initiale, les moteurs de recherche ne peuvent pas savoir que votre site ou les données de votre entreprise existent. Par ailleurs, il peut être utile de procéder à une exploration interne de votre site. Vous pourrez ainsi gérer les données de votre site, en les maintenant à jour et en assurant leur pertinence, afin que vous ayez accès aux informations appropriées lors d'une requête et que vous puissiez atteindre les publics concernés.

Satisfaction des utilisateurs

Il est également essentiel d'utiliser un robot d'indexation pour optimiser les fonctions de recherche de votre site web. Étant donné que le robot d'indexation indexe les données de votre site (sans que cela soit un casse-tête pour vous), vous pouvez offrir aux utilisateurs une expérience de recherche fluide. Et il y a de grandes chances que ceux-ci deviennent des clients.

Automatisation et gain de temps

Un robot d'indexation automatise la récupération des données. Il vous permet d'attirer des visiteurs vers votre site web en effectuant des explorations internes et externes. Vous pouvez ainsi vous consacrer à la création de contenus et apporter des changements stratégiques selon les besoins. Pour faire court, l'exploration du web est un élément important dans la réussite de votre entreprise, tout comme la capacité d'exploration de votre site.

Composants clés d'un robot d'indexation

Les robots d'indexation sont des outils essentiels pour les moteurs de recherche. De ce fait, les composants dont ils sont équipés sont considérés comme des informations propriétaires. Ce sont ces composants qui vont faire la différence entre plusieurs services de recherche et qui vont définir l'expérience de recherche. Par exemple, l'expérience que vous propose Google est différente de celle de Yandex ou de Bing. Par ailleurs, l'expérience de recherche sur votre propre site web peut varier par rapport à celle de vos concurrents selon le degré de tenue à jour, de précision et de pertinence des informations présentées dans les résultats.

Toutefois, même si les robots d'indexation fonctionnent de façon différente, ils ont une architecture commune et disposent de capacités similaires, qu'il s'agisse de robots d'indexation sur Internet ou de robots d'indexation d'entreprise. Un robot d'indexation quel qu'il soit reçoit une URL connue, ou graine, comme donnée d'entrée. De là, il peut accéder à d'autres URL situées aux frontières de l'exploration, qu'il n'a pas encore visitées.

Conformément à un ensemble de règles ou de principes d'exploration, comme les principes de politesse (ce que le robot peut indexer) et de re-visite (c.-à-d. la fréquence d'exploration), le robot d'indexation continuera à consulter ces nouvelles URL.

De là, il doit être capable de rapporter les informations des URL, de les télécharger à haut débit, de les indexer et de les stocker dans le moteur en vue d'une utilisation ultérieure.

À noter : un robot d'indexation sur Internet permet de faire une recherche sur le web, tandis qu'un robot d'indexation d'entreprise permet de faire une recherche sur le contenu de votre site. Parmi les capacités des robots d'indexation, citons :

- une visibilité totale sur l'activité d'exploration, afin que vous puissiez en suivre la performance ;

- la programmabilité, qui vous donne le contrôle sur le robot avec des API flexibles ;

- des interfaces utilisateur simples à utiliser.

Types de robots d'indexation

Les robots d'indexation peuvent être programmés pour exécuter différentes tâches. Il existe donc différents types de robots.

Robot d'indexation ciblé : l'objectif d'un robot d'indexation ciblé est d'explorer le contenu ciblé sur un paramètre, par exemple un thème précis ou un type de domaine unique. Dans cette optique, un robot d'indexation ciblé déterminera les liens à suivre selon la probabilité qu'ils présentent.

Robot d'indexation incrémentiel : un robot d'indexation incrémentiel est un type de robot d'indexation qui revisite des pages afin de mettre à jour les index. Il remplace les anciens liens par les nouvelles URL le cas échéant. Ce processus permet de diminuer les téléchargements de documents incohérents.

Robot d'indexation distribué : les robots d'indexation distribués fonctionnent sur plusieurs sites web en même temps pour exécuter leurs tâches d'exploration.

Robot d'indexation parallèle : un robot d'indexation parallèle est un type de robot d'indexation qui exécute plusieurs processus simultanément, c.-à-d. en parallèle, pour améliorer l'efficacité des téléchargements.

Robots de moteurs de recherche populaires

Les robots d'indexation les plus populaires sont des robots de moteurs de recherche sur Internet. Citons notamment :

- BingBot : robot d'indexation de Bing

- GoogleBot : constitué de deux robots, l'un pour les plateformes mobiles, l'autre pour les bureaux

- DuckDuckBot : robot d'indexation de DuckDuckGo

- Slurp : robot d'indexation de Yahoo Search

- YandexBot : robot d'indexation de Yandex

- Baiduspider : robot du moteur de recherche Baidu

Avantages de l'exploration du web

L'exploration du web que proposent les moteurs de recherche offre une expérience de recherche conviviale, mais ce n'est pas tout.

L'un des principaux avantages de l'exploration du web, c'est qu'elle permet à votre entreprise de faire découvrir son site, son contenu et ses données. C'est donc un aspect essentiel pour les stratégies en matière de SEO et de recherche. L'exploration de votre site constitue également le moyen le plus facile d'indexer des données sur votre propre site web pour votre propre expérience de recherche. La bonne nouvelle, c'est que l'exploration du web ne nuit pas aux performances de votre site, étant donné qu'elle s'exécute en arrière-plan. Une exploration du web normale vous permet également de gérer les performances de votre site et l'expérience de recherche, et de vous assurer qu'il soit classé de manière optimale.

Parmi les autres avantages qu'apporte l'exploration du web, citons :

- Reporting intégré : la plupart des robots d'indexation sont équipés de fonctionnalités de reporting ou d'analyse auxquelles vous pouvez accéder. Ces rapports peuvent souvent être exportés dans des feuilles de calcul ou d'autres formats lisibles et sont des outils utiles pour gérer votre stratégie en matière de SEO et de recherche.

- Paramètres d'exploration : en tant qu'administrateur de site, vous pouvez définir des règles concernant la fréquence à laquelle votre robot explore votre site. Étant donné que le robot est automatisé, vous n'avez pas à extraire les rapports d'exploration à chaque fois.

- Indexation automatisée : en utilisant un robot d'indexation sur votre site, vous pouvez indexer vos données automatiquement. Vous pouvez déterminer les données à explorer et à indexer pour automatiser encore davantage le processus.

- Génération de pistes : l'exploration peut vous aider à recueillir des informations sur le marché, y trouver des opportunités et générer des pistes. Étant donné qu'il s'agit d'un outil de recherche automatique, il accélère un processus qui serait autrement manuel.

- Monitoring : les robots d'indexation vous aident à monitorer les publications mentionnant votre entreprise sur les réseaux sociaux, pour y répondre rapidement. Lorsqu'un robot d'indexation est utilisé à des fins de monitoring, il peut constituer un outil de relations publiques efficace.

Défis et limitations de l'exploration du web

Le principal défi auquel l'exploration du web est confrontée, c'est tout simplement le volume de données qui existent et qui ne cessent d'augmenter ou d'être mises à jour. Les robots d'indexation sont continuellement à la recherche de liens, mais ne pourront pas découvrir tout ce qui est produit. Cela s'explique en partie par les défis et limitations auxquels ils font face :

- Mises à jour régulières des contenus : les stratégies d'optimisation des moteurs de recherche poussent les entreprises à mettre régulièrement à jour le contenu de leurs pages. Certaines entreprises utilisent des pages web dynamiques, qui ajustent automatiquement le contenu en fonction des interactions avec le visiteur. Étant donné que le code source change régulièrement, les robots d'indexation doivent revisiter fréquemment les pages pour tenir à jour les index.

- Pièges à araignée (crawler traps) : Certains sites web utilisent de façon intentionnelle des pièges à araignée afin d'empêcher les robots d'explorer certaines pages. On peut citer notamment les fichiers robots.txt ou les balises méta noindex. Même si leur but est de protéger certaines parties d'un site afin qu'elles ne soient pas explorées ni indexées, ils peuvent parfois piéger le robot. Lorsque cela se produit, le robot se retrouve coincé dans une boucle infinie qui gaspille ses ressources, et donc votre budget.

- Pression au niveau de la bande passante : lors du téléchargement et de l'indexation d'un grand nombre de pages, les robots d'indexation peuvent consommer beaucoup de capacité réseau, ce qui peut entraîner une pression sur la bande passante.

- Contenu en doublon : qu'il s'agisse d'une erreur de la machine ou d'une erreur humaine, la présence d'un contenu en doublon peut entraîner une indexation inexacte. Lorsqu'un robot d'indexation visite des pages en doublon, il indexe et classe uniquement une seule page. Mais il est difficile pour lui de déterminer laquelle il doit télécharger et indexer, ce qui est contreproductif pour l'entreprise.

Exploration du web ou moissonnage du web ?

La différence principale qui existe entre l'exploration et le moissonnage est que l'exploration sert pour indexer les données, tandis que le moissonnage sert à extraire les données.

Le moissonnage, qu'on appelle aussi scraping ou harvesting, est généralement plus ciblé que l'exploration. Il peut être réalisé à petite ou grande échelle, et sert à extraire des données et des contenus des sites à des fins d'études de marché, de génération de pistes ou de testing de sites web. On emploie parfois les termes d'exploration ou de moissonnage de manière interchangeable.

Alors que les robots d'indexation sont généralement soumis à des règles qu'ils doivent respecter, comme les fichiers robots.txt et les principes de frontière des URL, les collecteurs web peuvent ignorer les autorisations, télécharger du contenu illégalement et ignorer toute pression que leurs activités pourraient exercer sur un serveur.

Tendances à venir concernant l'exploration du web

Tous les moteurs de recherche utilisent un robot d'indexation. Il s'agit donc d'un technologie plutôt mature. C'est pourquoi peu d'entreprises prennent le temps de concevoir leur propre robot d'indexation. Qui plus est, il existe des robots d'indexation open source.

Néanmoins, étant donné que la production de nouvelles données continue à augmenter de manière exponentielle, et comme les entreprises se tournent davantage sur les possibilités qu'offrent les données non structurées, la technologie d'exploration du web va continuer à évoluer pour répondre à la demande. Les fonctionnalités de recherche sont essentielles pour les entreprises, et avec l'arrivée de l'IA, les robots d'indexation d'entreprise sont la clé pour faire en sorte que l'IA générative ait à sa disposition les informations les plus pertinentes et les plus à jour grâce à une exploration et une indexation régulières des données du site d'une entreprise.

Les entreprises consacrent également une plus grande part de leurs budgets au moissonnage du web pour étendre leurs cas d'utilisation actuels, notamment les examens, les études de marchés, le monitoring des concurrents, voire même les enquêtes criminelles. D'après Opimas, les dépenses devraient passer à 6 milliards d'USD d'ici 20251.

L'exploration du web avec Elastic

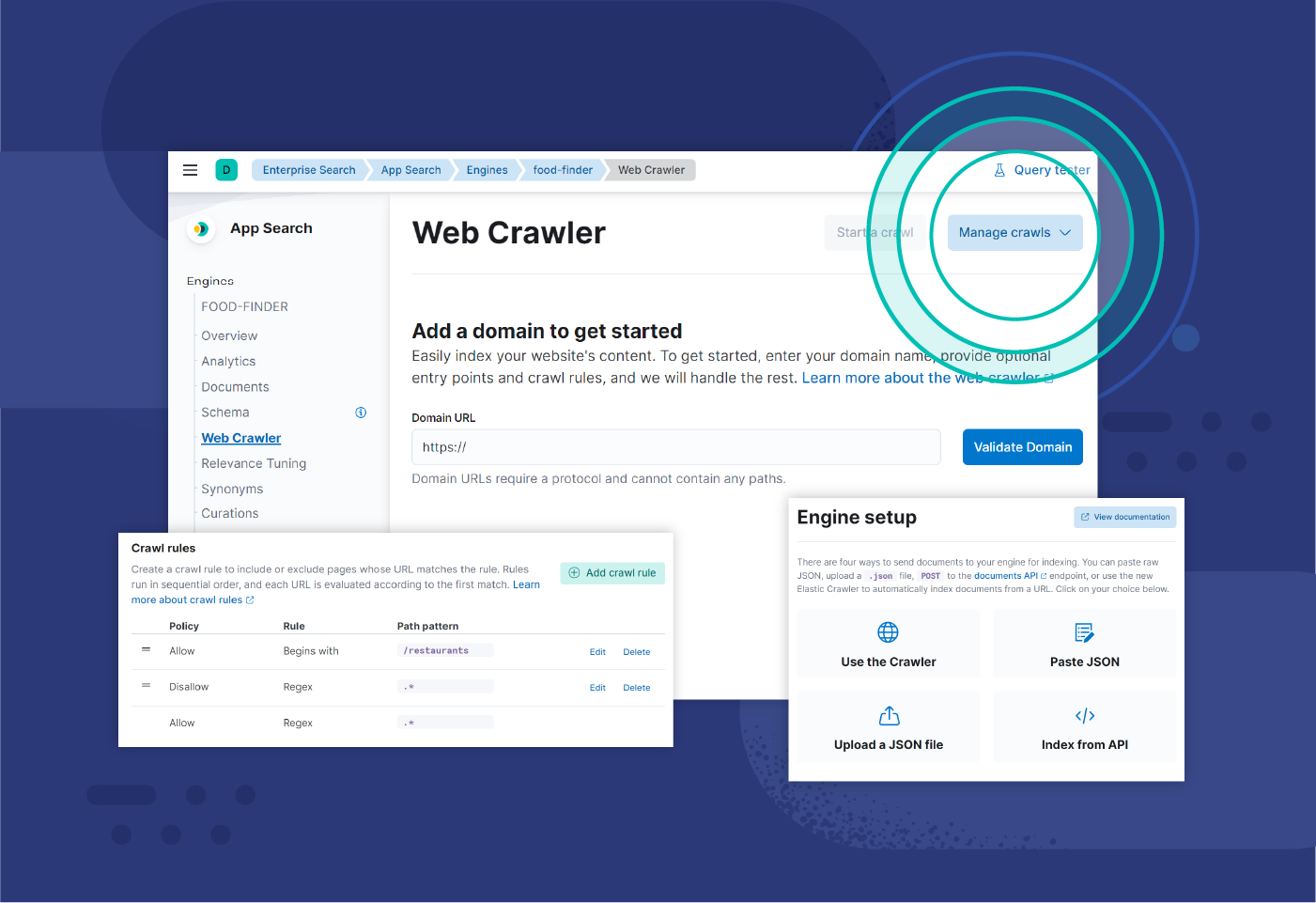

Le robot d'indexation d'Elastic est un outil d'Elasticsearch qui permet aux développeurs d'indexer et de synchroniser facilement les contenus de leur site web. Le robot d'indexation gère automatiquement l'indexation et est facile à contrôler, tout en étant configurable et observable.

Avec le robot d'indexation d'Elastic, qui est prêt à être utilisé en production, vous pouvez planifier les explorations de sorte à ce qu'elles s'exécutent automatiquement, configurer des règles, ainsi qu'explorer des contenus et des PDF authentifiés.

Notes

1 "What's the future of web scraping in 2023?", article d'Apify, janvier 2023