Was sind große Sprachmodelle (Large Language Models, LLMs)?

Definition: Großes Sprachmodell

Im Wesentlichen ist ein großes Sprachmodell (LLM) ein Modell, das mithilfe von Deep-Learning-Algorithmen trainiert wurde und eine Vielzahl von Aufgaben der Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) ausführen kann, darunter Sentimentanalyse, Beantwortung von Fragen im Dialog, Textübersetzung, Klassifizierung und Generierung. Ein LLM ist eine Art neuronales Netzwerk (NN), das speziell Transformator-Architekturen verwendet. Dabei handelt es sich um Modelle, die dazu dienen, Abhängigkeiten zwischen verschiedenen Teilen einer Datensequenz zu erkennen, unabhängig von ihrer Entfernung zueinander. Diese neuronalen Netzwerke bestehen aus Schichten von Verarbeitungseinheiten, die oft mit Neuronen im Gehirn verglichen werden. Große Sprachmodelle haben außerdem eine Vielzahl von Parametern, die den Erinnerungen entsprechen, die das Modell beim Training sammelt. Sie können sich diese Parameter als die Wissensdatenbank des Modells vorstellen.

Dank dieser Verarbeitungsfähigkeit können LLMs für Aufgaben wie das Schreiben von Softwarecode, die Sprachgenerierung und vieles mehr trainiert werden, während spezialisierte Modelle Aufgaben wie das Verstehen von Proteinstrukturen übernehmen.1 Große Sprachmodelle müssen vortrainiert und anschließend fein abgestimmt werden, um Probleme wie Textklassifizierung, Beantwortung von Fragen, Dokumentenzusammenfassung, Textgenerierung und andere Aufgaben zu lösen. Diese Problemlösungsfähigkeiten können dann in Bereichen wie Gesundheits- und Finanzwesen oder Entertainment eingesetzt werden. Dort werden große Sprachmodelle in einer Vielzahl von NLP-Anwendungen genutzt, wie etwa für Übersetzungen, Chatbots und KI-Assistenten.

Sehen Sie sich dieses Video an und tauchen Sie tiefer in LLMs ein.

Wie funktionieren LLMs?

Grundsätzlich funktioniert ein großes Sprachmodell wie folgt: Es empfängt eine Eingabe, codiert sie und decodiert sie anschließend, um eine Ausgabevorhersage zu erstellen, beispielsweise das nächste Wort, den nächsten Satz oder eine konkrete Antwort. Wie alle Machine-Learning-Modelle muss auch ein großes Sprachmodell trainiert und fein abgestimmt werden, bevor es die erwarteten und erforderlichen Ergebnisse liefern kann. So wird der Prozess optimiert:

- Training: Große Sprachmodelle werden mit großen Datensätzen von Websites wie Wikipedia, GitHub oder anderen vortrainiert. Diese Datensätze enthalten Billionen von Wörtern, und ihre Qualität beeinflusst die Leistung des Sprachmodells. In dieser Phase lernt das große Sprachmodell unbeaufsichtigt, da es die ihm zugeführten Datensätze ohne spezifische Anweisungen verarbeitet. Dabei lernt der Algorithmus, die statistischen Zusammenhänge zwischen Wörtern und ihrem Kontext zu erkennen. Das LLM lernt beispielsweise, zu verstehen, ob mit „August“ ein Monat oder der Name einer Person gemeint ist.

- Feinabstimmung: Damit ein großes Sprachmodell eine spezifische Aufgabe ausführen kann, wie zum Beispiel Übersetzungen, muss es für diese spezielle Aktivität fein abgestimmt werden. Durch Feinabstimmung werden die Parameter des Modells angepasst, um seine Leistung bei bestimmten Aufgaben zu optimieren, indem es anhand zusätzlicher beschrifteter Daten trainiert wird.

- Das Prompt-Tuning dient einem ähnlichen Zweck wie die Feinabstimmung. Dabei wird ein Modell mit wenigen Anweisungen (Few-Shot-Prompting) oder gar keinen Anweisungen (Zero-Shot-Prompting) für eine Aufgabe trainiert. Few-Shot-Prompting liefert dem Modell Beispiele, die es bei der Vorhersage von Ausgaben unterstützen, wie zum Beispiel Folgende:

| Kundenbewertung | Kundenstimmung |

|---|---|

| „Diese Pflanze ist wirklich schön!“ | Positiv |

| „Diese Pflanze ist total hässlich!“ | Negativ |

In diesem Fall versteht das Modell die Bedeutung von „hässlich“, weil ein gegenteiliges Beispiel (schön) angegeben wurde.

Beim Zero-Shot-Prompting werden jedoch keine Beispiele verwendet. Stattdessen wird das Modell direkt aufgefordert, eine Aufgabe auszuführen, beispielsweise wie folgt:

„Die Stimmung bei ‚Diese Pflanze ist total hässlich‘ ist …“

Basierend auf dem vorherigem Training muss das Modell die Stimmung ohne bereitgestellte Beispiele vorhersagen.Wichtige Komponenten von großen Sprachmodellen

Große Sprachmodelle bestehen aus mehrschichtigen neuronalen Netzen. Einbettungs-, Aufmerksamkeits- und Feedforward-Schichten arbeiten zusammen, um Eingabetexte zu verarbeiten und Ausgabeinhalte zu erzeugen.

- Die Einbettungsschicht erstellt Vektoreinbettungen. aus dem Eingabetext oder mathematischen Darstellungen der Wörter, mit denen sie gespeist wird. Dieser Teil des Modells erfasst die semantische und syntaktische Bedeutung der Eingabe, damit das Modell Wörter und ihre Beziehungen im Kontext verstehen kann.

- Der Aufmerksamkeitsmechanismus ermöglicht es dem Modell, sich auf alle Teile des Eingabetextes zu konzentrieren, basierend auf deren Relevanz für die aktuelle Aufgabe, wodurch langfristige Abhängigkeiten erfasst werden können.

- Die Feedforward-Schicht besteht aus mehreren vollständig verbundenen Schichten, die nichtlineare Transformationen auf die Daten anwenden. Diese verarbeiten die Informationen, nachdem sie durch den Aufmerksamkeitsmechanismus codiert wurden.

Wir unterscheiden drei verschiedene Arten von großen Sprachmodellen:

- Allgemeine oder rohe Sprachmodelle sagen das nächste Wort anhand der Sprache in den Trainingsdaten vorher. Diese Sprachmodelle werden eingesetzt, um Informationen abzurufen.

- Anweisungsbasierte Sprachmodelle werden trainiert, um Antworten auf die in der Eingabe enthaltenen Anweisungen vorherzusagen. Auf diese Weise können Sentimentanalysen durchgeführt oder Texte oder Code generiert werden.

- Dialogoptimierte Sprachmodelle werden trainiert, um Dialoge zu führen, indem die nächste Antwort vorhergesagt wird. Mögliche Einsatzbereiche sind Chatbots oder KI für Unterhaltungen.

Was ist der Unterschied zwischen großen Sprachmodellen und generativer KI?

Generative KI ist ein Oberbegriff für KI-Modelle, die Inhalte erstellen können. Diese Modelle können Text, Code, Bilder, Video und Musik generieren. Sie können sich auch auf verschiedene Inhaltstypen spezialisieren, wie Textgenerierung (z. B. ChatGPT) oder Bilderstellung (z. B. DALL-E, MidJourney).

Große Sprachmodelle sind eine Art von generativer KI, die speziell mit großen Textdatensätzen trainiert wird und dazu dient, Textinhalte zu generieren, wie beispielsweise im Fall von ChatGPT.

Alle LLMs sind generative KI, aber nicht alle generativen KI-Modelle sind LLMs. Beispielsweise generieren DALL-E und MidJourney Bilder, aber keinen Text.

Was ist ein Transformer-Modell?

Ein Transformationsmodell ist die gängigste Architekturform eines großen Sprachmodells. Es besteht typischerweise aus einem Encoder und einem Decoder, wobei einige Modelle, wie GPT, nur den Decoder verwenden. Transformationsmodelle verarbeiten Daten, indem zunächst die Eingabe tokenisiert und anschließend parallele mathematische Gleichungen verwendet werden, um Beziehungen zwischen den Token zu ermitteln. Auf diese Weise kann der Computer dieselben Muster erkennen, die auch ein Mensch für dieselbe Fragestellung sehen würde.

Transformationsmodelle verwenden Selbstbeobachtungsmechanismen, mit denen das Modell schneller lernen kann als herkömmliche Modelle, wie etwa Modelle mit Lang- und Kurzzeitgedächtnis. Selbstaufmerksamkeit ermöglicht es Transformer-Modellen, Beziehungen zwischen Wörtern besser zu erfassen als ältere Modelle, selbst wenn diese in einem Satz weit voneinander entfernt sind. Dies wird in erster Linie durch die parallele Verarbeitung von Informationen erreicht.

Verwandt: Transformer in Ihren Suchanwendungen einsetzen

Beispiele und Anwendungsfälle für große Sprachmodelle

Große Sprachmodelle können für verschiedene Zwecke verwendet werden:

- Informationsabruf: Denken Sie an Bing oder Google. LLMs können in Suchmaschinen integriert werden, um die Reaktion auf Abfragen zu verbessern. Während herkömmliche Suchmaschinen hauptsächlich auf Indexierungsalgorithmen basieren, verbessern LLMs die Fähigkeit, auf der Grundlage einer Abfrage konversationsorientierte oder kontextbezogene Antworten zu generieren.

- Sentimentanalyse: Als Anwendung der Verarbeitung natürlicher Sprache ermöglichen große Sprachmodelle Unternehmen die Analyse der Stimmung in Textdaten.

- Textgenerierung: Große Sprachmodelle wie ChatGPT sind die Grundlage generativer KI-Systeme und können kohärenten und kontextrelevanten Text auf Basis von Eingaben generieren. Sie können ein LLM beispielsweise mit „Schreib mir ein Gedicht über Palmen im Stil von Emily Dickinson“ dazu auffordern.

- Codegenerierung: Wie die Textgenerierung ist auch die Codegenerierung eine Anwendung generativer KI. LLMs können basierend auf Eingaben syntaktisch und logisch korrekten Code generieren, indem sie aus riesigen Mengen an Programmiercode in verschiedenen Sprachen lernen.

- Chatbots und dialogorientierte KI: Große Sprachmodelle bilden die Grundlage für Chatbots im Kundenservice und dialogorientierte KI. Sie helfen bei der Interpretation von Kundenanfragen, dem Verstehen von Absichten und der Generierung von Antworten, die eine menschenähnliche Konversation simulieren.

Verwandt: Wie man einen Chatbot erstellt: Dos und Don'ts für Entwickler

Neben diesen Anwendungsfällen können große Sprachmodelle auch Sätze vervollständigen, Fragen beantworten und Texte zusammenfassen.

Angesichts dieser vielfältigen Anwendungsmöglichkeiten werden LLMs in einer Vielzahl von Bereichen eingesetzt:

- Technik: Große Sprachmodelle werden in verschiedenen Anwendungen eingesetzt, z. B. zur Verbesserung der Antworten auf Suchmaschinenanfragen und zur Unterstützung von Entwickler:innen beim Schreiben von Code.

- Gesundheitswesen und Wissenschaft: Große Sprachmodelle können Textdaten zu Proteinen, Molekülen, DNA und RNA analysieren und so bei der Forschung, der Entwicklung von Impfstoffen, der Identifizierung potenzieller Heilmittel für Krankheiten und der Verbesserung präventiver Medikamente helfen. LLMs werden außerdem als medizinische Chatbots eingesetzt, um Patienten aufzunehmen oder einfache Diagnosen zu stellen, wobei normalerweise menschliche Aufsicht erforderlich ist.

- Kundenservice: LLMs werden branchenübergreifend im Kundenservice eingesetzt, etwa in Form von Chatbots oder dialogorientierter KI.

- Marketing: Marketingteams können LLMs für Sentimentanalysen, Inhaltsgenerierung und Brainstorming zu Ideen für Kampagnen nutzen. Sie hilft, Texte für Verkaufsgespräche, Werbung und andere Materialien zu generieren.

- Rechtswesen: Von der Suche in riesigen Datensätzen aus dem Rechtsbereich bis hin zur Erstellung von Rechtsdokumenten können große Sprachmodelle Anwält:innen, Rechtsanwaltsfachangestellte und juristische Mitarbeitende unterstützen.

- Bankwesen: LLMs können bei der Analyse von Finanztransaktionen und Kundenkommunikationen helfen, um potenziellen Betrug aufzudecken, oft als Teil umfassenderer Betrugserkennungssysteme.

Erste Schritte mit generativer KI im Unternehmen. Sehen Sie sich dieses Webinar an und erkunden Sie die Herausforderungen und Chancen der generativen KI in Ihrer Unternehmensumgebung.

Einschränkungen und Herausforderungen von LLMs

Große Sprachmodelle gaukeln uns manchmal vor, dass sie Bedeutungen verstehen und exakt darauf antworten können. Sie sind jedoch nach wie vor ein Tool, das von menschlicher Aufsicht profitiert und mit einer Vielzahl von Herausforderungen konfrontiert ist.

- Halluzinationen: Eine Halluzination tritt auf, wenn ein LLM eine Ausgabe generiert, die falsch ist oder nicht der Absicht der Person entspricht, die es nutzt. Beispiele sind LLMs, die sich als Menschen ausgeben, Emotionen vortäuschen oder dem Nutzer ihre Liebe erklären. Große Sprachmodelle sagen die nächsten syntaktisch richtigen Wörter oder Sätze vorher und können daher menschliche Absichten nicht vollständig interpretieren. Dadurch entstehen manchmal sogenannte Halluzinationen.

- Sicherheit: Große Sprachmodelle bergen erhebliche Sicherheitsrisiken, wenn sie nicht angemessen verwaltet oder überwacht werden. Sie könnten versehentlich private Informationen aus Trainingsdaten oder Interaktionen preisgeben und für bösartige Zwecke wie Phishing oder Spam-Generierung ausgenutzt werden. Nutzer:innen mit böswilligen Absichten können LLMs auch missbrauchen, um verzerrte Ideologien, Fehlinformationen oder schädliche Inhalte zu verbreiten.

- Verzerrung: Die Daten, die zur Schulung von Sprachmodellen verwendet werden, beeinflussen die Ausgaben, die ein bestimmtes Modell erzeugt. Wenn die Trainingsdaten nicht vielfältig genug sind oder eine bestimmte Bevölkerungsgruppe überproportional vertreten ist, kann das Modell diese Verzerrungen reproduzieren, was zu Ergebnissen führt, die eine verzerrte – und wahrscheinlich eingeschränkte – Perspektive widerspiegeln. Die Gewährleistung eines vielfältigen und repräsentativen Trainingsdatensatzes ist der Schlüssel, um Verzerrungen in den Modellergebnissen zu reduzieren.

- Einwilligung: Große Sprachmodelle werden mit umfangreichen Datensätzen trainiert, von denen einige möglicherweise ohne ausdrückliche Einwilligung oder unter Verstoß gegen Urheberrechtsvereinbarungen erhoben wurden. Dies kann zu Verletzungen von Rechten an geistigem Eigentum führen, wenn Inhalte ohne ordnungsgemäße Quellenangabe oder Genehmigung reproduziert werden. Darüber hinaus können diese Modelle personenbezogene Daten erfassen, was Bedenken hinsichtlich des Datenschutzes aufwirft.2 Es gab bereits Fälle, in denen LLMs mit rechtlichen Herausforderungen konfrontiert waren, wie zum Beispiel Klagen von Unternehmen wie Getty Images3 wegen Urheberrechtsverletzungen.

- Skalieren: Das Skalieren von LLMs kann sehr ressourcenintensiv sein und erfordert erhebliche Rechenleistung. Die Pflege solcher Modelle umfasst kontinuierliche Aktualisierungen, Optimierungen und Überwachungen, was diesen Prozess sowohl zeit- als auch kostenintensiv macht. Die zur Unterstützung dieser Modelle notwendige Infrastruktur ist ebenfalls umfangreich.

- Bereitstellung: Die Bereitstellung großer Sprachmodelle erfordert Fachwissen in den Bereichen Deep Learning und Transformer-Architekturen sowie spezielle Hardware und verteilte Softwaresysteme.

Vorteile von LLMs

Mit ihrem breiten Anwendungsspektrum sind große Sprachmodelle außerordentlich vorteilhaft, um Probleme zu lösen, da sie Informationen in einem klaren und für die Nutzer leicht verständlichen Unterhaltungsstil liefern.

- Sie haben ein breites Anwendungsspektrum: LLMs werden unter anderem in den Bereichen Sprachübersetzung, Satzvervollständigung, Standpunktanalysen, Beantwortung von Fragen und mathematische Gleichungen eingesetzt.

- Sie werden immer besser: Die Leistung von großen Sprachmodellen verbessert sich kontinuierlich, da weitere Daten und Parameter hinzugefügt werden. Diese Verbesserung hängt auch von Faktoren wie der Modellarchitektur und der Qualität der hinzugefügten Trainingsdaten ab. Anders ausgedrückt: Je mehr die Modelle lernen, desto besser werden sie. Außerdem sind große Sprachmodelle zu sogenanntem Kontextlernen fähig: Das Modell kann Aufgaben basierend auf im Prompt gegebenen Beispielen ausführen, ohne dass zusätzliches Training oder weitere Parameter erforderlich sind. So ist das Modell in der Lage, mit nur wenigen Beispielen (Few-Shot-Lernen) oder sogar ohne vorherige Beispiele (Zero-Shot-Lernen) zu generalisieren oder sich an verschiedene Aufgaben anpassen. Auf diese Weise lernt das Modell fortlaufend weiter.

- Sie lernen schnell: Durch Kontextlernen können LLMs sich mit möglichst wenigen Beispielen an neue Aufgaben anpassen. Sie benötigen weder zusätzliches Training noch weitere Parameter und können dennoch schnell auf den Kontext der Eingabe reagieren. Daher sind sie besonders effizient in Szenarien, in denen nur wenige Beispiele zur Verfügung stehen.

Beispiele für beliebte große Sprachmodelle

Einige große Sprachmodelle haben die Welt im Sturm erobert. Viele von ihnen werden inzwischen in verschiedensten Branchen eingesetzt. Sie haben bestimmt schon von ChatGPT gehört, einer Art von Chatbot mit generativer KI.

Weitere Beispiele für beliebte LLMs:

- PaLM: Das Pathways Language Model (PaLM) von Google ist ein Transformer-Sprachmodell, das logische und arithmetische Schlussfolgerungen ziehen, Witze erklären, Code generieren und Texte übersetzen kann.

- BERT: Das Sprachmodell „Bidirectional Encoder Representations from Transformers“ (BERT) wurde ebenfalls von Google entwickelt.Dieses transformationsbasierte Modell kann natürliche Sprache verstehen und Fragen beantworten.

- XLNet: Als Permutationssprachmodell trainiert XLNet alle möglichen Permutationen von Eingabetoken, generiert jedoch während der Inferenz Vorhersagen standardmäßig von links nach rechts.

- GPT: Generative vortrainierte Transformer (generative pretrained Transformers) sind vermutlich die bekannteste Art von großen Sprachmodellen. Die von OpenAI entwickelte GPT ist ein beliebtes Grundmodell, dessen durchnummerierte Iterationen jeweils Verbesserungen gegenüber der Vorgängerversion sind (GPT-3, GPT-4 usw.). GPT-Modelle können für spezifische Aufgaben fein abgestimmt werden. Unabhängig davon haben andere Unternehmen domänenspezifische Modelle entwickelt, die sich an grundlegenden LLMs orientieren, beispielsweise EinsteinGPT von Salesforce für CRM-Anwendungen und BloombergGPT für Finanzdaten.

Verwandt: Einsteiger-Leitfaden für Open-Source-LLMs

Zukünftige Fortschritte im Bereich der großen Sprachmodelle

Mit der Einführung von ChatGPT sind große Sprachmodelle ins Rampenlicht gerückt und haben Spekulationen und hitzige Debatten darüber ausgelöst, wie die Zukunft aussehen könnte.

Angesichts immer weiter wachsenden und immer ausgefeilter antwortenden großen Sprachmodellen gibt es zahlreiche Bedenken über die Auswirkungen dieser Fortschritte auf den Arbeitsmarkt.

In den richtigen Händen können große Sprachmodelle die Produktivität und Effizienz von Prozessen steigern, wobei jedoch bestimmte ethische und gesellschaftliche Fragen nicht übergangen werden dürfen.

Die Elasticsearch Relevance Engine kennenlernen

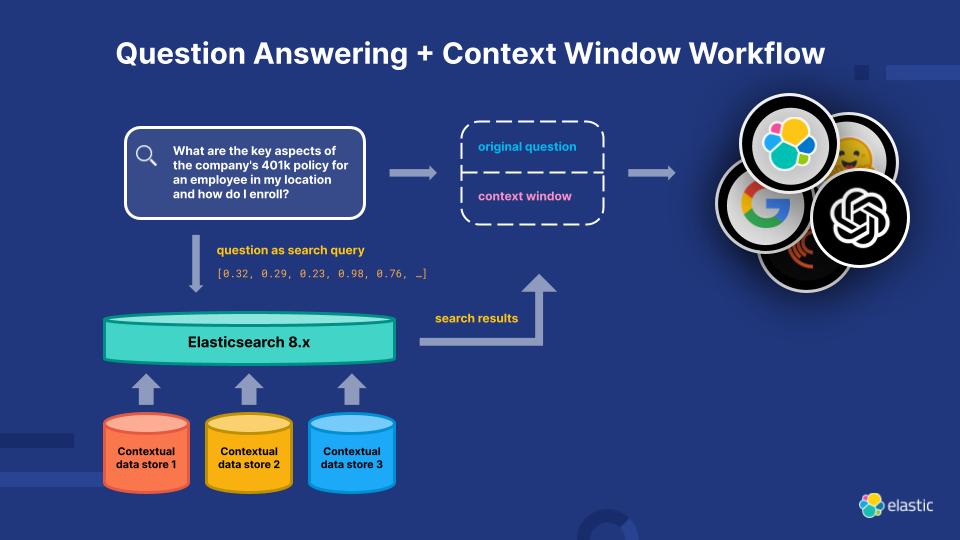

Die Elasticsearch Relevance Engine (ESRE) ist ein für KI-gestützte Suchanwendungen entwickeltes Relevanzmodul, das die aktuellen Einschränkungen von LLMs behebt. Mit ESRE können Entwickler:innen ihre eigene semantische Suchanwendung erstellen, ihre eigenen Transformer-Modelle verwenden und NLP und generative KI kombinieren, um das Sucherlebnis ihrer Kunden zu verbessern.

Die Elasticsearch Relevance Engine ist der Turbo für Ihre Relevanz

Erkunden Sie weitere Ressourcen zu großen Sprachmodellen

- LLM-Beobachtbarkeit

- Auf generativer KI basierende Elastic-Tools und -Funktionen

- Wie wählt man eine Vektordatenbank aus?

- Wie man einen Chatbot erstellt: Tipps und Fallstricke für Entwickler:innen

- Die Wahl eines LLM: Der Einsteiger-Leitfaden für Open-Source-LLMs

- Sprachmodelle in Elasticsearch

- Technische Trends 2025: Das Zeitalter der Wahlmöglichkeiten nutzen, um GenAI in die Produktion zu integrieren

- Übersicht über Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) im Elastic Stack

- Mit dem Elastic Stack kompatible Modelle von Drittanbietern

- Anleitung zu trainierten Modellen im Elastic Stack

- Die LLM-Sicherheitsbewertung

Fußnoten

- Sarumi, Oluwafemi A. und Dominik Heider. „Large Language Models and Their Applications in Bioinformatics.“ Computational and Structural Biotechnology Journal, Bd. 23. April 2024, S. 3498–3505.

https://www.csbj.org/article/S2001-0370(24)00320-9/fulltext. - Sheng, Ellen. „In generative AI legal Wild West, the courtroom battles are just getting started“ (Im juristischen Wildwest der generativen KI haben die Gerichtsschlachten angefangen, in englischer Sprache) CNBC, 3. April 2023, https://www.cnbc.com/2023/04/03/in-generative-ai-legal-wild-west-lawsuits-are-just-getting-started.html (Abgerufen am 29. Juni 2023)

- Erklärung von Getty Images, Getty Images, 17. Januar 2023 https://newsroom.gettyimages.com/en/getty-images/getty-images-statement (Abgerufen am 29. Juni 2023)