O que é um rastreador da web?

Definição de rastreador da web

Um rastreador da web é um bot de mecanismo de busca digital que usa texto e metadados para descobrir e indexar páginas de sites. Também conhecido como spider bot, ele “rastreia” a rede mundial de computadores para saber do que trata uma determinada página. Em seguida, indexa as páginas e armazena as informações para buscas futuras.

A indexação consiste em organizar os dados dentro de um determinado esquema ou estrutura. É um processo que permite ao mecanismo de busca fazer a correspondência, com a utilização de dados indexados, entre resultados de busca relevantes e uma consulta. Consequentemente, um rastreador da web é uma ferramenta que facilita a navegação na web.

Há uma distinção entre rastreadores da web da internet e rastreadores da web empresariais. Um rastreador da web da internet rastreia a internet e expande continuamente a fronteira de rastreamento ao descobrir novos sites e indexá-los. Um rastreador da web empresarial rastreia um determinado site comercial e indexa os dados do site para que as informações possam ser descobertas quando consultadas por um usuário usando a função de busca do site. Ele também pode ser usado como uma ferramenta de negócios que automatiza determinadas buscas.

Como funciona o rastreamento da web?

O rastreamento da web funciona descobrindo novas páginas, indexando-as e armazenando as informações para uso futuro. Ele pode rastrear continuamente seu conteúdo em intervalos especificados para manter os resultados da busca atualizados e pesquisáveis.

Descoberta e busca de páginas

Para coletar informações sobre o maior número possível de sites ou páginas online, um rastreador da web se moverá entre os links das páginas.

Um rastreador da web começa em um URL conhecido, ou URL inicial, e então descobre e acessa novos sites a partir dos links dessa página. Ele repete esse processo indefinidamente, procurando novas páginas constantemente. Devido ao enorme número de páginas online e ao fato de as informações serem continuamente atualizadas, esse processo pode continuar quase indefinidamente.

Os links que o rastreador encontra, mas lembra para descobertas futuras, constituem o que é conhecido como fronteira de rastreamento. Esses hiperlinks são então visitados em uma ordem determinada por um conjunto de políticas ou regras de rastreamento, entre as quais incluem-se políticas de seleção, políticas de revisita, políticas de polidez e políticas de paralelização.

Um rastreador da web considerará o número de URLs vinculados a uma determinada página e o número de visitas a uma determinada página, tudo em um esforço para descobrir e indexar conteúdo que seja importante. A lógica é que uma página frequentemente visitada e citada contém informações confiáveis e de alta qualidade. Portanto, é importante que o mecanismo de busca conheça o site e tenha a capacidade de torná-lo detectável.

Renderização, download e indexação de páginas

Depois que um bot rastreador descobre uma nova página, ele renderiza as informações contidas nela, seja o texto do site ou metatags, baixa essas informações e as indexa. Alguns rastreadores da web só podem acessar ou ler páginas públicas, enquanto outros têm permissões para indexar páginas autenticadas. Eles também estão sujeitos aos arquivos robots.txt e aos requisitos de metatag noindex. Um arquivo robots.txt é um livro de regras para páginas online que determina quais links um bot pode seguir e quais informações ele pode indexar. Uma metatag noindex distingue as metatags que não são para indexação.

Enxágue e repita

O objetivo dos rastreadores da web é indexar e baixar informações sobre determinados sites. Os rastreadores estão sempre expandindo a fronteira de rastreamento, à procura de novos sites, páginas e atualizações. Como resultado, eles continuam a expandir os dados indexados de seu mecanismo de busca.

Com a ajuda de seus spider bots, os algoritmos dos mecanismos de busca podem classificar os índices criados pelos rastreadores para que possam ser buscados e classificados em resultados quando consultados.

Por que o rastreamento da web é importante?

O rastreamento da web é importante para as empresas porque é fundamental para a funcionalidade do mecanismo de busca. Ele permite que os mecanismos de busca indexem informações e sabe quais sites e páginas existem para poder consultar essas informações quando forem relevantes para uma consulta.

Capacidade de descoberta

O rastreamento da web faz parte de uma estratégia de SEO e de busca bem-sucedida, em parte porque torna os sites e as informações comerciais detectáveis. Sem um rastreamento inicial, os mecanismos de busca não podem saber que seu site ou que os dados do site existem. Um rastreamento interno do seu site também ajuda a gerenciar os dados do seu site, mantendo-os atualizados e relevantes para que as informações certas possam ser descobertas quando consultadas e para que você alcance os públicos certos.

Satisfação do usuário

Usar um rastreador da web empresarial também é fundamental para as funções de busca do site da sua empresa. Como o rastreamento indexa os dados do seu site (sem complicações), você pode oferecer aos usuários uma experiência de busca perfeita e tem maior probabilidade de convertê-los em clientes.

Automação e economia de tempo

Um rastreador da web automatiza a recuperação de dados e permite que você gere engajamento com seu site rastreando interna e externamente. Dessa forma, você pode se concentrar na criação de conteúdo e em fazer mudanças estratégicas quando necessário. Resumindo, o rastreamento da web (e a rastreabilidade do seu site) é importante para o sucesso da sua empresa.

Principais componentes de um rastreador da web

Os rastreadores da web são ferramentas dos mecanismos de busca, portanto, seus componentes específicos são considerados informações proprietárias. Eles contribuem para distinguir os serviços e definir a experiência de busca — sua experiência no Google é diferente da sua experiência no Yandex ou no Bing, por exemplo. Além disso, sua experiência de busca no seu próprio site pode ser diferente da dos seus concorrentes, dependendo do quanto as informações apresentadas nos seus resultados de busca estiverem atualizadas e forem precisas e relevantes.

Portanto, embora diferentes rastreadores da web funcionem de maneira diferente, sejam eles bots rastreadores da internet ou empresariais, eles compartilham uma arquitetura padrão e têm funcionalidades semelhantes. Eles recebem um URL inicial como entrada. A partir daí, podem acessar mais URLs ao longo da fronteira de rastreamento, que é composta por uma lista de URLs que ainda não foram visitados por um bot de rastreamento.

Com base em um conjunto de políticas ou regras de rastreamento, como polidez (o que o bot pode indexar) e políticas de revisita (com que frequência ele pode rastrear), o rastreador continuará visitando novos URLs.

A partir daí, ele deverá ter a capacidade de renderizar as informações do URL, baixá-las em alta velocidade, indexá-las e armazená-las no mecanismo para uso futuro.

Enquanto os rastreadores da internet permitem uma busca em toda a web, os rastreadores da web empresariais permitem que seu conteúdo seja buscável no seu site. Estas são algumas de suas funcionalidades:

- Visibilidade total da atividade de rastreamento para que você possa acompanhar o desempenho do rastreamento

- Capacidade de programação, que lhe dá controle do bot com APIs flexíveis

- Interfaces do usuário fáceis de usar

Tipos de rastreadores da web

Os rastreadores da web podem ser programados para realizar diferentes tarefas. Como tal, existem diferentes tipos de rastreadores da web.

Rastreador da web com foco. O objetivo de um rastreador da web com foco é rastrear conteúdo com foco em um parâmetro, como conteúdo relacionado a um único tópico ou de um único tipo de domínio. Para fazer isso, um rastreador da web com foco discernirá quais hiperlinks seguir com base na probabilidade.

Rastreador da web incremental. Um rastreador da web incremental é um tipo de bot rastreador que revisita as páginas para atualizar os índices. Ele substitui links antigos por novos URLs quando aplicável. Esse processo serve para reduzir downloads inconsistentes de documentos.

Rastreador distribuído. Os rastreadores distribuídos trabalham em diferentes sites simultaneamente para cumprir as tarefas de rastreamento.

Rastreador paralelo. Um rastreador paralelo é um tipo de bot de rastreamento que executa vários processos simultaneamente (ou em paralelo) para aumentar a eficiência do download.

Bots populares de mecanismos de busca

Os bots rastreadores mais populares são os bots de mecanismos de busca da internet. São os seguintes:

- BingBot: bot rastreador do Bing

- GoogleBot: composto por dois bots — um para plataformas móveis e outro para desktops

- DuckDuckBot: bot do DuckDuckGo

- Slurp: bot do Yahoo Search

- YandexBot: bot do Yandex

- Baiduspider: bot do mecanismo de busca do Baidu

Benefícios do rastreamento da web

Embora o rastreamento da web usado pelos mecanismos de busca forneça uma experiência de busca amigável, os usuários empresariais se beneficiam do rastreamento da web de várias maneiras.

O principal benefício do rastreamento da web para usuários empresariais é que ele permite a descoberta de seu site, conteúdo e dados e, como tal, é essencial para a estratégia de busca e SEO da empresa. Rastrear seu site também é a maneira mais fácil de indexar dados no seu próprio site para sua própria experiência de busca. E a boa notícia é que o rastreamento da web não afeta o desempenho do seu site porque é executado em segundo plano. O rastreamento regular da web também ajuda a gerenciar o desempenho do seu site e a experiência de busca, bem como garantir que ele seja classificado de forma ideal.

Benefícios adicionais do rastreamento da web:

- Relatórios integrados. A maioria dos rastreadores da web tem recursos de relatórios ou analítica que você pode acessar. Muitas vezes, esses relatórios podem ser exportados para planilhas ou outros formatos legíveis e são ferramentas úteis para gerenciar sua estratégia de busca e SEO.

- Parâmetros de rastreamento. Como gerente do site, você pode definir regras de frequência para a taxa de rastreamento. Você decide com que frequência o spider bot rastreia seu site. Como o bot é automatizado, não há necessidade de extrair manualmente relatórios de rastreamento todas as vezes.

- Indexação automatizada. Ao usar um rastreador da web no seu site, você pode indexar seus dados automaticamente. Você pode controlar quais dados são rastreados e indexados, automatizando ainda mais o processo.

- Geração de leads. O rastreamento pode ajudar você a reunir insights sobre o mercado, encontrar oportunidades e gerar leads. Como ferramenta de busca automática, ele acelera um processo que de outra forma poderia ser manual.

- Monitoramento. Os rastreadores da web podem ajudar você a monitorar as menções à sua empresa nas redes sociais e a melhorar o tempo de resposta. Quando usado para monitoramento, um rastreador da web pode ser uma ferramenta de relações públicas eficaz.

Desafios e limitações do rastreamento da web

O principal desafio do rastreamento da web é a grande quantidade de dados que existe e é continuamente produzida ou atualizada. Os rastreadores estão continuamente procurando links, mas é improvável que descubram tudo o que já foi produzido. Isso se deve em parte a estes desafios e limitações:

- Atualizações regulares de conteúdo. As estratégias de otimização para mecanismos de busca (SEO) incentivam as empresas a atualizar regularmente o conteúdo de suas páginas. Algumas empresas usam páginas da web dinâmicas, que ajustam automaticamente seu conteúdo com base no engajamento do visitante. Com o código-fonte em constante mudança, os rastreadores da web precisam revisitar as páginas com frequência para manter os índices atualizados.

- Armadilhas para rastreadores. Às vezes, intencionalmente, os sites usam armadilhas para rastreadores para evitar que spider bots rastreiem determinadas páginas. Os obstáculos comumente usados para os rastreadores são arquivos robots.txt ou metatags noindex. Embora tenham como objetivo proteger certas partes de um site contra rastreamento e indexação, às vezes eles podem atrapalhar o rastreador. Quando isso acontece, o bot pode ficar preso em um ciclo vicioso de rastreamento que desperdiça os recursos do rastreador e seu orçamento.

- Sobrecarga da largura de banda. Ao baixar e indexar um grande número de páginas, os rastreadores da web podem consumir muita capacidade da rede e, portanto, sobrecarregar a largura de banda.

- Conteúdo duplicado. O conteúdo duplicado, seja produto de erro de máquina ou humano, pode resultar em uma indexação imprecisa. Quando os rastreadores visitam páginas duplicadas, eles indexam e classificam apenas uma página. Determinar qual delas baixar e indexar é difícil para o bot e contraproducente para a empresa.

Rastreamento da web e raspagem da web

A principal diferença entre rastreamento e raspagem é que o rastreamento da web é usado para indexação de dados, enquanto a raspagem da web é usada para extração de dados.

A raspagem da web, também conhecida como colheita da web, é geralmente mais direcionada do que o rastreamento. Pode ser realizada em pequena e grande escala e é usada para extrair dados e conteúdo de sites para pesquisa de mercado, geração de leads ou testes de sites. Às vezes, o rastreamento da web e a raspagem da web são usados de forma intercambiável.

Onde os rastreadores da web geralmente estão sujeitos a regras como arquivos robots.txt e políticas de fronteira de URL, os raspadores da web podem ignorar as permissões, baixar conteúdo ilegalmente e desconsiderar qualquer sobrecarga no servidor que suas atividades possam estar causando.

Tendências futuras em rastreamento da web

Os rastreadores da web são usados por todos os mecanismos de busca e são uma tecnologia bastante madura. Por esse motivo, poucos investem tempo na construção de seus próprios rastreadores. Além do mais, existem rastreadores da web open source.

No entanto, à medida que a produção de novos dados continuar a crescer exponencialmente e à medida que as empresas avançarem mais no sentido de explorar as possibilidades dos dados não estruturados, a tecnologia de rastreamento da web evoluirá para atender à demanda. As funcionalidades de busca são vitais para as empresas e, com a chegada da IA, os rastreadores da web empresariais são um elemento crucial para garantir que a IA generativa obtenha as informações mais relevantes e atualizadas rastreando e indexando regularmente os dados dos sites.

As empresas também estão dedicando mais de seus orçamentos à raspagem da web para expandir os casos de uso atuais, que incluem investigações, pesquisas de mercado, monitoramento de concorrentes ou até mesmo investigações criminais. A Opimas prevê que os investimentos subirão para US$ 6 bilhões até 20251.

Rastreamento da web com a Elastic

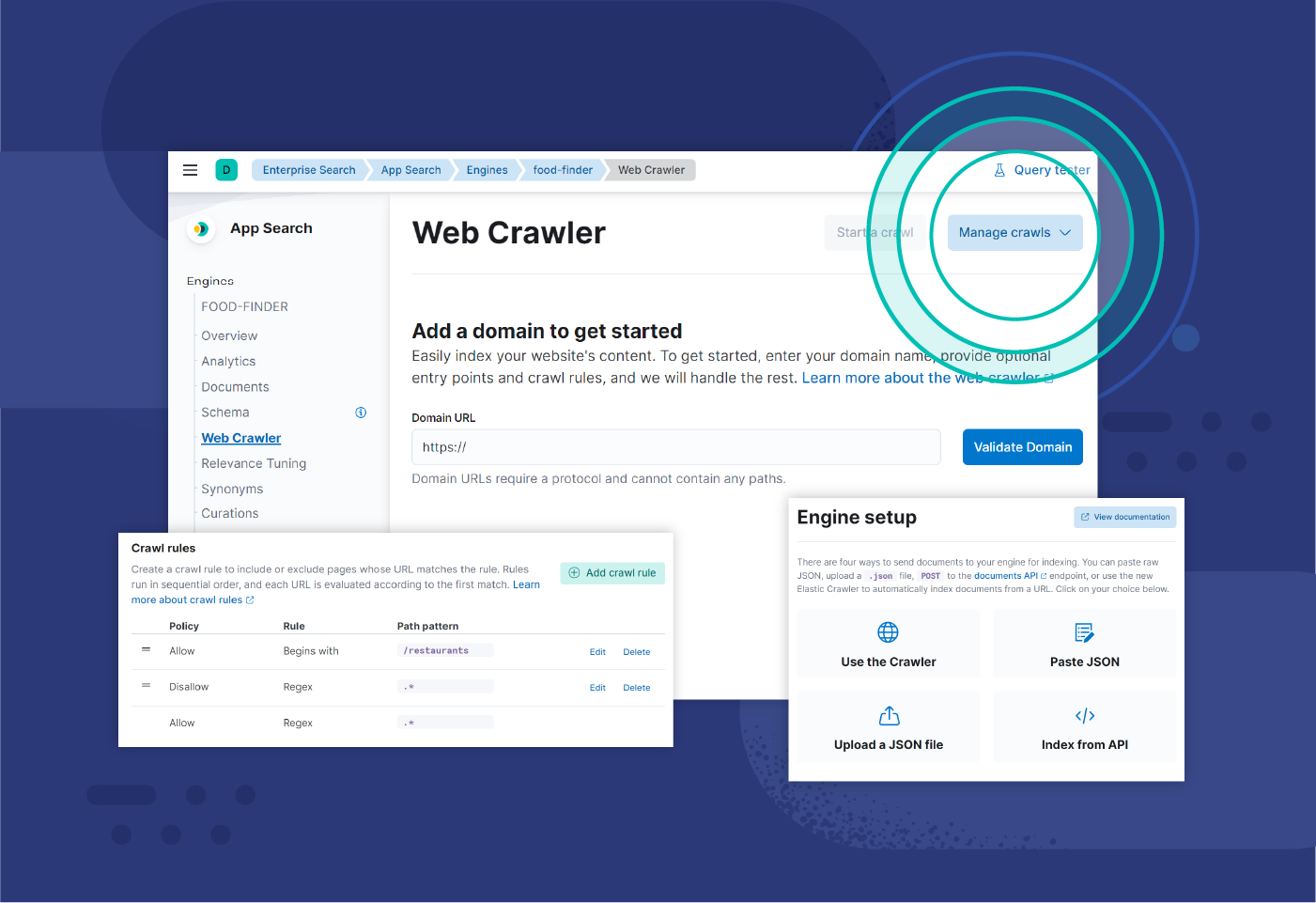

O rastreador da web da Elastic é uma ferramenta do Elasticsearch que permite aos desenvolvedores indexar e sincronizar facilmente o conteúdo de seus sites. O rastreador lida automaticamente com a indexação e é fácil de controlar, ao mesmo tempo que é configurável e observável.

Com o rastreador da web da Elastic pronto para produção, você pode agendar rastreamentos para execução automática, configurar regras e rastrear conteúdo autenticado e PDFs.

Recursos sobre rastreamento da web

- Building a scalable solution to common web crawling challenges (Como criar uma solução escalável para desafios comuns de rastreamento da web)

- Funcionalidades de rastreamento da web da Elastic (em inglês)

- Getting started with website search (Introdução à busca de sites)

- Treinamento Quick Start sobre rastreadores da web (em inglês)

Notas de rodapé

1 “What's the future of web scraping in 2023?”, Blog da Apify, janeiro de 2023