2. März 2026

Adaptive vorzeitige Beendigung für HNSW in Elasticsearch

Einführung einer neuen adaptiven Strategie zur vorzeitigen Beendigung von HNSW in Elasticsearch.

3. Dezember 2025

Bis zu 12 Mal schnellere Vektorindizierung in Elasticsearch mit NVIDIA cuVS: GPU-Beschleunigung Kapitel 2

Entdecken Sie, wie Elasticsearch mit GPU-beschleunigter Vektorindizierung und NVIDIA cuVS einen fast 12-mal höheren Indizierungsdurchsatz erzielt.

4. November 2025

Multimodale Suche nach Berggipfeln mit Elasticsearch und SigLIP-2

Lernen Sie, wie Sie die multimodale Suche von Text zu Bild und von Bild zu Bild mithilfe von SigLIP-2-Einbettungen und der Elasticsearch kNN-Vektorsuche implementieren. Projektschwerpunkt: Auffinden von Fotos des Gipfels des Mount Ama Dablam während einer Everest-Trekkingtour.

3. November 2025

Verbesserung der Relevanz mehrsprachiger Einbettungsmodelle durch hybrides Such-Reranking

Erfahren Sie, wie Sie die Relevanz der Suchergebnisse des E5-Multilingual-Embedding-Modells mithilfe des Cohere-Rerankers und der Hybridsuche in Elasticsearch verbessern können.

22. Oktober 2025

Bereitstellung eines mehrsprachigen Einbettungsmodells in Elasticsearch

Erfahren Sie, wie Sie ein mehrsprachiges e5-Einbettungsmodell für die Vektorsuche und den sprachübergreifenden Abruf in Elasticsearch bereitstellen.

3. September 2025

Vektorsuchfilterung: Relevanz beibehalten

Es reicht nicht aus, eine Vektorsuche durchzuführen, um die ähnlichsten Ergebnisse zu einer Suchanfrage zu finden. Um die Suchergebnisse einzugrenzen, ist häufig das Filtern erforderlich. Dieser Artikel erklärt, wie die Filterung bei der Vektorsuche in Elasticsearch und Apache Lucene funktioniert.

13. Mai 2025

Zuordnung von Einbettungen zu Elasticsearch-Feldtypen: semantic_text, dense_vector, sparse_vector

Erörterung, wie und wann semantic_text, dense_vector oder sparse_vector verwendet werden und wie diese mit der Einbettungsgenerierung zusammenhängen.

23. April 2025

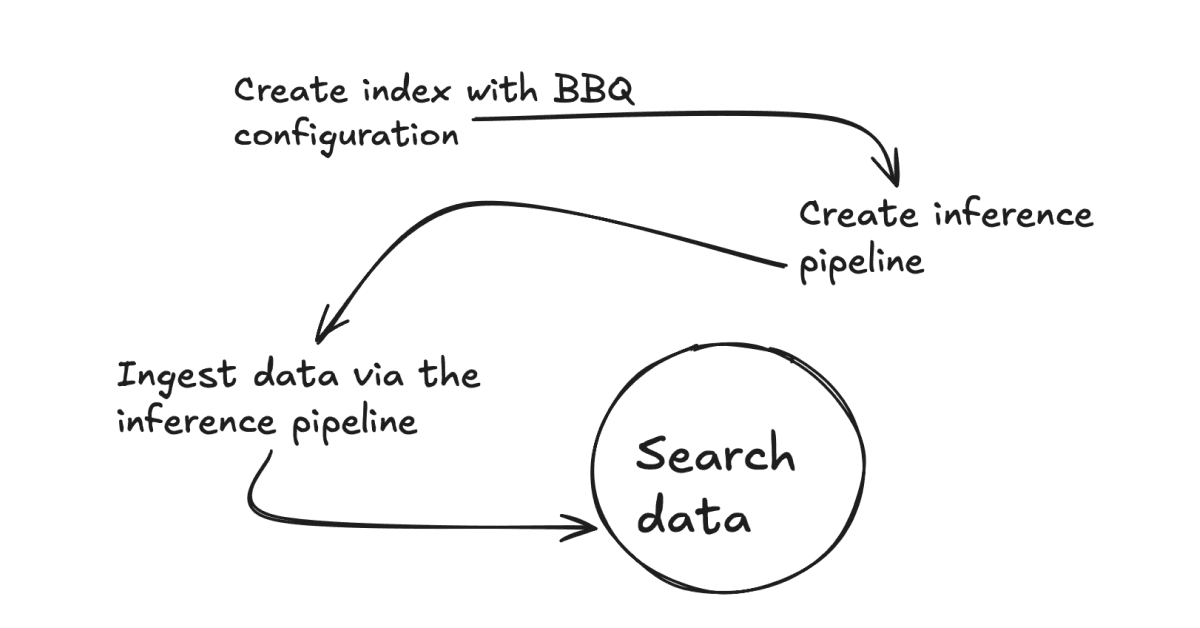

Wie Sie Better Binary Quantization (BBQ) in Ihren Anwendungsfall implementieren können

Erfahren Sie, warum Sie Better Binary Quantization (BBQ) in Ihrem Anwendungsfall einsetzen sollten und wie Sie dabei vorgehen.

15. April 2025

Elasticsearch BBQ vs. OpenSearch FAISS: Leistungsvergleich der Vektorsuche

Ein Leistungsvergleich zwischen Elasticsearch BBQ und OpenSearch FAISS.