Von der Vektorsuche bis hin zu leistungsstarken REST-APIs bietet Elasticsearch Entwicklern das umfangreichste Such-Toolkit. Sehen Sie sich die Beispiel-Notebooks auf GitHub an, um etwas Neues testen. Sie können auch noch heute Ihre kostenlose Testversion starten oder Elasticsearch lokal ausführen.

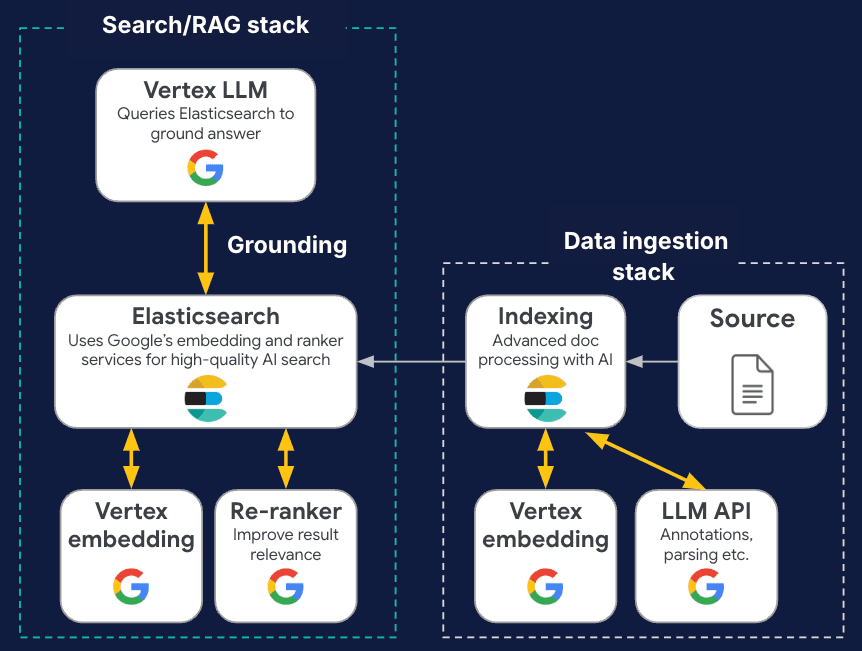

Elastic freut sich, bekannt geben zu können, dass die Vektordatenbank von Elasticsearch jetzt als nativ unterstützte Informationsabruf-Engine in die Vertex AI-Plattform von Google Cloud integriert ist. Dadurch können Benutzer die multimodalen Stärken der Gemini-Modelle von Google mit den erweiterten KI-gestützten semantischen und hybriden Suchfunktionen von Elasticsearch nutzen.

Entwickler können ihre RAG-Anwendungen jetzt im Rahmen eines einheitlichen Prozesses erstellen und ihre Chat-Erlebnisse auf Basis ihrer privaten Daten auf eine flexible und codearme Weise gestalten. Egal, ob Sie KI-Agenten für Ihre Kunden und internen Mitarbeiter entwickeln oder die Generierung von LLMs innerhalb Ihrer Software nutzen, die Vertex AI-Plattform stellt Ihnen die Relevanz von Elasticsearch mit minimalem Konfigurationsaufwand zur Verfügung. Diese Integration ermöglicht eine einfachere und schnellere Einführung von Gemini-Modellen in Produktionsumgebungen und treibt GenAI von Machbarkeitsstudien hin zu realen Anwendungsszenarien voran.

In diesem Blog führen wir Sie durch die Integration von Elasticsearch mit der Vertex AI-Plattform von Google Cloud für eine nahtlose Datenerstellung und die Erstellung vollständig anpassbarer GenAI-Anwendungen. Lassen Sie uns herausfinden, wie.

Die Vertex AI- und Gemini-Modelle von Google Cloud basieren auf Ihren Daten mithilfe von Elasticsearch.

Benutzer, die Vertex AI-Dienste und -Tools zum Erstellen von GenAI-Anwendungen nutzen, können jetzt auf die neue Option „Grounding“ zugreifen, um ihre privaten Daten automatisch in ihre Konversationsinteraktion einzubringen. Elasticsearch ist jetzt Teil dieser Funktion und kann über beides verwendet werden:

- Vertex AI LLM-APIs, die die Gemini-Modelle von Google zum Zeitpunkt der Generierung direkt anreichern (bevorzugt);

- Grounded Generation API, wird stattdessen im Vertex AI Agent Builder-Ökosystem zum Erstellen von Agentenerlebnissen verwendet.

Mit dieser Integration bringt Elasticsearch – die am häufigsten heruntergeladene und eingesetzte Vektordatenbank – Ihre relevanten Unternehmensdaten überall dorthin, wo sie in Ihren internen Chats mit Endkunden benötigt werden. Dies ist für die praktische Einführung von GenAI in Geschäftsprozesse von entscheidender Bedeutung.

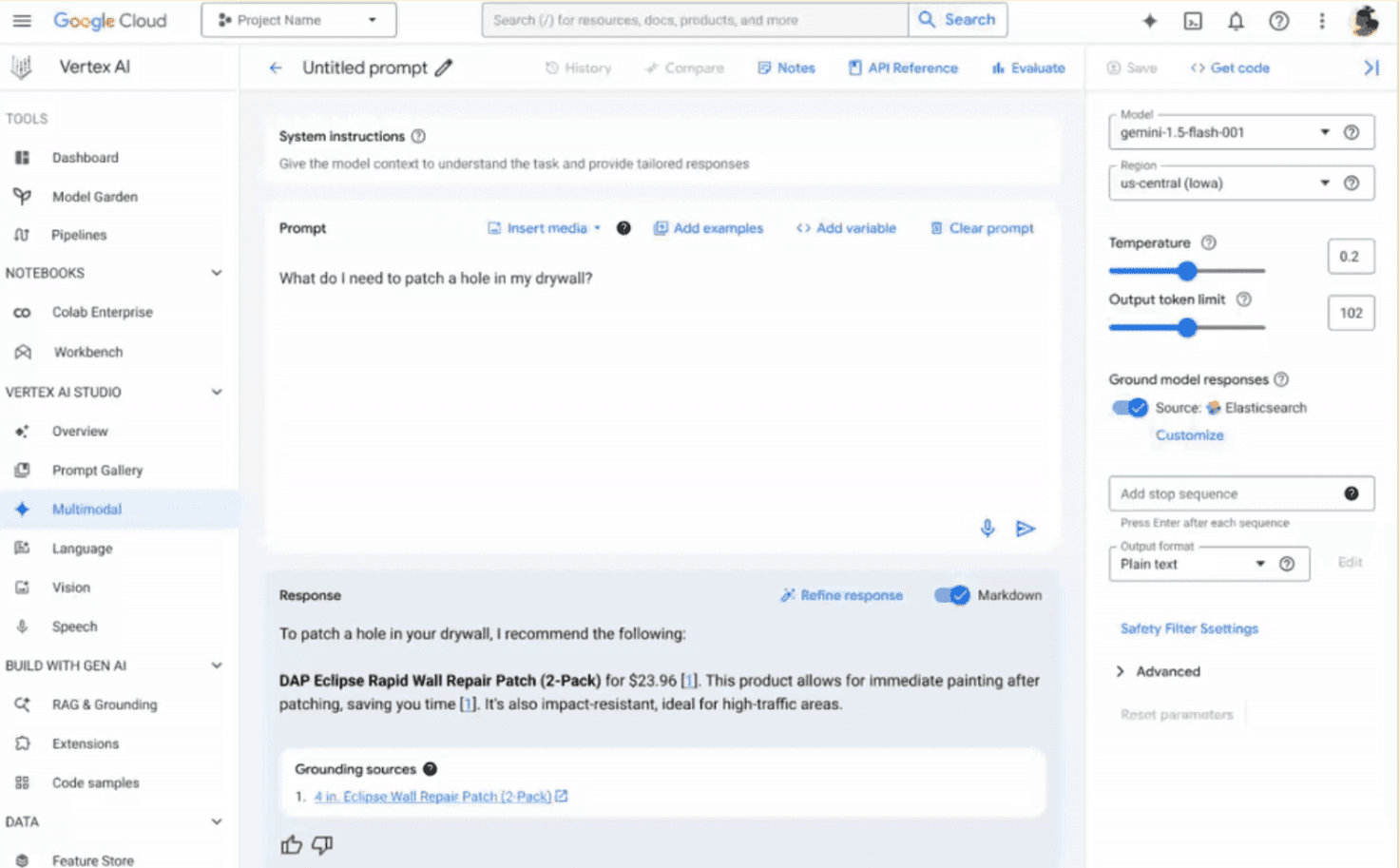

Die oben genannten APIs ermöglichen es Entwicklern, diese neue Partnerfunktion in ihren Code zu übernehmen. Allerdings bleiben die schnelle Entwicklung und das Testen entscheidende Schritte bei der Anwendungsentwicklung und dienen als erste Entdeckungsplattform. Um dies zu unterstützen, ist Elasticsearch für eine einfache Auswertung durch Benutzer innerhalb des Vertex AI Studio-Konsolentools konzipiert.

Es sind nur ein paar einfache Schritte erforderlich, um die Elastic-Endpunkte mit den gewünschten Parametern (zu durchsuchender Index, Anzahl der abzurufenden Dokumente und gewünschte Suchvorlage) auf der Registerkarte „Customize Grounding“ in der Benutzeroberfläche zu konfigurieren, wie unten gezeigt (beachten Sie, dass Sie den API-Schlüssel mit dem Wort „ApiKey“ in die Benutzeroberfläche und die Codebeispiele unten eingeben müssen, damit es funktioniert). Jetzt sind Sie bereit, mit Ihrem privaten Wissen zu generieren!

Produktionsreife GenAI-Anwendungen mit Leichtigkeit

Elastic und Google Cloud arbeiten daran, Entwicklern umfassende und angenehme Erfahrungen zu bieten. Durch die native Verbindung mit Elastic sowohl in LLM als auch in der Grounding Generation API werden Komplexität und Aufwand beim Erstellen von GAI-Anwendungen auf Vertex AI reduziert, wodurch unnötige zusätzliche APIs und Datenorchestrierung vermieden werden und die Erdung in nur einem einheitlichen Aufruf erfolgt.

Sehen wir uns an, wie es in beiden Szenarien funktioniert.

Das erste Beispiel wird mit der LLM-API ausgeführt:

Im obigen Beispiel können wir mit dem Feld retrieval der API, die die Inhaltsgenerierung für Gemini 2.0 Flash anfordert, kontextbezogen eine Abruf-Engine für die Anforderung festlegen. Wenn Sie api_spec auf „ELASTIC_SEARCH“ setzen, können Sie zusätzliche Konfigurationsparameter verwenden, beispielsweise den API-Schlüssel und den Cluster-Endpunkt (erforderlich, um eine Anfrage an Ihren Elastic-Cluster weiterzuleiten), den Index, aus dem die Daten abgerufen werden sollen, und die Suchvorlage, die für Ihre Suchlogik verwendet werden soll.

Dasselbe Ergebnis könnte mit der Grounding Generation API durch Festlegen des Parameters groundingSpec erreicht werden:

Bei beiden Ansätzen erhalten Sie in der Antwort eine Antwort mit den relevantesten privaten Dokumenten, die in Elasticsearch gefunden wurden – und den damit verbundenen Datenquellen – um Ihre Anfrage zu unterstützen.

Einfachheit sollte jedoch nicht mit einem Mangel an Personalisierung verwechselt werden, um Ihre spezifischen Anforderungen und Anwendungsfälle zu erfüllen. Vor diesem Hintergrund haben wir es so konzipiert, dass Sie die Suchkonfiguration perfekt an Ihr Szenario anpassen können.

Vollständig anpassbare Suche auf Knopfdruck: Suchvorlagen

Um eine maximale Anpassung an Ihr Suchszenario zu ermöglichen, haben wir in Zusammenarbeit mit Google Cloud die Erfahrung auf der Grundlage unserer bekannten Suchvorlagen aufgebaut. Elasticsearch-Suchvorlagen sind ein hervorragendes Tool zum Erstellen dynamischer, wiederverwendbarer und wartbarer Suchanfragen. Sie ermöglichen Ihnen, Abfragestrukturen vorzudefinieren und wiederzuverwenden. Sie sind besonders nützlich, wenn ähnliche Abfragen mit unterschiedlichen Parametern ausgeführt werden, da sie Entwicklungszeit sparen und die Wahrscheinlichkeit von Fehlern verringern. Vorlagen können Platzhalter für Variablen enthalten, wodurch die Abfragen dynamisch und an unterschiedliche Suchanforderungen anpassbar werden.

Wenn Sie Vertex AI-APIs und Elasticsearch zur Erdung verwenden, müssen Sie auf eine gewünschte Suchvorlage verweisen – wie in den obigen Codeausschnitten gezeigt –, in der die Suchlogik implementiert und an Elasticsearch weitergeleitet wird. Elastic Power-User können die Suchansätze asynchron verwalten, konfigurieren und aktualisieren und sie auf die spezifischen Indizes, Modelle und Daten zuschneiden. Dies geschieht auf völlig transparente Weise für Vertex AI-Benutzer, Web-App-Entwickler oder KI-Ingenieure, die lediglich den Namen der Vorlage in der Grounding-API angeben müssen.

Dieses Design ermöglicht eine vollständige Anpassung und stellt Ihnen die umfangreichen Elasticsearch-Abruffunktionen in einer Google Cloud AI-Umgebung zur Verfügung. Gleichzeitig wird Modularität, Transparenz und Benutzerfreundlichkeit für verschiedene Entwickler gewährleistet, auch für diejenigen, die mit Elastic nicht vertraut sind.

Wann immer Sie eine BM25-Suche, eine semantische Suche oder einen hybriden Ansatz aus beiden benötigen (Haben Sie Retriever bereits erkundet? Zusammensetzbare Abruftechniken in einem einzigen Such-API-Aufruf) können Sie Ihre benutzerdefinierte Logik in einer Suchvorlage definieren, die Vertex AI automatisch nutzen kann.

Dies gilt auch für Einbettungen und Neurangmodelle, die Sie zur Verwaltung von Vektoren und Ergebnissen auswählen. Je nach Anwendungsfall möchten Sie möglicherweise Modelle auf den ML-Knoten von Elastic hosten, einen Service-Endpunkt eines Drittanbieters über die Inference-API verwenden oder Ihr lokales Modell vor Ort ausführen. Dies ist über eine Suchvorlage möglich und wir werden im nächsten Abschnitt sehen, wie es funktioniert.

Beginnen Sie mit Referenzvorlagen und erstellen Sie dann Ihre eigenen

Damit Sie schnell loslegen können, haben wir eine Reihe kompatibler Suchvorlagenbeispiele bereitgestellt, die Sie als erste Referenz verwenden können. Anschließend können Sie Ihre eigenen Vorlagen ändern und darauf aufbauen:

- Semantische Suche mit ELSER-Modell (spärliche Vektoren und Chunking)

- Semantische Suche mit dem mehrsprachigen e5-Modell (dichte Vektoren und Chunking)

- Hybridsuche mit dem Text-Embedding-Modell von Vertex AI

Sie finden sie in diesem GitHub-Repo.

Sehen wir uns ein Beispiel an: Erstellen von Einbettungen mit den Vertex AI-APIs von Google Cloud in einem Produktkatalog. Zuerst müssen wir die Suchvorlage in Elasticsearch wie unten gezeigt erstellen:

In diesem Beispiel führen wir die KNN-Suche in zwei Feldern innerhalb einer einzigen Suche aus: title_embedding – das Vektorfeld, das den Namen des Produkts enthält – und description_embedding – das Feld, das die Darstellung seiner Beschreibung enthält.

Sie können die excludes -Syntax nutzen, um die Rückgabe unnötiger Felder an das LLM zu vermeiden, da dies zu Störungen bei der Verarbeitung führen und die Qualität der endgültigen Antwort beeinträchtigen kann. In unserem Beispiel haben wir die Felder ausgeschlossen, die Vektoren und Bild-URLs enthalten.

Vektoren werden zum Zeitpunkt der Abfrage auf der übermittelten Eingabe über einen Inferenzendpunkt zur Vertex AI-Einbettungs-API googlevertexai_embeddings_004 im laufenden Betrieb erstellt, der zuvor wie folgt definiert wurde:

Weitere Informationen zur Verwendung der Inference API von Elastic finden Sie hier.

Wir sind jetzt bereit, unsere Vorlagensuche zu testen:

Die Felder params ersetzen die Variablen, die wir in den Vorlagenskripten in doppelten geschweiften Klammern festgelegt haben. Derzeit können die APIs Vertex AI LLM und Grounded Generation die folgenden Eingabevariablen an Elastic senden:

- „query“ – die zu durchsuchende Benutzerabfrage

- „index_name“ – der Name des Index, in dem gesucht werden soll

- „num_hits“ – wie viele Dokumente wir in der endgültigen Ausgabe abrufen möchten

Hier ist eine Beispielausgabe:

Die obige Abfrage ist genau das, was Vertex AI von Google Cloud im Hintergrund auf Elasticsearch ausführt, wenn auf die zuvor erstellte Suchvorlage verwiesen wird. Gemini-Modelle verwenden die Ausgabedokumente, um ihre Antwort zu untermauern: Wenn Sie fragen „Was brauche ich, um meine Trockenbauwand zu flicken?“, erhalten Sie vom Chat-Agenten keinen allgemeinen Vorschlag, sondern konkrete Produkte!

End-to-End-GenAI-Reise mit Elastic und Google Cloud

Elastic arbeitet mit Google Cloud zusammen, um produktionsreife, durchgängige GenAI-Erlebnisse und -Lösungen zu schaffen. Wie wir gerade gesehen haben, ist Elastic der erste ISV, der direkt in die Benutzeroberfläche und das SDK für die Vertex AI-Plattform integriert ist, was nahtlose, fundierte Eingabeaufforderungen und Agenten für Gemini-Modelle mithilfe unserer Vektorsuchfunktionen ermöglicht. Darüber hinaus lässt sich Elastic in die Einbettungs-, Neubewertungs- und Vervollständigungsmodelle von Vertex AI und Google AI Studiointegrieren, um Vektoren zu erstellen und zu bewerten, ohne die Google Cloud-Landschaft zu verlassen, und so die Grundsätze verantwortungsvoller KI sicherzustellen. Durch die Unterstützung multimodaler Ansätze ermöglichen wir gemeinsam Anwendungen über verschiedene Datenformate hinweg.

Sie können Ihren GenAI-Suchcode über unseren Playground optimieren, testen und exportieren.

Aber es geht nicht nur um die Entwicklung von Such-Apps: Elastic nutzt Gemini-Modelle, um den IT-Betrieb zu stärken, beispielsweise in den Elastic AI Assistants, der Angriffserkennung und den Funktionen für den automatischen Import. Dadurch wird die tägliche Ermüdung von Sicherheitsanalysten und SREs bei Aufgaben mit geringem Wert verringert und es ihnen ermöglicht, sich auf die Verbesserung ihres Geschäfts zu konzentrieren. Elastic ermöglicht außerdem eine umfassende Überwachung der Vertex AI-Nutzung und verfolgt Metriken und Protokolle wie Antwortzeiten, Token und Ressourcen, um eine optimale Leistung sicherzustellen. Gemeinsam verwalten wir den gesamten GenAI-Lebenszyklus, von der Datenaufnahme und Einbettungsgenerierung bis hin zur Verankerung mit hybrider Suche, und gewährleisten gleichzeitig eine robuste Beobachtbarkeit und Sicherheit der GenAI-Tools mit LLM-gestützten Aktionen.

Entdecken Sie mehr und probieren Sie es aus!

Haben Sie Interesse, dies auszuprobieren? Die Funktion ist derzeit in Ihren Google Cloud-Projekten allgemein verfügbar!

Falls Sie dies noch nicht getan haben, können Sie am einfachsten mit der Elastic Search AI Platform beginnen und unsere Funktionen erkunden, indem Sie Ihre kostenlose Elastic Cloud-Testversion nutzen oder sich über den Google Cloud Marketplace anmelden.

Die Entscheidung über die Veröffentlichung der in diesem Blogeintrag beschriebenen Leistungsmerkmale und Features sowie deren Zeitpunkt liegt allein bei Elastic. Es ist möglich, dass noch nicht verfügbare Leistungsmerkmale oder Features nicht rechtzeitig oder überhaupt nicht veröffentlicht werden. Elastic, Elasticsearch und zugehörige Marken, Waren- und Dienstleistungszeichen sind Marken oder eingetragene Marken von Elastic N.V. in den USA und anderen Ländern. Alle weiteren Marken- oder Warenzeichen sind eingetragene Marken oder eingetragene Warenzeichen der jeweiligen Eigentümer.

Häufige Fragen

Was ist die Vertex AI-Plattform von Google Cloud?

Vertex AI ist die einheitliche Plattform von Google Cloud für den gesamten Lebenszyklus der künstlichen Intelligenz. Es soll die Lücke zwischen „Forschung“ und „Produktion“ schließen, indem es die besten Tools für maschinelles Lernen (ML) und generative KI von Google zusammenführt.

Welche Vorteile bietet der Einsatz von Elasticsearch auf der Vertex AI-Plattform von Google Cloud?

Der Hauptvorteil der Verwendung von Elasticsearch auf der Vertex AI-Plattform von Google besteht darin, dass nur wenige einfache Schritte erforderlich sind, um die Elastic-Endpunkte mit den gewünschten Parametern zu konfigurieren, wie z. B. dem zu durchsuchenden Index oder der Anzahl der abzurufenden Dokumente.

Welche Ressourcen bietet Elasticsearch, um das Einrichten von Abfragen für Gemini-Modelle zu vereinfachen?

Elasticsearch verfügt über anpassbare Suchvorlagen, mit denen dynamische, wiederverwendbare Suchanfragen erstellt werden können.