2 mars 2026

Arrêt précoce adaptatif pour HNSW dans Elasticsearch

Présentation d'une nouvelle stratégie adaptative d'arrêt précoce pour HNSW dans Elasticsearch.

3 décembre 2025

Indexation vectorielle jusqu'à 12 fois plus rapide dans Elasticsearch avec NVIDIA cuVS : accélération GPU : chapitre 2

Découvrez comment Elasticsearch atteint un débit d'indexation près de 12 fois supérieur grâce à l'indexation vectorielle accélérée par GPU et NVIDIA cuVS.

4 novembre 2025

Recherche multimodale de sommets avec Elasticsearch et SigLIP-2

Apprenez à mettre en œuvre la recherche multimodale texte-image et image-image en utilisant les encastrements SigLIP-2 et la recherche vectorielle Elasticsearch kNN. Objectif du projet : trouver des photos du sommet du mont Ama Dablam prises lors d'un trekking dans l'Everest.

3 novembre 2025

Amélioration de la pertinence des modèles d'intégration multilingues grâce à un système hybride de classement des recherches

Découvrez comment améliorer la pertinence des résultats de recherche du modèle d'intégration multilingue E5 en utilisant le reranker de Cohere et la recherche hybride dans Elasticsearch.

22 octobre 2025

Déploiement d'un modèle d'intégration multilingue dans Elasticsearch

Apprenez à déployer un modèle d'intégration multilingue e5 pour la recherche vectorielle et l'extraction multilingue dans Elasticsearch.

3 septembre 2025

Filtrage de la recherche vectorielle : Garder la pertinence

Il ne suffit pas d'effectuer une recherche vectorielle pour trouver les résultats les plus similaires à une requête. Le filtrage est souvent nécessaire pour réduire les résultats de la recherche. Cet article explique comment fonctionne le filtrage pour la recherche vectorielle dans Elasticsearch et Apache Lucene.

13 mai 2025

Mapping embeddings to Elasticsearch field types : semantic_text, dense_vector, sparse_vector

Discuter comment et quand utiliser semantic_text, dense_vector, ou sparse_vector, et comment ils sont liés à la génération d'embedding.

23 avril 2025

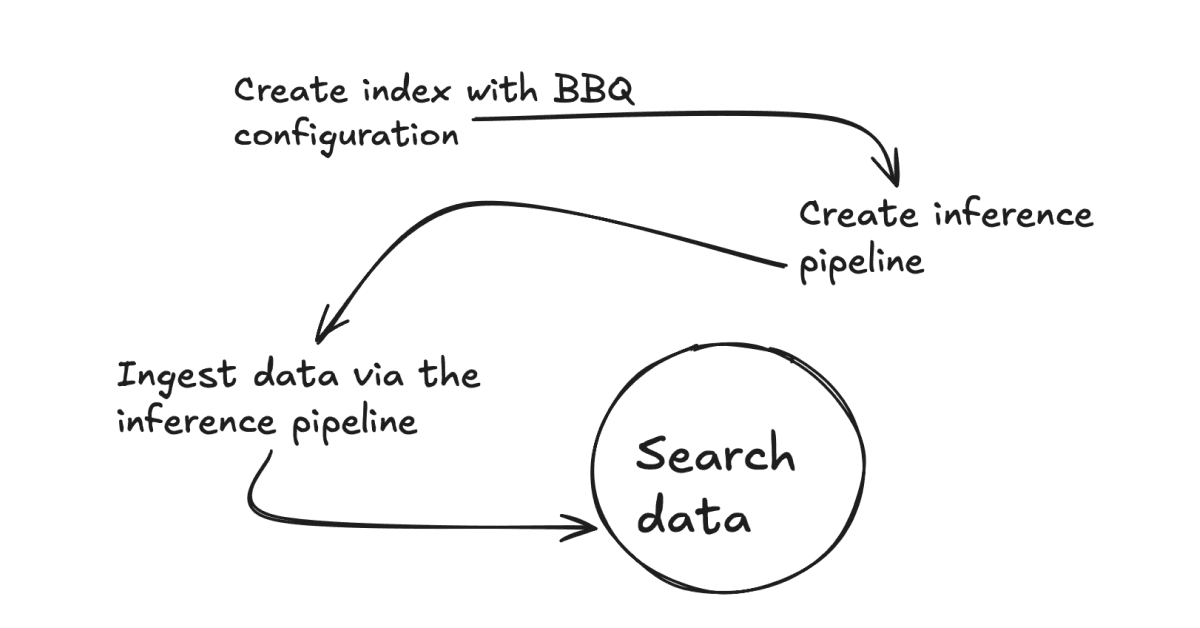

Comment mettre en œuvre une meilleure quantification binaire (BBQ) dans votre cas d'utilisation ?

Expliquez pourquoi vous devriez mettre en œuvre une meilleure quantification binaire (BBQ) dans votre cas d'utilisation et comment le faire.

15 avril 2025

Elasticsearch BBQ vs. OpenSearch FAISS : Comparaison des performances de la recherche vectorielle

Comparaison des performances entre Elasticsearch BBQ et OpenSearch FAISS.