Da busca vetorial às poderosas REST APIs, o Elasticsearch oferece aos desenvolvedores o kit de ferramentas de busca mais abrangente. Mergulhe em notebooks de exemplo no GitHub para experimentar algo novo. Você também pode iniciar seu teste gratuito ou executar o Elasticsearch localmente hoje mesmo.

A Elastic tem o prazer de anunciar que o banco de dados de vetores Elasticsearch agora está integrado à plataforma Vertex AI do Google Cloud como um mecanismo de recuperação de informações com suporte nativo, permitindo que os usuários aproveitem os pontos fortes multimodais dos modelos Gemini do Google com os recursos avançados de pesquisa semântica e híbrida com tecnologia de IA do Elasticsearch.

Os desenvolvedores agora podem criar seus aplicativos RAG em uma jornada unificada, fundamentando suas experiências de bate-papo em seus dados privados de maneira flexível e com pouco código. Seja para criar agentes de IA para seus clientes e funcionários internos ou para aproveitar a geração de LLMs (Modelos de Aprendizagem Baseados em Aprendizagem) em seu software, a plataforma Vertex AI coloca a relevância do Elasticsearch ao seu alcance com configuração mínima. Essa integração permite uma adoção mais fácil e rápida dos modelos Gemini em casos de uso de produção, levando o GenAI de provas de conceito a cenários da vida real.

Neste blog, mostraremos como integrar o Elasticsearch com a plataforma Vertex AI do Google Cloud para obter uma base de dados perfeita e criar aplicativos GenAI totalmente personalizáveis. Vamos descobrir como.

Os modelos Vertex AI e Gemini do Google Cloud são baseados nos seus dados com o Elasticsearch.

Usuários que utilizam serviços e ferramentas da Vertex AI para criar aplicativos GenAI agora podem acessar a nova opção “Grounding” para trazer seus dados privados para suas interações de conversação automaticamente. O Elasticsearch agora faz parte desse recurso e pode ser usado por meio de:

- APIs LLM da Vertex AI, que enriquecem diretamente os modelos Gemini do Google no momento da geração (preferencial);

- API Grounded Generation, usada no ecossistema Vertex AI Agent Builder para criar experiências de agente.

Com essa integração, o Elasticsearch — o banco de dados vetorial mais baixado e implantado — levará seus dados empresariais relevantes para onde forem necessários em seus chats internos com clientes finais, o que é crucial para a adoção real do GenAI em processos de negócios.

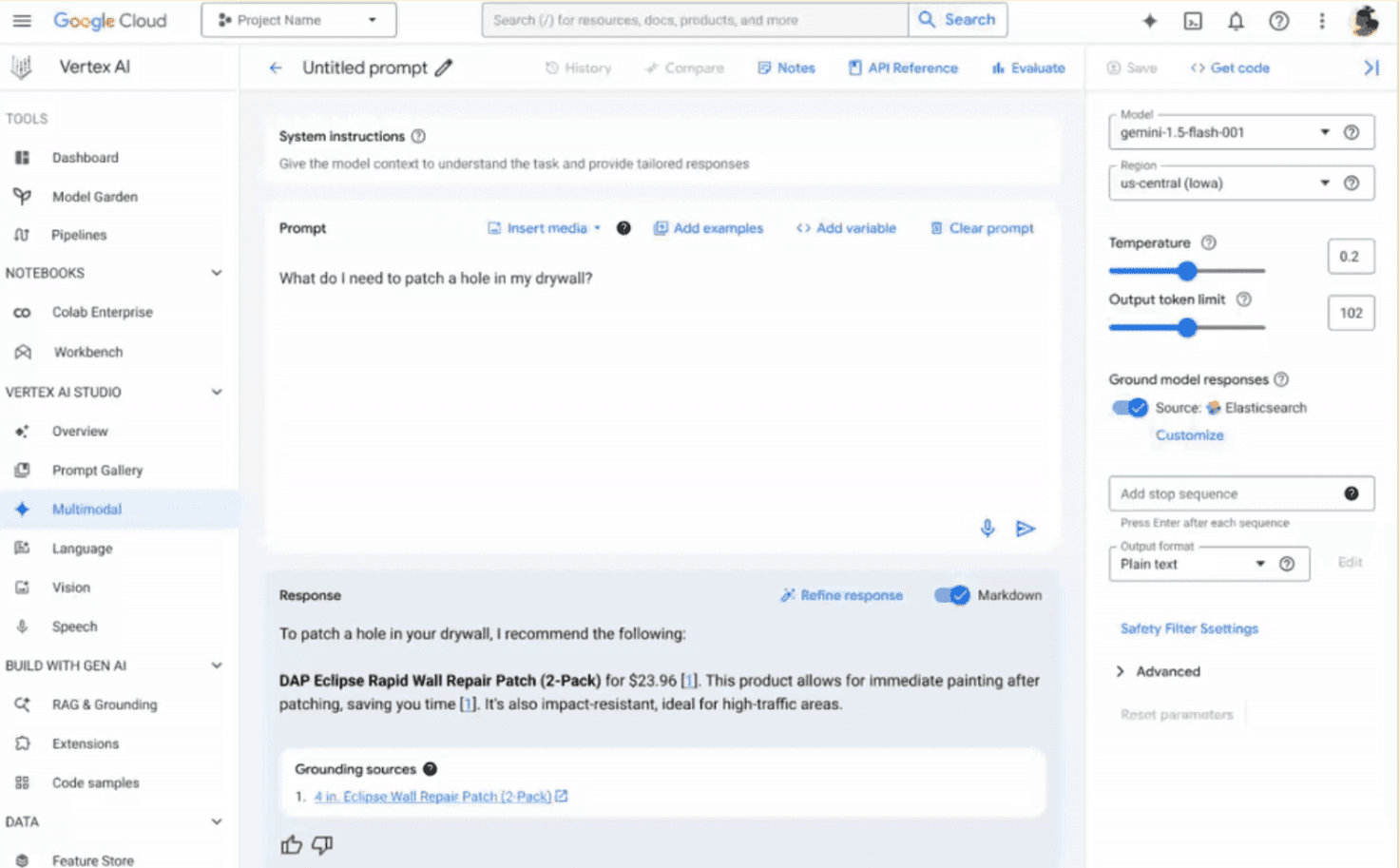

As APIs mencionadas permitirão que os desenvolvedores adotem esse novo recurso de parceria em seu código. No entanto, a engenharia e os testes rápidos continuam sendo etapas cruciais no desenvolvimento do aplicativo e servem como um playground de descoberta inicial. Para dar suporte a isso, o Elasticsearch foi projetado para fácil avaliação pelos usuários na ferramenta de console do Vertex AI Studio.

Bastam alguns passos simples para configurar os endpoints do Elastic com os parâmetros desejados (índice a ser pesquisado, número de documentos a serem recuperados e modelo de pesquisa desejado) na aba “Personalizar aterramento” na interface do usuário, conforme mostrado abaixo (observe que, para que isso funcione, você precisa digitar a chave da API com a palavra "ApiKey" na interface do usuário e nos exemplos de código abaixo). Agora você está pronto para gerar com seu conhecimento privado!

Aplicações GenAI prontas para produção com facilidade

A Elastic e o Google Cloud trabalham para proporcionar experiências completas, agradáveis e voltadas para o desenvolvedor. A conexão nativa ao Elastic no LLM e na Grounding Generation API reduz a complexidade e a sobrecarga ao criar aplicativos GAI no Vertex AI, evitando APIs adicionais desnecessárias e orquestração de dados durante o aterramento em apenas uma chamada unificada.

Vamos ver como isso funciona em ambos os cenários.

O primeiro exemplo é executado com a API LLM:

No exemplo acima, com o campo retrieval da API solicitando geração de conteúdo para o Gemini 2.0 Flash, podemos definir contextualmente um mecanismo de recuperação para a solicitação. Definir api_spec como “ELASTIC_SEARCH” permite o uso de parâmetros de configuração adicionais, como a chave de API e o ponto de extremidade do cluster (necessário para rotear uma solicitação para seu cluster Elastic), o índice do qual recuperar dados e o modelo de pesquisa a ser usado para sua lógica de pesquisa.

Da mesma forma, o mesmo resultado pode ser alcançado com a API Grounding Generation, definindo o parâmetro groundingSpec :

Com ambas as abordagens, a resposta fornecerá uma resposta com os documentos privados mais relevantes encontrados no Elasticsearch – e as fontes de dados conectadas relacionadas – para dar suporte à sua consulta.

Simplicidade, no entanto, não deve ser confundida com falta de personalização para atender às suas necessidades e casos de uso específicos. Pensando nisso, nós o projetamos para permitir que você adapte perfeitamente a configuração de pesquisa ao seu cenário.

Pesquisa totalmente personalizável na ponta dos dedos: modelos de pesquisa

Para fornecer a máxima personalização ao seu cenário de pesquisa, criamos, em colaboração com o Google Cloud, a experiência com base em nossos conhecidos Modelos de Pesquisa. Os modelos de pesquisa do Elasticsearch são uma excelente ferramenta para criar consultas de pesquisa dinâmicas, reutilizáveis e fáceis de manter. Eles permitem que você predefina e reutilize estruturas de consulta. Eles são particularmente úteis ao executar consultas semelhantes com parâmetros diferentes, pois economizam tempo de desenvolvimento e reduzem a chance de erros. Os modelos podem incluir espaços reservados para variáveis, tornando as consultas dinâmicas e adaptáveis a diferentes requisitos de pesquisa.

Ao usar as APIs do Vertex AI e o Elasticsearch para aterramento, você deve referenciar um modelo de pesquisa desejado — conforme mostrado nos trechos de código acima — onde a lógica de pesquisa é implementada e enviada ao Elasticsearch. Usuários avançados do Elastic podem gerenciar, configurar e atualizar de forma assíncrona as abordagens de pesquisa e adaptá-las aos índices, modelos e dados específicos de forma totalmente transparente para usuários do Vertex AI, desenvolvedores de aplicativos da web ou engenheiros de IA, que precisam apenas especificar o nome do modelo na API de aterramento.

Este design permite personalização completa, colocando os amplos recursos de recuperação do Elasticsearch à sua disposição em um ambiente de IA do Google Cloud, ao mesmo tempo em que garante modularidade, transparência e facilidade de uso para diferentes desenvolvedores, mesmo aqueles não familiarizados com o Elastic.

Sempre que você precisar de pesquisa BM25, pesquisa semântica ou uma abordagem híbrida entre as duas (você já explorou os recuperadores ? Técnicas de recuperação componíveis em uma única chamada de API de pesquisa), você pode definir sua lógica personalizada em um modelo de pesquisa, que o Vertex AI pode aproveitar automaticamente.

Isso também se aplica a incorporações e modelos de reclassificação que você escolhe para gerenciar vetores e resultados. Dependendo do seu caso de uso, você pode hospedar modelos nos nós de ML da Elastic, usar um ponto de extremidade de serviço de terceiros por meio da API de Inferência ou executar seu modelo local no local. Isso pode ser feito por meio de um modelo de pesquisa, e veremos como funciona na próxima seção.

Comece com modelos de referência e depois crie os seus próprios

Para ajudar você a começar rapidamente, fornecemos um conjunto de exemplos de modelos de pesquisa compatíveis para serem usados como referência inicial; você pode então modificar e criar seus próprios modelos personalizados com base em:

- Busca Semântica com modelo ELSER (vetores esparsos e fragmentação)

- Pesquisa semântica com modelo multilíngue e5 (vetores densos e fragmentação)

- Pesquisa híbrida com modelo de incorporação de texto Vertex AI

Você pode encontrá-los neste repositório do GitHub.

Vejamos um exemplo: criar embeddings com as APIs Vertex AI do Google Cloud em um catálogo de produtos. Primeiro, precisamos criar o modelo de pesquisa no Elasticsearch, conforme mostrado abaixo:

Neste exemplo, executaremos a pesquisa KNN em dois campos dentro de uma única pesquisa: title_embedding – o campo vetorial que contém o nome do produto – e description_embedding – aquele que contém a representação de sua descrição.

Você pode aproveitar a sintaxe excludes para evitar retornar campos desnecessários ao LLM, o que pode causar ruído em seu processamento e afetar a qualidade da resposta final. Em nosso exemplo, excluímos os campos contendo vetores e URLs de imagens.

Os vetores são criados dinamicamente no momento da consulta na entrada enviada por meio de um ponto de extremidade de inferência para a API de incorporação do Vertex AI, googlevertexai_embeddings_004, definida anteriormente da seguinte forma:

Você pode encontrar informações adicionais sobre como usar a API de Inferência da Elastic aqui.

Agora estamos prontos para testar nossa pesquisa de modelo:

Os campos params substituirão as variáveis que definimos nos scripts de modelo entre colchetes duplos. Atualmente, as APIs Vertex AI LLM e Grounded Generation podem enviar ao Elastic as seguintes variáveis de entrada:

- “consulta” - a consulta do usuário a ser pesquisada

- “index_name” - o nome do índice onde pesquisar

- “num_hits” - quantos documentos queremos recuperar na saída final

Aqui está um exemplo de saída:

A consulta acima é exatamente o que o Vertex AI do Google Cloud executará no Elasticsearch nos bastidores ao consultar o modelo de pesquisa criado anteriormente. Os modelos Gemini usarão os documentos de saída para fundamentar sua resposta: quando você perguntar "O que preciso para consertar minha parede de gesso?" em vez de receber uma sugestão genérica, o agente de chat fornecerá produtos específicos!

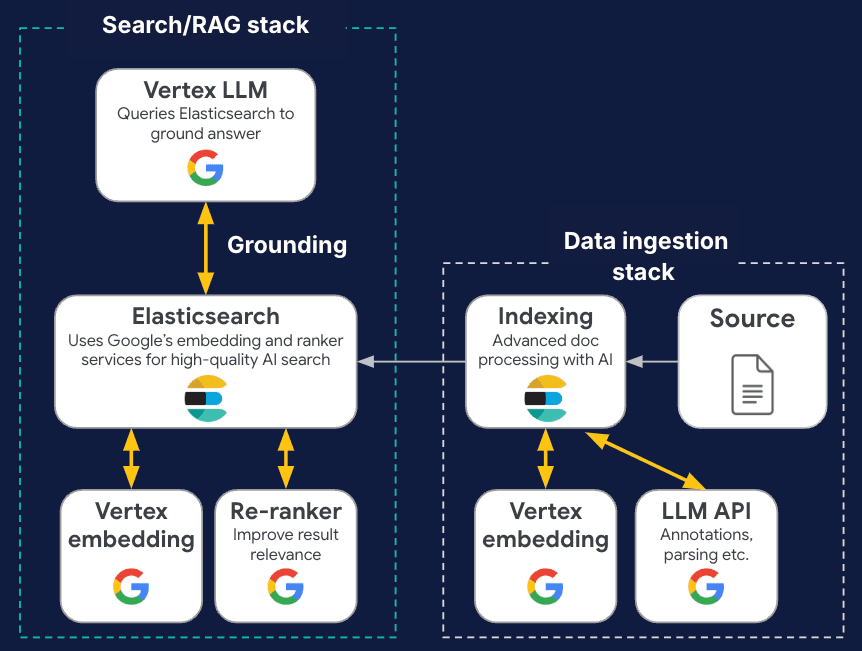

Jornada GenAI de ponta a ponta com Elastic e Google Cloud

A Elastic faz parceria com o Google Cloud para criar experiências e soluções GenAI completas e prontas para produção. Como acabamos de ver, o Elastic é o primeiro ISV a ser integrado diretamente à interface do usuário e ao SDK da plataforma Vertex AI, permitindo prompts e agentes de modelos Gemini integrados e fundamentados usando nossos recursos de pesquisa de vetores. Além disso, o Elastic integra-se aos modelos de incorporação, reclassificação e conclusão do Vertex AI e do Google AI Studiopara criar e classificar vetores sem sair do cenário do Google Cloud, garantindo os princípios da IA responsável . Ao oferecer suporte a abordagens multimodais, facilitamos conjuntamente aplicações em diversos formatos de dados.

Você pode ajustar, testar e exportar seu código de pesquisa GenAI por meio do nosso Playground.

Mas não se trata apenas de criar aplicativos de pesquisa: a Elastic utiliza os modelos Gemini para fortalecer as operações de TI, como nos recursos Elastic AI Assistants, Attack Discovery e Automatic Import, reduzindo a fadiga diária de analistas de segurança e SREs em tarefas de baixo valor e permitindo que eles se concentrem em melhorar seus negócios. O Elastic também permite o monitoramento abrangente do uso do Vertex AI, rastreando métricas e logs, como tempos de resposta, tokens e recursos, para garantir o desempenho ideal. Juntos, gerenciamos o ciclo de vida completo do GenAI, desde a ingestão de dados e geração de incorporação até a consolidação com pesquisa híbrida, ao mesmo tempo em que garantimos a observabilidade e a segurança robustas das ferramentas GenAI com ações baseadas em LLM.

Explore mais e experimente!

Você está interessado em experimentar isso? O recurso está atualmente disponível em seus projetos do Google Cloud!

Se você ainda não o fez, uma das maneiras mais fáceis de começar a usar o Elastic Search AI Platform e explorar nossos recursos é com seu teste gratuito do Elastic Cloud ou assinando pelo Google Cloud Marketplace.

O lançamento e o cronograma de quaisquer recursos ou funcionalidades descritos nesta publicação permanecem a critério exclusivo da Elastic. Quaisquer recursos ou funcionalidades não disponíveis no momento podem não ser entregues no prazo ou não serem entregues. Elastic, Elasticsearch e marcas associadas são marcas comerciais, logotipos ou marcas registradas da Elasticsearch NV nos Estados Unidos e em outros países. Todos os outros nomes de empresas e produtos são marcas comerciais, logotipos ou marcas registradas de seus respectivos proprietários.

Perguntas frequentes

O que é a plataforma Vertex AI do Google Cloud?

O Vertex AI é a plataforma unificada do Google Cloud para todo o ciclo de vida da inteligência artificial. Ele foi projetado para preencher a lacuna entre "pesquisa" e "produção", reunindo as melhores ferramentas de aprendizado de máquina (ML) e inteligência artificial generativa do Google.

Quais são os benefícios de usar o Elasticsearch na plataforma Vertex AI do Google Cloud?

A principal vantagem de usar o Elasticsearch na plataforma Vertex AI do Google é a necessidade de apenas alguns passos simples para configurar os endpoints do Elastic com os parâmetros desejados, como o índice a ser pesquisado ou o número de documentos a serem recuperados.

Quais recursos o Elasticsearch oferece para facilitar a configuração de consultas para modelos Gemini?

O Elasticsearch possui modelos de pesquisa personalizáveis que podem ser usados para criar consultas de pesquisa dinâmicas e reutilizáveis.