2 de março de 2026

Terminação adaptativa precoce para HNSW no Elasticsearch

Introdução de uma nova estratégia adaptativa de terminação antecipada para HNSW no Elasticsearch.

3 de dezembro de 2025

Indexação Vetorial Até 12x Mais Rápida no Elasticsearch com NVIDIA cuVS: Aceleração por GPU - Capítulo 2

Descubra como o Elasticsearch alcança uma taxa de indexação quase 12x maior com indexação vetorial acelerada por GPU e NVIDIA cuVS.

4 de novembro de 2025

Busca multimodal de picos de montanhas com Elasticsearch e SigLIP-2

Aprenda como implementar buscas multimodais de texto para imagem e de imagem para imagem usando embeddings SigLIP-2 e busca vetorial kNN do Elasticsearch. Objetivo do projeto: encontrar fotos do pico do Monte Ama Dablam tiradas durante uma trilha no Everest.

3 de novembro de 2025

Melhorando a relevância de modelos de incorporação multilíngues com reclassificação de busca híbrida.

Aprenda como melhorar a relevância dos resultados de busca do modelo de incorporação multilíngue E5 usando o reranker do Cohere e a busca híbrida no Elasticsearch.

22 de outubro de 2025

Implantação de um modelo de incorporação multilíngue no Elasticsearch

Aprenda como implantar um modelo de incorporação multilíngue e5 para busca vetorial e recuperação multilíngue no Elasticsearch.

3 de setembro de 2025

Filtragem de pesquisa vetorial: Mantenha a relevância

Realizar uma busca vetorial para encontrar os resultados mais semelhantes a uma consulta não é suficiente. Muitas vezes, é necessário usar filtros para refinar os resultados da pesquisa. Este artigo explica como funciona a filtragem para busca vetorial no Elasticsearch e no Apache Lucene.

13 de maio de 2025

Mapeamento de embeddings para tipos de campo do Elasticsearch: semantic_text, dense_vector, sparse_vector

Discutindo como e quando usar semantic_text, dense_vector ou sparse_vector, e como eles se relacionam com a geração de embeddings.

23 de abril de 2025

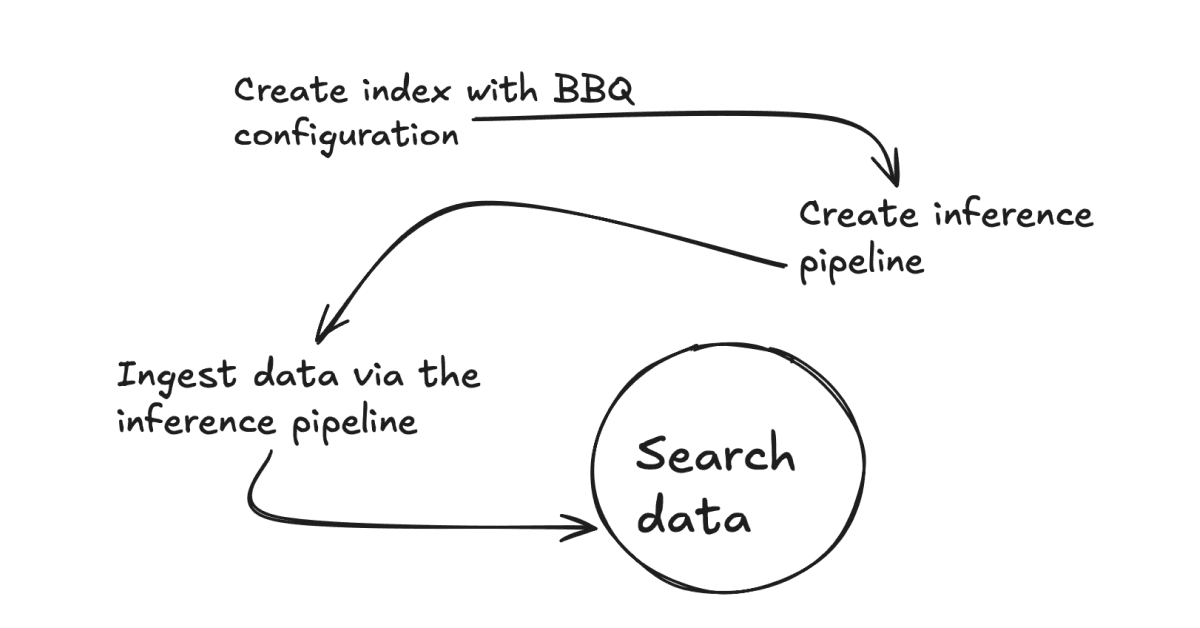

Como implementar a Quantização Binária Aprimorada (BBQ) em seu caso de uso.

Descubra por que você implementaria a Quantização Binária Aprimorada (BBQ) em seu caso de uso e como fazê-lo.

15 de abril de 2025

Elasticsearch BBQ vs. OpenSearch FAISS: Comparação de desempenho de pesquisa vetorial

Uma comparação de desempenho entre o Elasticsearch BBQ e o OpenSearch FAISS.