Was ist ein Web-Crawler?

Definition: Web-Crawler

Ein Web-Crawler ist ein digitaler Suchmaschinen-Bot, der Text- und Metadaten verwendet, um Seiten auf Websites zu entdecken und zu indexieren. Web-Crawler werden manchmal auch als Spider-Bots bezeichnet und durchforsten das Internet, um herauszufinden, womit sich bestimmte Seiten befassen. Anschließend werden die Seiten indexiert und die Informationen zur späteren Verwendung gespeichert.

Beim Indexieren werden die Daten in einem bestimmten Schema oder einer bestimmten Struktur organisiert. Anschließend kann die Suchmaschine die indexierten Daten nutzen, um relevante Suchergebnisse für eine Abfrage zurückzugeben. Ein Web-Crawler ist also ein Tool, der das Surfen im Web erleichtert.

Wir unterscheiden zwischen Internet-Web-Crawlern und Unternehmens-Web-Crawlern. Internet-Web-Crawler durchforsten das Internet und erweitern ihre Crawling-Grenze ständig, indem sie neue Websites entdecken und indexieren. Unternehmens-Web-Crawler durchforsten eine bestimmte Unternehmens-Website, um deren Daten zu indexieren und auffindbar zu machen, wenn ein Nutzer die Suchfunktion der Website verwendet. Diese Crawler können auch als Unternehmenstool eingesetzt werden, um bestimmte Suchvorgänge zu automatisieren.

Wie funktioniert das Web-Crawling?

Beim Web-Crawling werden neue Seiten entdeckt und indexiert und deren Informationen zur späteren Verwendung gespeichert. Ein Crawler kann Ihre Inhalte in bestimmten Intervallen fortlaufend durchforsten, damit die Daten immer aktuell und auffindbar sind.

Seiten entdecken und abrufen

Um Informationen auf möglichst vielen Online-Websites oder Seiten zu finden, verwenden Web-Crawler Links, mit denen sie zwischen Seiten springen.

Ein Web-Crawler beginnt auf einer bekannten URL, einer sogenannten Seed-URL, und verwendet die Links auf dieser Seite, um neue Websites zu entdecken und abzurufen. Dieser Prozess wiederholt sich ständig, wobei immer neue Seiten entdeckt werden. Angesichts der riesigen Anzahl an Webseiten und den ständig aktualisierten Informationen auf diesen Seiten kann dieser Prozess praktisch beliebig fortgesetzt werden.

Links, die ein Crawler findet und zur späteren Entdeckung speichert, bilden die sogenannte Crawling-Grenze. Diese Hyperlinks werden anschließend in einer Reihenfolge besucht, die durch bestimmte Richtlinien oder Crawling-Regeln bestimmt wird. Dazu gehören Auswahlrichtlinien, Wiederholungsrichtlinien, Höflichkeitsrichtlinien und Parallelisierungsrichtlinien.

Web-Crawler berücksichtigen die Anzahl der URLs, die auf eine bestimmte Seite verweisen, sowie die Anzahl der Besuche auf einer bestimmten Seite, um möglichst wichtige Inhalte zu entdecken und zu indexieren. Dahinter steckt die Logik, dass häufig besuchte und verlinkte Seiten autoritative und hochwertige Informationen enthalten. Daher ist es wichtig für die Suchmaschine, die Website zu kennen und sie auffindbar zu machen.

Rendern, Herunterladen und Indexieren von Seiten

Nachdem ein Crawler-Bot eine neue Seite entdeckt hat, rendert er die enthaltenen Informationen, wie etwa Texte und Meta-Tags, lädt sie herunter und indexiert sie. Manche Web-Crawler können nur öffentliche Seiten abrufen oder lesen, während andere Crawler zum Indexieren authentifizierter Seiten berechtigt sind. Außerdem berücksichtigen sie „robots.txt“-Dateien und „noindex“-Metatag-Anforderungen. Eine „robots.txt“-Datei enthält Regeln für Webseiten und legt fest, welchen Links ein Bot folgen darf und welche Informationen er indexieren darf. Ein „noindex“-Metatag unterscheidet Metatags, die nicht für die Indexierung bestimmt sind.

Ständige Wiederholung

Web-Crawler haben den Zweck, Informationen über bestimmte Websites zu indexieren und herunterzuladen. Die Crawler erweitern ihre Crawling-Grenze ständig und suchen nach neuen Websites, Seiten und Aktualisierungen. Daher werden die indexierten Daten der entsprechenden Suchmaschinen ständig erweitert.

Mit ihren Spider-Bots können die Algorithmen der Suchmaschinen die von den Crawlern erstellten Indizes passend sortieren, um sie bei Abfragen abrufen und die Ergebnisse ordnen zu können.

Warum ist Web-Crawling wichtig?

Web-Crawling ist wichtig für Unternehmen, weil Suchmaschinen ansonsten nicht möglich wären. Mit dem Web-Crawling können Suchmaschinen ihre Informationen indexieren und herausfinden, welche Websites und Seiten existieren, um diese Informationen bei Bedarf zurückzugeben.

Auffindbarkeit

Web-Crawling gehört zu einer erfolgreichen SEO- und Suchstrategie, unter anderem, weil die Websites und Informationen von Unternehmen damit auffindbar gemacht werden. Ohne ein erstes Crawling wissen Suchmaschinen nicht, dass Ihre Website oder Ihre Website-Daten existieren. Mit einem internen Crawling Ihrer Site können Sie außerdem Ihre Website-Daten verwalten, damit diese immer aktuell, relevant und bei Bedarf auffindbar sind und damit Sie die richtigen Zielgruppen erreichen.

Nutzerzufriedenheit

Ein Unternehmens-Web-Crawler ist auch wichtig für die Suchfunktionen auf Ihrer Unternehmens-Website. Beim Crawling werden Ihre Website-Daten ohne Aufwand indexiert, und Sie können ein reibungsloses Sucherlebnis anbieten und mit größerer Wahrscheinlichkeit neue Kunden gewinnen.

Automatisierung und Zeiteinsparung

Ein Web-Crawler automatisiert den Datenabruf und führt mit internem und externem Crawling zu mehr Interaktionen mit Ihrer Website. Auf diese Weise können Sie sich darauf konzentrieren, Inhalte zu erstellen und an den richtigen Stellen strategische Änderungen vorzunehmen. Web-Crawling – und die Durchforstbarkeit Ihrer Website – ist also wichtig für den Erfolg Ihres Unternehmens.

Schlüsselkomponenten eines Web-Crawlers

Web-Crawler sind unverzichtbare Tools für Suchmaschinen, daher sind genaue Details zu ihren Komponenten oft geschützte Informationen. Sie tragen zur Unterscheidung von Suchdiensten bei und definieren das Sucherlebnis: Google bietet beispielsweise ein anderes Sucherlebnis als Yandex oder Bing. Außerdem unterscheidet sich das Sucherlebnis auf Ihrer Website von der Ihrer Konkurrenz, je nachdem, wie aktuell, genau und relevant die in Ihren Suchergebnissen zurückgegebenen Informationen sind.

Verschiedene Web-Crawler funktionieren also unterschiedlich, egal ob es sich um Internet- oder Unternehmens-Crawler handelt, haben aber eine gemeinsame Standardarchitektur und einen ähnlichen Funktionsumfang. Sie erhalten eine Anfangs-URL als Eingabe. Von dort aus greifen sie entlang der Crawling-Grenze, einer Liste der vom Crawling-Bot noch nicht besuchten URLs, auf weitere URLs zu.

Gemäß einer Reihe von Richtlinien oder Crawling-Regeln, etwa im Hinblick auf Höflichkeit (was darf der Bot indexieren?) oder wiederholte Besuche (wie oft findet das Crawling statt) besucht der Crawler immer neue URLs.

Dort muss er in der Lage sein, die unter der URL verfügbaren Informationen zu rendern, mit hohem Tempo herunterzuladen, zu indexieren und zur späteren Verwendung in der Suchmaschine zu speichern.

Internet-Crawler werden für eine internetweite Suche eingesetzt, während Unternehmens-Web-Crawler den Inhalt einer bestimmten Website durchsuchbar machen. Sie bieten unter anderem die folgenden Funktionen:

- Umfassende Einblicke in das Crawling-Verhalten, um die Leistung nachverfolgen zu können

- Programmierbarkeit, um den Bot mit flexiblen APIs steuern zu können

- Benutzerfreundliche Schnittstellen

Arten von Web-Crawlern

Web-Crawler können für unterschiedliche Aufgaben programmiert werden. Daher existieren verschiedene Arten von Web-Crawlern.

Fokussierte Web-Crawler: Fokussierte Web-Crawler durchforsten Inhalte im Hinblick auf einen bestimmten Parameter, etwa um Inhalte zu einem bestimmten Thema oder aus einem bestimmten Fachgebiet zu finden. Dazu unterscheiden fokussierte Web-Crawler die Hyperlinks, denen sie folgen, anhand von Wahrscheinlichkeiten.

Inkrementelle Web-Crawler: Inkrementelle Web-Crawler sind Crawler-Bots, die Seiten wiederholt besuchen, um ihre Indizes zu aktualisieren. Dabei werden alte Links bei Bedarf durch neue URLs ersetzt. Mit diesem Prozess werden inkonsistente Downloads von Dokumenten reduziert.

Verteilte Crawler: Verteilte Crawler besuchen gleichzeitig mehrere Websites, um ihre Aufgabe zu erfüllen.

Parallele Crawler: Parallele Crawler sind Crawler-Bots, die mehrere Prozesse gleichzeitig – also parallel – ausführen, um die Download-Effizienz zu verbessern.

Beliebte Suchmaschinen-Bots

Die beliebtesten Crawler-Bots sind die Bots von Internetsuchmaschinen. Dazu gehören:

- BingBot: Der Crawler-Bot von Bing

- GoogleBot: Besteht aus zwei Bots: einem für mobile Plattformen und einem für Desktops

- DuckDuckBot: Der Bot von DuckDuckGo

- Slurp: Der Bot der Yahoo-Suche

- YandexBot: Der Yandex-Bot

- Baiduspider: Der Bot der Baidu-Suchmaschine

Vorteile des Web-Crawling

Das von Suchmaschinen betriebene Web-Crawling bietet ein benutzerfreundliches Sucherlebnis, und Geschäftsanwender profitieren in mehrfacher Hinsicht vom Web-Crawling.

Web-Crawling bietet Unternehmen hauptsächlich den Vorteil, dass ihre Website sowie ihre Inhalte und Daten auffindbar gemacht werden, und ist damit entscheidend für die SEO- und Suchstrategie der Unternehmen. Das Crawlen Ihrer Website ist auch der einfachste Weg, um die enthaltenen Daten für Ihre eigene Suche zu indexieren. Außerdem wirkt sich das Web-Crawling nicht auf die Leistung Ihrer Website aus, da es im Hintergrund abläuft. Mit regelmäßigem Web-Crawling können Sie also die Leistung und das Sucherlebnis Ihrer Website verwalten und sicherstellen, dass sie in Suchmaschinen optimal platziert ist.

Weitere Vorteile des Web-Crawling:

- Integrierte Berichterstellung: Die meisten Web-Crawler bieten Berichterstellungs- oder Analysefunktionen. Diese Berichte werden oft als Tabellenkalkulation oder in andere lesbare Formate exportiert und sind sehr hilfreich für die Verwaltung Ihrer SEO- und Suchstrategie.

- Crawling-Parameter: Als Site-Manager können Sie die Regeln für die Crawling-Häufigkeit festlegen. Sie bestimmen, wie oft der Spider-Bot Ihre Website durchforstet. Da der Bot automatisch ausgeführt wird, müssen Sie die Crawling-Berichte nicht jedes Mal manuell abrufen.

- Automatisierte Indexierung: Mit einem Web-Crawler für Ihre Website können Sie Ihre Daten automatisch indexieren. Sie können steuern, welche Daten durchforstet und indexiert werden, und den Prozess noch weiter automatisieren.

- Lead-Generation: Mit dem Crawling können Sie zusätzliche Markteinblicke gewinnen, neue Chancen erkennen und Leads generieren. Mit dem Crawling als automatischem Such-Tool können Sie einen Prozess beschleunigen, der andernfalls manuell ausgeführt werden müsste.

- Überwachung: Mit Web-Crawlern können Sie Social-Media-Erwähnungen Ihres Unternehmens überwachen und schneller reagieren. Zu Überwachungszwecken eingesetzte Web-Crawler sind ein sehr effektives PR-Werkzeug.

Herausforderungen und Einschränkungen beim Web-Crawling

Die größte Herausforderung beim Web-Crawling ist die riesige Menge an vorhandenen und ständig neu produzierten oder aktualisierten Daten. Crawler suchen ständig nach Links, wobei es jedoch unwahrscheinlich ist, dass sie sämtliche je produzierten Informationen finden. Dies liegt zum Teil an den folgenden Herausforderungen und Einschränkungen:

- Regelmäßige Inhaltsupdates: Suchmaschinenoptimierungsstrategien (SEO) ermutigen Unternehmen dazu, die Inhalte auf ihren Seiten regelmäßig zu aktualisieren. Viele Unternehmen betreiben dynamische Webseiten, deren Inhalte auf Basis der Interaktionen von Besuchern automatisch angepasst werden. Da sich der Quellcode regelmäßig ändert, müssen Web-Crawler die Seiten oft erneut besuchen, um ihre Indizes zu aktualisieren.

- Crawler-Fallen: Manche Websites nutzen absichtlich sogenannte Crawler-Fallen, um zu verhindern, dass die Spider-Bots bestimmte Seiten durchforsten. Häufig verwendete Barrieren für Crawler sind „robots.txt“-Dateien oder „noindex“-Metatags. Diese Elemente dienen zwar dazu, zu verhindern, dass bestimmte Teile einer Website durchforstet und indexiert werden, können aber den Crawler manchmal auch ins Stolpern bringen. In diesem Fall kann es passieren, dass der Bot in einer Crawling-Schleife steckenbleibt, die die Ressourcen des Crawlers und Ihr Crawling-Budget verschwendet.

- Bandbreitennutzung: Beim Herunterladen und Indexieren großer Mengen an Seiten verbrauchen die Web-Crawler oft beträchtliche Netzwerkressourcen und können die Bandbreite belasten.

- Duplizierte Inhalte: Duplizierte Inhalte, egal sie ob durch maschinelle oder menschliche Fehler entstanden sind, können die Indexierung beeinträchtigen. Wenn Crawler Duplikate von Seiten besuchen, indexieren und bewerten sie nur eine Seite. Die Entscheidung, welche Daten heruntergeladen und indexiert werden, ist für den Bot schwierig und für das Unternehmen kontraproduktiv.

Unterschiede zwischen Web-Crawling und Web-Scraping

Der wichtigste Unterschied zwischen Web-Crawling und Web-Scraping besteht darin, dass beim Crawling Daten indexiert und beim Web-Scraping extrahiert werden.

Web-Scraping wird manchmal auch als Web-Harvesting bezeichnet und ist ein gezielterer Prozess als das Crawling. Scraping kann in verschiedenen Größenordnungen durchgeführt werden, um Daten und Inhalte von Sites zu Zwecken wie Marktforschung, Lead-Generation oder Website-Tests zu extrahieren. Die Begriffe Web-Crawling und Web-Scraping werden manchmal synonym verwendet.

Während Web-Crawler im Allgemeinen an Regeln wie „robots.txt“-Dateien und Richtlinien für URL-Grenzen gebunden sind, können Web-Scraper Berechtigungen ignorieren, Inhalte illegal her und die durch ihre Aktivitäten verursachten Serverbelastungen ignorieren.

Zukunftstrends für Web-Crawler

Web-Crawler werden von allen Suchmaschinen eingesetzt und sind eine relativ ausgereifte Technologie. Daher investieren nur wenige Unternehmen in die Entwicklung eigener Versionen. Außerdem existieren Open-Source-Web-Crawler.

Angesichts des exponentiellen Datenwachstums und der zunehmenden Nutzung von unstrukturierten Daten in Unternehmen, werden sich auch Web-Crawling-Technologien weiter an die Anforderungen anpassen. Suchfunktionen sind entscheidend für Unternehmen, und mit dem Aufkommen von KI sind Unternehmens-Web-Crawler der Schlüssel dazu, mit generativer KI möglichst relevante und aktuelle Informationen zu erhalten, indem die Website-Daten regelmäßig durchforstet und indexiert werden.

Viele Unternehmen investieren auch zunehmend im Bereich Web-Scraping, um aktuelle Anwendungsfälle zu erweitern, wie etwa Nachforschungen, Marktforschung, Überwachung von Konkurrenten oder sogar kriminelle Untersuchungen. Opimas schätzt, dass die Ausgaben bis 2025 auf sechs Milliarden US-Dollar steigen werden1.

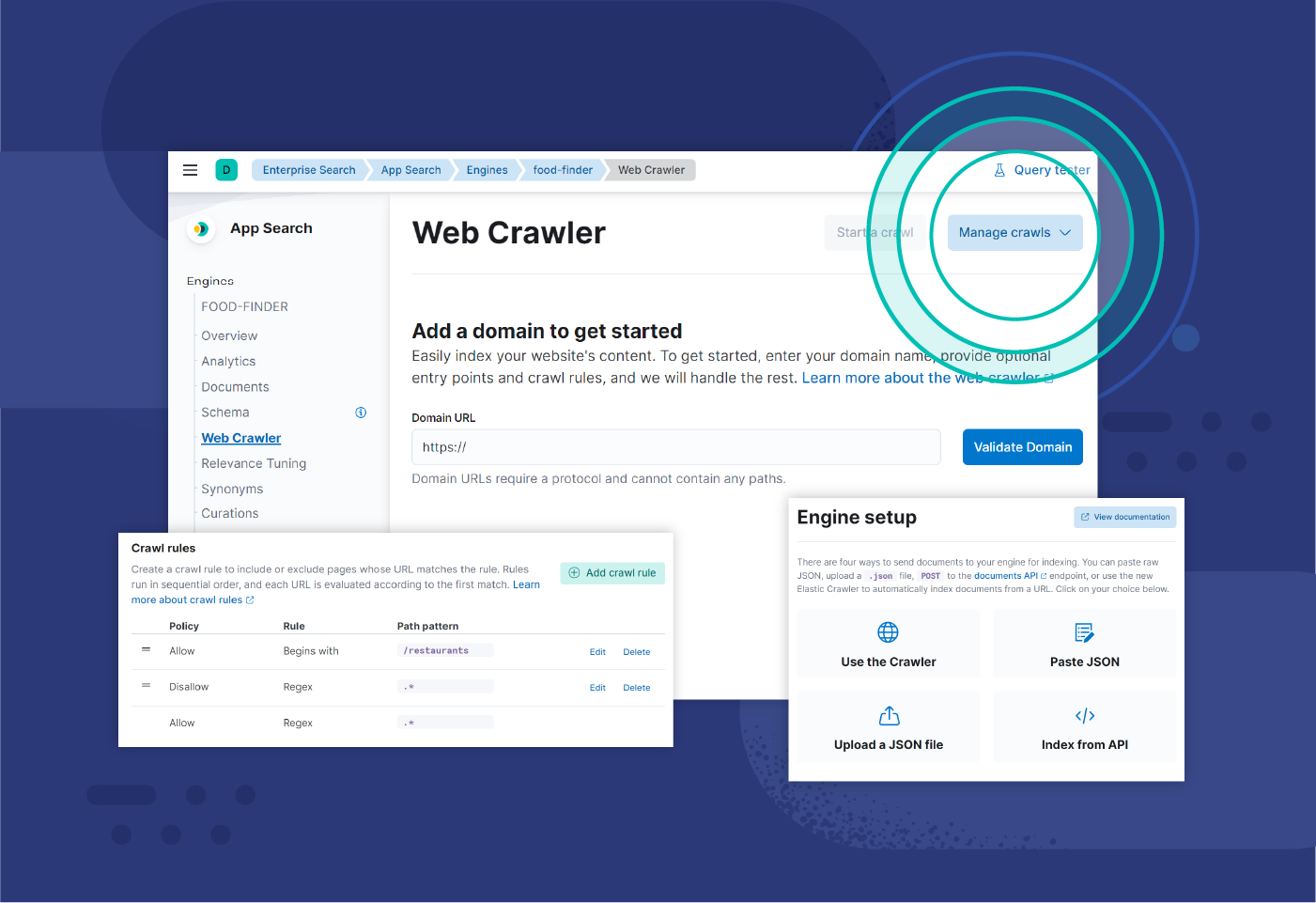

Web-Crawling mit Elastic

Der Elastic-Web-Crawler ist ein Elasticsearch-Tool, mit dem Entwickler die Inhalte auf ihrer Website mühelos indexieren und synchronisieren können. Der Crawler kümmert sich automatisch um die Indexierung, ist sehr einfach zu steuern und gleichzeitig konfigurierbar und überwachbar.

Mit dem produktionsbereiten Web-Crawler von Elastic können Sie Durchläufe automatisch planen, Regeln konfigurieren und authentifizierte Inhalte sowie PDFs durchforsten.

Fußnoten

1 „What's the future of web scraping in 2023?“, Apify Blog, Januar 2023 („Die Zukunft des Web-Crawling für 2023“, in englischer Sprache)