O Agent Builder está disponível agora como prévia técnica. Comece com um teste do Elastic Cloud e confira a documentação do Agent Builder aqui.

Introdução

Este artigo mostrará como criar um agente de IA para RH usando GPT-OSS e Elastic Agent Builder. O agente pode responder às suas perguntas sem enviar dados para a OpenAI, Anthropic ou qualquer serviço externo.

Usaremos o LM Studio para disponibilizar o GPT-OSS localmente e conectá-lo ao Elastic Agent Builder.

Ao final deste artigo, você terá um agente de IA personalizado capaz de responder a perguntas em linguagem natural sobre os dados de seus funcionários, mantendo o controle total sobre suas informações e modelo.

Pré-requisitos

Para ler este artigo, você precisa de:

- Elastic Cloud hospedado na versão 9.2, implantação local ou sem servidor.

- Recomenda-se máquina com 32 GB de RAM (mínimo de 16 GB para GPT-OSS 20B).

- LM Studio instalado

- Docker Desktop instalado

Por que usar GPT-OSS?

Com um LLM local, você tem o controle para implantá-lo em sua própria infraestrutura e ajustá-lo para atender às suas necessidades específicas. Tudo isso mantendo o controle sobre os dados que você compartilha com o modelo e, claro, sem precisar pagar nenhuma taxa de licença a um fornecedor externo.

A OpenAI lançou o GPT-OSS em 5 de agosto de 2025, como parte de seu compromisso com o ecossistema de modelos abertos.

O modelo de parâmetros 20B oferece:

- capacidades de utilização da ferramenta

- Inferência eficiente

- Compatível com o SDK OpenAI

- Compatível com fluxos de trabalho agentes

Comparação de referência:

Fonte de referência.

Arquitetura da solução

A arquitetura é executada inteiramente em sua máquina local. O Elastic (executado em um contêiner Docker) se comunica diretamente com seu LLM local por meio do LM Studio, e o Elastic Agent Builder usa essa conexão para criar agentes de IA personalizados que podem consultar os dados de seus funcionários.

Para obter mais detalhes, consulte esta documentação.

Construindo um agente de IA para RH: Etapas

Dividiremos a implementação em 5 etapas:

- Configure o LM Studio com um modelo local.

- Implante o Elastic local com o Docker.

- Crie o conector OpenAI no Elastic

- Carregar dados de funcionários no Elasticsearch

- Crie e teste seu agente de IA.

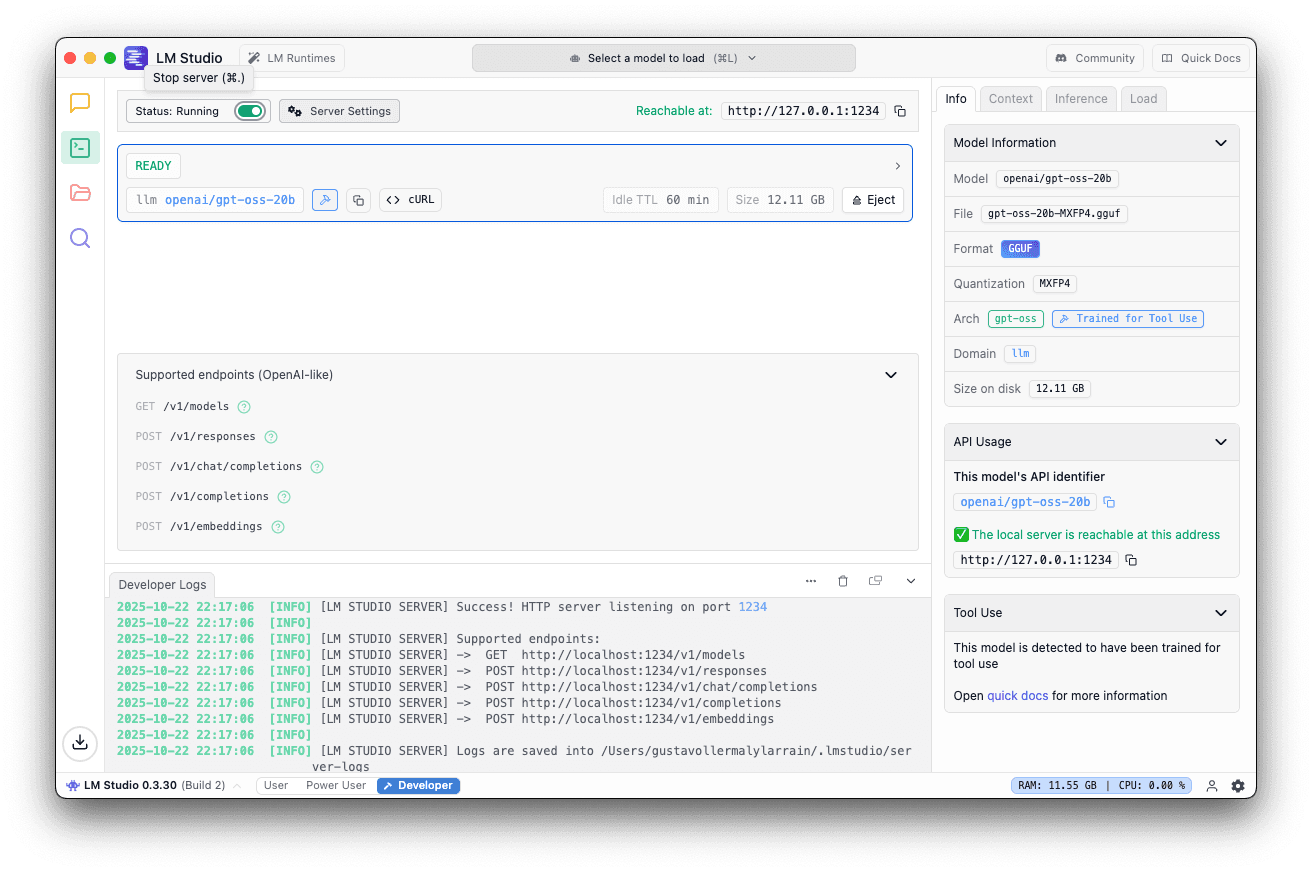

Etapa 1: Configurar o LM Studio com GPT-OSS 20B

O LM Studio é um aplicativo fácil de usar que permite executar grandes modelos de linguagem localmente em seu computador. Ele fornece um servidor de API compatível com OpenAI, facilitando a integração com ferramentas como o Elastic, sem um processo de configuração complexo. Para obter mais detalhes, consulte a documentação do LM Studio.

Primeiro, baixe e instale o LM Studio a partir do site oficial. Após a instalação, abra o aplicativo.

Na interface do LM Studio:

- Acesse a aba de pesquisa e procure por “GPT-OSS”.

- Selecione o

openai/gpt-oss-20bda OpenAI - Clique em baixar

O tamanho deste modelo deverá ser de aproximadamente 12,10 GB. O download pode demorar alguns minutos, dependendo da sua conexão com a internet.

Após o download do modelo:

- Acesse a aba do servidor local.

- Selecione o openai/gpt-oss-20b

- Use a porta padrão 1234

- No painel direito, acesse Carregar e defina o Comprimento do Contexto para 40K ou mais.

5. Clique em Iniciar servidor

Você deverá ver isso se o servidor estiver em execução.

Etapa 2: Implante o Elastic local com o Docker

Agora vamos configurar o Elasticsearch e o Kibana localmente usando o Docker. A Elastic fornece um script prático que lida com todo o processo de configuração. Para obter mais detalhes, consulte a documentação oficial.

Execute o script start-local

Execute o seguinte comando no seu terminal:

Este script irá:

- Baixe e configure o Elasticsearch e o Kibana.

- Inicie ambos os serviços usando o Docker Compose.

- Ative automaticamente uma licença de avaliação Platinum de 30 dias.

Resultado esperado

Aguarde a seguinte mensagem e salve a senha e a chave da API exibidas; você precisará delas para acessar o Kibana:

Acesse o Kibana

Abra seu navegador e acesse:

Faça login utilizando as credenciais obtidas na saída do terminal.

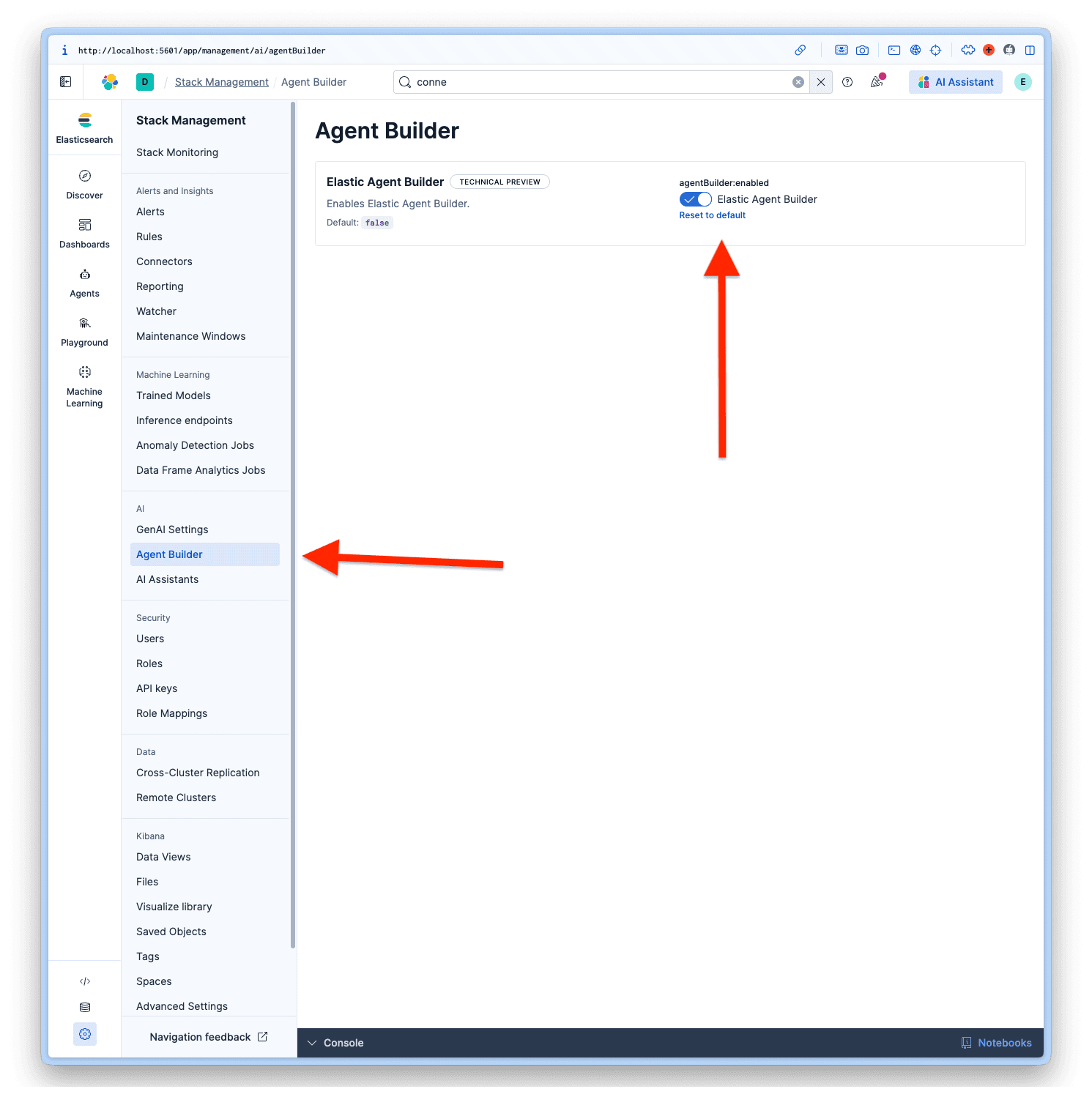

Habilitar o Construtor de Agentes

Após fazer login no Kibana, navegue até Gerenciamento > IA > Construtor de Agentes e ative o Construtor de Agentes.

Etapa 3: Crie o conector OpenAI no Elastic

Agora vamos configurar o Elastic para usar seu LLM local.

Conectores de acesso

- Em Kibana

- Acesse Configurações do projeto > Gerenciamento

- Em Alertas e insights, selecione Conectores.

- Clique em Criar conector

Configure o conector

Selecione OpenAI na lista de conectores. O LM Studio utiliza o SDK da OpenAI, o que o torna compatível.

Preencha os campos com estes valores:

- Nome do conector: LM Studio - GPT-OSS 20B

- Selecione um provedor OpenAI: Outro (Serviço compatível com OpenAI)

- URL:

http://host.docker.internal:1234/v1/chat/completions - Modelo padrão: openai/gpt-oss-20b

- Chave da API: testkey-123 (qualquer texto funciona, pois o LM Studio Server não requer autenticação).

Para finalizar a configuração, clique em Salvar e testar.

Importante: Ative a opção “Habilitar chamada de função nativa”; isso é necessário para que o Construtor de Agentes funcione corretamente. Se você não habilitar isso, você receberá um erro No tool calls found in the response .

Teste a conexão

O Elastic deve testar a conexão automaticamente. Se tudo estiver configurado corretamente, você verá uma mensagem de sucesso como esta:

Resposta.

Etapa 4: Carregar os dados dos funcionários no Elasticsearch

Agora vamos carregar o conjunto de dados de funcionários de RH para demonstrar como o agente trabalha com dados confidenciais. Eu gerei um conjunto de dados fictício com essa estrutura.

Estrutura do conjunto de dados

Criar o índice com mapeamentos

Primeiro, crie o índice com os mapeamentos adequados. Observe que estamos usando campos semantic_text para alguns campos-chave; isso possibilita recursos de busca semântica em nosso índice.

Indexar com API em lote

Copie e cole o conjunto de dados nas suas Ferramentas de Desenvolvedor no Kibana e execute-o:

Verifique os dados

Execute uma consulta para verificar:

Etapa 5: Crie e teste seu agente de IA

Com tudo configurado, é hora de criar um agente de IA personalizado usando o Elastic Agent Builder. Para obter mais detalhes, consulte a documentação da Elastic.

Adicione o conector

Antes de podermos criar nosso novo agente, precisamos configurar nosso construtor de agentes para usar nosso conector personalizado chamado LM Studio - GPT-OSS 20B , porque o padrão é o Elastic Managed LLM. Para isso, precisamos acessar Configurações do Projeto > Gerenciamento > Configurações do GenAI; agora selecionamos a que criamos e clicamos em Salvar.

Construtor de Agentes de Acesso

- Acesse a seção de Agentes.

- Clique em Criar um novo agente

Configure o agente

Para criar um novo agente, os campos obrigatórios são o ID do Agente, o Nome de Exibição e as Instruções de Exibição.

Mas existem mais opções de personalização, como as Instruções Personalizadas, que orientam o comportamento do seu agente e a forma como ele interagirá com as suas ferramentas, de forma semelhante a um prompt do sistema, mas para o nosso agente personalizado. As etiquetas ajudam a organizar seus agentes, a cor do avatar e o símbolo do avatar.

Os agentes que escolhi para o nosso agente, com base no conjunto de dados, são:

ID do agente: hr_assistant

Instruções personalizadas:

Rótulos: Human Resources e GPT-OSS

Nome de exibição: HR Analytics Assistant

Descrição da tela:

Com todos os dados inseridos, podemos clicar em Salvar nosso novo agente.

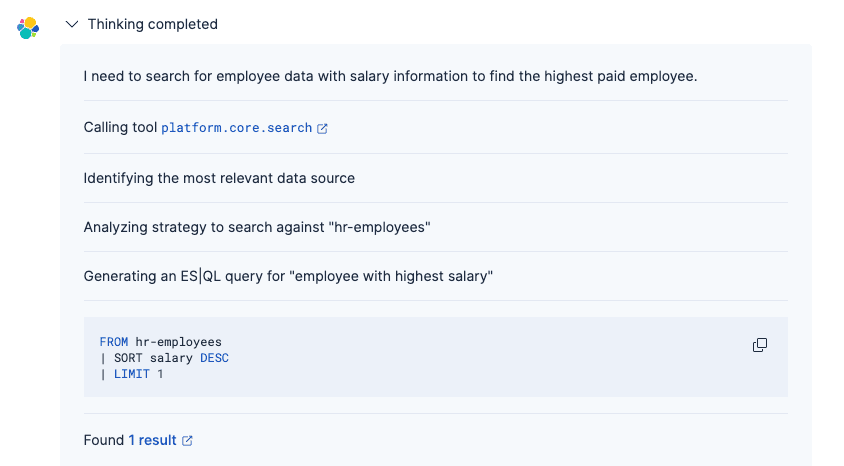

Teste o agente

Agora você pode fazer perguntas em linguagem natural sobre os dados de seus funcionários, e o GPT-OSS 20B entenderá a intenção e gerará uma resposta apropriada.

Incitar:

Responder:

O processo do Agente foi o seguinte:

1. Compreenda sua pergunta usando o conector GPT-OSS.

2. Gere a consulta Elasticsearch apropriada (usando as ferramentas integradas ou ES|QL personalizado).

3. Recuperar registros de funcionários correspondentes

4. Apresentar os resultados em linguagem natural com formatação adequada.

Diferentemente da busca lexical tradicional, o agente baseado em GPT-OSS entende a intenção e o contexto, facilitando a localização de informações sem a necessidade de conhecer os nomes exatos dos campos ou a sintaxe da consulta. Para obter mais detalhes sobre o processo de pensamento do agente, consulte este artigo.

Conclusão

Neste artigo, criamos um agente de IA personalizado usando o Agent Builder da Elastic para conectar-se ao modelo GPT-OSS da OpenAI em execução localmente. Ao implantar o Elastic e o LLM em sua máquina local, essa arquitetura permite que você aproveite os recursos de IA generativa, mantendo o controle total sobre seus dados, tudo isso sem enviar informações para serviços externos.

Utilizamos o GPT-OSS 20B como experimento, mas os modelos oficialmente recomendados para o Elastic Agent Builder podem ser consultados aqui. Se você precisar de recursos de raciocínio mais avançados, existe também a variante com 120 parâmetros , que apresenta melhor desempenho em cenários complexos, embora exija uma máquina com especificações mais altas para ser executada localmente. Para obter mais detalhes, consulte a documentação oficial da OpenAI.