Elasticsearch dispose d'intégrations natives avec les outils et fournisseurs d'IA générative leaders du secteur. Consultez nos webinars sur le dépassement des bases de RAG ou sur la création d'applications prêtes à l'emploi avec la Base vectorielle Elastic.

Pour élaborer les meilleures solutions de recherche pour votre cas d'utilisation, commencez un essai gratuit d'Elastic Cloud ou essayez Elastic sur votre machine locale dès maintenant.

J'ai récemment assisté au sommet des développeurs MCP à San Francisco et il est clair que le protocole MCP (Model Context Protocol) devient rapidement un élément fondamental pour les agents d'intelligence artificielle et les applications d'intelligence artificielle riches en contexte. Chez Elastic, nous nous orientons dans cette direction en exposant les serveurs MCP directement à partir d'Agent Builder, faisant d'Elasticsearch un contexte de premier ordre et un fournisseur d'outils pour tout agent compatible MCP. Dans ce billet, je vais passer en revue les principales mises à jour de l'événement, les cas d'utilisation émergents, ce qui se profile à l'horizon pour MCP, et comment vous pouvez utiliser Agent Builder pour rendre Elasticsearch disponible aux agents via MCP.

Qu'est-ce que le protocole de contexte de modèle (MCP) ?

Pour ceux qui ne connaissent pas, Model Context Protocol est une norme ouverte qui offre un moyen structuré et bidirectionnel de connecter les modèles d'IA à diverses sources de données et à divers outils, ce qui leur permet de générer des réponses plus pertinentes et mieux informées. Il est communément appelé "port USB-C pour les applications d'intelligence artificielle".

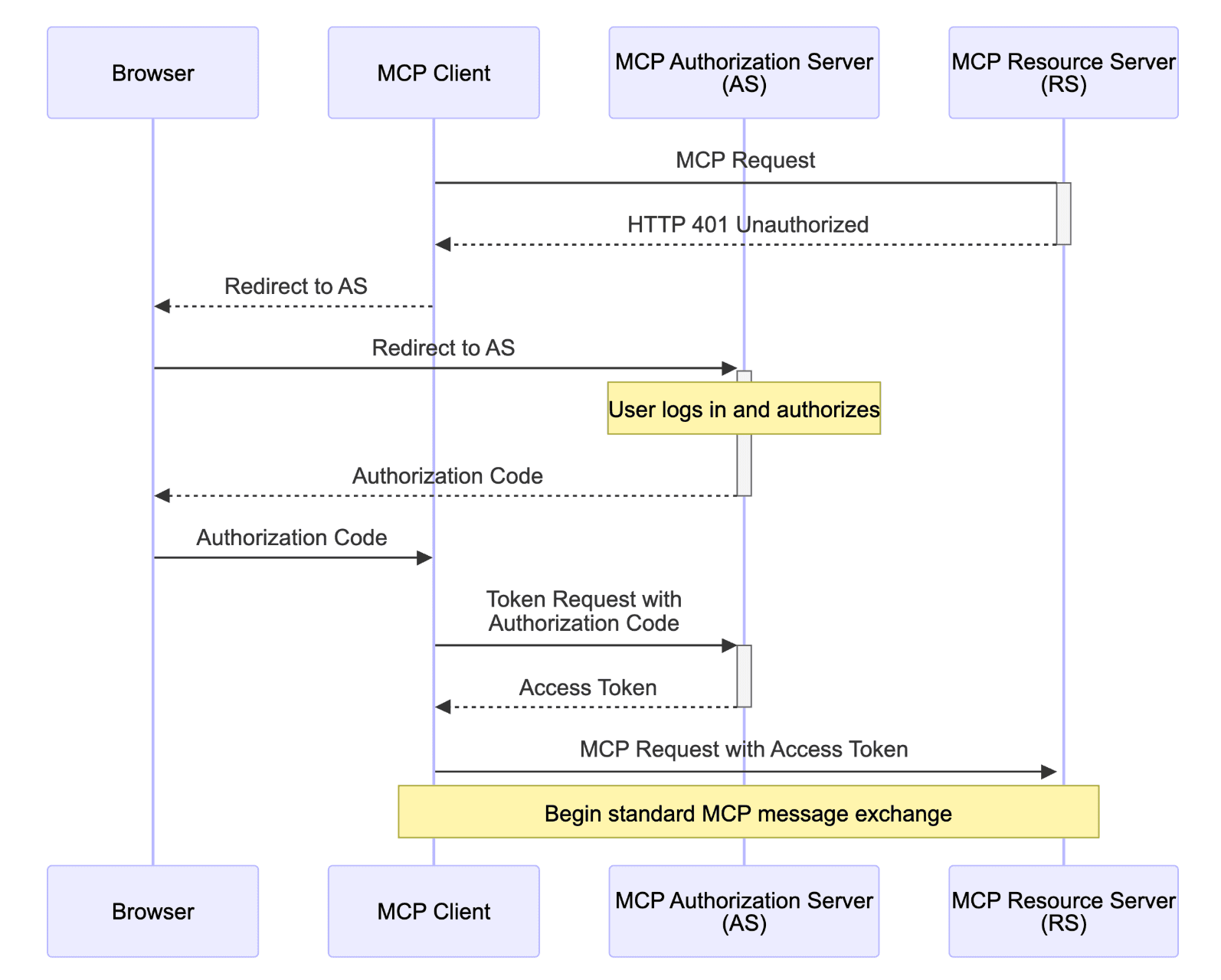

Voici un schéma architectural qui met en évidence son caractère bidirectionnel :

Il s'agit d'un changement important pour les praticiens de l'IA, car l'un des principaux défis de la mise à l'échelle des applications d'IA est de devoir créer des intégrations personnalisées pour chaque nouvelle source de données. MCP offre une architecture durable et réutilisable pour la gestion et la fourniture de contexte aux modèles. Il est indépendant des modèles et des serveurs et est entièrement open source.

MCP est la dernière itération d'une lignée de spécifications d'API visant à normaliser l'intégration entre les applications. Dans le passé, nous avions OpenAPI pour les services RESTful, GraphQL pour l'interrogation des données et gRPC pour la communication des microservices. MCP ne partage pas seulement la rigueur structurée de ces anciennes spécifications, mais l'intègre également dans un cadre d'IA générative, ce qui facilite l'intégration des agents dans différents systèmes sans avoir recours à des connecteurs personnalisés. À bien des égards, MCP vise à faire pour les agents d'intelligence artificielle ce que HTTP a fait pour le web. Tout comme HTTP a normalisé la communication entre les navigateurs et les sites web, MCP cherche à normaliser la façon dont les agents d'intelligence artificielle interagissent avec le monde des données qui les entoure.

MCP par rapport à d'autres protocoles d'agents

Le paysage des protocoles d'agents se développe rapidement, avec plus d'une douzaine de normes émergentes en concurrence pour définir la manière dont les agents interagissent. Laurie Voss de LlamaIndex décrit comment la plupart peuvent être catégorisés en 2 types : les protocoles inter-agents qui se concentrent sur les agents qui parlent entre eux et les protocoles orientés vers le contexte comme MCP qui se concentrent sur la fourniture d'un contexte structuré aux LLMs.

D'autres protocoles populaires comme A2A (Agent to Agent) de Google, ACP (Agent Communication Protocol) de Cisco et IBM, et Agora, visent à permettre les négociations entre agents, la création de coalitions et même des systèmes d'identité décentralisés. MCP adopte une approche un peu plus pragmatique en ce sens qu'il se concentre sur la manière dont les agents accèdent aux outils et aux données et pas nécessairement sur la manière dont ils communiquent entre eux (bien que MCP puisse également permettre cela à l'avenir de différentes manières).

Actuellement, ce qui distingue MCP, c'est sa traction et son élan. Comme React dans les premiers jours des frameworks frontaux, MCP a commencé avec un problème de niche et est maintenant l'un des protocoles d'agent les plus adoptés et les plus extensibles dans la pratique.

Récapitulation du sommet : Évolution des priorités pour le MCP

Le sommet a accueilli des intervenants de Anthropic, Okta, OpenAI, AWS, GitHub et bien d'autres. Les discussions ont porté sur l'amélioration des protocoles de base et sur leur mise en œuvre dans le monde réel, et ont mis en évidence les priorités immédiates et à long terme. Ces exposés ont montré que l'on s'éloignait de l'expérimentation précoce et de l'appel à de simples outils pour passer à la construction de systèmes d'IA fiables, évolutifs et modulaires en utilisant le MCP comme base.

Plusieurs orateurs ont évoqué un avenir où le MCP est plus qu'un simple protocole, il peut devenir le fondement d'un web orienté vers l'intelligence artificielle. Tout comme JavaScript permet aux utilisateurs de cliquer et d'interagir avec les pages web, MCP pourrait permettre aux agents d'effectuer ces mêmes actions en notre nom. Par exemple, dans le domaine du commerce électronique, au lieu de naviguer manuellement sur un site web pour faire des achats, les utilisateurs pourraient simplement demander à un agent de se connecter, de trouver un produit spécifique, de l'ajouter à leur panier et de passer à la caisse.

Il ne s'agit pas non plus d'une pure spéculation ou d'un battage médiatique : PayPal a présenté sa nouvelle boîte à outils pour agents et son serveur MCP lors du sommet, qui permet exactement cette expérience de commerce agentique. Grâce à MCP qui fournit un accès sécurisé et fiable aux outils et aux sources de données, les agents ne se contenteront pas de lire le web, ils pourront agir en conséquence. Aujourd'hui, MCP est déjà une norme puissante qui a le vent en poupe et, à terme, elle pourrait devenir la norme des interactions utilisateur améliorées par l'IA sur l'ensemble du web.

Mise à jour du projet MCP : Transport, élicitation et outils structurés

Jerome Swannack, l'un des principaux contributeurs à MCP, a fait part de quelques mises à jour de la spécification du protocole au cours des six derniers mois. Les principaux objectifs de ces changements sont les suivants

- Pour activer le MCP à distance avec l'ajout du HTTP en continu

- Permettre des modèles d'interaction entre agents plus riches grâce à l'ajout de schémas d'élicitation et de sortie d'outils.

MCP étant un logiciel libre, les développeurs peuvent déjà mettre en œuvre des modifications telles que le protocole HTTP fluide. Les schémas d'élicitation et de sortie de l'outil ne sont pas encore publiés ; ils sont à l'état de projet et peuvent évoluer.

Streamable HTTP (publié le 26 mars 2025): Une mise à jour technique importante a été l'introduction du protocole HTTP en flux continu en tant que nouveau mécanisme de transport. Il remplace les événements envoyés par le serveur (SSE) par un modèle bidirectionnel plus évolutif qui prend en charge le codage de transfert par morceaux et la transmission progressive de messages sur une seule connexion HTTP. Cela vous permet de déployer des serveurs MCP sur une infrastructure cloud comme AWS Lambda et de prendre en charge les contraintes du réseau d'entreprise sans connexions à longue durée de vie ni nécessité de polling.

Elicitation (publié le 18 juin 2025): L'élicitation permet aux serveurs de définir un schéma sur la façon dont ils veulent que le contexte soit structuré à partir d'un client. Essentiellement, le serveur peut décrire ce dont il a besoin et le type d'entrée qu'il attend. Cela a plusieurs implications : Les constructeurs de serveurs peuvent créer des interactions agentiques plus complexes. Les concepteurs de clients peuvent mettre en œuvre des interfaces utilisateur dynamiques qui s'adaptent à ces schémas. Cependant, l'élicitation ne doit pas être utilisée pour extraire des informations sensibles ou personnellement identifiables des utilisateurs. Les développeurs doivent suivre les meilleures pratiques pour s'assurer que les messages d'élicitation restent sûrs et appropriés, en particulier au fur et à mesure que le MCP évolue. Ceci est lié à des problèmes de sécurité plus larges que nous aborderons plus loin dans ce billet.

Schémas de sortie d'outil (publié le 18 juin 2025): Ce concept permet au client et au LLM de connaître à l'avance les formes de sortie de l'outil. Les schémas de sortie des outils permettent aux développeurs de décrire les résultats attendus d'un outil. Ces schémas répondent à l'une des principales limites de l'appel direct d'outils, à savoir l'utilisation inefficace de la fenêtre contextuelle. La fenêtre contextuelle est considérée comme l'une des ressources les plus importantes lorsque vous travaillez avec des LLM. Lorsque vous appelez directement un outil, celui-ci renvoie un contenu brut qui est entièrement transféré dans le contexte du LLM. Les schémas de sortie des outils peuvent vous aider à mieux utiliser vos jetons et la fenêtre contextuelle en permettant au serveur MCP de fournir des données structurées. Voici quelques bonnes pratiques concernant les outils en général.

Ensemble, ces nouvelles mises à jour et les ajouts futurs aideront le MCP à devenir un protocole d'agent plus modulaire, typé et prêt pour la production.

Caractéristiques de puissance sous-utilisées : Échantillonnage et racines

Bien qu'ils ne soient pas nouveaux dans la spécification MCP, l'échantillonnage et les racines ont été mis en évidence lors de la présentation. Ces deux primitives sont actuellement négligées et sous-explorées, mais elles peuvent contribuer de manière significative à des interactions plus riches et plus sûres entre les agents.

Échantillonnage - Les serveurs peuvent demander des compléments au client : L'échantillonnage permet aux serveurs MCP de demander des compléments au LLM côté client. Cela ajoute à la nature bidirectionnelle du protocole, où le serveur ne se contente pas de répondre aux demandes ; il peut inciter et demander au modèle du client de générer une réponse. Cela permet au client de garder un contrôle total sur le coût, la sécurité et le modèle utilisé par le serveur MCP. Ainsi, dans le cas de l'utilisation d'un serveur MCP externe avec un modèle préconfiguré, vous n'aurez pas besoin de fournir vos propres clés API ou de configurer votre propre abonnement à ce modèle, car le serveur peut simplement demander le modèle déjà connecté au client. Cela permet d'obtenir des comportements d'agents plus complexes et plus interactifs.

Racines - Accès limité aux ressources : Lesracines ont été conçues pour permettre aux clients d'informer les serveurs des ressources et des espaces de travail pertinents sur lesquels ils doivent se concentrer. Il s'agit d'un outil puissant pour définir le champ d'action des serveurs. Il est important de noter que les racines sont "informatives et non strictement exécutoires", ce qui signifie qu'elles ne définissent pas de droits ou de permissions pour les serveurs ou les agents MCP. En d'autres termes, vous ne pouvez pas vous fier uniquement aux racines pour empêcher un serveur ou un agent d'exécuter certains outils ou d'effectuer des actions d'écriture. En ce qui concerne les racines, les autorisations doivent toujours être gérées du côté du client, avec des mécanismes d'approbation par l'utilisateur. Par ailleurs, les développeurs doivent toujours veiller à utiliser des serveurs conçus pour respecter les limites fixées par les racines et utiliser les meilleures pratiques.

Authentification des agents : OAuth 2.1 et métadonnées protégées

Cette section se concentre sur OAuth 2.1, la dernière itération d'OAuth 2.0, qui supprime les flux non sécurisés et consolide les meilleures pratiques.

La prise en charge d'OAuth était un sujet très attendu, d'autant plus que la sécurité et l'évolutivité sont considérées comme les principaux obstacles qui empêchent MCP de devenir la norme pour la connexion des agents aux outils. Aaron Parecki (éditeur d'OAuth 2.1 et expert en normes d'identité chez Okta) a expliqué comment MCP peut adopter un flux OAuth propre et évolutif qui décharge les développeurs de serveurs de la majeure partie de la complexité. La spécification d'autorisation officielle OAuth 2.1 a été récemment publiée dans la dernière révision du protocole le 18 juin 2025.

Dans cette implémentation, les responsabilités OAuth peuvent être réparties entre le client MCP et le serveur. La majeure partie du flux d'authentification est initiée et gérée par le client MCP, le serveur n'intervenant qu'à la fin pour recevoir et vérifier le jeton sécurisé. Cette scission permet de résoudre un problème critique de mise à l'échelle, à savoir comment s'authentifier à travers de nombreux outils sans exiger des développeurs qu'ils configurent chaque connexion, et garantit que les développeurs de serveurs MCP n'ont pas à devenir des experts OAuth.

Deux points saillants de l'exposé :

- Métadonnées des ressources protégées: Les serveurs MCP peuvent publier un fichier JSON décrivant leur objectif, leurs points d'accès et leurs méthodes d'authentification. Cela permet aux clients de démarrer des flux OAuth avec seulement l'URL du serveur, ce qui simplifie le processus de connexion. En savoir plus : Corrigeons OAuth dans MCP

- Prise en charge des IDP et du SSO: les entreprises peuvent intégrer des fournisseurs d'identité pour gérer l'accès de manière centralisée. C'est une victoire pour l'expérience de l'utilisateur et la sécurité. Les utilisateurs n'auraient pas besoin de cliquer sur dix écrans de consentement différents et les équipes de sécurité pourraient observer chaque connexion.

En transférant la logique OAuth au client et en s'appuyant sur les métadonnées des serveurs, l'écosystème MCP évite un goulot d'étranglement majeur. Le MCP s'aligne ainsi plus étroitement sur la manière dont les API modernes sont sécurisées dans les environnements de production d'aujourd'hui.

Lecture complémentaire : OAuth 2 simplifié.

Défis de sécurité dans un écosystème composable

Les nouveaux développements s'accompagnent également de nouvelles surfaces d'attaque. Arjun Sambamoorthy, de Cisco, énumère les principales menaces qui pèsent sur le paysage MCP :

| Profils | Description | Remédiation & meilleures pratiques |

|---|---|---|

| Injection rapide & Empoisonnement des outils | Un moyen d'injecter une invite malveillante dans le contexte du système LLM ou dans la description de l'outil, amenant le LLM à effectuer des actions involontaires telles que la lecture de fichiers ou la fuite de données. | Utilisez des outils tels que MCP Scan pour vérifier les métadonnées des outils. Validez les descriptions et les paramètres avant de les inclure dans les invites. Enfin, envisagez de mettre en place des approbations d'utilisateurs pour les outils à haut risque. Pour plus de détails, voir le guide OWASP Prompt Injection dans la liste de lectures complémentaires sous le tableau. |

| Attaques par échantillonnage | Dans le contexte de MCP, l'échantillonnage ouvre la porte au serveur MCP pour effectuer des attaques d'injection rapide sur le LLM. | Désactiver l'échantillonnage pour les serveurs non fiables et envisager d'ajouter des approbations humaines en boucle pour les demandes d'échantillonnage. |

| Serveurs MCP malveillants | Dans les collections actuelles de serveurs MCP, il est difficile de contrôler chacun d'entre eux pour garantir la sécurité. Des serveurs malveillants peuvent discrètement collecter vos données et les exposer à des acteurs malveillants. | Ne vous connectez qu'à des serveurs MCP provenant de registres de confiance ou de listes internes. Exécuter des serveurs tiers dans des conteneurs avec sandboxing. |

| Outils d'installation MCP malveillants | Les installateurs de ligne de commande et les scripts sont pratiques pour mettre en œuvre rapidement des serveurs ou des outils MCP, mais vous risquez d'installer du code non vérifié et compromis. | Installer dans des environnements "sandbox" et valider les signatures des paquets. Ne jamais effectuer de mise à jour automatique à partir de sources non vérifiées. |

Pour lutter contre ce problème, Arjun suggère d'utiliser un registre MCP de confiance pour gérer toutes les vérifications (un sujet qui était au cœur de l'actualité - pour plus de détails, voir les deux premiers éléments de la liste de lecture ci-dessous), ainsi que d'utiliser cette liste de contrôle de la sécurité.

Lecture complémentaire :

- Meilleures pratiques officielles de sécurité MCP

- Top 10 des candidatures au LLM de l'OWASP

- Recherche sur les menaces HiddenLayer

- Scan MCP

- Guide OWASP sur l'injection d'invites

Prochaines étapes : Registres, gouvernance et écosystème

Un registre centralisé des MCP est en cours d'élaboration et a été l'un des sujets les plus discutés lors du sommet. L'écosystème actuel des serveurs souffre de fragmentation, d'un manque de confiance et d'accessibilité. Il est difficile pour les développeurs de trouver des serveurs MCP, de vérifier ce qu'ils font et de les installer en toute sécurité, en particulier dans un écosystème décentralisé où les métadonnées peuvent être incomplètes ou usurpées.

Un registre centralisé répond directement à ces problèmes en agissant comme une source de vérité fiable, en améliorant la découvrabilité, en garantissant l'intégrité des métadonnées du serveur et en réduisant le risque d'installation d'outils malveillants.

Les objectifs du registre MCP sont les suivants :

- Offrir une source unique de vérité pour les métadonnées des serveurs (ce que fait un serveur, comment s'authentifier, l'installer et l'appeler)

- Se débarrasser des registres tiers incomplets et de la fragmentation, de sorte que lorsqu'un serveur veut être enregistré, il n'a pas à mettre à jour tous les autres registres sur l'internet.

- Fournir un flux d'enregistrement de serveur qui comprend un outil CLI et un fichier server.json qui contient les métadonnées mentionnées précédemment.

L'espoir le plus large est qu'un registre fiable aidera à développer l'écosystème en toute sécurité, en permettant aux développeurs de créer et de partager de nouveaux outils en toute confiance.

La gouvernance est une autre question prioritaire pour Anthropic. Ils ont clairement indiqué que le projet MCP devait rester ouvert et dirigé par la communauté, mais la mise à l'échelle de ce modèle de gouvernance est encore un travail en cours. Ils recherchent actuellement de l'aide dans ce domaine et demandent à toute personne ayant de l'expérience en matière de gouvernance dans les protocoles à source ouverte de les contacter. Cela nous amène à l'autre sujet que je voulais aborder. Tout au long de l'événement, les intervenants ont insisté sur le fait que l'écosystème ne peut se développer qu'avec les contributions des développeurs. Un effort concentré est nécessaire pour faire de MCP la nouvelle norme web et se démarquer des autres protocoles d'agents populaires.

MCP dans le monde réel : Études de cas et démonstrations

Plusieurs organisations ont expliqué comment le MCP est déjà utilisé dans des applications pratiques :

- PayPal - Serveur MCP pour le commerce agentique : PayPal a présenté son nouvel agent-toolkit et son serveur MCP, qui peuvent changer fondamentalement l'expérience d'achat d'un utilisateur. Au lieu de parcourir les médias sociaux pour trouver des articles, comparer les prix et passer à la caisse, les utilisateurs peuvent discuter avec un agent qui se connecte au serveur MCP de PayPal pour gérer toutes ces actions.

- EpicAI.pro - Jarvis : Les développements de MCP nous rapprochent de plus en plus d'un véritable assistant de type Jarvis. Pour ceux qui ne connaissent pas les films d'Iron Man, Jarvis est un assistant IA qui utilise le langage naturel, répond aux entrées multimodales, n'a aucune latence lorsqu'il répond, est proactif en anticipant les besoins de l'utilisateur, gère automatiquement les intégrations et peut passer d'un appareil à l'autre et d'un lieu à l'autre en fonction du contexte. Si nous imaginons Jarvis comme un assistant robotique physique, MCP lui donne des "mains" ou la capacité de gérer des tâches complexes.

- Postman - Générateur de serveur MCP: Fournit une expérience de panier pour les demandes d'API où vous pouvez choisir différentes demandes d'API, les mettre dans un panier et télécharger l'ensemble du panier en tant que serveur MCP.

- Bloomberg - Bloomberg a résolu un goulot d'étranglement important dans le développement de la GenAI en entreprise. Avec près de 10 000 ingénieurs, la société avait besoin d'un moyen standardisé pour intégrer les outils et les agents au sein des équipes. Avec MCP, ils ont transformé leurs outils internes en composants modulaires à distance que les agents peuvent facilement appeler sur une interface unifiée. Cela a permis à leurs ingénieurs de fournir des outils à l'ensemble de l'organisation, tandis que les équipes d'intelligence artificielle se sont concentrées sur la création d'agents plutôt que sur des intégrations personnalisées. Bloomberg prend désormais en charge des flux de travail d'agents évolutifs et sécurisés qui débloquent une interopérabilité totale avec l'écosystème MCP. Bloomberg n'a lié aucune ressource publique, mais c'est ce qu'ils ont présenté en public lors du sommet.

- Block - Block utilise MCP pour alimenter Goose, un agent d'intelligence artificielle interne qui permet aux employés d'automatiser des tâches dans les domaines de l'ingénierie, des ventes, du marketing, etc. Ils ont construit plus de 60 serveurs MCP pour des outils tels que Git, Snowflake, Jira et Google Workspace afin de permettre une interaction en langage naturel avec les systèmes qu'ils utilisent tous les jours. Les employés de Block utilisent désormais Goose pour interroger les données, détecter les fraudes, gérer les incidents, naviguer dans les processus internes et bien plus encore, le tout sans avoir à écrire de code. MCP a aidé Block à adopter l'IA dans de nombreuses fonctions en seulement 2 mois.

- AWS - Serveurs MCP AWS: AWS a présenté un serveur MCP amusant sur le thème de Donjons et Dragons qui simule un lancer de dés, suit les lancers passés et renvoie les résultats à l'aide de HTTP en continu. Cet exemple léger a mis en évidence la facilité avec laquelle il est possible de construire et de déployer des serveurs MCP à l'aide d'outils et d'infrastructures AWS comme Lambda et Fargate. Ils ont également présenté Strands SDK, un kit d'outils open-source pour la création d'agents multimodaux qui interagissent avec les serveurs MCP.

Support MCP dans Elastic Agent Builder

Vous pouvez commencer à expérimenter MCP dès aujourd'hui en utilisant Elastic Agent Builder, qui est le moyen le plus simple de créer des agents directement à partir de vos données. Agent Builder vous permet d'exposer des outils basés sur Elasticsearch à des agents compatibles avec MCP et il est déjà livré avec quelques outils intégrés puissants, notamment :

platform.core.search- Exécute des recherches à l'aide du DSL Elasticsearch Query complet.platform.core.list_indices- Liste de tous les index disponibles dans Elasticsearch (aide les agents à découvrir les données existantes)platform.core.get_index_mapping- Récupère les correspondances de champs pour un index spécifique (aide les agents à comprendre la forme et les types de vos données).platform.core.get_document_by_id- Recherche d'un document spécifique par son numéro d'identification (pour une recherche précise)

Grâce à ces outils, vous pouvez doter votre agent d'une fonction de recherche et de pertinence au niveau de l'entreprise, ce qui est essentiel pour créer des agents d'intelligence artificielle fiables.

Ce qui rend Agent Builder encore plus puissant, c'est la possibilité de définir et d'exposer vos propres outils personnalisés, adaptés aux besoins de votre application. Ceci est particulièrement utile pour les flux de travail basés sur l'opinion ou répétables lorsque vous souhaitez que l'agent effectue un type de recherche spécifique sur un index spécifique sans avoir à redécouvrir cette logique à chaque fois. Au lieu de dépenser des jetons en planification et en raisonnement pour arriver à la même conclusion, vous pouvez encoder cette intention directement dans un outil, ce qui rend vos agents plus rapides, plus fiables et plus rentables.

Dans l'interface utilisateur de l'Agent Builder, voici un exemple de définition d'outil personnalisé qui utilise ES|QL :

Une fois que vous avez défini vos outils personnalisés, vous pouvez les exposer (ainsi que les outils natifs intégrés) à l'aide de MCP en cliquant sur la liste déroulante Manage MCP et en copiant l'URL du serveur MCP.

Vous pouvez maintenant importer ce point de terminaison MCP dans n'importe quel client qui consomme MCP pour le connecter à Agent Builder et lui donner accès à tous les outils disponibles. Pour plus d'informations, lisez cette introduction à Agent Builder.

Conclusion

Le MCP Dev Summit a clairement montré que le MCP façonne la manière dont ces agents d'intelligence artificielle interagissent entre eux et avec le monde des données qui les entoure. Qu'il s'agisse de connecter un agent aux données de l'entreprise ou de concevoir des agents entièrement autonomes, MCP offre une méthode d'intégration normalisée et composable qui devient rapidement utile à grande échelle. Des protocoles de transport et des modèles de sécurité aux registres et à la gouvernance, l'écosystème MCP mûrit rapidement. Le programme MCP restera ouvert et axé sur la communauté, de sorte que les développeurs d'aujourd'hui ont la possibilité de façonner son évolution.

Questions fréquentes

1. Qu'est-ce que le protocole de contexte de modèle (MCP) ?

Model Context Protocol est une norme ouverte qui offre un moyen structuré et bidirectionnel de connecter les modèles d'intelligence artificielle à diverses sources de données et à divers outils, ce qui leur permet de générer des réponses plus pertinentes et mieux informées.

2. Comment le MCP se compare-t-il aux autres protocoles d'agents ?

La plupart des protocoles d'agents peuvent être classés en deux catégories : les protocoles inter-agents qui se concentrent sur la communication entre les agents et les protocoles orientés vers le contexte, comme le MCP, qui se concentrent sur la fourniture d'un contexte structuré aux LLM.

3. Quels types d'outils peuvent être exposés par le serveur MCP d'Elastic ?

Les outils suivants peuvent être exposés par le serveur MCP d'Elastic : La fonction list_indices : Liste tous les index Elasticsearch disponibles get_mappings : Obtenez les mappings de champs pour un index Elasticsearch spécifique. search : Effectuez une recherche Elasticsearch avec la requête DSL fournie. get_shards : Obtenir des informations sur les tessons pour l'ensemble des indices ou pour des indices spécifiques.