Agent Builder ist jetzt allgemein verfügbar (GA). Starten Sie mit einer Elastic Cloud-Testversion und sehen Sie sich hier die Dokumentation für Agent Builder an.

Einleitung

Dieser Artikel zeigt Ihnen, wie Sie mit GPT-OSS und Elastic Agent Builder einen KI-Agenten für HR erstellen. Der Agent kann Ihre Fragen beantworten, ohne Daten an OpenAI, Anthropic oder einen externen Dienst zu senden.

Wir werden LM Studio verwenden, um GPT-OSS lokal bereitzustellen und es mit dem Elastic Agent Builder zu verbinden.

Am Ende dieses Artikels verfügen Sie über einen individuell angepassten KI-Agenten, der Fragen in natürlicher Sprache zu Ihren Mitarbeiterdaten beantworten kann und gleichzeitig die volle Kontrolle über Ihre Informationen und Ihr Modell behält.

Voraussetzungen

Für diesen Artikel benötigen Sie:

- Elastic Cloud- gehostete Version 9.2, serverlose oder lokale Bereitstellung

- Empfohlen wird ein Rechner mit 32 GB RAM (mindestens 16 GB für GPT-OSS 20B).

- LM Studio installiert

- Docker Desktop installiert

Warum GPT-OSS verwenden?

Mit einem lokalen LLM haben Sie die Kontrolle, es in Ihrer eigenen Infrastruktur einzusetzen und es genau an Ihre Bedürfnisse anzupassen. All dies, während Sie die Kontrolle über die Daten behalten, die Sie mit dem Modell teilen, und natürlich müssen Sie keine Lizenzgebühr an einen externen Anbieter zahlen.

OpenAI veröffentlichte GPT-OSS am 5. August 2025 als Teil seines Engagements für das offene Ökosystem von Computermodellen.

Das Parametermodell 20B bietet:

- Werkzeugnutzungsfähigkeiten

- Effiziente Schlussfolgerung

- OpenAI SDK-kompatibel

- Kompatibel mit agentenbasierten Workflows

Vergleich der Benchmarks:

Benchmark- Quelle.

Lösungsarchitektur

Die Architektur läuft vollständig auf Ihrem lokalen Rechner. Elastic (läuft in Docker) kommuniziert direkt mit Ihrem lokalen LLM über LM Studio, und der Elastic Agent Builder nutzt diese Verbindung, um benutzerdefinierte KI-Agenten zu erstellen, die Ihre Mitarbeiterdaten abfragen können.

Weitere Einzelheiten entnehmen Sie bitte dieser Dokumentation.

Entwicklung eines KI-Agenten für die Personalabteilung: Schritte

Wir werden die Implementierung in 5 Schritte unterteilen:

- Konfigurieren Sie LM Studio mit einem lokalen Modell

- Lokalen Elastic-Speicher mit Docker bereitstellen

- Erstellen Sie den OpenAI-Konnektor in Elastic

- Mitarbeiterdaten in Elasticsearch hochladen

- Erstellen und testen Sie Ihren KI-Agenten

Schritt 1: LM Studio mit GPT-OSS 20B konfigurieren

LM Studio ist eine benutzerfreundliche Anwendung, mit der Sie große Sprachmodelle lokal auf Ihrem Computer ausführen können. Es bietet einen OpenAI-kompatiblen API-Server, wodurch die Integration mit Tools wie Elastic ohne komplexen Einrichtungsprozess vereinfacht wird. Weitere Details finden Sie in der LM Studio-Dokumentation.

Laden Sie zunächst LM Studio von der offiziellen Website herunter und installieren Sie es. Nach der Installation öffnen Sie die Anwendung.

In der LM Studio-Oberfläche:

- Gehen Sie zum Suchfeld und suchen Sie nach „GPT-OSS“.

- Wählen Sie

openai/gpt-oss-20baus OpenAI aus. - Klicken Sie auf „Herunterladen“.

Die Größe dieses Modells sollte ungefähr 12,10 GB betragen. Der Download kann je nach Ihrer Internetverbindung einige Minuten dauern.

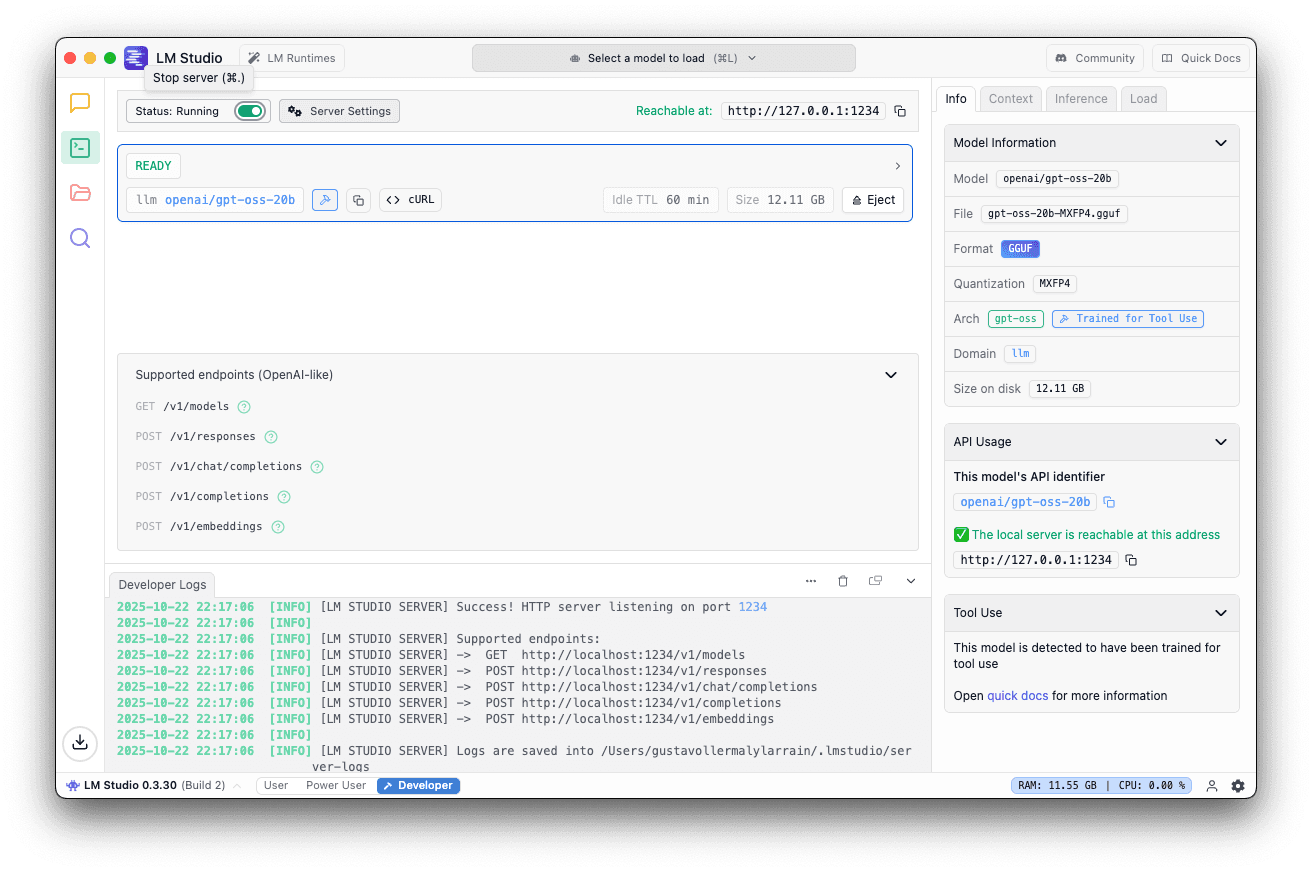

Sobald das Modell heruntergeladen ist:

- Wechseln Sie zur Registerkarte „Lokaler Server“.

- Wählen Sie openai/gpt-oss-20b aus.

- Verwenden Sie den Standardport 1234.

- Gehen Sie im rechten Bereich auf „Laden“und stellen Sie die Kontextlänge auf 40 KB oder höher ein.

5. Klicken Sie auf „Server starten“.

Dies sollte Ihnen angezeigt werden, wenn der Server läuft.

Schritt 2: Lokalen Elastic-Speicher mit Docker bereitstellen

Nun richten wir Elasticsearch und Kibana lokal mit Docker ein. Elastic stellt ein praktisches Skript zur Verfügung, das den gesamten Einrichtungsprozess übernimmt. Für weitere Einzelheiten verweisen wir auf die offizielle Dokumentation.

Führen Sie das Start-Lokal-Skript aus

Führen Sie folgenden Befehl in Ihrem Terminal aus:

Dieses Skript wird:

- Elasticsearch und Kibana herunterladen und konfigurieren

- Starten Sie beide Dienste mit Docker Compose.

- Automatische Aktivierung einer 30-tägigen Platinum-Testlizenz

Erwartete Ausgabe

Warten Sie einfach auf die folgende Meldung und speichern Sie das angezeigte Passwort und den API-Schlüssel; Sie benötigen diese für den Zugriff auf Kibana:

Zugriff auf Kibana

Öffnen Sie Ihren Browser und navigieren Sie zu:

Melden Sie sich mit den Anmeldeinformationen an, die Sie in der Terminalausgabe erhalten haben.

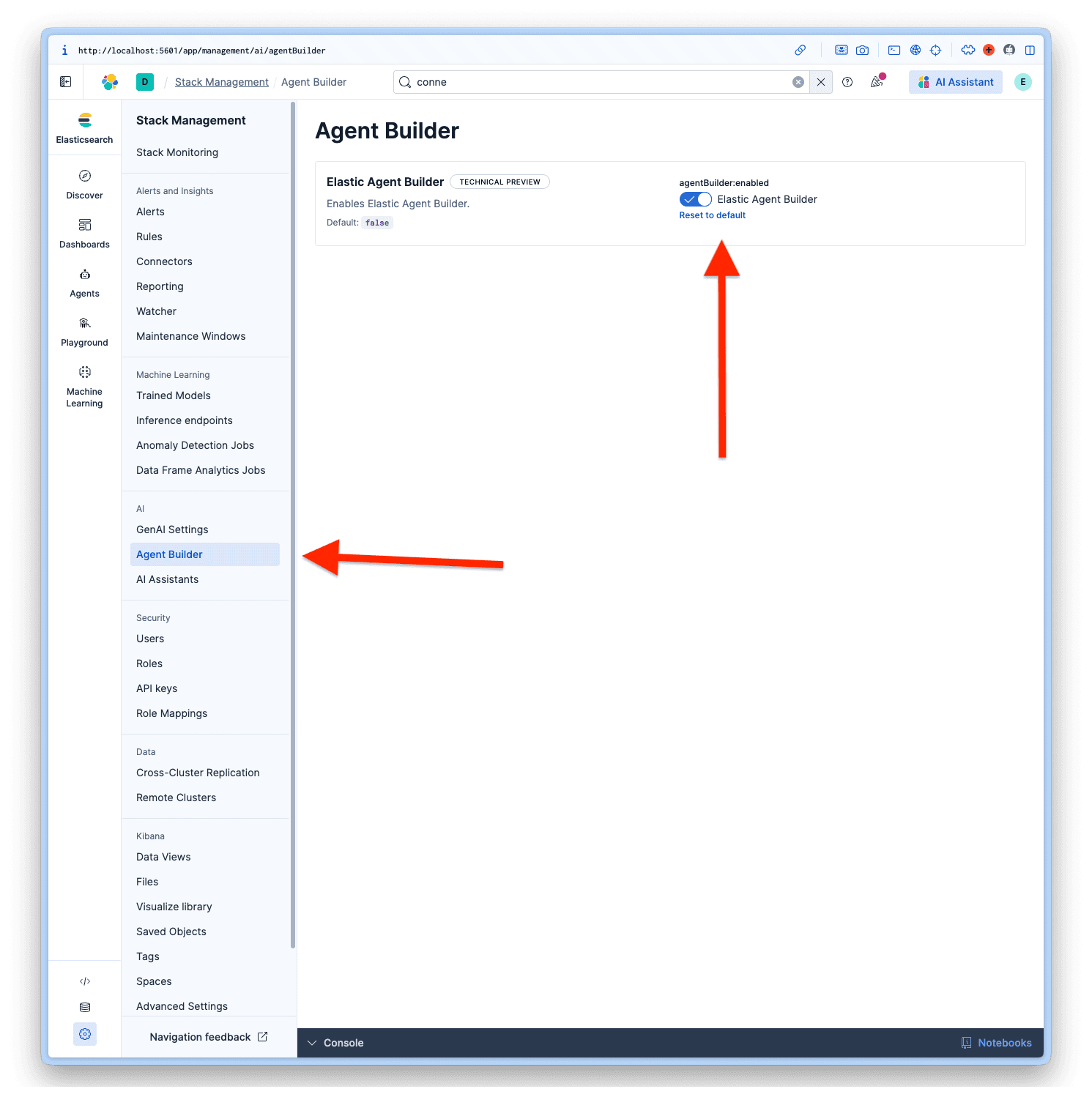

Agent Builder aktivieren

Nach dem Einloggen in Kibana navigieren Sie zu Management > AI > Agent Builder und aktivieren den Agent Builder.

Schritt 3: Erstellen Sie den OpenAI-Konnektor in Elastic

Nun konfigurieren wir Elastic so, dass es Ihr lokales LLM verwendet.

Zugangsanschlüsse

- In Kibana

- Gehen Sie zu Projekteinstellungen > Verwaltung

- Unter „Warnungen und Einblicke“ wählen Sie „Konnektoren“aus.

- Klicken Sie auf „Connector erstellen“.

Konfigurieren Sie den Anschluss

Wählen Sie OpenAI aus der Liste der Konnektoren aus. LM Studio nutzt das OpenAI SDK und ist daher kompatibel.

Füllen Sie die Felder mit diesen Werten aus:

- Anschlussname: LM Studio - GPT-OSS 20B

- Wählen Sie einen OpenAI-Anbieter: Andere (OpenAI-kompatibler Dienst)

- URL:

http://host.docker.internal:1234/v1/chat/completions - Standardmodell: openai/gpt-oss-20b

- API-Schlüssel: testkey-123 (Jeder beliebige Text funktioniert, da LM Studio Server keine Authentifizierung erfordert.)

Klicken Sie zum Abschluss der Konfiguration auf Speichern & Testen.

Wichtig: Aktivieren Sie die Option „ Native Funktionsaufrufe aktivieren“; dies ist erforderlich, damit der Agent Builder ordnungsgemäß funktioniert. Wenn Sie dies nicht aktivieren, erhalten Sie einen No tool calls found in the response -Fehler.

Testen Sie die Verbindung

Elastic sollte die Verbindung automatisch testen. Wenn alles korrekt konfiguriert ist, wird eine Erfolgsmeldung wie diese angezeigt:

Abwehr:

Schritt 4: Mitarbeiterdaten in Elasticsearch hochladen

Nun laden wir den HR-Mitarbeiterdatensatz hoch, um zu demonstrieren, wie der Agent mit sensiblen Daten arbeitet. Ich habe einen fiktiven Datensatz mit dieser Struktur generiert.

Struktur des Datensatzes

Erstellen Sie den Index mit Zuordnungen

Zuerst muss der Index mit den entsprechenden Zuordnungen erstellt werden. Beachten Sie, dass wir für einige Schlüsselfelder semantische Textfelder verwenden; dies ermöglicht semantische Suchfunktionen für unseren Index.

Indexierung mit Bulk-API

Kopieren Sie den Datensatz in Ihre Entwicklertools in Kibana und führen Sie ihn aus:

Überprüfen Sie die Daten.

Führen Sie eine Abfrage zur Überprüfung durch:

Schritt 5: KI-Agent erstellen und testen

Nachdem alles konfiguriert ist, ist es nun an der Zeit, mit dem Elastic Agent Builder einen benutzerdefinierten KI-Agenten zu erstellen. Weitere Details finden Sie in der Elastic-Dokumentation.

Fügen Sie den Verbinder hinzu.

Bevor wir unseren neuen Agenten erstellen können, müssen wir unseren Agent Builder so einstellen, dass er unseren benutzerdefinierten Konnektor mit der Bezeichnung LM Studio - GPT-OSS 20B verwendet, da der Standardkonnektor Elastic Managed LLM ist. Dazu müssen wir zu Projekteinstellungen > Verwaltung > GenAI-Einstellungen gehen; jetzt wählen wir die von uns erstellte Einstellung aus und klicken auf Speichern.

Zugriffsagenten-Generator

- Gehen Sie zu den Agenten.

- Klicken Sie auf „Neuen Agenten erstellen“.

Konfigurieren Sie den Agenten

Zum Anlegen eines neuen Agenten sind die Felder Agenten-ID, Anzeigename und Anzeigeanweisungen erforderlich.

Es gibt aber noch weitere Anpassungsmöglichkeiten, wie zum Beispiel die benutzerdefinierten Anweisungen, die vorgeben, wie sich Ihr Agent verhalten und mit Ihren Tools interagieren soll, ähnlich einer Systemaufforderung, aber für unseren benutzerdefinierten Agenten. Mithilfe von Labels lassen sich Agenten, Avatarfarben und Avatarsymbole organisieren.

Diejenigen, die ich anhand des Datensatzes für unseren Agenten ausgewählt habe, sind:

Agenten-ID: hr_assistant

Benutzerdefinierte Anweisungen:

Labels: Human Resources und GPT-OSS

Anzeigename: HR Analytics Assistant

Anzeigebeschreibung:

Nachdem alle Daten eingegeben wurden, können wir auf „Unseren neuen Agenten speichern “ klicken.

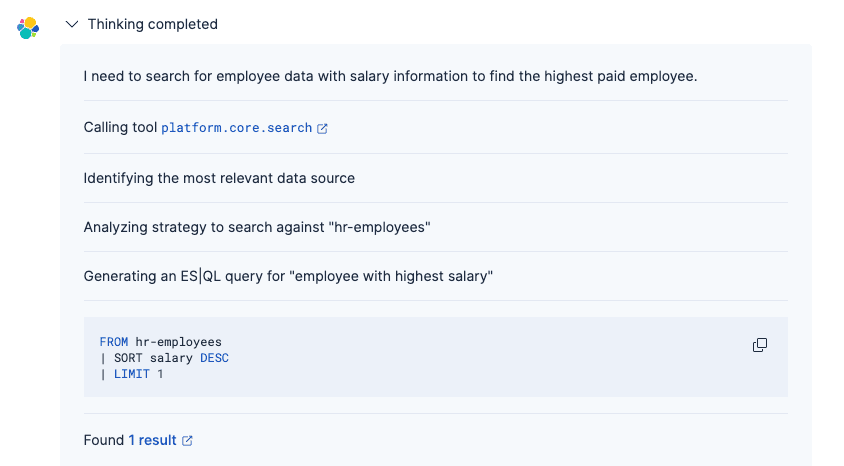

Testen Sie den Agenten

Sie können nun Fragen in natürlicher Sprache zu Ihren Mitarbeiterdaten stellen, und GPT-OSS 20B versteht die Absicht und generiert eine angemessene Antwort.

Prompt:

Antwort:

Der Agentenprozess war wie folgt:

1. Verstehen Sie Ihre Frage mithilfe des GPT-OSS-Connectors.

2. Generieren Sie die entsprechende Elasticsearch-Abfrage (mithilfe der integrierten Tools oder einer benutzerdefinierten ES|QL- Abfrage).

3. Abrufen passender Mitarbeiterdatensätze

4. Die Ergebnisse in natürlicher Sprache und mit geeigneter Formatierung präsentieren

Im Gegensatz zur herkömmlichen lexikalischen Suche versteht der von GPT-OSS unterstützte Agent Absicht und Kontext, wodurch es einfacher wird, Informationen zu finden, ohne die genauen Feldnamen oder die Abfragesyntax kennen zu müssen. Weitere Einzelheiten zum Denkprozess des Agenten finden Sie in diesem Artikel.

Fazit

In diesem Artikel haben wir mithilfe des Agent Builders von Elastic einen benutzerdefinierten KI-Agenten erstellt, um eine Verbindung zum lokal laufenden OpenAI GPT-OSS-Modell herzustellen. Durch die Bereitstellung von Elastic und LLM auf Ihrem lokalen Rechner ermöglicht Ihnen diese Architektur die Nutzung generativer KI-Funktionen bei gleichzeitiger vollständiger Kontrolle über Ihre Daten, ohne dass Informationen an externe Dienste gesendet werden müssen.

Wir haben GPT-OSS 20B als Experiment verwendet, aber die offiziell empfohlenen Modelle für Elastic Agent Builder sind hier aufgeführt. Falls Sie fortgeschrittenere Schlussfolgerungsfähigkeiten benötigen, gibt es auch die 120B-Parametervariante , die bei komplexen Szenarien besser abschneidet, allerdings ist für die lokale Ausführung ein leistungsstärkerer Rechner erforderlich. Weitere Einzelheiten finden Sie in der offiziellen OpenAI-Dokumentation.