Monitorez votre stack IA avec l'observabilité des LLM

Détectez les risques, résolvez les problèmes et maintenez vos applications d'IA agentiques et d'IA générative prêtes pour la production grâce aux capacités de surveillance de bout en bout d'Elastic Observability.

Des bibliothèques aux modèles, nous sommes là pour vous aider

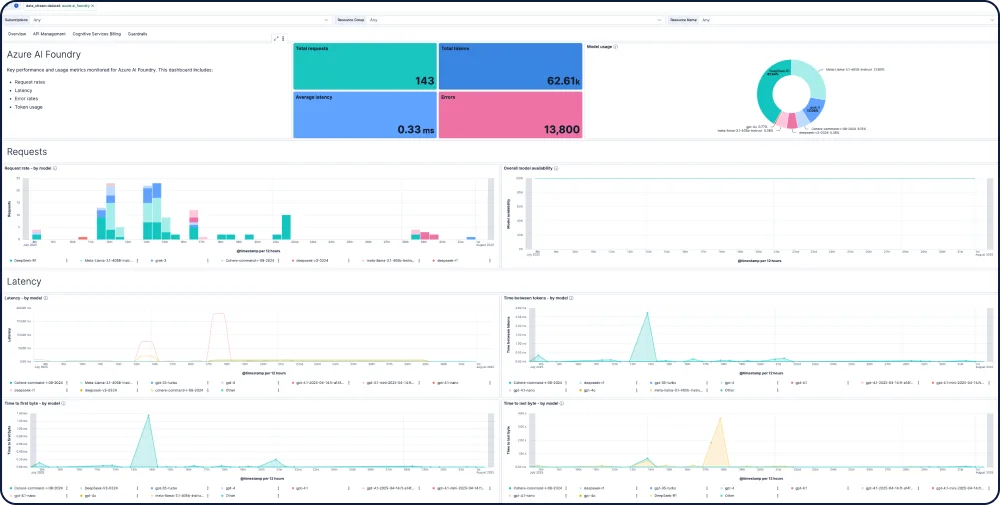

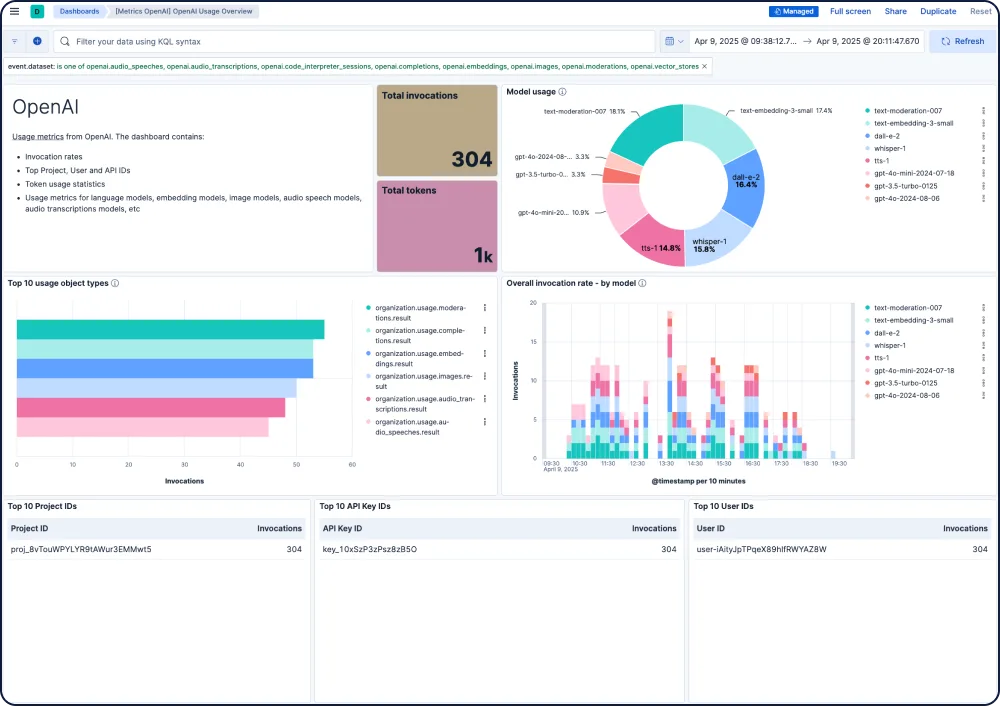

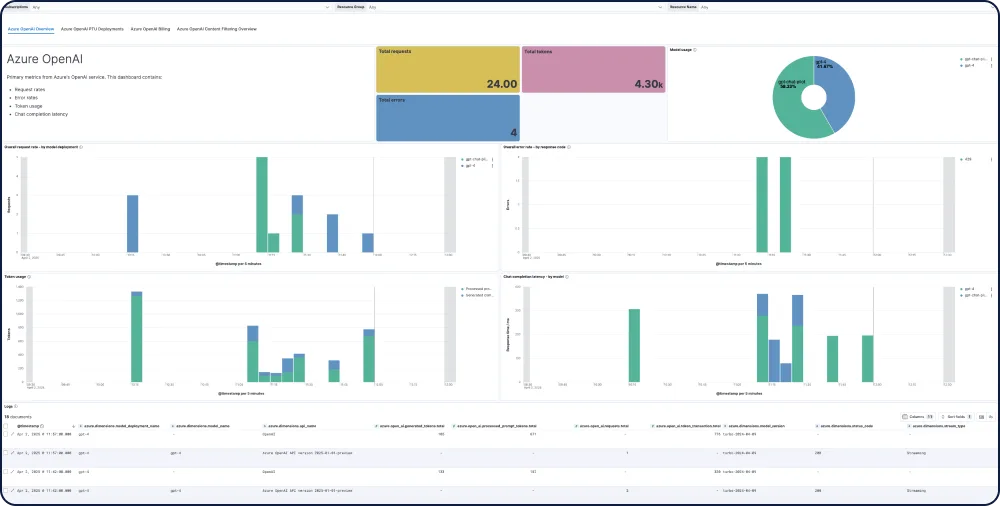

Elastic vous offre une visibilité de bout en bout sur les applications d'IA, en les intégrant aux bibliothèques de traçage les plus populaires et en fournissant des informations prêtes à l'emploi sur les modèles des principaux fournisseurs de LLM, notamment GPT-4o, Mistral, LLaMA, Anthropic, Cohere et DALL·E.

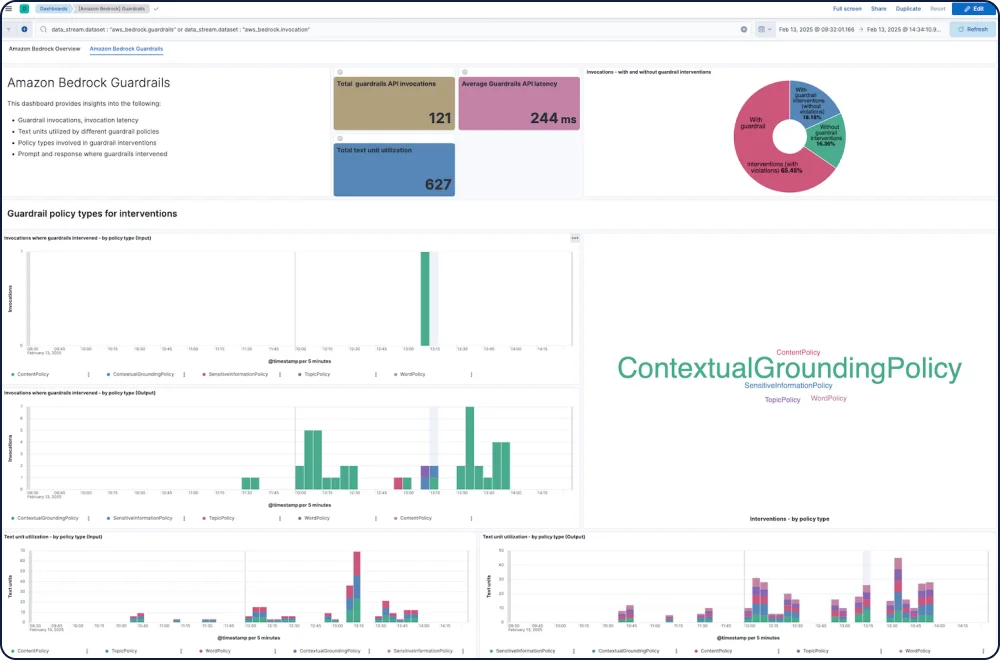

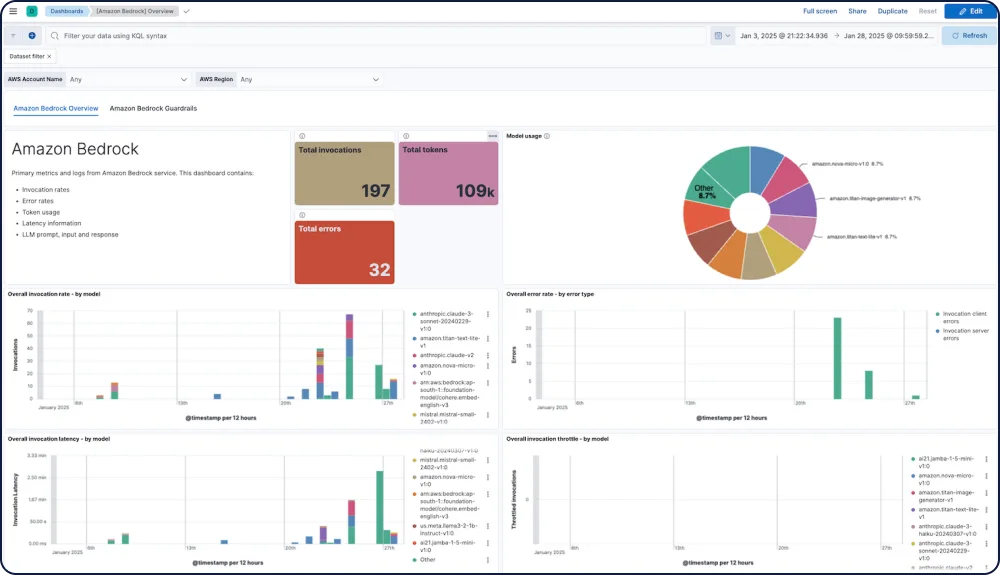

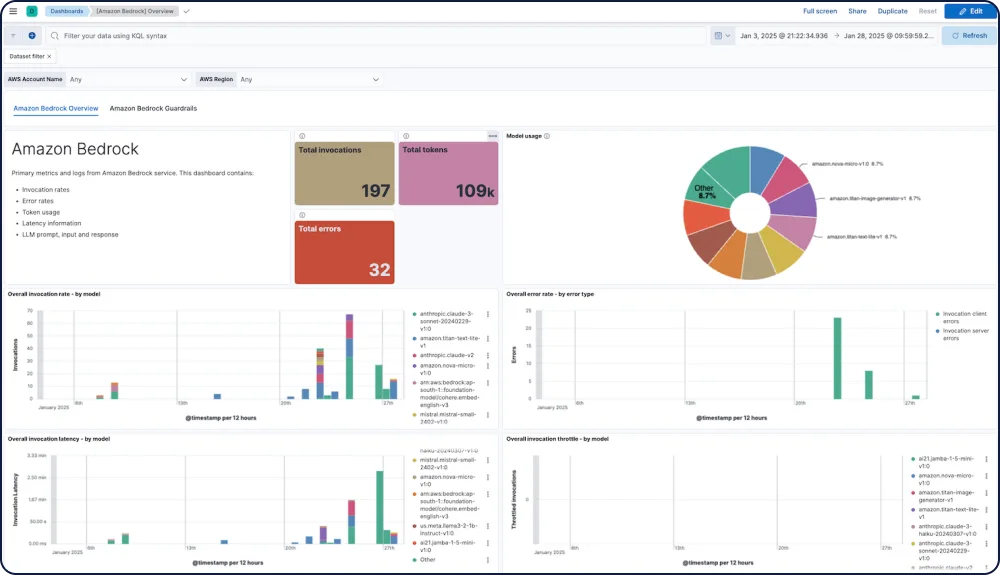

GALERIE DE TABLEAUX DE BORD

Intégrations et capacités pour vos applications d'IA

Suivez les performances, la sécurité et les dépenses pour chaque modèle.

L'intégration Amazon Bedrock pour Elastic Observability offre une visibilité complète sur les performances, l'utilisation et la sécurité d'Amazon Bedrock LLM, y compris pour les modèles d'Anthropic, Mistral et Cohere.

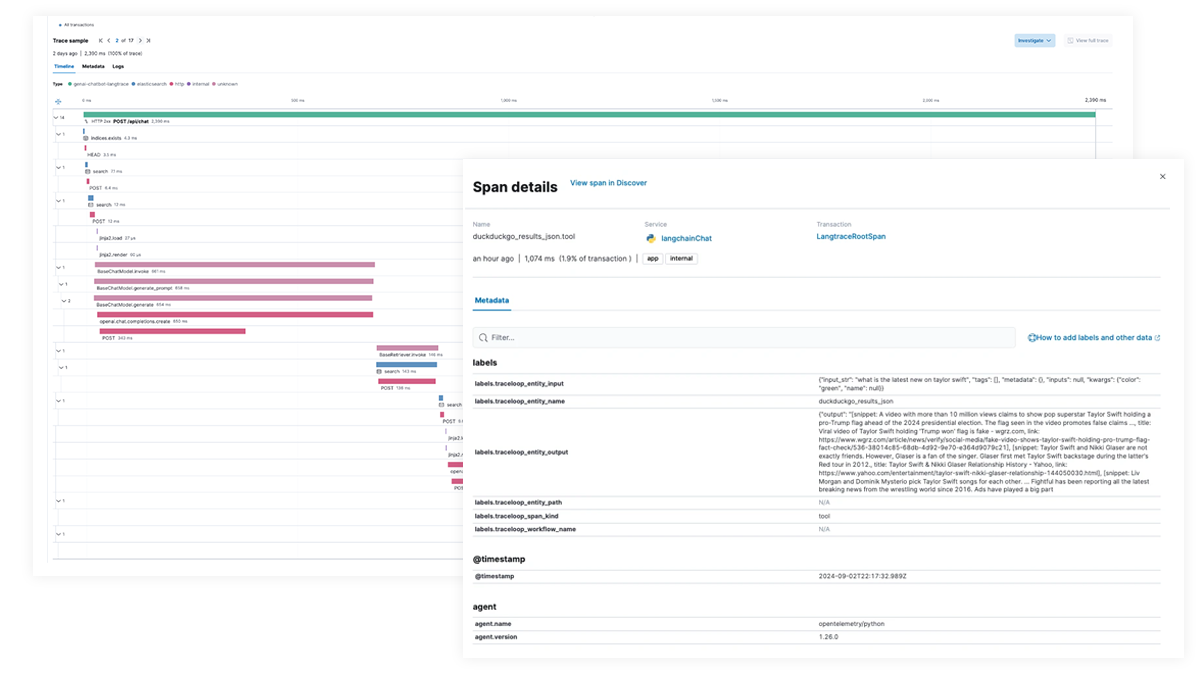

Traçage et débogage de bout en bout pour les applications IA et les workflows agentiques

Utilisez Elastic APM pour analyser et déboguer les applications d'IA avec OpenTelemetry, pris en charge par Elastic Distributions of OpenTelemetry (EDOT) pour Python, Java et Node.js, ainsi que par des bibliothèques de traçage tierces telles que LangTrace, OpenLIT et OpenLLMetry.

Essayez l’application Elastic chatbot RAG vous-même !

Cet exemple d’application combine Elasticsearch, LangChain et plusieurs LLM pour alimenter un chatbot avec ELSER et vos données privées.