¿Qué es un rastreador web?

Definición de rastreador web

Un rastreador web es un bot de motor de búsqueda digital que usa el copiado y los metadatos para descubrir e indexar páginas de sitios. También conocido como araña, este bot "rastrea" la red mundial (y por eso se lo conoce como "araña" y "rastreador") para conocer de qué se trata una página dada. Luego indexa la página y almacena la información para búsquedas futuras.

Indexación hace referencia a organizar los datos en un esquema o una estructura dados. Es un proceso que permite al motor de búsqueda encontrar coincidencias, mediante el uso de datos indexados, con resultados de búsqueda relevantes para una consulta. Como resultado, un rastreador web es una herramienta que facilita la navegación web.

Existe una diferencia entre los rastreadores web de internet y los rastreadores web empresariales. Un rastreador web de internet rastrea la internet y amplía continuamente las fronteras de rastreo mediante el descubrimiento de sitios nuevos y su indexación. Un rastreador web empresarial rastrea un sitio web empresarial dado para indexar los datos del sitio de modo que la información pueda detectarse cuando un usuario lo consulte a través de la función de búsqueda del sitio. También se puede usar como una herramienta comercial que automatice ciertas búsquedas.

¿Cómo funciona el rastreo web?

El rastreo web funciona mediante el descubrimiento de páginas nuevas, su indexación y el almacenamiento de la información para uso futuro. Puede rastrear continuamente el contenido a intervalos especificados para mantener los resultados de búsqueda actualizados y buscables.

Descubrimiento y obtención de páginas

A fin de reunir información sobre la mayor cantidad posible de páginas o sitios en línea, un rastreador web se moverá entre los enlaces en las páginas.

Un rastreador web comienza en una URL conocida, o URL "semilla", y luego descubre nuevos sitios a partir de los enlaces en dicha página y accede a ellos. Repite este proceso una y otra vez, en una búsqueda constante de páginas nuevas. Debido a la enorme cantidad de páginas en línea, y al hecho de que la información se actualiza de manera constante, este proceso puede continuar prácticamente de forma indefinida.

Los enlaces que encuentra el rastreador y recuerda para un descubrimiento futuro componen lo que se conoce como frontera de rastreo. Luego, estos hiperenlaces se visitan en un orden determinado por un conjunto de políticas o reglas de rastreo. Estas incluyen políticas de selección, políticas de repetición de visita, políticas de cortesía y políticas de paralelización.

Un rastreador web considerará la cantidad de URL que enlazan a una página dada y la cantidad de visitas a una página dada; todo a fin de descubrir e indexar contenido que sea importante. La lógica dicta que una página citada y visitada con frecuencia contiene información de alta calidad y confiable. Por lo tanto, es importante para el motor de búsqueda conocer el sitio y tener la capacidad de hacer que pueda detectarse.

Representar, descargar e indexar páginas

Una vez que un bot rastreador descubre una página nueva, representa la información que contiene, ya sea una copia del sitio o etiquetas meta, descarga esta información y la indexa. Algunos rastreadores web solo pueden acceder o leer páginas públicas, otros tienen permisos para indexar páginas autenticadas. También están comprometidos con requisitos de etiquetas meta noindex y archivos robots.txt. Un archivo robots.txt es un libro de reglas para páginas en línea que determina qué enlaces puede seguir un bot y qué información puede indexar. Una etiqueta meta noindex diferencia etiquetas meta que no son para indexar.

Limpiar y repetir

El objetivo de los rastreadores web es indexar y descargar información sobre sitios dados. Los rastreadores amplían continuamente la frontera de rastreo en busca de sitios, páginas y actualizaciones nuevas. Como resultado, siguen ampliando los datos indexados de su motor de búsqueda.

Con la ayuda de sus bots araña, los algoritmos del motor de búsqueda pueden ordenar los índices creados por los rastreadores de modo que puedan obtenerse y clasificarse en resultados cuando se consulten.

¿Por qué es importante el rastreo web?

El rastreo web es importante para las empresas porque es clave para la funcionalidad del motor de búsqueda. Permite a los motores de búsqueda indexar la información y sabe qué sitios y páginas existen, de modo que puede consultar esta información cuando resulte relevante para una búsqueda.

Detectabilidad

El rastreo web es parte de una estrategia de búsqueda y SEO exitosa, en parte porque hace que los sitios web empresariales y la información comercial puedan detectarse. Sin un rastreo inicial, los motores de búsqueda no pueden saber que tu sitio o datos de tu sitio web existen. Un rastreo interno de tu sitio también te ayuda a gestionar los datos del sitio, manteniéndolos actualizados y relevantes para que la información correcta pueda detectarse cuando se busque, y de modo que puedas llegar a las audiencias correctas.

Satisfacción del usuario

Usar un rastreador web empresarial también es clave para las funciones de búsqueda de tu sitio web empresarial. Como el rastreo indexa los datos de tu sitio (sin complicaciones), puedes ofrecer a los usuarios una experiencia de búsqueda sin problemas, y es más probable que logres convertirlos en clientes.

Automatización y ahorro de tiempo

Un rastreador web automatiza la recuperación de datos y te permite impulsar la interacción en tu sitio web mediante el rastreo de forma interna y externa. De esta forma, puedes enfocarte en crear contenido y realizar cambios estratégicos donde resulte necesario. En pocas palabras, el rastreo web (y la rastreabilidad de tu sitio) es importante para el éxito de tu empresa.

Componentes clave de un rastreador web

Los rastreadores web son herramientas de motor de búsqueda esenciales, de modo que sus componentes específicos se consideran información de propiedad exclusiva. Contribuyen a distinguir servicios de búsqueda y definir la experiencia de búsqueda; tu experiencia en Google es diferente a tu experiencia en Yandex o Bing, por ejemplo. Además, tu experiencia de búsqueda en tu propio sitio web puede ser distinta a la experiencia en el sitio de la competencia según cuán actualizada, precisa y relevante sea la información presentada en tus resultados de búsqueda.

Entonces, si bien los distintos rastreadores web funcionan diferente, sean bots rastreadores de internet o empresariales, comparten una arquitectura estándar y tienen capacidades similares. Reciben una URL "semilla" como entrada. A partir de allí, puede acceder a más URL en la frontera de rastreo, que se compone de una lista de URL que aún no visitó un bot de rastreo.

Conforme a un conjunto de políticas o reglas de rastreo, como las políticas de cortesía (lo que puede indexar un bot) y de repetición de visita (con qué frecuencia puede rastrear), el rastreador continuará visitando URL nuevas.

A partir de allí, debe tener la capacidad de representar la información de la URL, descargarla a alta velocidad, indexarla y almacenarla en el motor para uso futuro.

Mientras que los rastreadores de internet permiten una búsqueda en toda la web, los rastreadores web empresariales permiten que tu contenido sea buscable en el sitio. Algunas de sus capacidades incluyen las siguientes:

- Visibilidad total de la actividad de rastreo para poder hacer un seguimiento del rendimiento de rastreo

- Capacidad de programación, lo que te brinda el control del bot con API flexibles

- Interfaces de usuario fáciles de usar

Tipos de rastreadores web

Los rastreadores web pueden programarse para realizar distintas tareas. Por tanto, existen distintos tipos de rastreadores web.

Rastreador web enfocado: el objetivo de un rastreador web enfocado es rastrear contenido enfocado en un parámetro, como contenido relacionado con un solo tema o de un único tipo de dominio. Para hacerlo, un rastreador web enfocado discernirá qué hiperenlaces seguir basándose en la probabilidad.

Rastreador web incremental: un rastreador web incremental es un tipo de bot rastreador que repite la visita a las páginas para actualizar los índices. Reemplaza enlaces antiguos con URL nuevas, cuando corresponde. Este proceso se usa para reducir las descargas de documentos inconsistentes.

Rastreador distribuido: los rastreadores distribuidos trabajan en distintos sitios web de forma simultánea para realizar tareas de rastreo.

Rastreador paralelo: un rastreador paralelo es un tipo de bot rastreador que ejecuta varios procesos en forma simultánea (o en paralelo) para aumentar la eficiencia de descarga.

Bots de motor de búsqueda populares

Los bots de rastreo más populares son bots de motor de búsqueda de internet. Incluyen los siguientes:

- BingBot: bot de rastreo de Bing

- GoogleBot: compuesto por dos bots: uno para plataformas móviles y otro para equipos de escritorio

- DuckDuckBot: bot de DuckDuckGo

- Slurp: bot de Yahoo Search

- YandexBot: bot de Yandex

- Baiduspider: bot de motor de búsqueda de Baidu

Beneficios de rastreo web

No solo el rastreo web que usan los motores de búsqueda proporciona una experiencia de búsqueda fácil de usar, sino que los usuarios empresariales se benefician del rastreo web de varias formas.

El principal beneficio del rastreo web para los usuarios empresariales es que permite que su sitio, contenido y datos sean detectables y, por tanto, es esencial para la estrategia de búsqueda y SEO empresarial. Rastrear tu sitio también es la forma más fácil de indexar datos en tu propio sitio web para tu propia experiencia de búsqueda. Y la buena noticia es que el rastreo web no afecta el rendimiento de tu sitio web porque se ejecuta en segundo plano. El rastreo web regular también te ayuda a gestionar el rendimiento de tu sitio y la experiencia de búsqueda, además de a asegurar que tenga una posición óptima.

Otros beneficio adicionales del rastreo web incluyen los siguientes:

- Reportes integrados: la mayoría de los rastreadores web poseen características de reporte o analíticas a las que puedes acceder. Estos reportes, en general, pueden exportarse a hojas de cálculo u otros formatos legibles y son herramientas útiles para gestionar tu estrategia de búsqueda y SEO.

- Parámetros de rastreo: como gerente del sitio, puedes configurar reglas de frecuencia de la tasa de rastreo. Tú decides la frecuencia con la que el bot araña rastrea el sitio. Como el bot está automatizado, no es necesario extraer manualmente los reportes de rastreo en cada ocasión.

- Indexación automatizada: usar un rastreador web en tu sitio te permite indexar tus datos de forma automática. Puedes controlar qué datos se rastrean e indexan, y automatizar más el proceso.

- Generación de clientes potenciales: el rastreo puede ayudarte a reunir información sobre el mercado, encontrar oportunidades y generar clientes potenciales. Como herramienta de búsqueda automática, acelera un proceso que de lo contrario sería manual.

- Monitoreo: los rastreadores web pueden ayudarte a monitorear menciones de tu empresa en las redes sociales y aumentar el tiempo de respuesta. Cuando se usa para el monitoreo, un rastreador web puede ser una herramienta de PR efectiva.

Desafíos y limitaciones del rastreo web

El principal desafío del rastreo web es la mera cantidad de datos que existe y que se produce o actualiza continuamente. Los rastreadores buscan enlaces en todo momento, pero no es probable que descubran todo lo que alguna vez se produjo. Esto se debe, en parte a estos desafíos y limitaciones:

- Actualizaciones de contenido regulares: las estrategias de optimización del motor de búsqueda motivan a las empresas a actualizar de forma regular el contenido en sus páginas. Algunas empresas usan páginas web dinámicas, que ajustan automáticamente su contenido según la interacción del visitante. Dado que el código fuente cambia con regularidad, los rastreadores web deben repetir la visita a las páginas con frecuencia para mantener los índices actualizados.

- Trampas de rastreadores: en ocasiones de forma intencional, los sitios web usarán trampas de rastreadores para evitar que bots araña rastreen ciertas páginas. Los obstáculos para rastreadores de uso más frecuente son los archivos robots.txt o las etiquetas meta noindex. Si bien su objetivo es proteger ciertas partes de un sitio del rastreo y la indexación, a veces pueden confundir al rastreador. Cuando sucede esto, el bot puede quedar atrapado en un ciclo vicioso de rastreo que desperdicia los recursos del rastreador y tu presupuesto de rastreo.

- Saturación del ancho de banda: al descargar e indexar grandes cantidades de páginas, los rastreadores web pueden consumir gran parte de la capacidad de red y saturar el ancho de banda de la red.

- Contenido duplicado: el contenido duplicado, sea el resultado de un error humano o de máquina, puede dar como resultado una indexación imprecisa. Cuando los rastreadores visitan páginas duplicadas, solo indexan y clasifican una página. Determinar cuál descargar e indexar es difícil para el bot y contraproducente para la empresa.

Rastreo web comparado con raspado web

La diferencia clave entre el rastreo y el raspado es que el rastreo web se usa para la indexación de datos, mientras que el raspado web se usa para la extracción de datos.

El raspado web, también conocido como extracción de datos web, suele ser más dirigido que el rastreo. Se puede realizar en escala pequeña y grande, y se usa para extraer datos y contenido de sitios para la investigación de mercado, la generación de clientes potenciales o la prueba de sitios web. Rastreo web y raspado web a veces se usan de forma indistinta.

Mientras que los rastreadores web en general suelen estar sujetos a reglas, como archivos robots.txt y políticas de fronteras de URL, los raspadores web pueden ignorar permisos, descargar contenido de forma ilegal e ignorar cualquier saturación del servidor que pueden estar causando sus actividades.

Tendencias futuras en el rastreo web

Los rastreadores web se usan en todos los motores de búsqueda, y son una tecnología bastante madura. Por este motivo, pocos invierten el tiempo en crear los suyos propios. Además, existen rastreadores web open source.

Sin embargo, a medida que continúa creciendo exponencialmente la producción de datos nuevos y que las empresas tienden más a minar las posibilidades de datos no estructurados, la tecnología de rastreo web evolucionará para cumplir la demanda. Las funcionalidades de búsqueda son vitales para las empresas; y con la llegada de la AI, los rastreadores web empresariales son clave para asegurar que la AI generativa obtenga la información más relevante y actualizada rastreando e indexando con regularidad los datos del sitio.

Las empresas también están dedicando una mayor parte de los presupuestos al raspado web a fin de ampliar los casos de uso actuales, que incluyen investigaciones, investigaciones de mercado, monitoreo de competidores o incluso investigaciones criminales. Opimas prevé que el gasto aumentará a USD 6000 millones para el 20251.

Rastreo web con Elastic

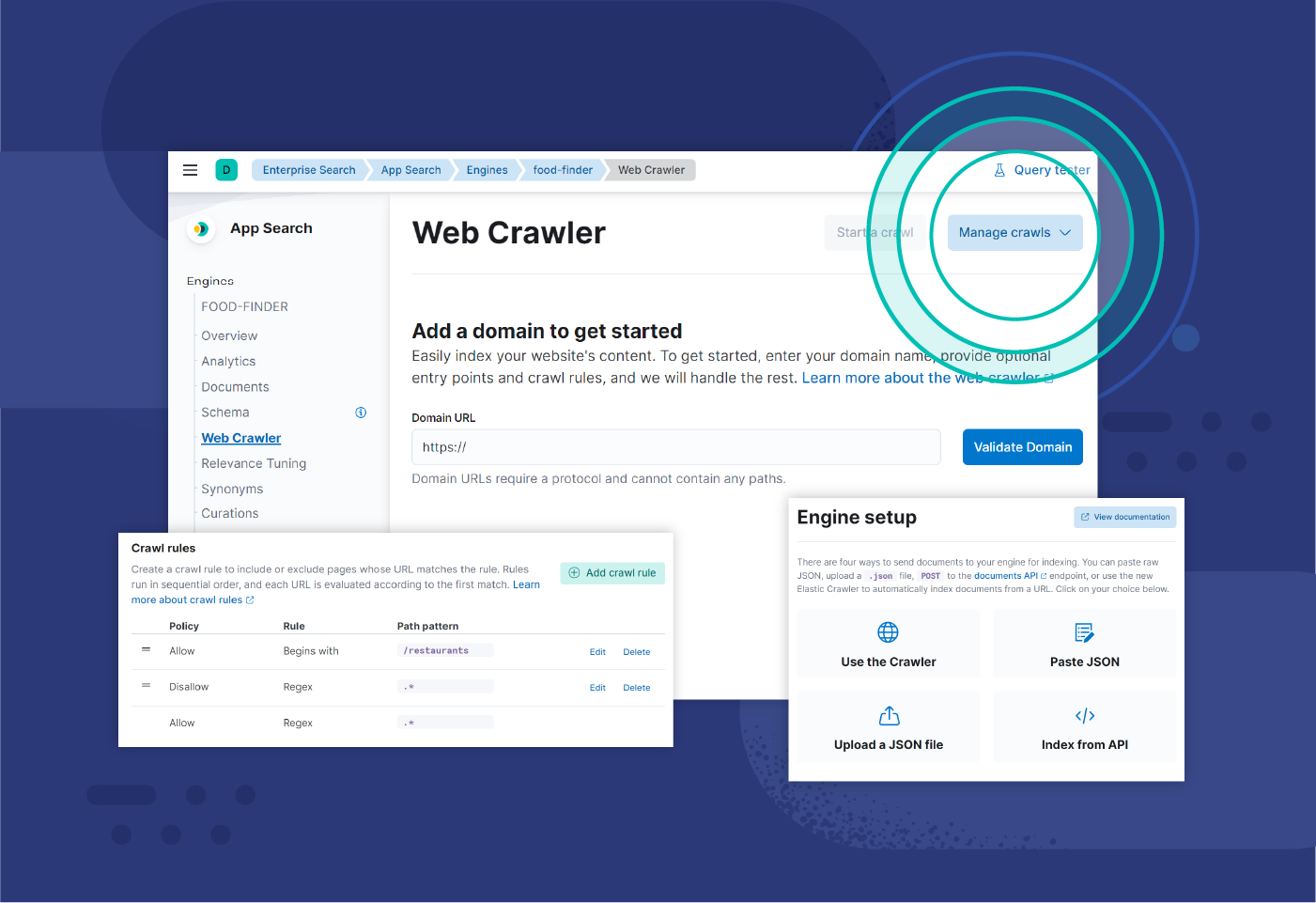

El rastreador web de Elastic es una herramienta de Elasticsearch que permite a los desarrolladores indexar y sincronizar con facilidad el contenido de sus sitios web. El rastreador se ocupa automáticamente de la indexación y es fácil de controlar, al tiempo que puede configurarse y observarse.

Con el rastreador web listo para producción de Elastic, puedes programar rastreos para que se ejecuten de forma automática, configurar reglas y rastrear contenido autenticado y archivos PDF.

Recursos de rastreo web

- Crear una solución escalable a los desafíos de rastreo web comunes

- Capacidades de rastreo web de Elastic

- Getting started with website search (Primeros pasos con la búsqueda en el sitio web)

- Entrenamiento de inicio rápido del rastreador web

Notas al pie

1 "What's the future of web scraping in 2023?" (¿Cuál es el futuro del raspado web en 2023?), Apify Blog, enero de 2023