Agent Builder est désormais disponible en aperçu technique. Commencez avec un essai Elastic Cloud et consultez la documentation d’Agent Builder ici.

Introduction

Cet article vous montrera comment construire un agent d'IA pour les RH en utilisant GPT-OSS et Elastic Agent Builder. L'agent peut répondre à vos questions sans envoyer de données à OpenAI, Anthropic ou tout autre service externe.

Nous allons utiliser LM Studio pour servir GPT-OSS localement et le connecter à Elastic Agent Builder.

À la fin de cet article, vous disposerez d'un agent d'IA personnalisé capable de répondre à des questions en langage naturel sur les données de vos employés, tout en conservant un contrôle total sur vos informations et votre modèle.

Produits requis

Pour cet article, vous avez besoin de :

- Elastic Cloud hébergé 9.2, déploiement sans serveur ou local.

- Machine avec 32 Go de RAM recommandée (minimum 16 Go pour GPT-OSS 20B)

- LM Studio installé

- Docker Desktop installé

Pourquoi utiliser GPT-OSS ?

Avec un LLM local, vous avez la possibilité de le déployer dans votre propre infrastructure et de l'adapter à vos besoins. Tout cela en gardant le contrôle sur les données que vous partagez avec le modèle et, bien sûr, sans avoir à payer de licence à un fournisseur externe.

OpenAI a publié GPT-OSS le 5 août 2025, dans le cadre de son engagement envers l'écosystème des modèles ouverts.

Le modèle de paramètres 20B offre :

- Capacités d'utilisation des outils

- Inférence efficace

- Compatible avec le SDK OpenAI

- Compatible avec les flux de travail agentiques

Comparaison des points de repère :

Source de référence.

Architecture de la solution

L'architecture fonctionne entièrement sur votre machine locale. Elastic (exécuté dans Docker) communique directement avec votre LLM local via LM Studio, et Elastic Agent Builder utilise cette connexion pour créer des agents d'IA personnalisés qui peuvent interroger les données de vos employés.

Pour plus de détails, consultez cette documentation.

Construire un agent d'IA pour les RH : étapes

Nous diviserons la mise en œuvre en 5 étapes :

- Configurer LM studio avec un modèle local

- Déployer Elastic local avec Docker

- Créer le connecteur OpenAI dans Elastic

- Téléchargement des données des employés vers Elasticsearch

- Créez et testez votre agent d'intelligence artificielle

Étape 1 : Configurer LM Studio avec GPT-OSS 20B

LM Studio est une application conviviale qui vous permet d'exécuter localement de grands modèles linguistiques sur votre ordinateur. Il fournit un serveur d'API compatible avec OpenAI, ce qui facilite l'intégration avec des outils tels qu'Elastic sans processus de configuration complexe. Pour plus de détails, reportez-vous à la documentation de LM Studio.

Tout d'abord, téléchargez et installez LM Studio depuis le site officiel. Une fois installée, ouvrez l'application.

Dans l'interface de LM Studio :

- Allez dans l'onglet recherche et cherchez "GPT-OSS"

- Sélectionnez le site

openai/gpt-oss-20bà partir d'OpenAI - Cliquez sur télécharger

La taille de ce modèle devrait être d'environ 12,10 Go. Le téléchargement peut prendre quelques minutes, en fonction de votre connexion internet.

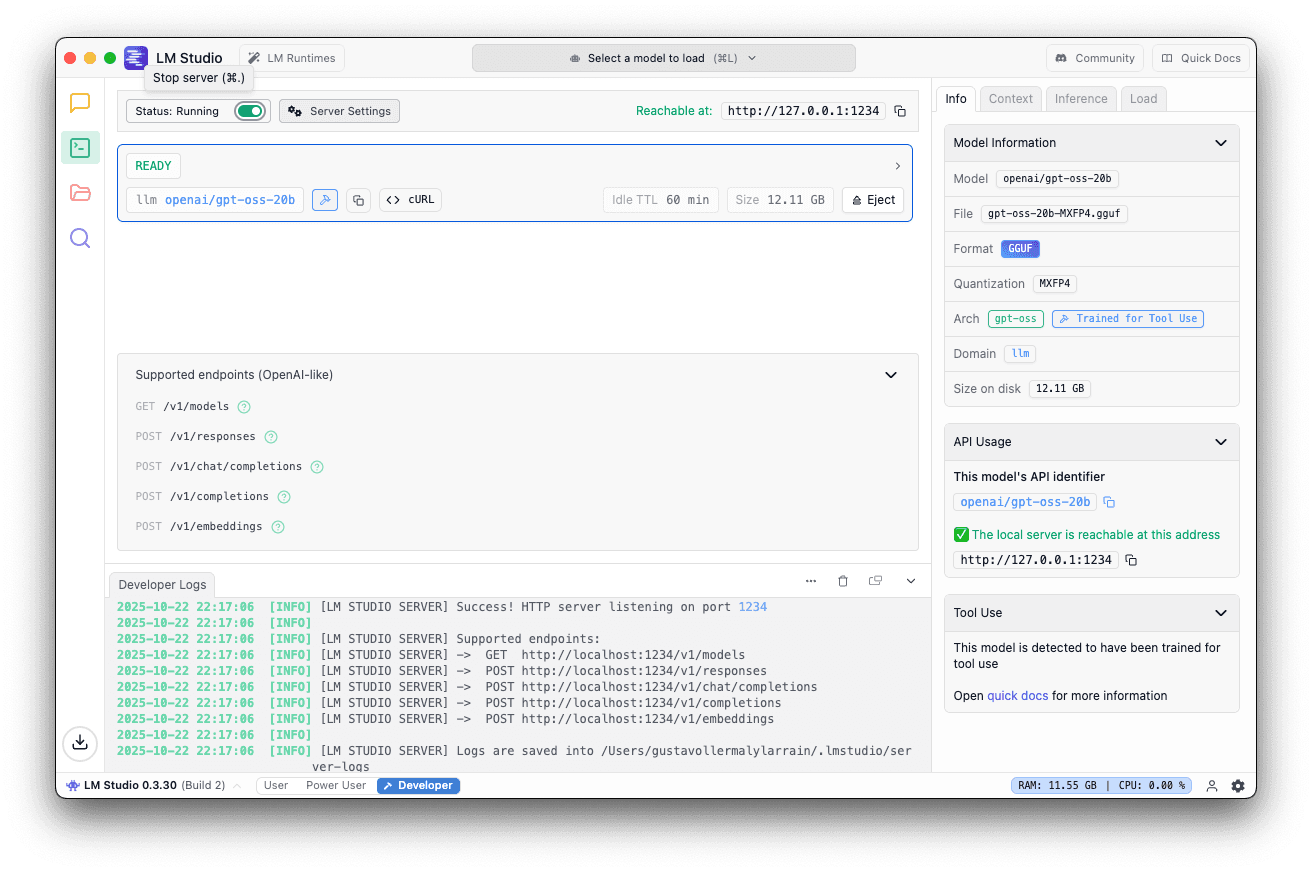

Une fois le modèle téléchargé :

- Aller dans l'onglet du serveur local

- Sélectionner l'openai/gpt-oss-20b

- Utiliser le port par défaut 1234

- Dans le panneau de droite, cliquez sur Charger et réglez la longueur du contexte sur 40K ou plus.

5. Cliquez sur démarrer le serveur

Vous devriez voir ceci si le serveur est en cours d'exécution.

Étape 2 : Déployer Elastic local avec Docker

Nous allons maintenant configurer Elasticsearch et Kibana localement à l'aide de Docker. Elastic fournit un script pratique qui gère l'ensemble du processus d'installation. Pour plus de détails, voir la documentation officielle.

Exécuter le script start-local

Exécutez la commande suivante dans votre terminal :

Ce script va :

- Télécharger et configurer Elasticsearch et Kibana

- Démarrer les deux services à l'aide de Docker Compose

- Activation automatique d'une licence d'essai Platinum de 30 jours

Résultats attendus

Attendez le message suivant et enregistrez le mot de passe et la clé API indiqués ; vous en aurez besoin pour accéder à Kibana :

Accéder à Kibana

Ouvrez votre navigateur et naviguez vers :

Connectez-vous en utilisant les informations d'identification obtenues dans la sortie du terminal.

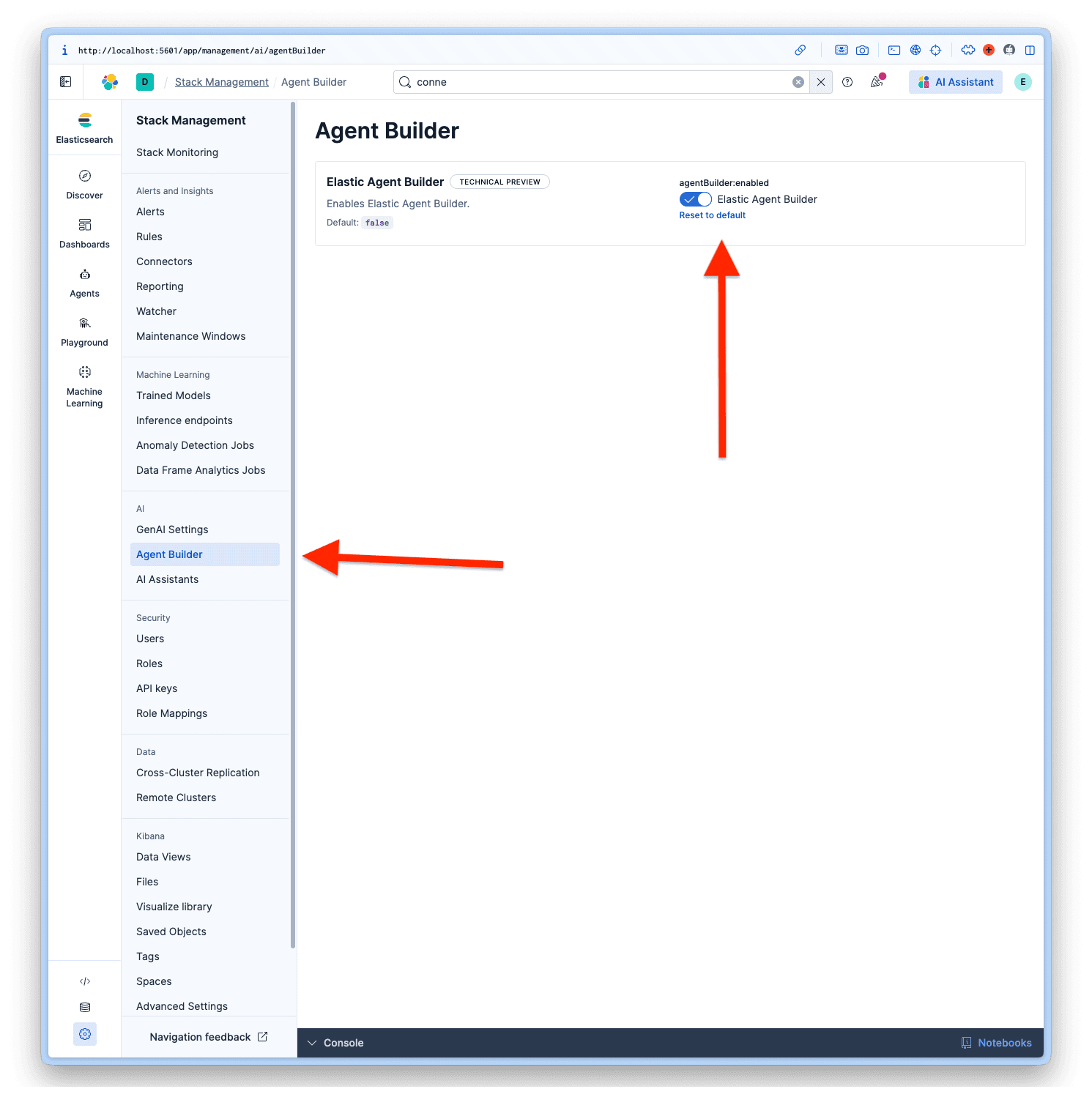

Activer le constructeur d'agents

Une fois connecté à Kibana, naviguez vers Management > AI > Agent Builder et activez l'Agent Builder.

Étape 3 : Créer le connecteur OpenAI dans Elastic

Nous allons maintenant configurer Elastic pour qu'il utilise votre LLM local.

Connecteurs d'accès

- Dans Kibana

- Allez dans Paramètres du projet > Gestion

- Sous Alertes et aperçus, sélectionnez Connecteurs

- Cliquez sur Créer un connecteur

Configurer le connecteur

Sélectionnez OpenAI dans la liste des connecteurs. LM Studio utilise le SDK OpenAI, ce qui le rend compatible.

Remplissez les champs avec ces valeurs :

- Nom du connecteur : LM Studio - GPT-OSS 20B

- Sélectionnez un fournisseur OpenAI : Autre (Service compatible avec l'OpenAI)

- URL :

http://host.docker.internal:1234/v1/chat/completions - Modèle par défaut : openai/gpt-oss-20b

- Clé API : testkey-123 (n'importe quel texte fonctionne, car le serveur LM Studio ne nécessite pas d'authentification).

Pour terminer la configuration, cliquez sur Save & test.

Important : Activez l'option "Enable native function calling" (activer l'appel de fonctions natives) ; cette option est nécessaire pour que l'Agent Builder fonctionne correctement. Si vous ne l'activez pas, vous obtiendrez une erreur No tool calls found in the response.

Tester la connexion

Elastic devrait automatiquement tester la connexion. Si tout est configuré correctement, vous obtiendrez un message de réussite comme celui-ci :

Réponse :

Étape 4 : Téléchargement des données des employés vers Elasticsearch

Nous allons maintenant télécharger l'ensemble de données relatives aux employés des RH afin de montrer comment l'agent travaille avec des données sensibles. J'ai généré un ensemble de données fictives avec cette structure.

Structure de l'ensemble de données

Créer l'index avec les correspondances

Tout d'abord, créez l'index avec les correspondances appropriées. Notez que nous utilisons des champs semantic_text pour certains champs clés ; cela permet des capacités de recherche sémantique pour notre index.

Index avec Bulk API

Copiez et collez le jeu de données dans votre Dev Tools dans Kibana et exécutez-le :

Vérifier les données

Exécutez une requête pour vérifier :

Étape 5 : Créer et tester votre agent d'intelligence artificielle

Une fois tout configuré, il est temps de créer un agent d'IA personnalisé à l'aide d'Elastic Agent Builder. Pour plus de détails, voir la documentation Elastic.

Ajouter le connecteur

Avant de pouvoir créer notre nouvel agent, nous devons configurer notre Agent builder pour qu'il utilise notre connecteur personnalisé appelé LM Studio - GPT-OSS 20B, car le connecteur par défaut est Elastic Managed LLM. Pour cela, nous devons aller dans Project Setting > Management > GenAI Settings; nous sélectionnons alors celui que nous avons créé et cliquons sur Save.

Agent d'accès Constructeur

- Aller aux agents

- Cliquez sur Créer un nouvel agent

Configurer l'agent

Pour créer un nouvel agent, les champs obligatoires sont l'identifiant de l'agent, le nom d'affichage et les instructions d'affichage.

Mais il existe d'autres options de personnalisation, comme les instructions personnalisées qui indiquent comment votre agent va se comporter et interagir avec vos outils, à la manière d'une invite système, mais pour notre agent personnalisé. Les étiquettes permettent d'organiser les agents, la couleur de l'avatar et le symbole de l'avatar.

Ceux que j'ai choisis pour notre agent sur la base de l'ensemble des données sont les suivants :

Agent ID : hr_assistant

Instructions personnalisées :

Étiquettes : Human Resources et GPT-OSS

Nom d'affichage : HR Analytics Assistant

Description de l'affichage :

Une fois toutes les données saisies, nous pouvons cliquer sur Enregistrer notre nouvel agent.

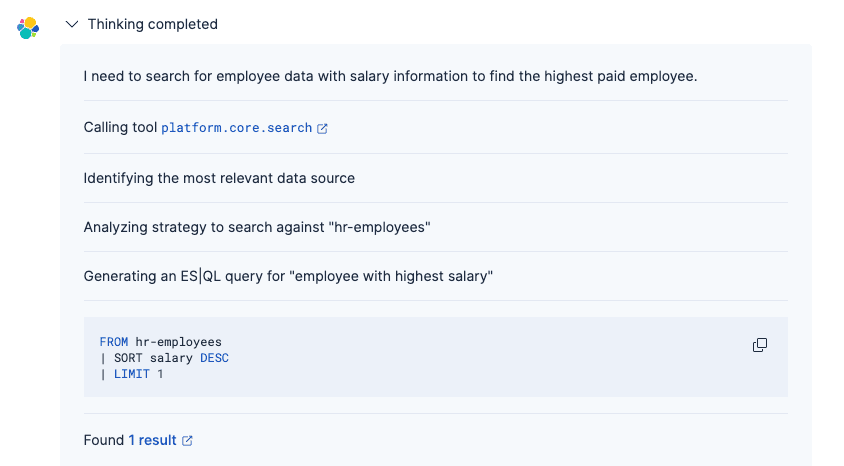

Tester l'agent

Vous pouvez désormais poser des questions en langage naturel sur les données de vos employés, et GPT-OSS 20B comprendra l'intention et générera une réponse appropriée.

Prompt :

Réponse :

Le processus de l'agent a été le suivant :

1. Comprendre votre question à l'aide du connecteur GPT-OSS

2. Générer la requête Elasticsearch appropriée (à l'aide des outils intégrés ou d'ES|QL personnalisés)

3. Récupérer les enregistrements des salariés correspondants

4. Présenter les résultats en langage naturel avec un formatage approprié

Contrairement à la recherche lexicale traditionnelle, l'agent alimenté par GPT-OSS comprend l'intention et le contexte, ce qui facilite la recherche d'informations sans connaître les noms exacts des champs ou la syntaxe de la requête. Pour plus de détails sur le processus de réflexion de l'agent, voir cet article.

Conclusion

Dans cet article, nous avons construit un agent d'IA personnalisé à l'aide de l'Agent Builder d'Elastic pour se connecter au modèle OpenAI GPT-OSS fonctionnant localement. En déployant à la fois Elastic et le LLM sur votre machine locale, cette architecture vous permet de tirer parti des capacités d'IA générative tout en conservant un contrôle total sur vos données, le tout sans envoyer d'informations à des services externes.

Nous avons utilisé GPT-OSS 20B à titre expérimental, mais les modèles officiellement recommandés pour Elastic Agent Builder sont référencés ici. Si vous avez besoin de capacités de raisonnement plus avancées, il existe également la variante de paramètre 120B qui est plus performante pour les scénarios complexes, bien qu'elle nécessite une machine plus sophistiquée pour fonctionner localement. Pour plus de détails, consultez la documentation officielle d'OpenAI.