LLMオブザーバビリティでAIスタックを監視

Elastic Observability のエンドツーエンドの監視機能を使用して、リスクを検出し、問題を解決し、エージェント型および生成AIアプリケーションを本番環境に対応可能な状態に保ちます。

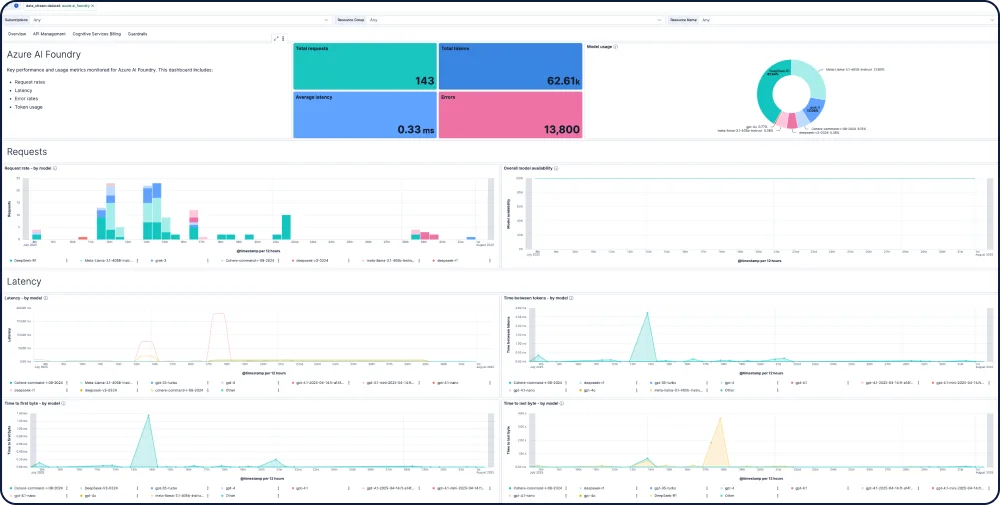

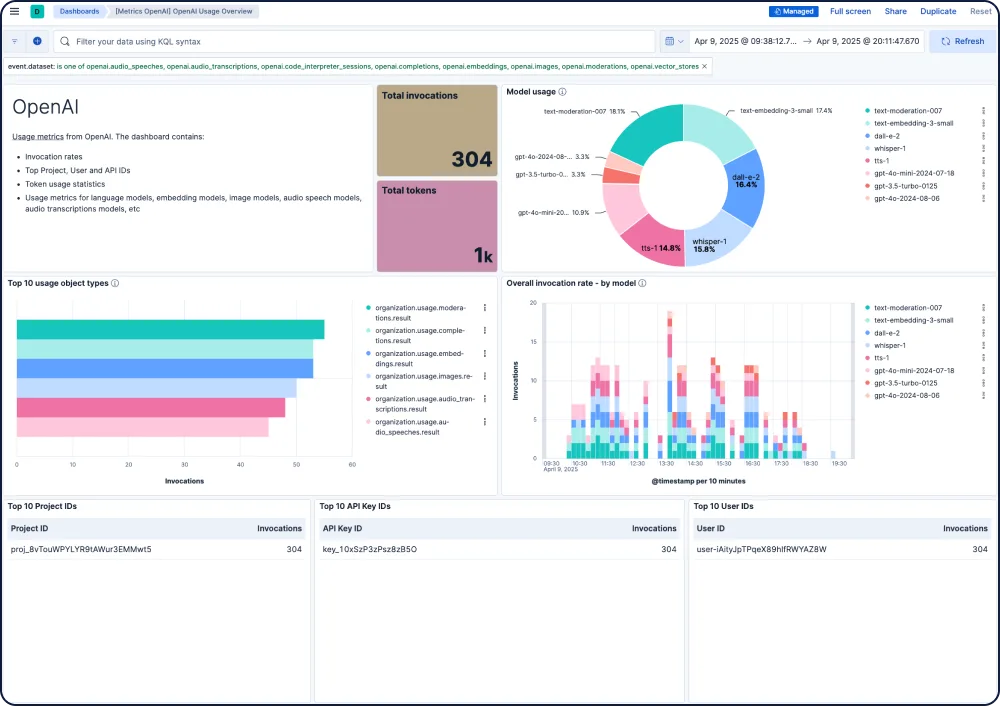

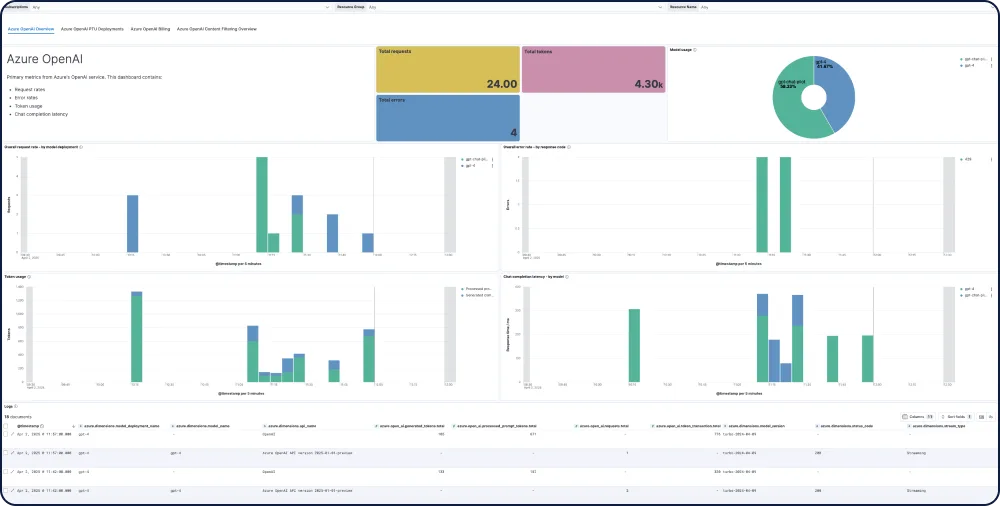

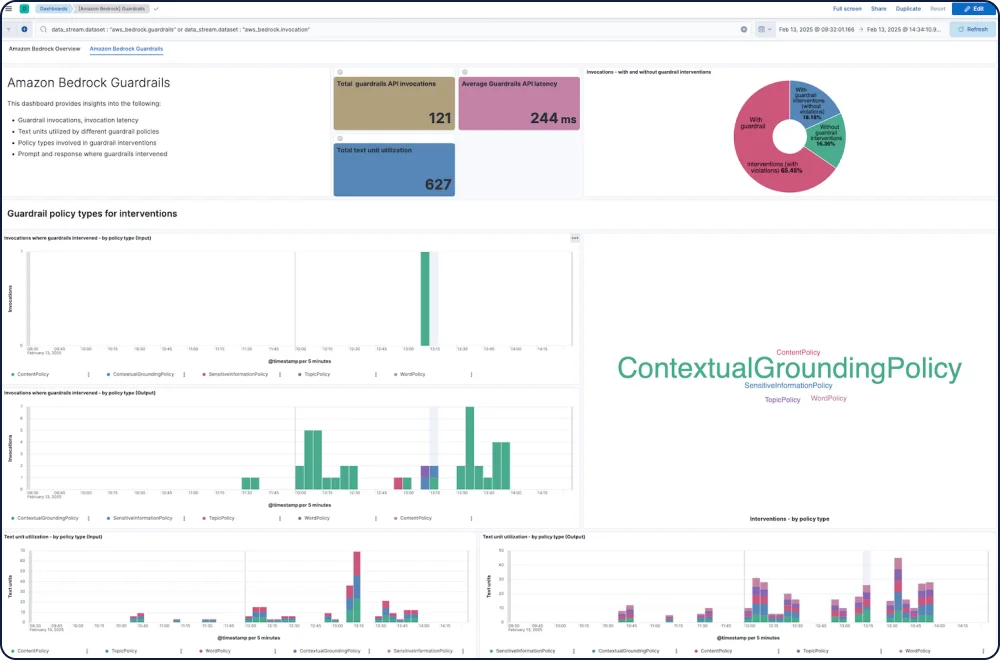

ダッシュボードギャラリー

AIアプリの統合と機能

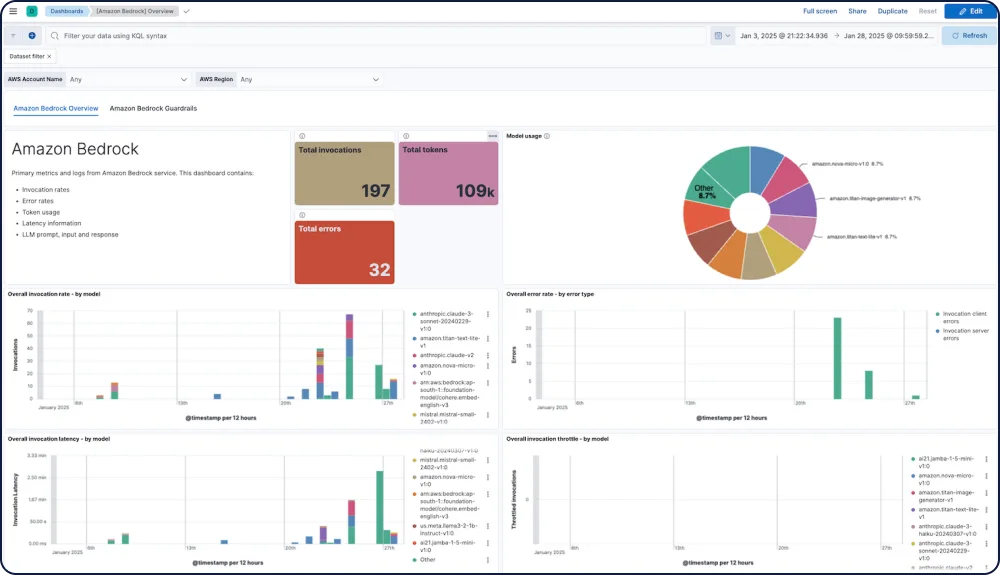

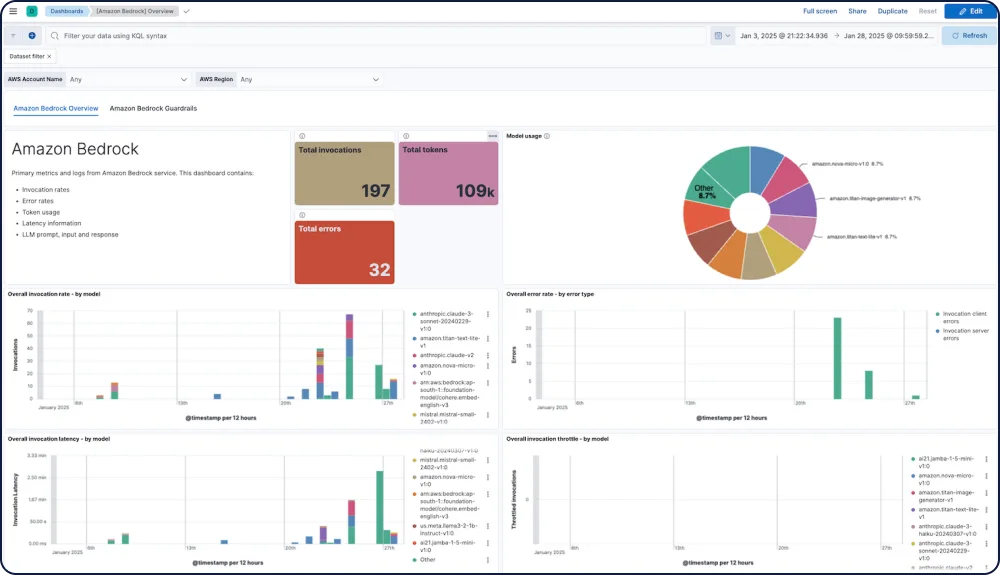

すべてのモデルのパフォーマンス、安全性、支出を追跡します。

Elastic Observability向けのAmazon Bedrock統合は、Anthropic、Mistral、Cohereのモデルを含む、Amazon BedrockのLLMパフォーマンス、使用状況、および安全性に関する包括的な可視性を提供します。

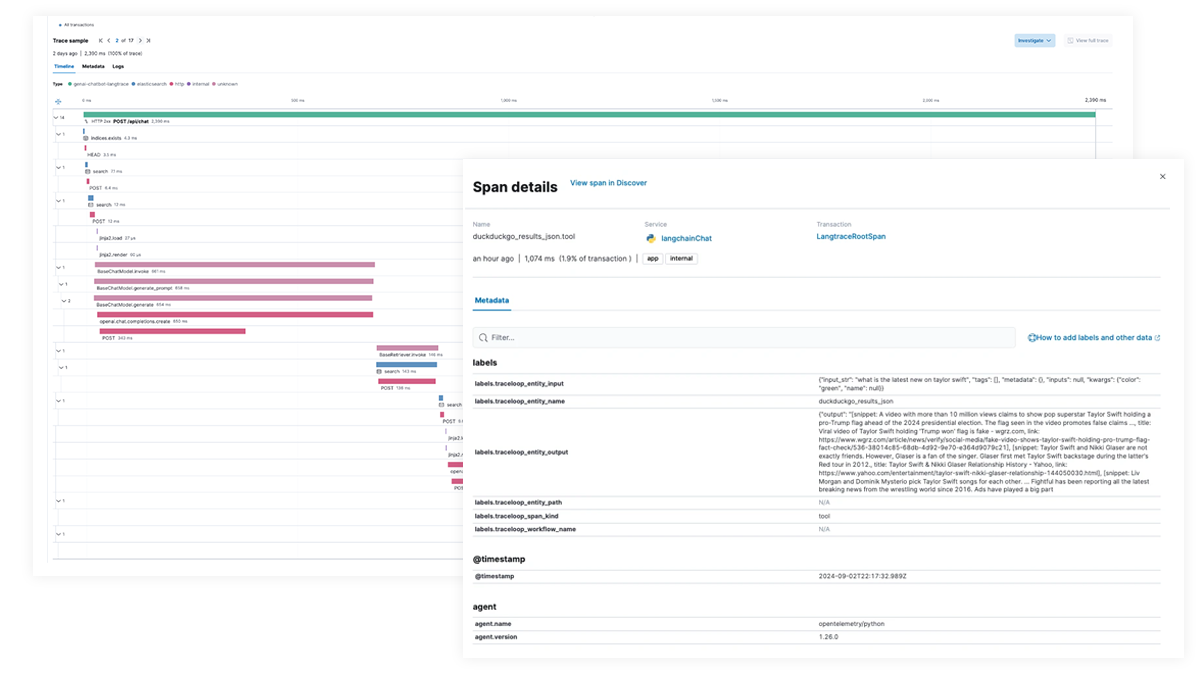

AIアプリとエージェントワークフローのエンドツーエンドのトレースとデバッグ

Elastic APMを使用してOpenTelemetryでAIアプリを分析およびデバッグします。これは、Python、Java、Node.js向けのElastic Distributions of OpenTelemetry(EDOT)および LangTrace、OpenLIT、OpenLLMetryなどのサードパーティのトレースライブラリでサポートされます。