GPUが全力稼働!Elastic Inference Service(EIS):Elasticsearch向けのGPUアクセラレーション推論

_(1).png)

Elastic Cloud上のElasticsearchとネイティブに統合されたGPUアクセラレーション推論を導入する Elastic Inference Service(EIS)を発表できることを嬉しく思います。

Elasticsearchは、最も広く導入されているベクトルおよびセマンティック検索データベースです。最新の検索およびAIワークロードは、埋め込み、再ランク付け、言語モデルのための高速でスケーラブルな推論に依存しています。量が増えるにつれて、インフラストラクチャーの管理、モデルのテスト、統合の処理、ポイントソリューションの組み合わせにより、運用上の負担が大きくなります。これにより、インフラストラクチャーや統合の運用負担なしで、速度、拡張性、コスト効率を提供するマネージドGPUアクセラレーションフリートに対する明確な顧客のニーズが生まれました。Elastic Inference Serviceは、推論をサービスとして提供し、埋め込み、再ランク付け、大規模および小規模の言語モデルをスケールでサービスとして提供するように設計されています。また、EISは、長期的な推論のニーズをすべて満たすために、マルチクラウドサービスプロバイダー(CSP)、マルチリージョン、マルチモーダルサービスとして設計されています。

EISはすでに最先端の大規模言語モデル(LLM)へのアクセスを提供しており、PlaygroundやAIアシスタントの自動取り込み、脅威検出、問題調査、根本原因分析など、すぐに使えるAI機能の基盤となっています。そして今回、最先端の検索関連性を実現するElasticの組み込みスパースベクトルモデルElastic Learned Sparse EncodeR(ELSER)を、EIS初のテキスト埋め込みモデルとしてテクニカルプレビューで提供できることを嬉しく思います。ELSERは、Elastic Platformにおけるセマンティック検索のユースケースの大部分を支え、業界をリードする関連性とパフォーマンスを提供します。これはほんの始まりに過ぎません。多言語埋め込みや再ランキング、そして最近Elasticの買収によって加わったJina AIのモデルなど、今後さらに追加されるモデルにより、可能性はさらに広がります。

最先端のアーキテクチャとパフォーマンス

EISは、最新のNVIDIA GPUを搭載した拡張性のあるアーキテクチャを提供し、低レイテンシかつ高スループットの推論を実現します。GPUを使用すると、機械学習(ML)モデルが多数の計算を並行して処理でき、全体的な効率が桁違いに向上します。

EISはElasticsearchユーザーに高速な推論エクスペリエンスを提供し、セットアップとワークフロー管理を簡素化します。このサービスは、エンドツーエンドのsemantic_textエクスペリエンスを提供し、ベクトル埋め込みを生成し、LLMを使用してコンテキストエンジニアリングとエージェントワークフローをパワーアップすることで、一貫した優れたパフォーマンスと開発者体験を保証します。

効率的な開発者エクスペリエンス:モデルのダウンロード、手動設定、リソースの提供は不要です。EISはsemantic_textおよび推論APIと直接統合されており、快適な開発者エクスペリエンスを提供します。モデルをデプロイする際にコールドスタートが発生することはなく、独自の自動スケーリングを実装する必要もありません。

- エンドツーエンドのセマンティック検索エクスペリエンスの向上:スパースベクトル、デンスベクトル、セマンティックリランキングなど、あらゆる検索に対応しています。さらに多くのモデルが近日中に追加されます!

- パフォーマンスの向上:GPUアクセラレーションによる推論は、特に高負荷時に、CPUベースの代替品と比較して、一貫したレイテンシーと最大10倍の取り込みスループットを提供します。

- 簡素化された生成AIワークフロー:外部サービス、APIキー、契約の煩わしさを省きます。Elastic Managed LLMを使用すれば、取り込み、調査、検出、分析のAI機能が初日からすぐに利用可能です。

- 下位互換性:既存のElasticsearch ML Nodeは引き続きサポートされますが、推論 APIにより、あらゆるサードパーティサービスに柔軟に接続できます。

- わかりやすい料金体系:EISは消費ベースの料金体系を提供しており、他の推論サービスと同様に、モデル100万トークンあたりの料金が発生します。ElasticはEISで提供されるすべてのモデルに対して補償を行っており、導入やサポートへのアクセスが容易です。

- アクセス:すべてのCSPおよびリージョンにおけるElastic Cloud ServerlessおよびElastic Cloud Hostedの導入は、EIS上の推論エンドポイントにアクセス可能です。

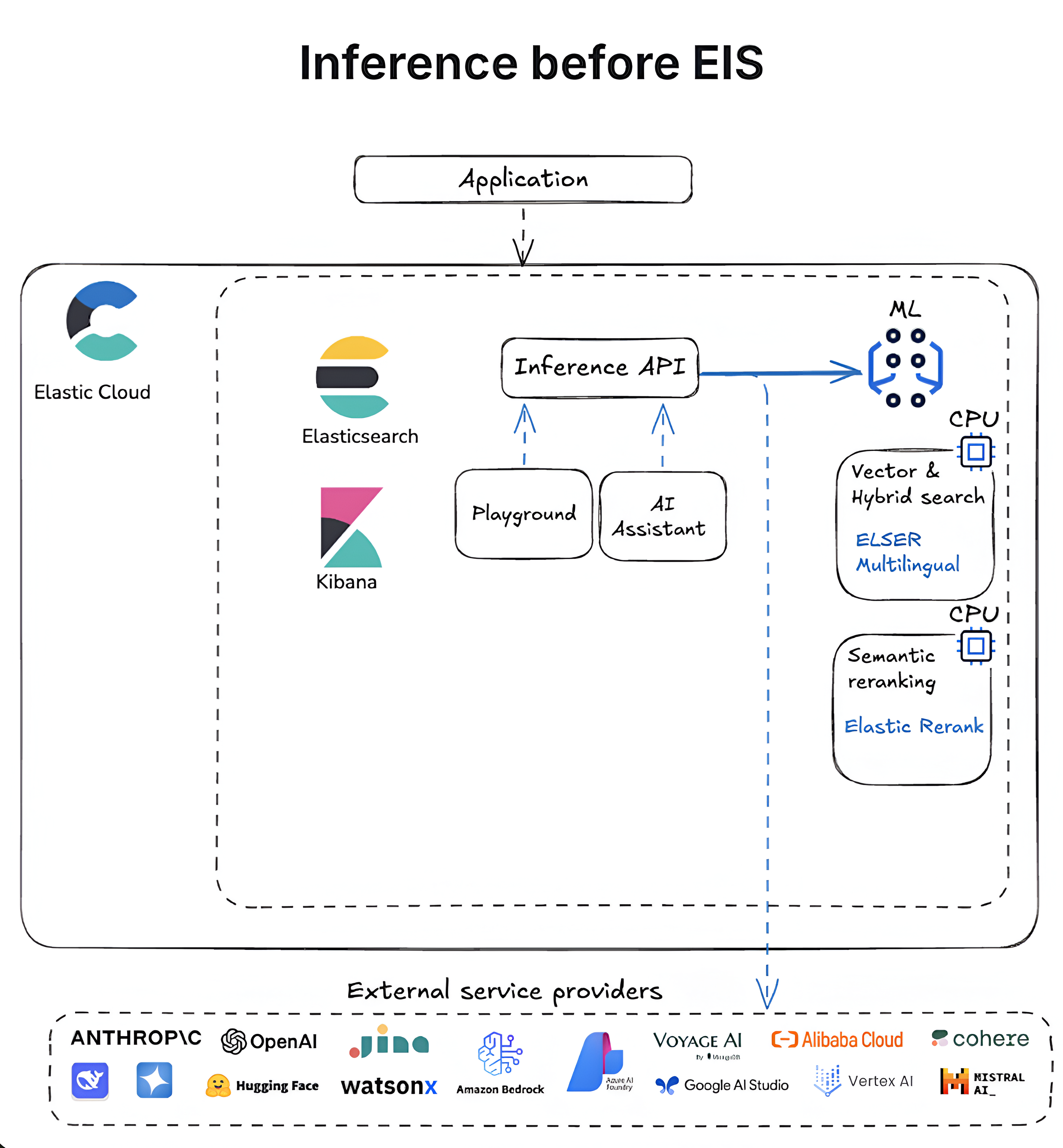

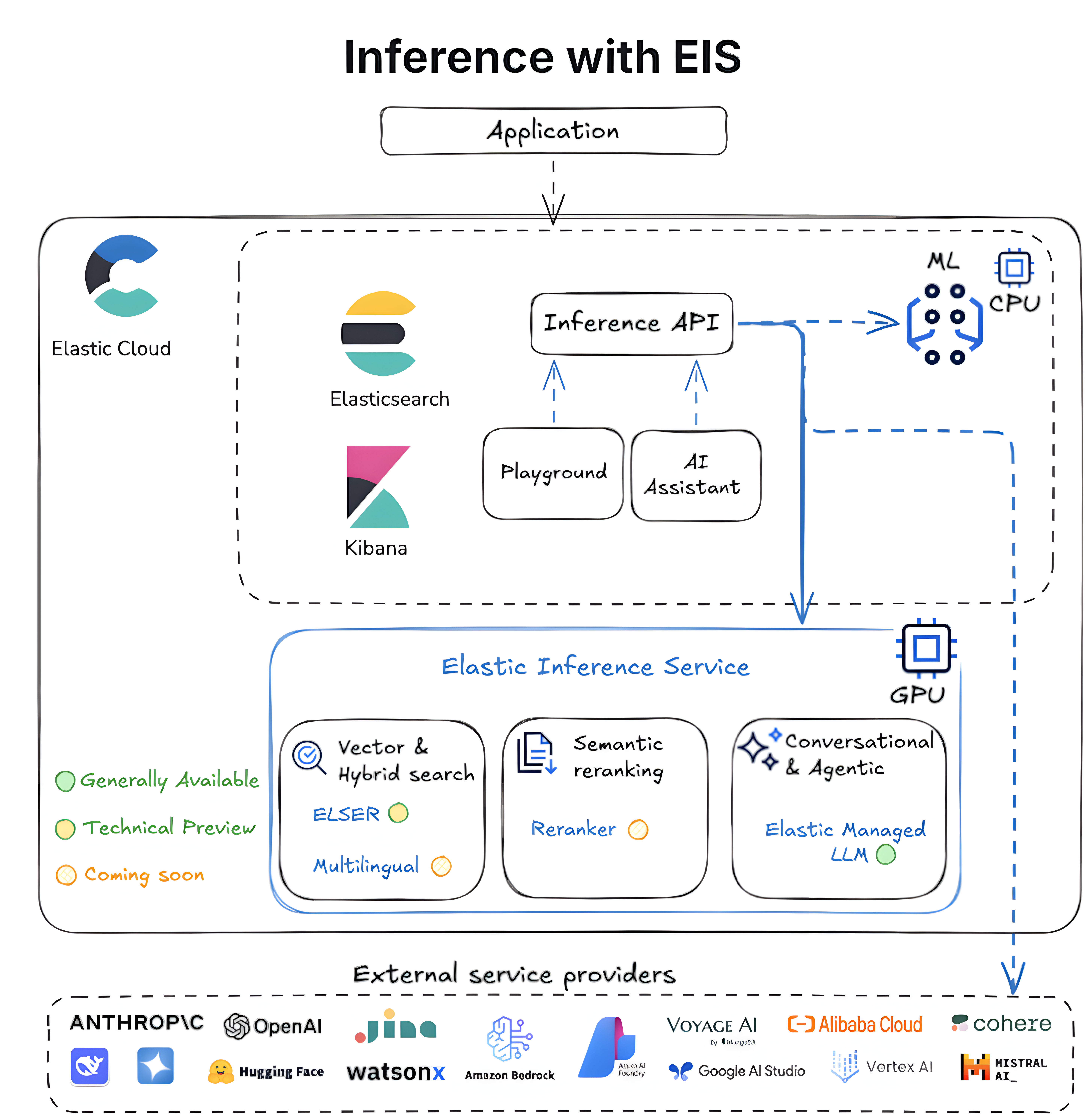

次の図は、Elasticsearchにおける推論の進化を、自己管理型のCPUベースのワークフローから、GPUに最適化された完全統合型のElastic Inference Serviceまで示しています。

次のステップ

私たちは、さまざまなユースケースに対応できるよう、Elastic Inference Serviceへの多くのエキサイティングな改善に取り組んでいます。主なものには次のようなものがあります。

より多くのモデル: お客様の高まる推論ニーズを満たすために、モデルカタログを拡張しています。今後数か月にわたり、さまざまな検索および推論のニーズをサポートするために、EISに新しいモデルを導入する予定です。

セマンティック検索のための多言語埋め込みモデル

セマンティックリランキングモデルで強化されたセマンティック検索と改善されたキーワードベースの検索を実現

マルチモーダル埋め込みモデルとリランキングモデル

小規模言語モデル(SLM)

より多くのLLM

今後もモデルの種類を増やしていきますので、ご希望のモデルがありましたら、support@elastic.coまでご連絡ください。

より多くのCSPとリージョン:近日中により多くのCSPとリージョンへカバレッジを拡大できるよう取り組んでいます。現在の利用可能状況については、ドキュメントをご覧ください。

- 簡素化されたセマンティック検索:クエリのフィールドタイプであるsemantic_textを使用したセマンティック検索は、インジェスト時に推論を行い、適切なデフォルト値を自動的に設定することで、推論ワークフローを簡素化します。まもなく、semantic_textはElastic Inference ServiceのELSERエンドポイントにデフォルトで設定される予定です。

- セルフマネージドのお客様へのさらなるサポート:セルフマネージド環境でも間もなく活用が可能になります。近い将来、クラウド接続モードがEISをセルフマネージド環境に導入し、運用の負担を軽減し、最適な場所でのハイブリッドアーキテクチャとスケーリングを可能にします。

さらに多くのエキサイティングな改善に注力していますので、ご質問がございましたらお気軽にお問い合わせください。

Elastic CloudでEISをお試しください

EISは、シームレスなワークフロー、リアルタイムの洞察、高速化されたパフォーマンスを通じて、Elasticエコシステム内で開発者がより迅速かつ効率的に生成AIアプリケーションを構築できるようにします。

すべてのElastic CloudトライアルでElastic Inference Serviceにアクセスできます。Elastic Cloud ServerlessとElastic Cloud Hostedで今すぐお試しください。

本記事に記述されているあらゆる機能ないし性能のリリースおよびタイミングは、Elasticの単独裁量に委ねられます。現時点で提供されていないあらゆる機能ないし性能は、すみやかに提供されない可能性、または一切の提供が行われない可能性があります。

このブログ記事では、それぞれのオーナーが所有・運用するサードパーティの生成AIツールを使用したり、参照している可能性があります。Elasticはこれらのサードパーティのツールについていかなる権限も持たず、これらのコンテンツ、運用、使用、またはこれらのツールの使用により生じた損失や損害について、一切の責任も義務も負いません。個人情報または秘密/機密情報についてAIツールを使用する場合は、十分に注意してください。提供したあらゆるデータはAIの訓練やその他の目的に使用される可能性があります。提供した情報の安全や機密性が確保される保証はありません。生成AIツールを使用する前に、プライバシー取り扱い方針や利用条件を十分に理解しておく必要があります。

Elastic、Elasticsearch、および関連するマークは、米国およびその他の国におけるElasticsearch B.V.の商標、ロゴ、または登録商標です。他のすべての会社名および製品名は、各所有者の商標、ロゴ、登録商標です。