Recherche hybride simplifiée — Une API unique. Une pertinence exceptionnelle.

Elasticsearch vous offre tous les outils nécessaires pour ajouter une recherche hybride via une API unique, afin que vous puissiez rapidement améliorer les résultats et optimiser la pertinence sans avoir à assembler plusieurs systèmes.

Pourquoi les développeurs choisissent Elasticsearch

Procurez-vous les meilleurs outils pour la précision, l'explicabilité et la maîtrise. La recherche lexicale est performante pour les requêtes structurées, les termes inhabituels et les données externes. La recherche sémantique ajoute une dimension floue et de la récupération lorsque les correspondances exactes ne sont pas optimales. Contrôlez leur synergie en paramétrant la notation, les filtres et les boosts.

Recherche lexicale

Recherche vectorielle

Recherche hybride

Utilisez la notation BM25F avec un contrôle total sur la pondération des champs et l’amplification des termes — aucun modèle n’est requis.

Récupérez des résultats sémantiquement liés via les champs dense_vector ou semantic_text.

Combinez les résultats via reciprocal_rank_fusion ou <options> dans l'API rank.

Optimisez la pertinence en utilisant les combined_fields, le boost, le flou (fuzziness), les synonymes et les analyseurs.

Apportez vos propres embeddings ou utilisez l’inférence intégrée avec ELSER, OpenAI, etc.

Utilisez une requête hybride unique avec filtres partagés, poids et logique de reclassement.

Bénéficiez d'une prise en charge native des filtres geo, term, range et ACL — rapide et stable à grande échelle.

ACORN-1 permet un kNN filtré rapide même sur de grands ensembles de données avec prise en charge de la clause de filtre .

Utilisez explain, profile et le champ _rank_features pour comprendre comment les documents obtiennent leur score.

Recherche lexicale

Recherche vectorielle

Recherche hybride

Utilisez la notation BM25F avec un contrôle total sur la pondération des champs et l’amplification des termes — aucun modèle n’est requis.

Récupérez des résultats sémantiquement liés via les champs dense_vector ou semantic_text.

Combinez les résultats via reciprocal_rank_fusion ou <options> dans l'API rank.

Optimisez la pertinence en utilisant les combined_fields, le boost, le flou (fuzziness), les synonymes et les analyseurs.

Apportez vos propres embeddings ou utilisez l’inférence intégrée avec ELSER, OpenAI, etc.

Utilisez une requête hybride unique avec filtres partagés, poids et logique de reclassement.

Bénéficiez d'une prise en charge native des filtres geo, term, range et ACL — rapide et stable à grande échelle.

ACORN-1 permet un kNN filtré rapide même sur de grands ensembles de données avec prise en charge de la clause de filtre .

Utilisez explain, profile et le champ _rank_features pour comprendre comment les documents obtiennent leur score.

Le meilleur de sa catégorie ? Intégré

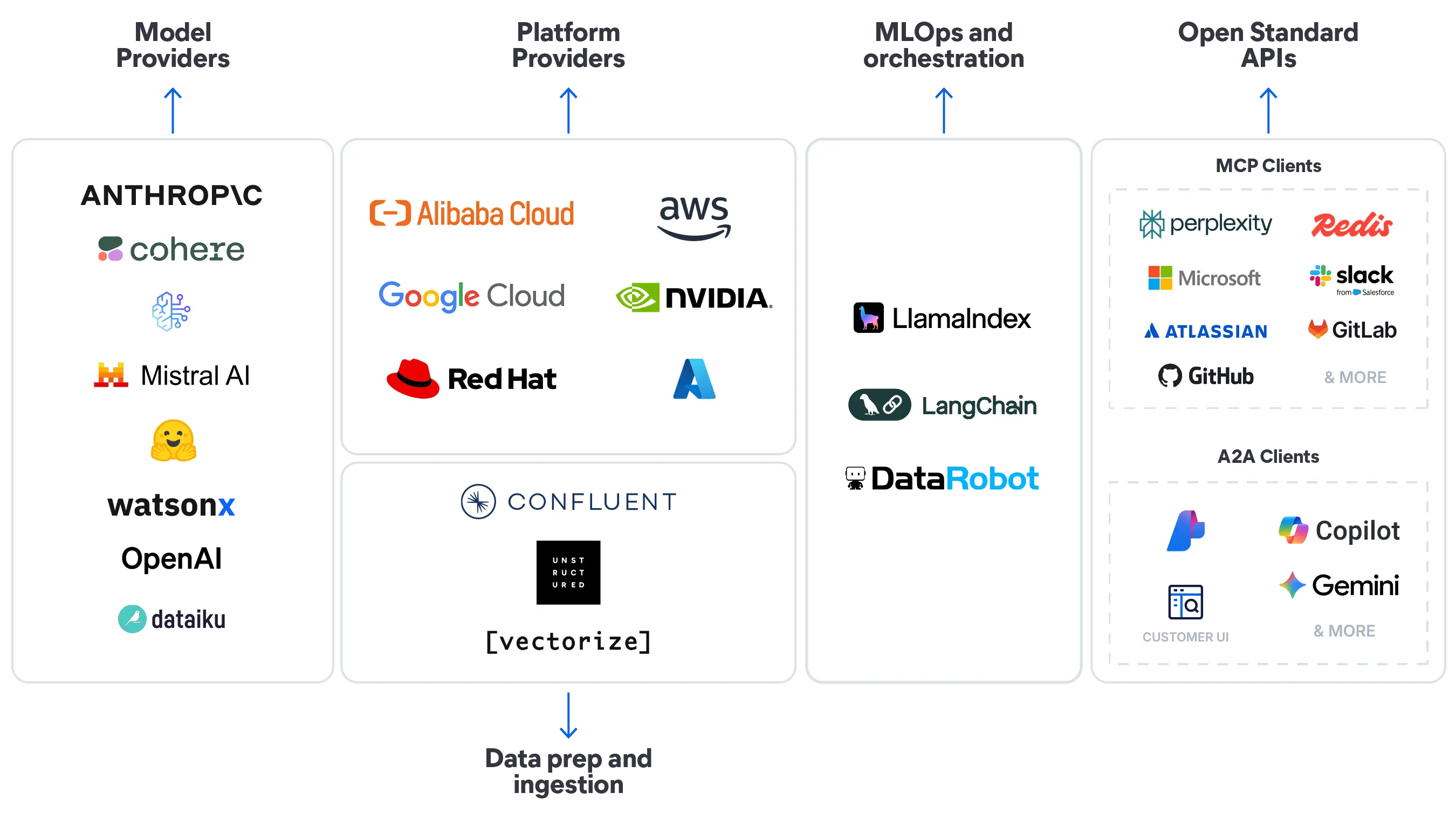

Commencez par les modèles d'IA ELSER et Jina AI, développés par Elastic et intégrés à Elasticsearch. Ou connectez-vous aux modèles que vous utilisez déjà grâce à des intégrations natives dans l'écosystème de l'IA.

Questions fréquentes

Recherche hybride allie la précision des mots-clés (lexicale) à la similarité des vecteurs (sémantique), permettant ainsi aux utilisateurs d’obtenir des résultats pertinents même lorsque les requêtes ne correspondent pas exactement au texte.

La recherche lexicale est faite pour les correspondances exactes et le filtrage. La recherche vectorielle comprend l'intention et la sémantique. La recherche hybride vous permet d'utiliser ces deux approches dans la même requête, classant les résultats en fonction de leur pertinence et non plus seulement de la correspondance.

Les requêtes de récupération associent plusieurs stratégies de recherche, y compris match, kNN ou text_expansion, dans une seule liste de résultats triés grâce à la fonction intégrée de fusion de rangs.

Oui, Elasticsearch prend en charge nativement les filtres, les facettes et les contraintes géospatiales en complément de la recherche vectorielle kNN approximative. Vous n’avez donc pas besoin de refaire le classement ou d’utiliser des solutions de contournement.

Elastic utilise des techniques de notation comme la fusion réciproque des rangs (RRF) ou la pondération convexe pour combiner équitablement les scores lexicaux et vectoriels, afin que les résultats soient équilibrés dès le départ.

Oui. La recherche hybride est entièrement prise en charge avec des champs vectoriels, des requêtes de récupération, des modèles sémantiques, des filtres et l'observabilité, le tout nativement dans Elasticsearch.