GPUs auf Kurs! Elastic Inference Service (EIS): GPU-beschleunigte Inferenz für Elasticsearch

_(1).png)

Wir freuen uns, den Elastic Inference Service (EIS) ankündigen zu können, der GPU-beschleunigte Inferenz einführt, die nativ in Elasticsearch auf Elastic Cloud integriert ist.

Elasticsearch ist die am weitesten verbreitete Vektor- und semantische Suchdatenbank. Moderne Suchen und KI-Workloads sind auf schnelle, Skalierbarkeit Inferenzen für Embeddings, Reranking und Sprachmodelle angewiesen. Mit zunehmendem Volumen stellen die Verwaltung der Infrastruktur, das Testen von Modellen, die Handhabung von Integrationen und das Zusammenfügen von Punktlösungen einen erheblichen operativen Aufwand dar. Dies hat einen klaren Kundenbedarf an verwalteten, GPU-beschleunigten Fleets geschaffen, die Geschwindigkeit, Skalierbarkeit und Kosteneffizienz bieten, ohne den betrieblichen Aufwand von Infrastruktur oder Integrationen. Der Elastic Inference Service wurde entwickelt, um Inferenz-as-a-Service bereitzustellen und Einbettung, Neubewertung sowie große und kleine Sprachmodelle als Service zu skalieren. Wir haben EIS auch als Multi-Cloud-Dienstanbieter (CSP), multiregionalen und multimodalen Dienst konzipiert, um alle Ihre langfristigen Inferenzanforderungen zu erfüllen.

EIS bietet bereits Zugriff auf ein hochmodernes Large Language Model (LLM), das wiederum sofort einsatzbereite KI-Features für die automatische Ingest, Bedrohungserkennung, Problemuntersuchung, Ursachenanalyse und mehr für Playground und KI-Assistenten bereitstellt. Wir freuen uns nun, Elastic Learned Sparse EncodeR (ELSER) – das integrierte Sparse-Vektormodell von Elastic für modernste Suchrelevanz – als erstes Texteinbettungsmodell auf EIS in der technischen Vorschau anbieten zu können. ELSER unterstützt einen Großteil der Anwendungsfälle für die semantische Suche auf unserer Plattform und bietet branchenführende Relevanz und Leistung. Das ist erst der Anfang; weitere Modelle für mehrsprachige Einbettungen, Reranking und Modelle von Jina AI, die kürzlich durch die Übernahme zu Elastic gestoßen sind, sind auf dem Weg, um die Möglichkeiten weiter auszubauen.

Hochmoderne Architektur und Leistung

EIS bietet eine Architektur mit Skalierbarkeit mit modernen NVIDIA-GPUs, um Inferenzen mit niedriger Latenz und hohem Durchsatz bereitzustellen. GPUs ermöglichen es Machine-Learning-(ML)-Modellen, viele Berechnungen parallel durchzuführen, wodurch die Gesamteffizienz um ein Vielfaches gesteigert wird.

EIS bietet Elasticsearch-Nutzern eine schnelle Inferenzerfahrung und vereinfacht die Einrichtung und das Workflow-Management. Der Dienst gewährleistet eine gleichbleibend hohe Leistung und Entwicklererfahrung, indem er einfach zu nutzende Inferenzen über APIs für ein durchgängiges semantisches Texterlebnis, die Generierung von Vektoreinbettungen und die Nutzung von LLMs, um Context Engineering und agentenbasierten Workflows mit Energie zu versorgen, bereitstellt.

Optimierte Entwicklererfahrung: Keine Modell-Downloads, keine manuelle Konfiguration oder Ressourcenbereitstellung sind erforderlich. EIS integriert sich direkt in semantic_text und die Inferenz-APIs, um eine angenehme Entwicklererfahrung zu bieten. Es gibt keine Kaltstarts beim Bereitstellen von Modellen, und es ist nicht erforderlich, eine eigene automatische Skalierung zu implementieren.

- Verbesserte End-to-End-Semantiksuche: Spärliche Vektoren, dichte Vektoren oder semantisches Reranking – wir haben alles für Sie. Weitere Modelle folgen in Kürze!

- Verbesserte Leistung: Die GPU-beschleunigte Inferenz bietet eine konsistente Latenz und bis zu 10-mal besseren Ingest-Durchsatz im Vergleich zu CPU-basierten Alternativen, insbesondere bei höheren Lasten.

- Vereinfachte generative KI (GenAI) Workflows: Vermeiden Sie die Reibung durch externe Dienste, API-Schlüssel und Verträge. Mit Elastic Managed LLM sind KI-Features für Ingest, Untersuchung, Erkennung und Analyse vom ersten Tag an einsatzbereit.

- Abwärtskompatibilität: Bestehende Elasticsearch ML-Nodes werden weiterhin unterstützt, während die Inferenz-API Ihnen die volle Flexibilität bietet, beliebige Drittanbieterdienste zu verbinden.

- Leicht verständliche Preisgestaltung: EIS bietet verbrauchsbasierte Preisgestaltung, ähnlich wie bei anderen Inferenzdiensten, die pro Modell und pro Million Token berechnet werden. Elastic stellt zudem alle auf EIS bereitgestellten Modelle frei von Haftung, was den Einstieg und den Zugang zum Support erleichtert.

- Zugriff: Elastic Cloud Serverless- und Elastic Cloud Hosted-Deployments in allen CSPs und Regionen können auf die Inferenz-Endpoints auf EIS zugreifen.

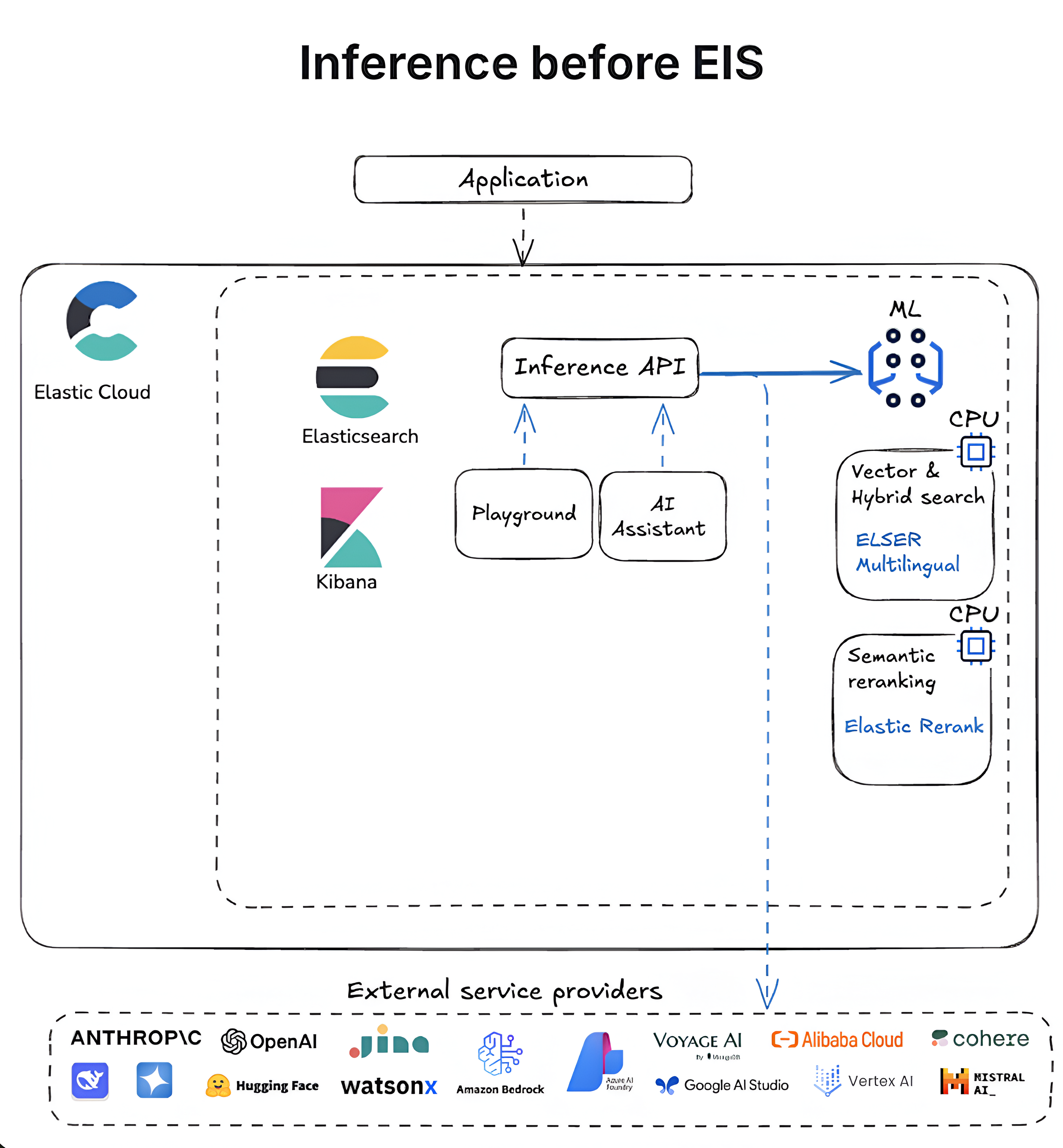

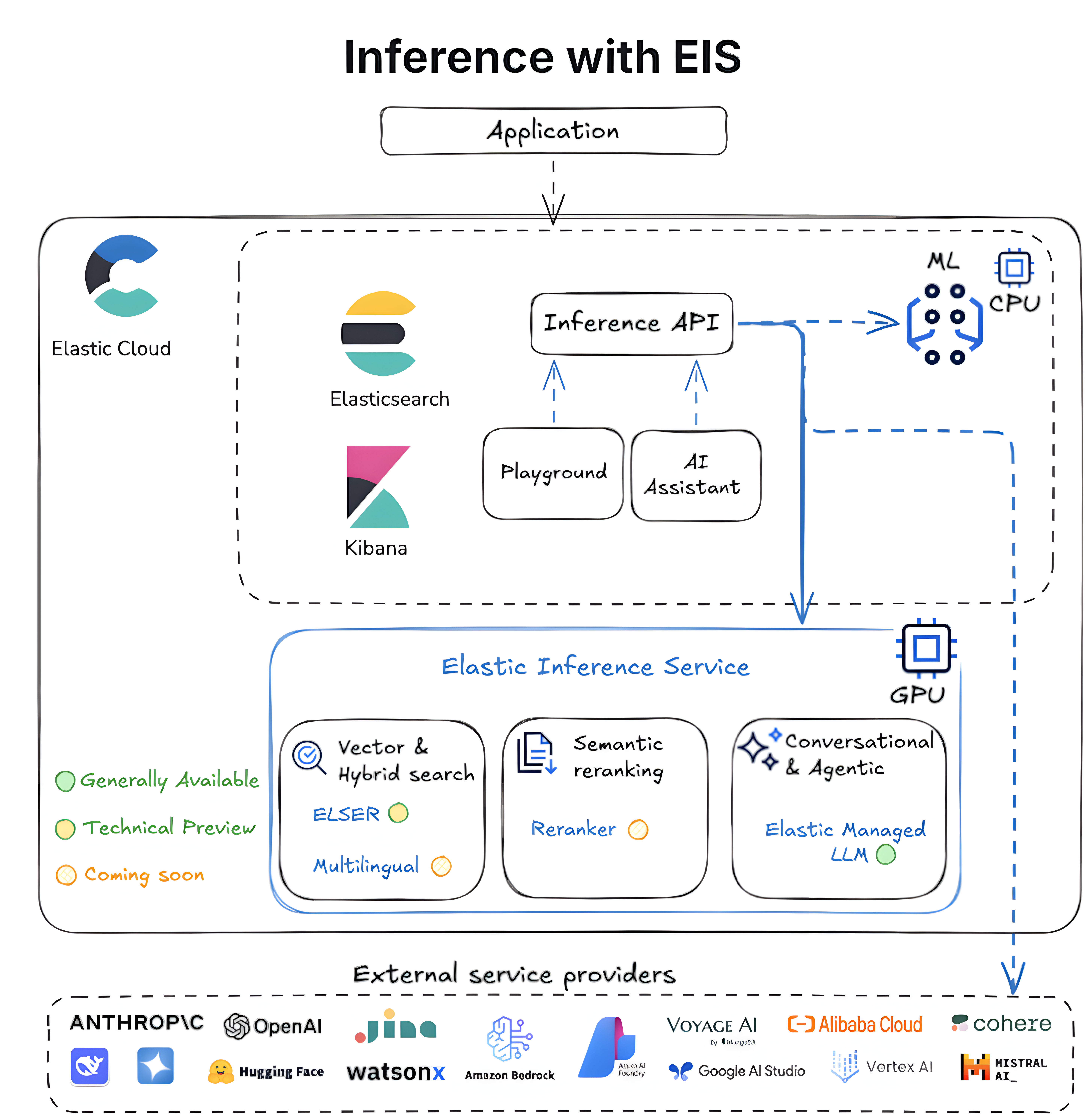

Die folgenden Diagramme skizzieren die Entwicklung der Inferenz in Elasticsearch von selbstverwalteten, CPU-basierten Workflows hin zum GPU-optimierten, vollständig integrierten Elastic Inference Service.

Wie geht es weiter?

Wir arbeiten an vielen spannenden Verbesserungen des Elastic Inference Service, um eine Vielzahl von Anwendungsfällen mit Energie zu versorgen. Einige der wichtigsten sind:

Mehr Modelle: Wir erweitern unseren Modellkatalog, um den steigenden Inferenzanforderungen unserer Kunden gerecht zu werden. In den kommenden Monaten werden wir neue Modelle auf EIS einführen, um eine größere Vielfalt an Such- und Inferenzanforderungen zu unterstützen, darunter:

Mehrsprachiges Einbettungsmodell für die semantische suchen

Semantisches Reranking-Modell für eine verbesserte semantische suchen und eine verbesserte schlüsselwortbasierte suchen

Multimodale Einbettung und Neusortierung von Modellen

Kleine Sprachmodelle (SLMs)

Mehr LLMs

Wir werden weiterhin weitere Modelltypen hinzufügen. Wenn Sie also ein Modell sehen möchten, wenden Sie sich an uns unter support@elastic.co.

Weitere CSPs und Regionen: Wir arbeiten daran, die Abdeckung bald auf weitere CSPs und Regionen auszuweiten. Informationen zur aktuellen Verfügbarkeit finden Sie in unseren Dokumentationen.

- Vereinfachte semantische Suchen: Die semantische Suche mit semantic_text, einem Feldtyp in der Abfrage, vereinfacht den Inferenz-Workflow, indem sie die Inferenz zum Zeitpunkt der Ingestion und sinnvolle Standardwerte automatisch bereitstellt. In Kürze wird semantic_text standardmäßig auf den ELSER-Endpoint des Elastic Inference Service verweisen.

- Mehr Liebe für selbstverwaltete Kunden: Unsere selbstverwalteten Nutzer können bald mitmachen. In naher Zukunft wird der Cloud Connected Mode EIS in selbstverwaltete Umgebungen bringen, wodurch der Betriebsaufwand reduziert wird und hybride Architekturen und Skalierungen dort ermöglicht werden, wo es für Sie am besten funktioniert.

Wir haben noch viele weitere spannende Verbesserungen, auf die wir uns konzentrieren. Bitte wenden Sie sich an uns, wenn Sie Fragen haben.

EIS auf Elastic Cloud testen

Mit nahtlosen Workflows, Echtzeit-Einblicken und beschleunigter Leistung befähigt EIS Entwickler, schnellere und effizientere GenAI-Anwendungen innerhalb des Elastic-Ökosystems zu erstellen.

Alle Elastic Cloud-Testversionen haben Zugriff auf den Elastic Inference Service. Probieren Sie es jetzt auf Elastic Cloud Serverless und Elastic Cloud Hosted aus.

Die Entscheidung über die Veröffentlichung der in diesem Blogeintrag beschriebenen Leistungsmerkmale und Features sowie deren Zeitpunkt liegt allein bei Elastic. Es ist möglich, dass noch nicht verfügbare Leistungsmerkmale oder Features nicht rechtzeitig oder überhaupt nicht veröffentlicht werden.

In diesem Blogpost haben wir möglicherweise generative KI-Tools von Drittanbietern verwendet oder darauf Bezug genommen, die von ihren jeweiligen Eigentümern betrieben werden. Elastic hat keine Kontrolle über die Drittanbieter-Tools und übernimmt keine Verantwortung oder Haftung für ihre Inhalte, ihren Betrieb oder ihre Anwendung sowie für etwaige Verluste oder Schäden, die sich aus Ihrer Anwendung solcher Tools ergeben. Gehen Sie vorsichtig vor, wenn Sie KI-Tools mit persönlichen, sensiblen oder vertraulichen Daten verwenden. Alle Daten, die Sie eingeben, können für das Training von KI oder andere Zwecke verwendet werden. Es gibt keine Garantie dafür, dass Informationen, die Sie bereitstellen, sicher oder vertraulich behandelt werden. Setzen Sie sich vor Gebrauch mit den Datenschutzpraktiken und den Nutzungsbedingungen generativer KI-Tools auseinander.

Elastic, Elasticsearch und zugehörige Marken sind Marken, Logos oder eingetragene Marken von Elasticsearch B.V. in den Vereinigten Staaten und anderen Ländern. Alle anderen Unternehmens- und Produktnamen sind Marken, Logos oder eingetragene Marken ihrer jeweiligen Eigentümer.