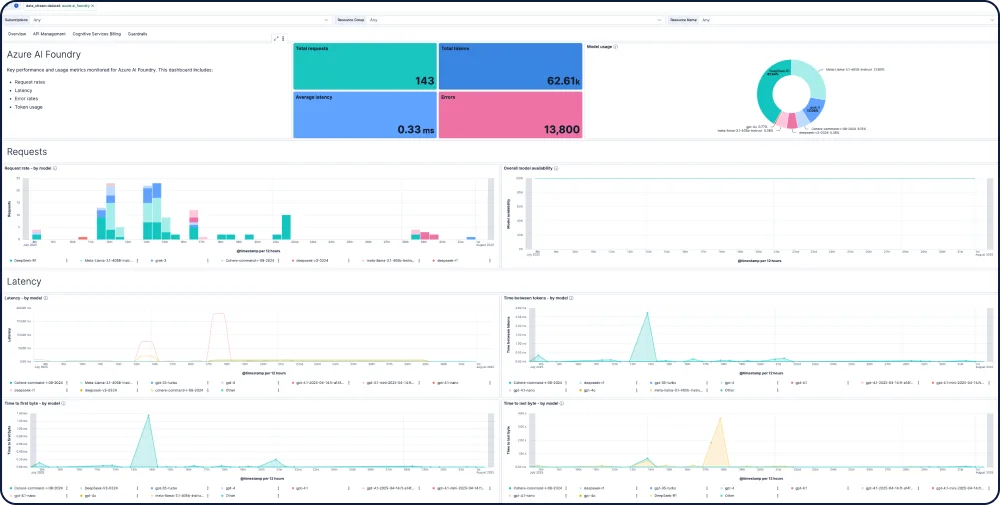

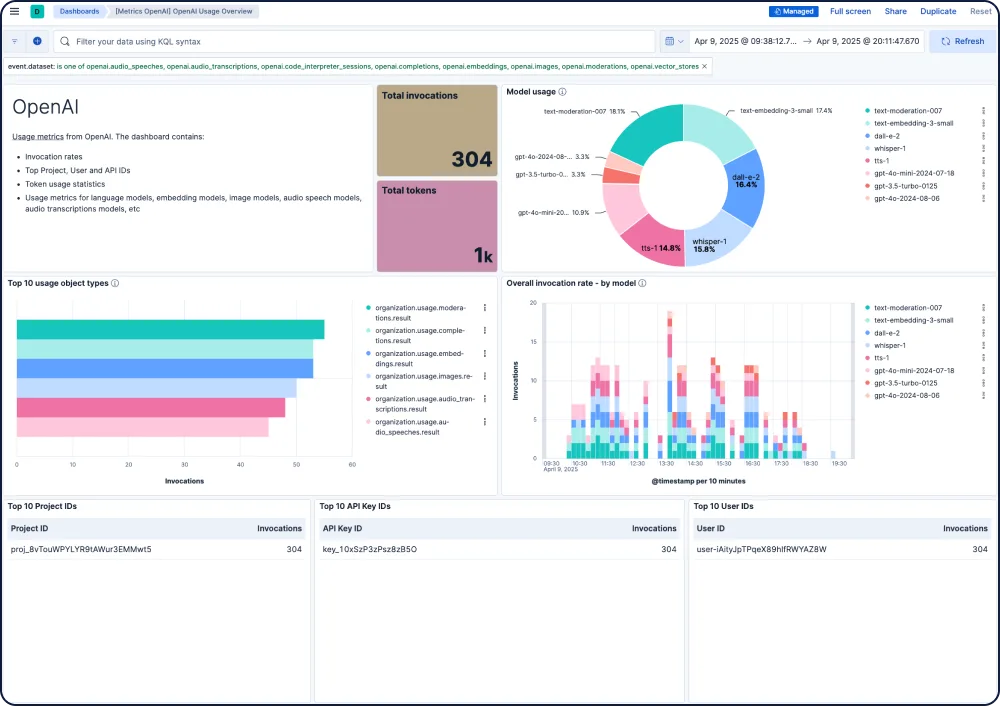

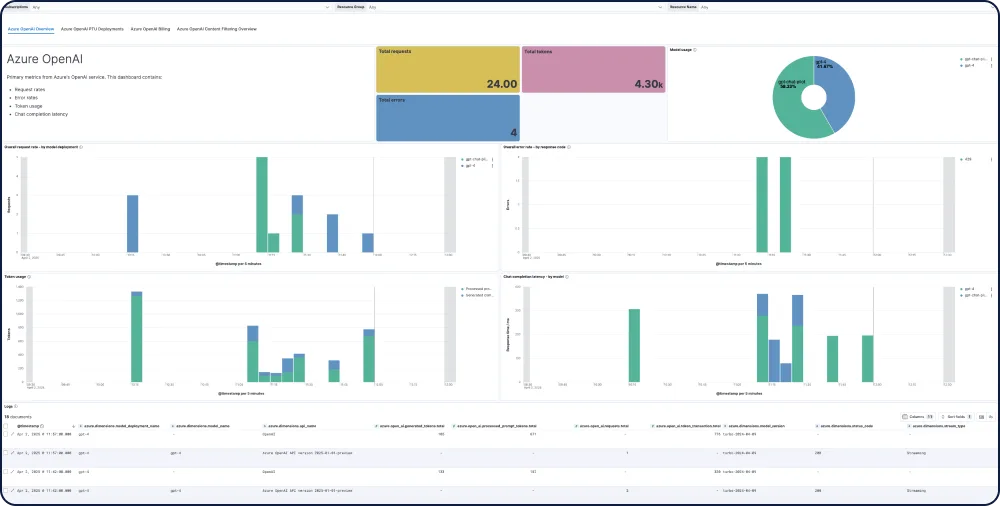

대시보드 갤러리

AI 앱을 위한 통합 및 기능

모든 모델에서 성능, 안전성 및 지출을 추적하세요.

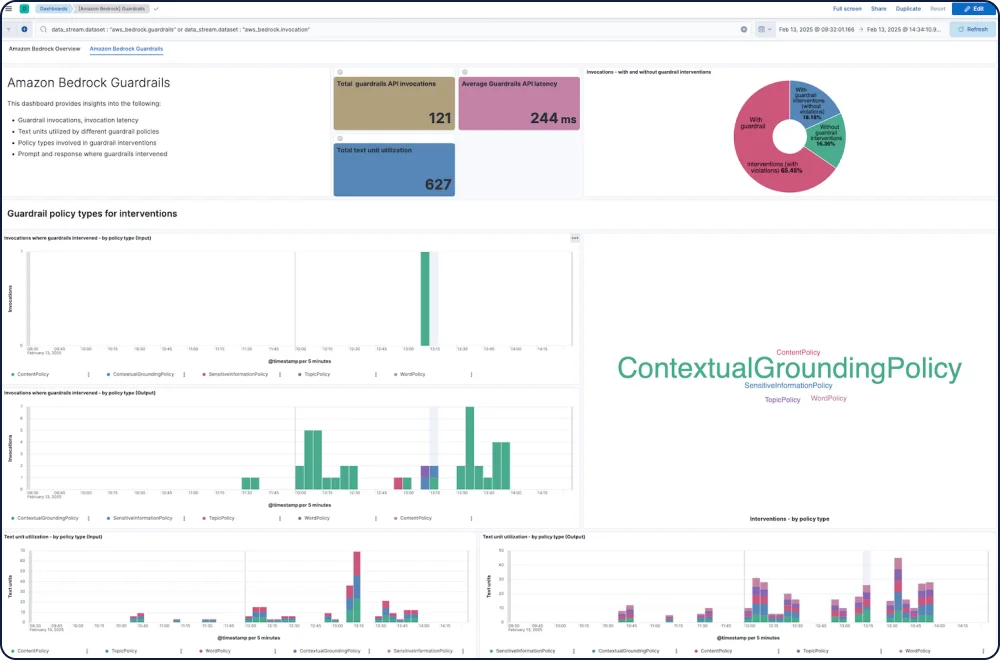

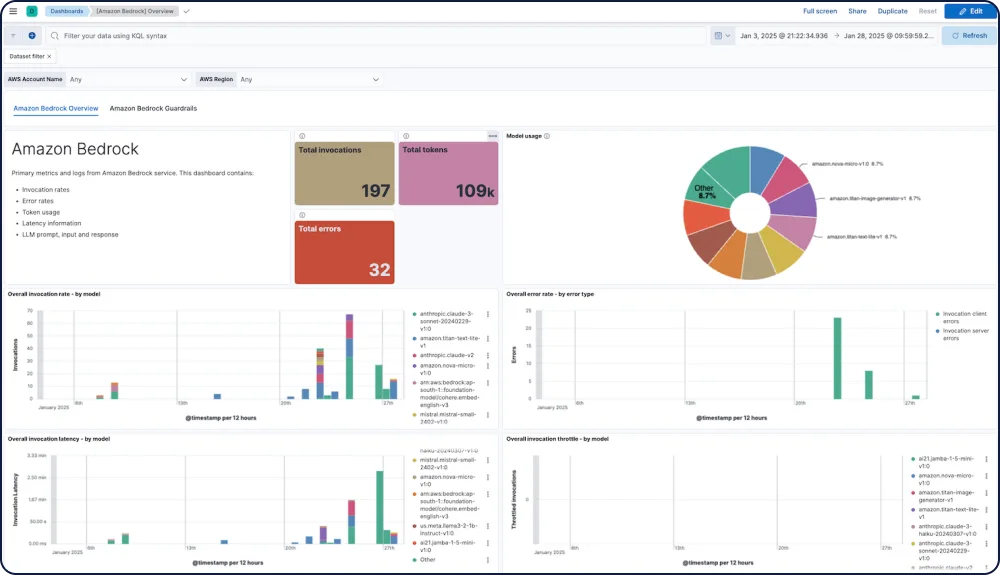

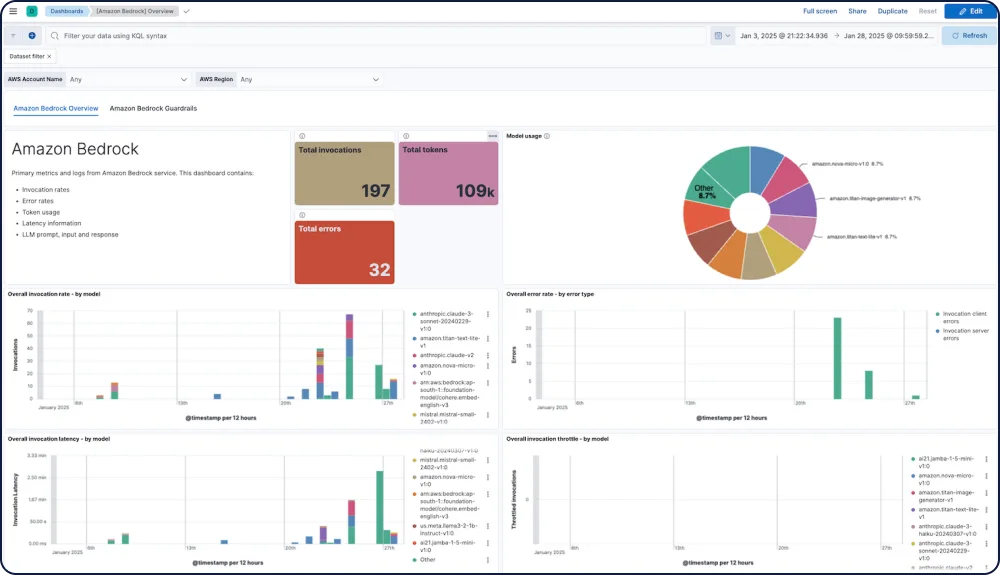

Elastic Observability의 Amazon Bedrock 통합은 Anthropic, Mistral, Cohere 등의 모델을 포함한 Amazon Bedrock LLM 성능, 사용량, 안전성에 대한 종합적인 가시성을 제공합니다.

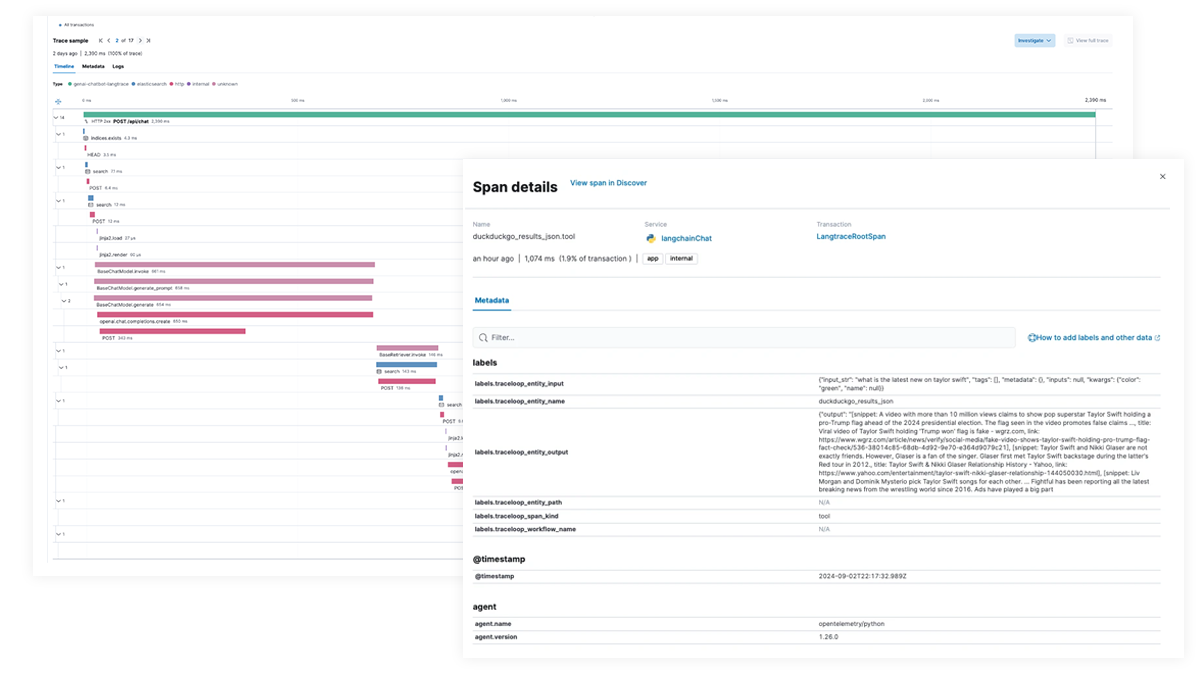

AI 앱과 에이전틱 워크플로우를 위한 엔드 투 엔드 추적 및 디버깅

Elastic APM을 사용해 OpenTelemetry로 AI 앱을 분석하고 디버깅하세요. Python, Java 및 Node.js용 Elastic Distributions of OpenTelemetry(EDOT)를 통해 지원되며, LangTrace, OpenLIT 및 OpenLLMetry와 같은 타사 추적 라이브러리도 지원됩니다.