Monitorea tu pila de IA con la observabilidad de LLM

Detecta riesgos, resuelve problemas y mantén tus aplicaciones de IA agéntica y generativa listas para la producción con las capacidades de monitoreo de extremo a extremo de Elastic Observability.

Desde bibliotecas hasta modelos, te tenemos cubierto

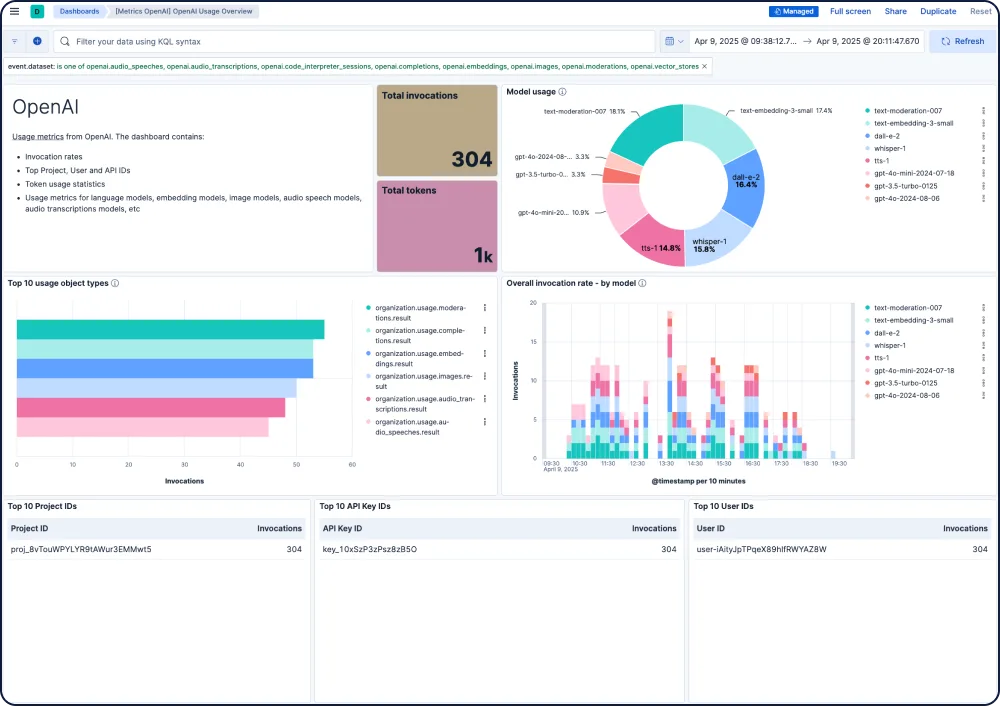

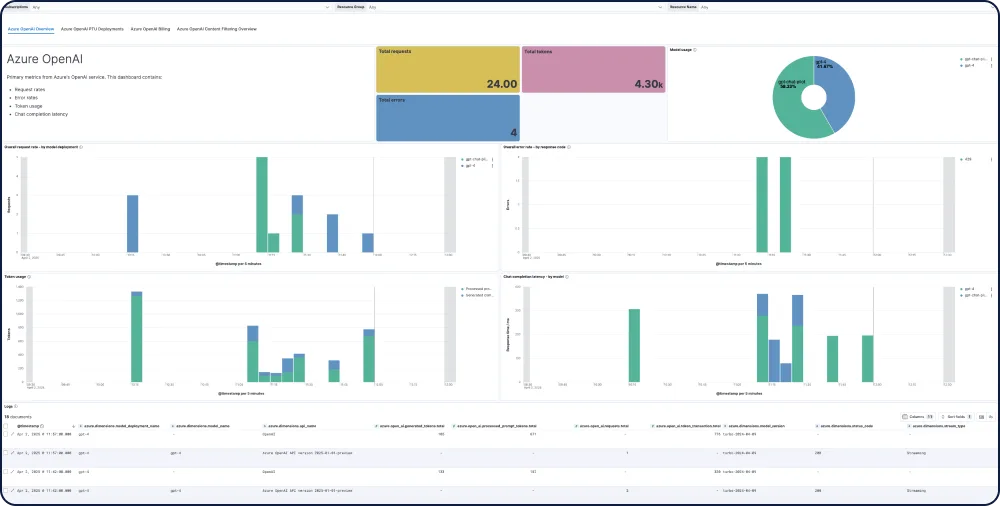

Elastic te ofrece visibilidad de extremo a extremo para apps de IA, integrándose con bibliotecas de rastreo populares y proporcionando información lista para usar sobre modelos de todos los principales proveedores de LLM, incluidos GPT-4o, Mistral, LLaMA, Anthropic, Cohere y DALL·E.

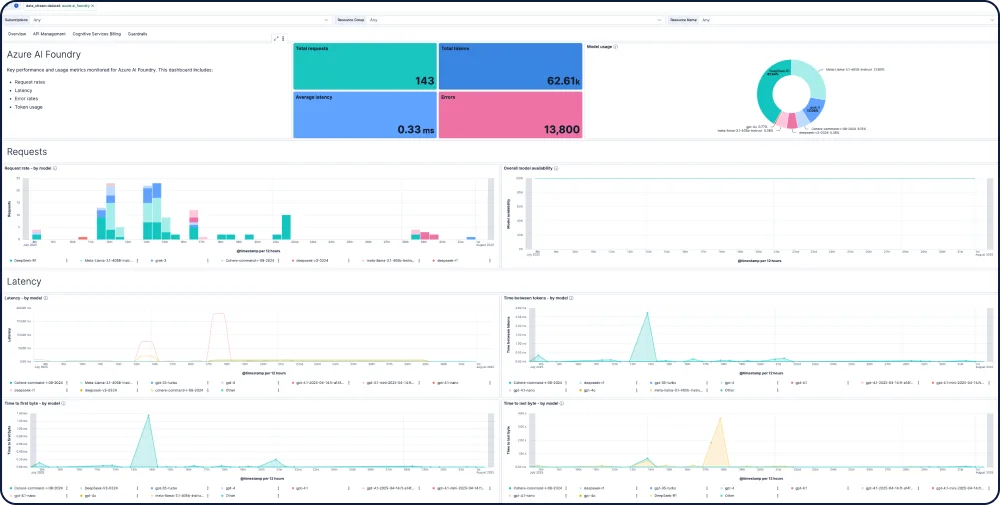

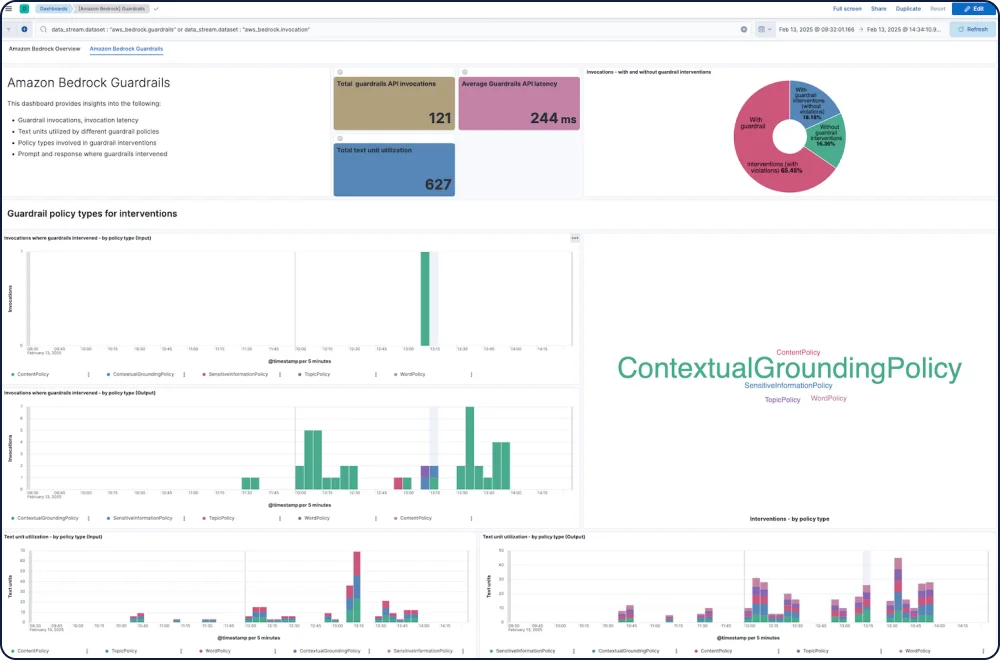

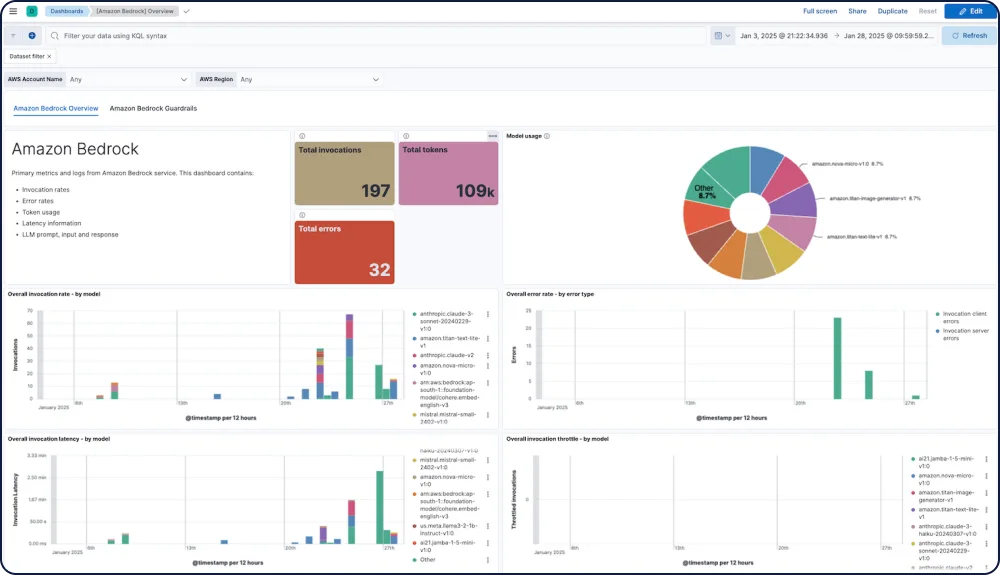

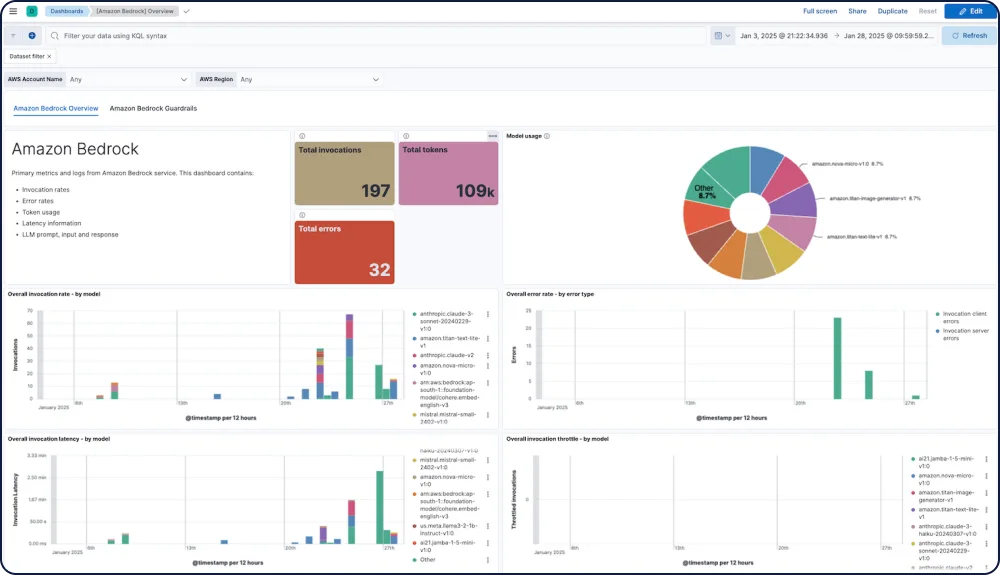

GALERÍA DE DASHBOARDS

Integraciones y capacidades para tus apps de IA

Rastrea el rendimiento, la seguridad y el gasto en todos los modelos.

La integración de Amazon Bedrock para Elastic Observability proporciona una visibilidad completa del rendimiento, el uso y la seguridad de Amazon Bedrock LLM, incluyendo modelos de Anthropic, Mistral y Cohere.

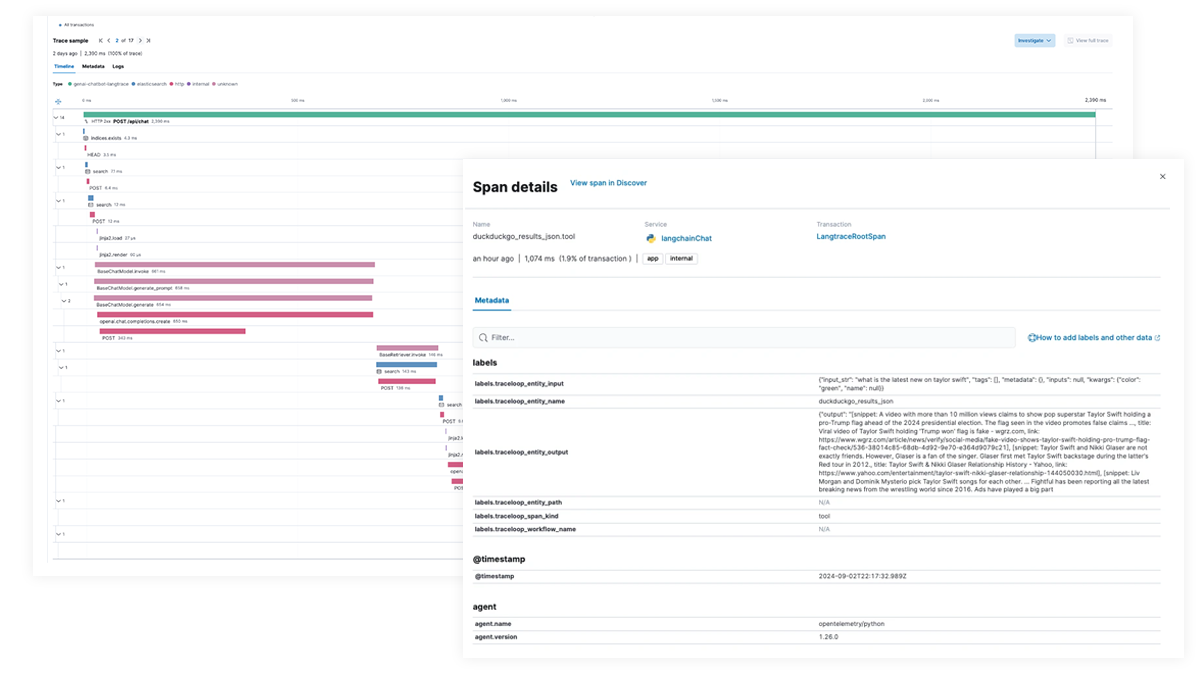

Trazado y depuración de extremo a extremo para apps de IA y flujos de trabajo agénticos

Usa Elastic APM para analizar y depurar apps de IA con OpenTelemetry, compatible con las Elastic Distributions of OpenTelemetry (EDOT) para Python, Java y Node.js, así como bibliotecas de rastreo de terceros como LangTrace, OpenLIT y OpenLLMetry.

¡Prueba la app de chatbot RAG de Elastic tú mismo!

Esta app de muestra combina Elasticsearch, LangChain y distintos LLM para potenciar un chatbot con ELSER y tus datos privados.