¡Las GPU a toda máquina! Servicio de Inferencia Elastic (EIS): inferencia acelerada por GPU para Elasticsearch

_(1).png)

Nos entusiasma anunciar el Elastic Inference Service (EIS), que introduce la inferencia acelerada por GPU que se integra de manera nativa con Elasticsearch en Elastic Cloud.

Elasticsearch es la base de datos de búsqueda vectorial y semántica más ampliamente desplegada. Las cargas de trabajo modernas de búsqueda e inteligencia artificial dependen de una inferencia rápida y con escalabilidad para embeddings, reclasificación y modelos de lenguaje. A medida que los volúmenes crecen, gestionar la infraestructura, probar modelos, manejar integraciones y unir soluciones puntuales agrega una gran carga operativa. Esto ha creado una clara necesidad del cliente de Fleet administradas aceleradas por GPU que ofrezcan velocidad, escalabilidad y rentabilidad sin la sobrecarga operativa de la infraestructura o las integraciones. El Servicio de Inferencia de Elastic está diseñado para ofrecer inferencia como servicio y para proporcionar incrustación, reclasificación y modelos de lenguaje grandes y pequeños como servicio a escalar. También hemos diseñado EIS para que sea un proveedor de servicios multi-cloud (CSP), multirregional y multimodal para satisfacer todas tus necesidades de inferencia a largo plazo.

EIS ya proporciona acceso a un modelo de lenguaje extenso (LLM) de última generación, que a su vez impulsa características de IA listas para usar para la ingesta automática, la detección de amenazas, la investigación de problemas, el análisis de la causa raíz y mucho más para Playground y asistentes de IA. Ahora estamos encantados de presentar Elastic Learned Sparse EncodeR (ELSER), el modelo de vectores dispersos integrado en Elastic para una búsqueda de relevancia de última generación, como el primer modelo de incrustación de texto en EIS en vista previa técnica. ELSER impulsa la mayoría de los casos de uso de búsqueda semántica en nuestra Platform y proporciona una relevancia y un rendimiento líderes en el sector. Esto es solo el principio; se acercan modelos adicionales para incrustaciones multilingües, reranking y modelos de Jina AI (que recientemente se unió a Elastic mediante adquisición) que desafiarán las posibilidades.

Arquitectura y rendimiento de última generación

EIS ofrece una arquitectura de escalabilidad con GPUs modernas de NVIDIA para proporcionar inferencia de baja latencia y alto rendimiento. Las GPU permiten que los modelos de machine learning (ML) procesen muchos cálculos en paralelo, aumentando la eficiencia general en un orden de magnitud.

EIS ofrece a los usuarios de Elasticsearch una experiencia de inferencia rápida mientras simplifica la configuración y la gestión del flujo de trabajo. El servicio garantiza un rendimiento superior y una experiencia de desarrollador consistente, proporcionando inferencia fácil de consumir a través de API para una experiencia de texto semántico de extremo a extremo, generando incrustaciones vectoriales y utilizando LLMs para impulsar la ingeniería de contexto y los flujos de trabajo agénticos.

Experiencia de desarrollador optimizada: no es necesario descargar modelos, configurar de forma manual ni provisionar recursos. EIS se integra directamente con semantic_text y las API de inferencia para una experiencia de desarrollador agradable. No hay arranques en frío al desplegar modelos y no es necesario implementar tu propio escalado automático.

- Experiencia mejorada de búsqueda semántica de extremo a extremo: vectores dispersos, vectores densos o reranking semántico: nos ocupamos de todo. ¡Más modelos próximamente!

- Rendimiento mejorado: la inferencia acelerada por GPU proporciona una latencia constante y un rendimiento de ingesta hasta 10 veces mejor en comparación con las alternativas basadas en CPU, especialmente con cargas más altas.

- Flujos de trabajo simplificados de IA generativa (GenAI): evita la fricción de los servicios externos, las claves de API y los contratos. Con Elastic Managed LLM, las características de IA para la ingesta, la investigación, la detección y el análisis funcionan desde el primer día.

- Compatibilidad con versiones anteriores: los nodos de Elasticsearch ML existentes siguen siendo compatibles, mientras que la API de inferencia te brinda total flexibilidad para conectar cualquier servicio de terceros.

- Precios fáciles de entender: EIS ofrece precios basados en el consumo similares a otros servicios de inferencia que se cobran por modelo por millón de tokens. Elastic también indemniza todos los modelos proporcionados en EIS, lo que permite comenzar y acceder al soporte con facilidad.

- Acceso: los despliegues de Elastic Cloud Serverless y Elastic Cloud Hosted en todos los CSP y las regiones pueden acceder a los endpoints de inferencia en EIS.

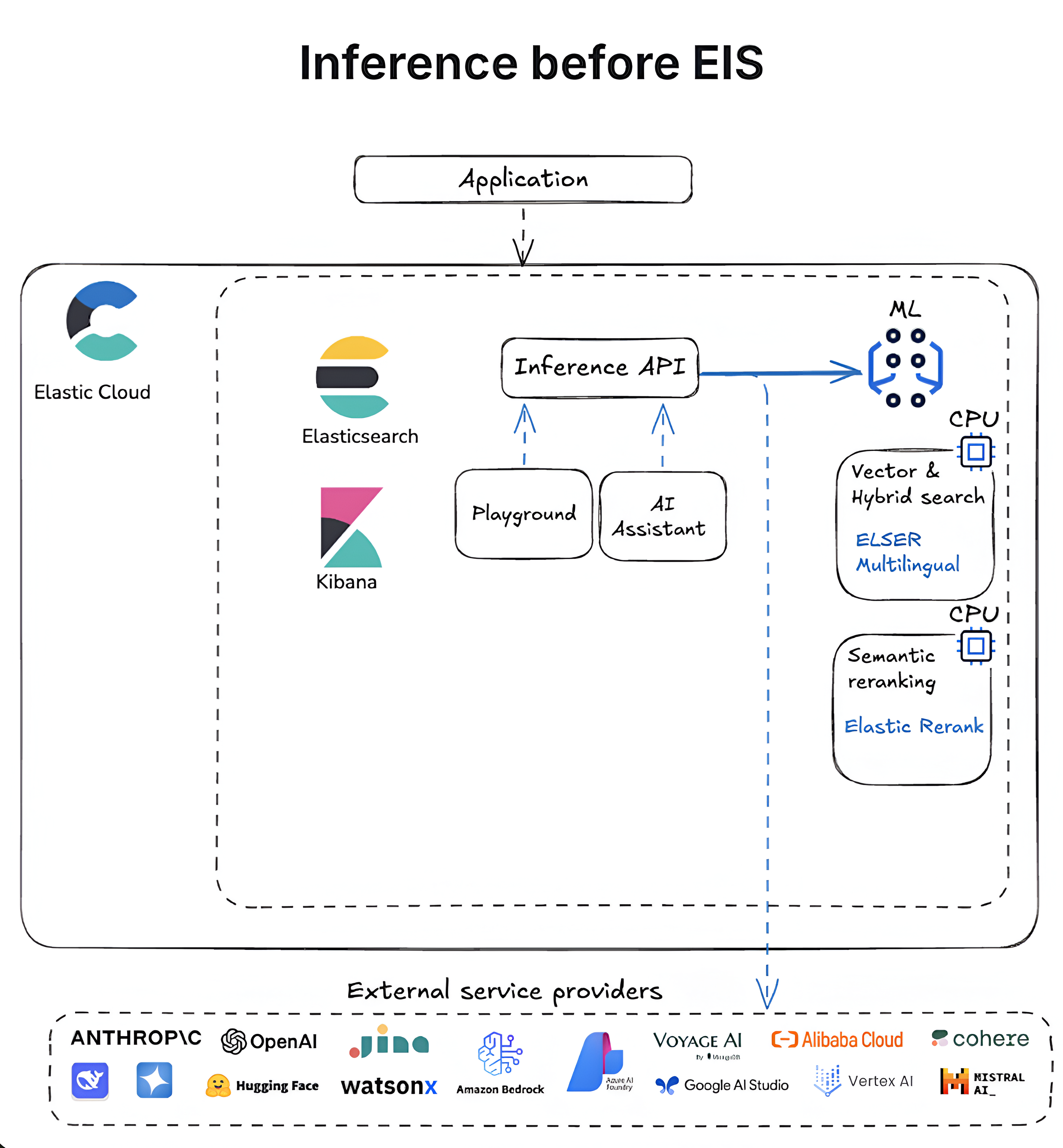

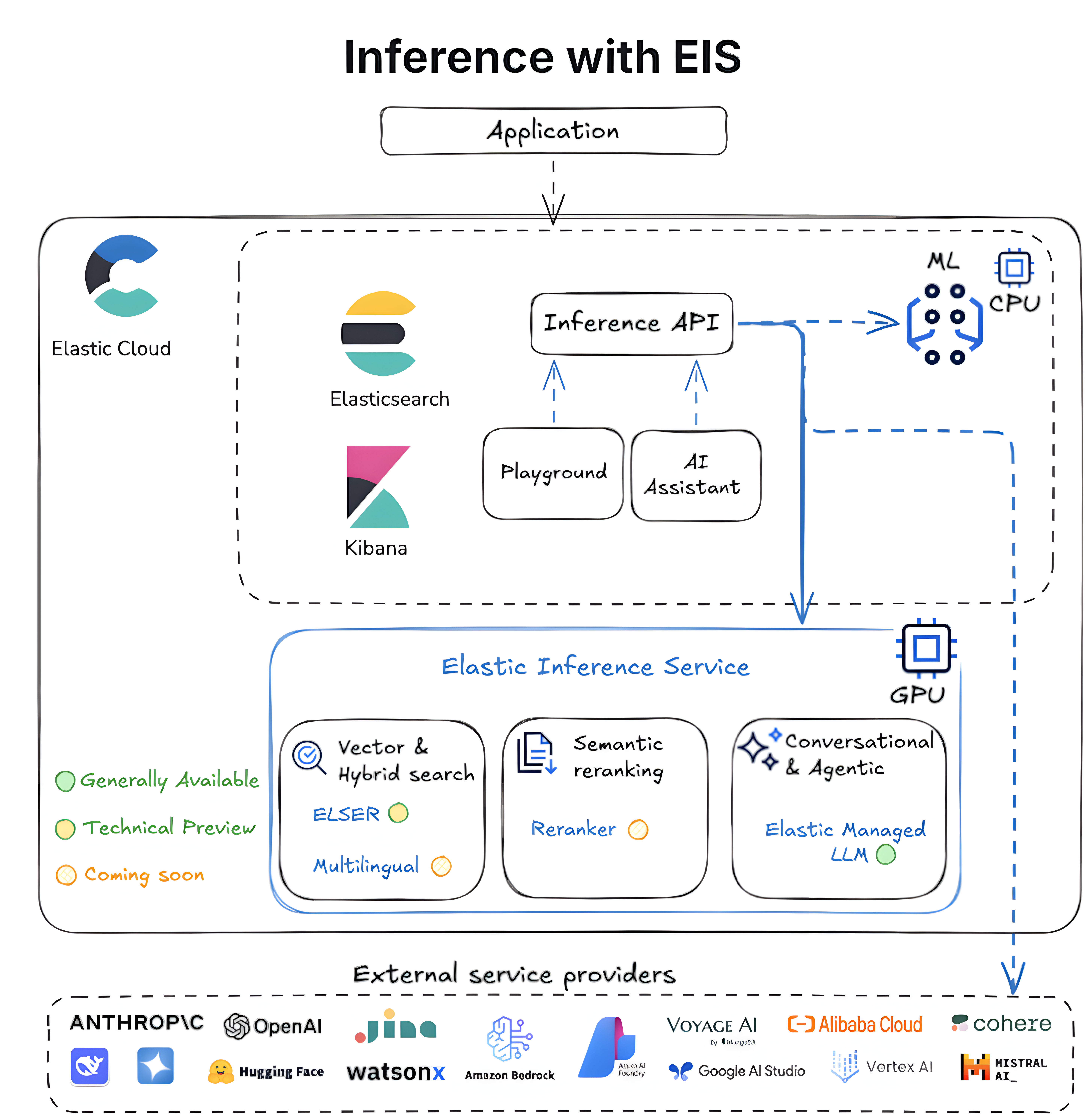

Los siguientes diagramas describen la evolución de la inferencia en Elasticsearch desde flujos de trabajo autogestionados basados en CPU hasta el servicio de inferencia Elastic totalmente integrado y optimizado para GPU.

¿Qué sigue?

Estamos trabajando en muchas mejoras emocionantes en el servicio Elastic Inference para impulsar una amplia variedad de casos de uso. Algunos de los principales son:

Más modelos: estamos ampliando nuestro catálogo de modelos para satisfacer las crecientes necesidades de inferencia de nuestros clientes. En los próximos meses, presentaremos nuevos modelos en EIS para satisfacer una variedad más amplia de necesidades de búsqueda e inferencia, como las siguientes:

Modelo de embeddings multilingües para búsqueda semántica

Modelo de reordenamiento semántico para una búsqueda semántica mejorada y una búsqueda mejorada basada en palabras clave

Modelos de incrustación y reordenamiento multimodales

Modelos de lenguaje pequeños (SLM)

Más modelos de lenguaje grandes (LLM)

Continuaremos agregando más tipos de modelos, así que si hay un modelo que te gustaría ver, contáctanos en support@elastic.co.

Más CSPs y regiones: estamos trabajando para ampliar la cobertura a más CSPs y regiones pronto. Para conocer la disponibilidad actual, consulta nuestros documentos.

- Búsqueda semántica simplificada: la búsqueda semántica con semantic_text, un tipo de campo en la consulta, simplifica el flujo de trabajo de inferencia al proporcionar inferencia en el momento de la ingesta y valores predeterminados razonables automáticamente. Muy pronto, semantic_text comenzará a usar por defecto el endpoint ELSER en el Elastic Inference Service.

- Más amor para los clientes autogestionados: nuestros usuarios autogestionados podrán unirse a la diversión pronto. En un futuro cercano, el Modo Conectado al cloud llevará EIS a entornos autogestionados, reduciendo la sobrecarga operativa y permitiendo arquitecturas híbridas y escalado donde prefieras.

Tenemos muchas más mejoras interesantes en las que estamos enfocados, así que ponte en contacto con nosotros si tienes alguna pregunta.

Prueba EIS en Elastic Cloud

Con flujos de trabajo fluidos, información en tiempo real y rendimiento acelerado, EIS empodera a los desarrolladores para construir aplicaciones GenAI más rápidas y eficientes dentro del ecosistema de Elastic.

Todas las pruebas de Elastic Cloud tienen acceso al Elastic Inference Service. Pruébalo ahora en Elastic Cloud Serverless y Elastic Cloud Hosted.

El lanzamiento y el momento de cualquier característica o funcionalidad descrita en esta publicación quedan a exclusivo criterio de Elastic. Es posible que cualquier característica o funcionalidad que no esté disponible en este momento no se lance a tiempo o no se lance en absoluto.

En esta publicación del blog, es posible que hayamos usado o nos hayamos referido a herramientas de AI generativa de terceros, que son propiedad de sus respectivos propietarios y están gestionadas por ellos. Elastic no tiene ningún control sobre las herramientas de terceros y no tenemos ninguna responsabilidad por su contenido, operación o uso, ni por ninguna pérdida o daño que pueda surgir de tu uso de dichas herramientas. Ten cuidado al usar herramientas de AI con información personal, sensible o confidencial. Cualquier dato que envíes puede usarse para el entrenamiento de AI u otros fines. No se garantiza que la información que proporciones se mantenga segura o confidencial. Debes familiarizarte con las prácticas de privacidad y los términos de uso de cualquier herramienta de AI generativa antes de usarla.

Elastic, Elasticsearch y las marcas asociadas son marcas comerciales, logotipos o marcas comerciales registradas de Elasticsearch B.V. en los Estados Unidos y otros países. Todos los demás nombres de empresas y productos son marcas comerciales, logotipos o marcas comerciales registradas de sus respectivos dueños.