GPU 狂飙!Elastic 推理服务 (EIS):适用于 Elasticsearch 的 GPU 加速推理

_(1).png)

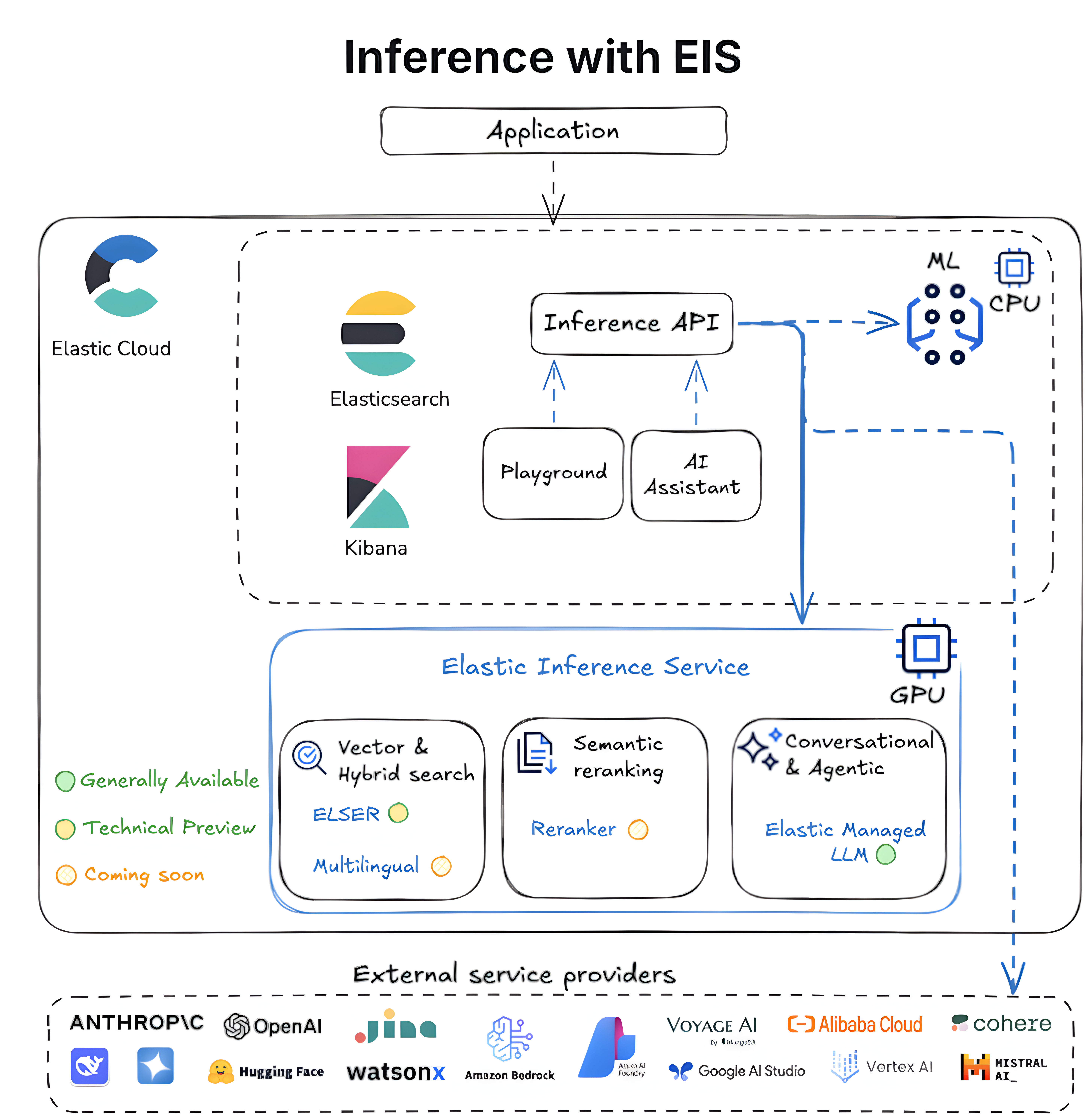

我们很高兴地宣布推出 Elastic Inference Service (EIS),它引入了原生集成于 Elastic Cloud 上的 Elasticsearch 的 GPU 加速推理功能。

Elasticsearch 是部署最广泛的向量和语义搜索数据库。现代搜索和 AI 工作负载依赖于对嵌入、重新排序和语言模型进行快速、可扩展的推理。随着数据量的增长,管理基础设施、测试模型、处理集成以及整合点解决方案都会增加繁重的运营负担。这就产生了客户对托管 GPU 加速 Fleet 的明确需求,这些 Fleet 可提供速度、可扩展性和成本效益,而无需基础架构或集成的运营开销。Elastic Inference Service 旨在提供推理即服务,并大规模提供嵌入、重新排序以及大型和小型语言模型即服务。我们还将 EIS 设计为多云服务提供商 (CSP)、多区域和多模式服务,以满足您的所有长期推理需求。

EIS 已经提供了对最先进的大型语言模型 (LLM) 的访问权限,该模型又为 Playground 和 AI 助手的自动摄取、威胁检测、问题调查、根本原因分析等开箱即用的 AI 功能提供了支持。现在,我们很高兴将 Elastic Learned Sparse EncodeR (ELSER)(Elastic 内置的用于实现最先进的搜索相关性的稀疏向量模型)作为 EIS 上的第一个文本嵌入模型进行技术预览。ELSER 为我们 Platform 上的大多数语义搜索用例提供支持,并提供行业领先的相关性和性能。这仅仅是个开始;更多用于多语言嵌入、重新排序的其他模型,以及最近通过收购加入 Elastic 的 Jina AI 的模型,都在进一步扩展可能性。

最先进的架构和性能

EIS 利用现代 NVIDIA GPU 提供可扩展的架构,以实现低延迟、高吞吐量的推理。GPU 允许机器学习 (ML) 模型并行处理大量计算,从而将整体效率提高一个数量级。

EIS 为 Elasticsearch 用户提供快速推理体验,同时简化了设置和工作流管理。该服务通过 API 提供易于使用的推理,确保端到端的 semantic_text 体验,生成向量嵌入,并使用 LLM 支持上下文工程和代理工作流,从而确保始终如一的卓越性能和开发者体验。

简化的开发者体验:无需下载模型、手动配置或资源配置。EIS 直接与 semantic_text 和推理 API 集成,为开发者带来愉悦的体验。部署模型时无需冷启动,也无需自行实现自动扩展。

- 改进的端到端语义搜索体验:稀疏向量、密集向量或语义重新排序——我们都能满足您的需求。更多模型即将推出!

- 增强的性能:GPU 加速推理可提供一致的延迟,并且与基于 CPU 的替代方案相比,在高负载情况下,数据摄取吞吐量最高可提升 10 倍。

- 简化的生成式 AI (GenAI) 工作流:省去外部服务、API 密钥和合同带来的麻烦。借助 Elastic Managed LLM,用于摄取、调查、检测和分析的 AI 功能从第一天起就能开箱即用。

- 向后兼容性:现有的 Elasticsearch ML 节点仍受支持,而推理 API 为您提供了连接任何第三方服务的完全灵活性。

- 易于理解的定价:EIS 提供与其他推理服务类似的基于使用量的定价,按每个模型每百万令牌收费。Elastic 还保护 EIS 上提供的所有模型,使用户可以轻松上手并获得支持。

- 访问权限:所有 CSP 和地区的 Elastic Cloud Serverless 和 Elastic Cloud Hosted 部署均可访问 EIS 上的推理终端。

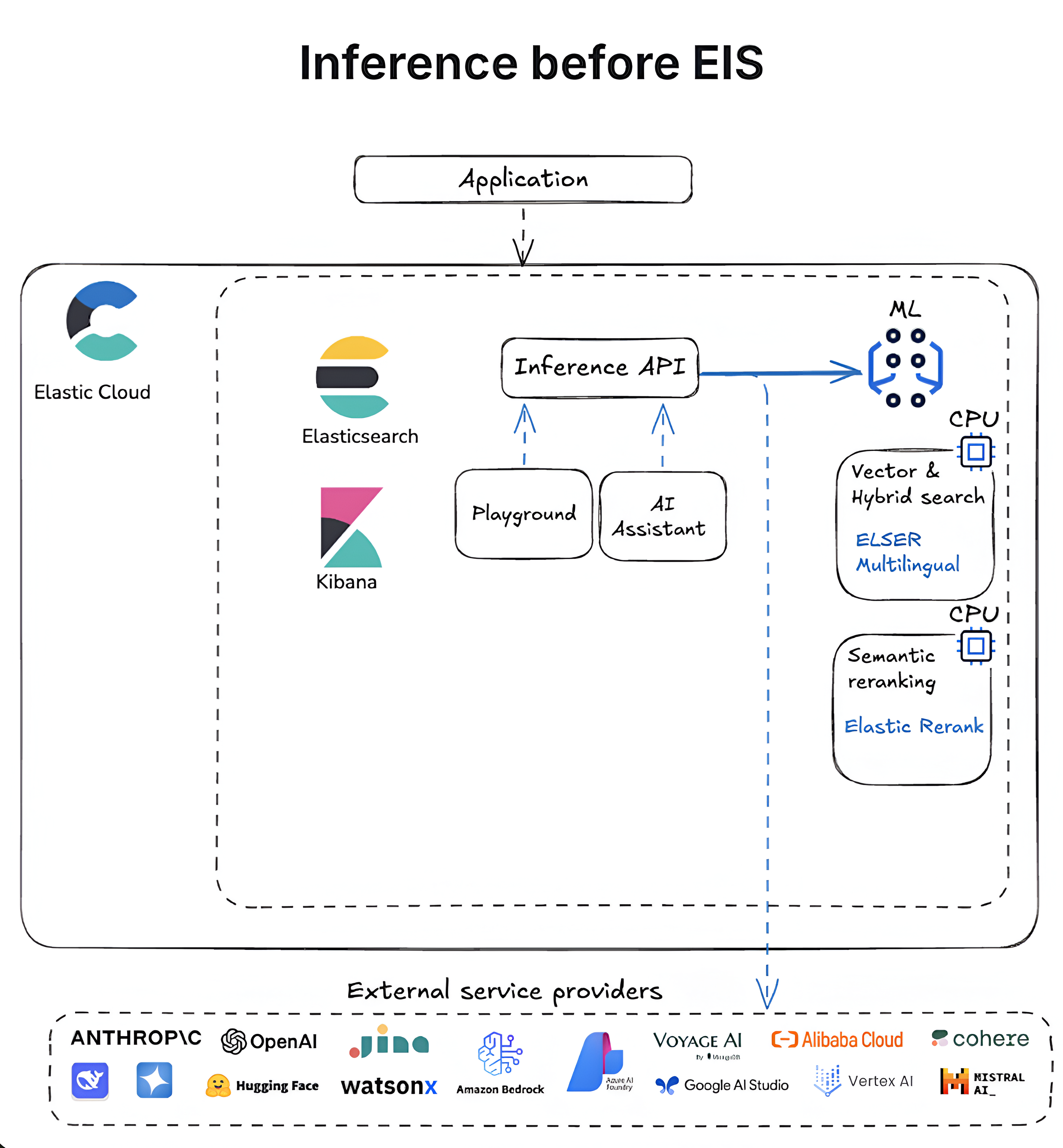

以下图表概述了 Elasticsearch 中推理功能的演变过程,从基于 CPU 的自管型工作流到 GPU 优化的、完全集成的 Elastic 推理服务。

下一步是什么?

我们正在对 Elastic Inference Service 进行许多令人兴奋的改进,以支持各种用例。一些主要内容包括:

更多模型:我们正在扩大模型目录,以满足客户日益增长的推理需求。在接下来的几个月中,我们将在 EIS 上推出新的模型,以支持更广泛的搜索和推理需求,包括:

适用于语义搜索的多语言嵌入模型

适用于增强的语义搜索和改进的基于关键词的搜索的语义重新排序模型

多模态嵌入和重新排序模型

小型语言模型 (SLM)

更多 LLM

我们将继续增加更多类型的模型,所以如果您希望看到某种模型,请通过 support@elastic.co 与我们联系。

更多 CSP 和地区:我们正在努力尽快将覆盖范围扩大到更多的 CSP 和地区。有关当前的可用性,请参阅我们的文档。

- 简化的语义搜索:使用 semantic_text(查询中的一种字段类型)进行语义搜索,可在摄取时自动提供推理和合理的默认值,从而简化推理工作流。很快,semantic_text 将开始默认使用 Elastic Inference Service 上的 ELSER 终端。

- 为自管型客户带来更多关爱:我们的自管型用户很快就能加入到这场乐趣中来。在不久的将来,云连接模式将把 EIS 引入自管型环境,降低运营开销,并支持混合架构和在最适合您的环境中进行扩展。

我们还有很多令人兴奋的改进正在进行中,如果您有任何问题,请随时联系我们。

在 Elastic Cloud 上试用 EIS

凭借无缝工作流、实时见解和加速的性能,EIS 使开发人员能够在 Elastic 生态系统内构建更快、更高效的 GenAI 应用程序。

所有 Elastic Cloud 试用版均可访问 Elastic 推理服务。立即试用 Elastic Cloud Serverless 和 Elastic Cloud Hosted。

本文中描述的任何功能或功能性的发布和时间均由 Elastic 自行决定。当前尚未发布的任何功能或功能性可能无法按时提供或根本无法提供。

在本博文中,我们可能使用或提到了第三方生成式 AI 工具,这些工具由其各自所有者拥有和运营。Elastic 对第三方工具没有任何控制权,对其内容、操作或使用不承担任何责任或义务,对您使用此类工具可能造成的任何损失或损害也不承担任何责任或义务。请谨慎使用 AI 工具处理个人、敏感或机密信息。您提交的任何数据都可能用于 AI 训练或其他目的。Elastic 不保证您所提供信息的安全性或保密性。在使用任何生成式 AI 工具之前,您都应自行熟悉其隐私惯例和使用条款。

Elastic、Elasticsearch 及相关标志是 Elasticsearch B.V. 在美国和其他国家/地区的商标、徽标或注册商标。所有其他公司和产品名称均为其相应所有者的商标、徽标或注册商标。