Monitore sua pilha de IA com observabilidade de LLM

Detecte riscos, resolva problemas e mantenha seus aplicativos de IA agentivos e generativos prontos para produção com os recursos de monitoramento de ponta a ponta do Elastic Observability.

De bibliotecas a modelos, temos tudo o que você precisa

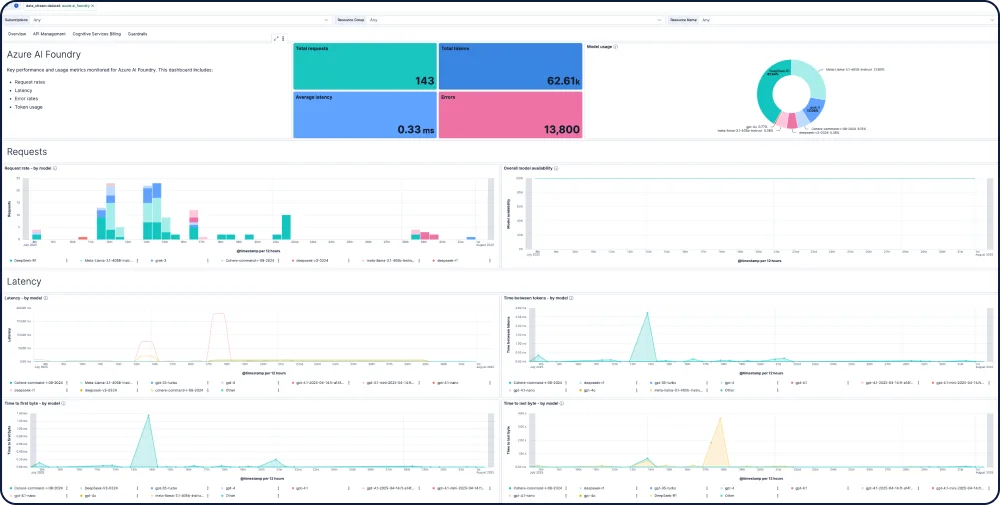

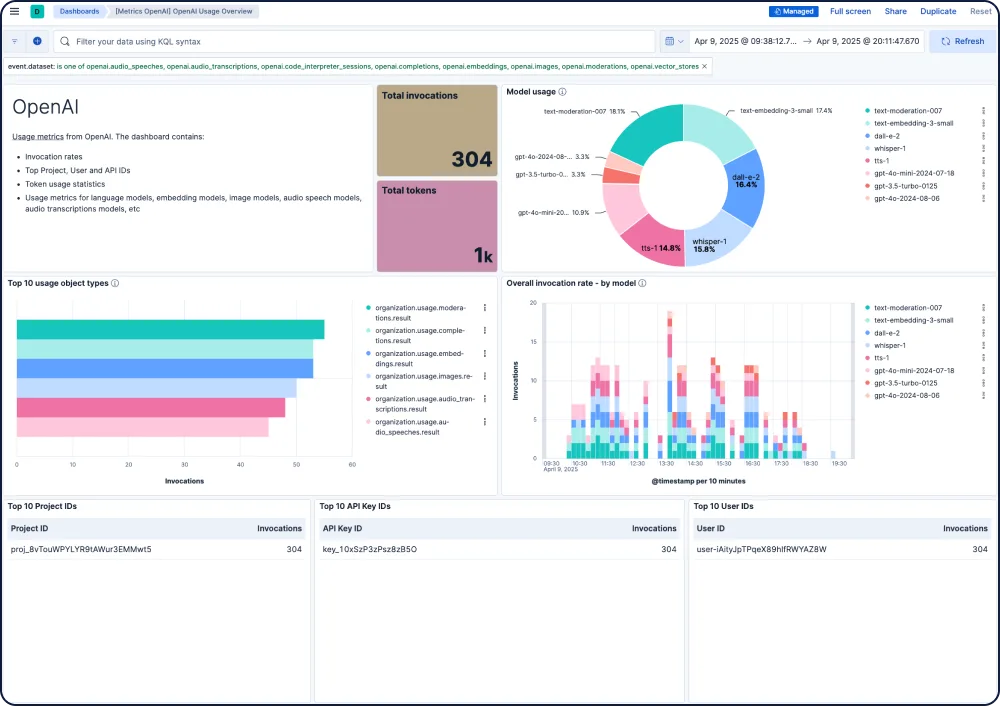

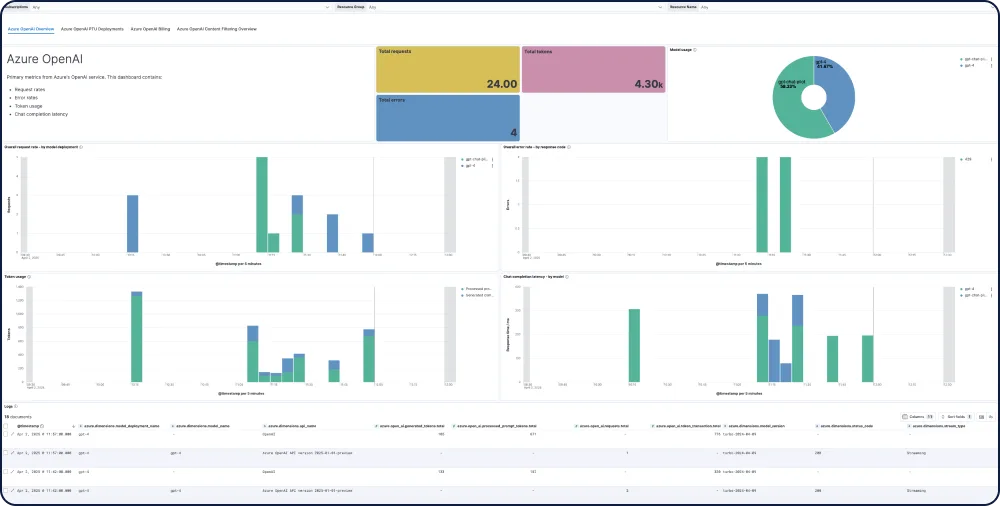

A Elastic oferece visibilidade de ponta a ponta para aplicativos de IA, integrando-se a bibliotecas populares de rastreamento e fornecendo insights prontos para uso sobre modelos de todos os principais provedores de LLM, incluindo GPT-4o, Mistral, LLaMA, Anthropic, Cohere e DALL·E.

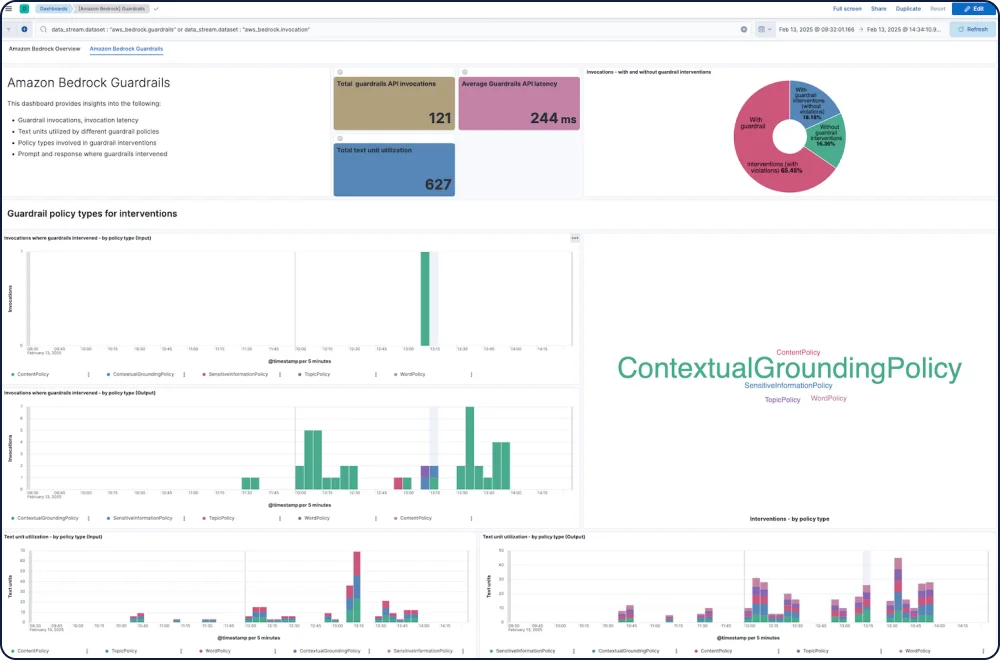

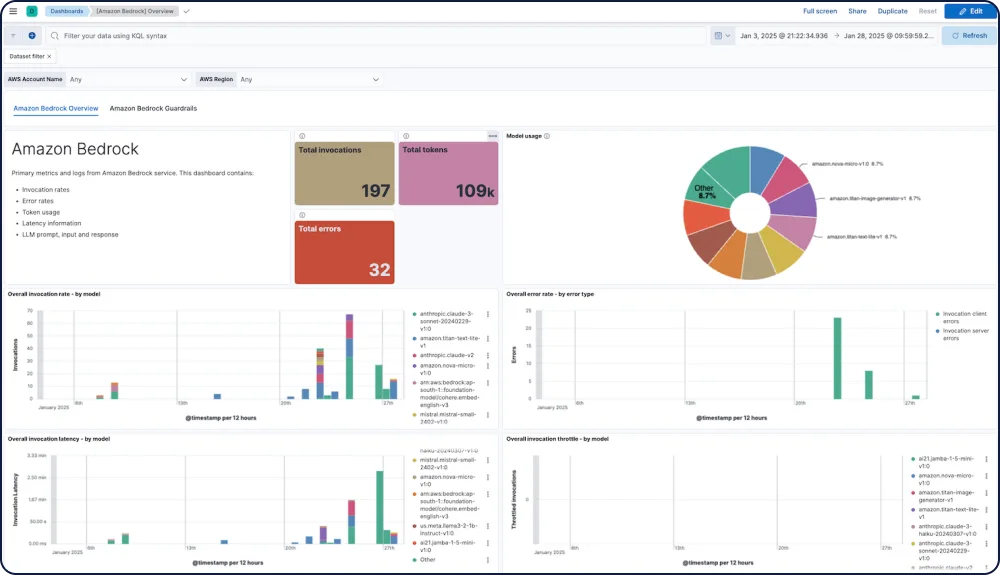

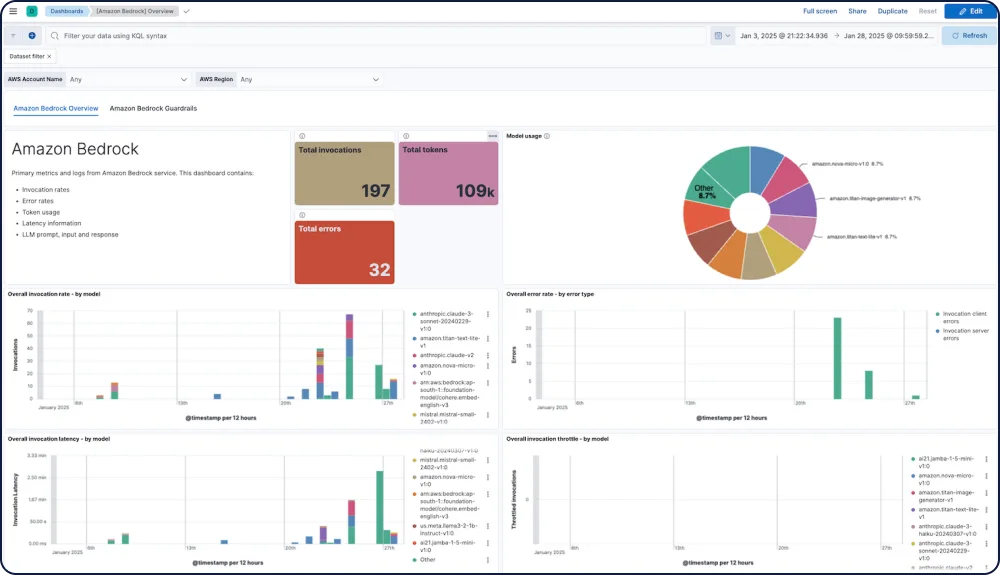

GALERIA DE DASHBOARDS

Integrações e capacidades para seus apps de IA

Acompanhe desempenho, segurança e custos em todos os modelos.

A integração do Amazon Bedrock com o Elastic Observability oferece visibilidade abrangente sobre o uso, a segurança e o desempenho dos LLMs do Amazon Bedrock, incluindo modelos da Anthropic, Mistral e Cohere.

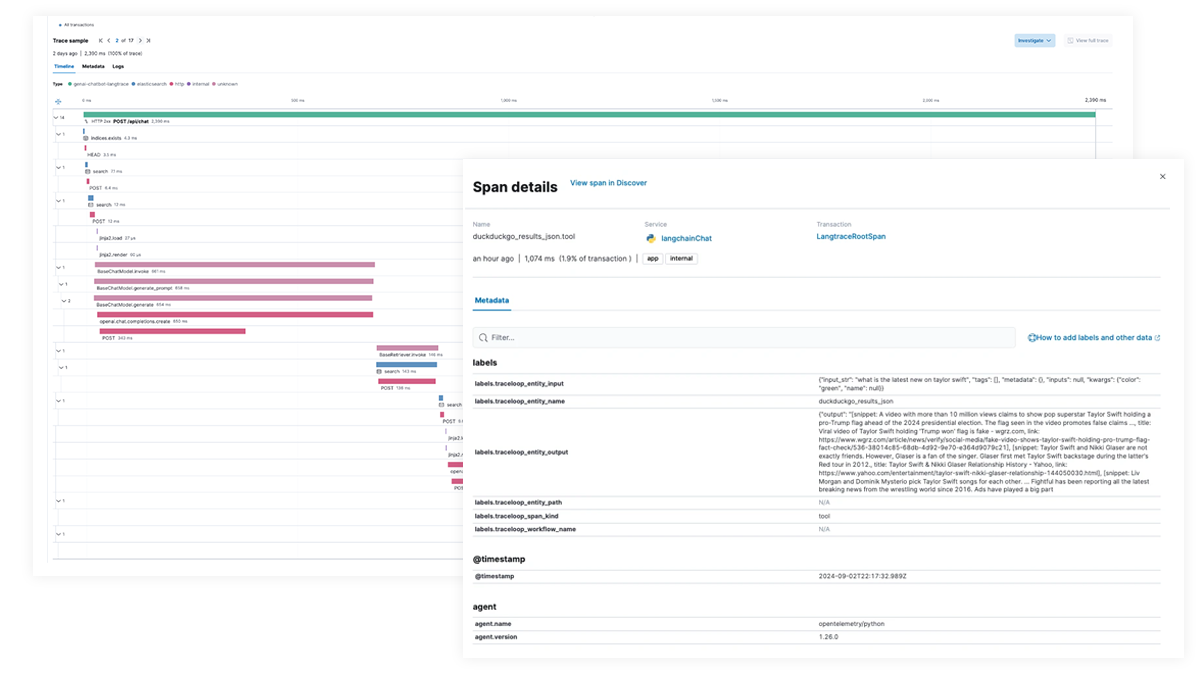

Rastreamento e depuração de ponta a ponta para aplicativos de IA e fluxos de trabalho agênticos

Use o Elastic APM para analisar e fazer debug de apps de IA com OpenTelemetry, suportado pelas Distribuições Elastic do OpenTelemetry (EDOT) para Python, Java e Node.js, bem como bibliotecas de rastreamento de terceiros como LangTrace, OpenLIT e OpenLLMetry.

Experimente você mesmo o aplicativo Elastic chatbot RAG!

Este aplicativo de exemplo combina Elasticsearch, LangChain e vários LLMs para alimentar um chatbot com ELSER e seus dados privados.