KI-gestützte Suche für Ihre Anwendungen

Die Elasticsearch Relevance Engine™ (ESRE) wurde speziell für KI-gestützte Suchanwendungen entwickelt. Mit ESRE können Sie semantische Suchfunktionen mit überragender Relevanz sofort (ohne fachspezifische Anpassung) einsetzen, eigene LLMs (Large Language Models) integrieren, hybride Sucherlebnisse implementieren und externe oder eigene Transformationsmodelle nutzen.

Sehen Sie sich an, wie einfach sich die Elasticsearch Relevance Engine einrichten lässt.

„Quick Start“-Video ansehenNutzen Sie ESRE, um komplexe RAG-basierte Anwendungen zu erstellen.

Für Schulung registrierenNutzen Sie beim Einsatz von GKI-Modellen private, interne Daten als Kontext, um Nutzer:innen aktuelle und zuverlässige Antworten auf ihre Fragen zu geben.

Video ansehen

„Ich bin begeistert von den Vorteilen, die wir unseren Kunden dank unseren Investitionen in die Nutzung von Elasticsearch in RelativityOne bieten können. Wir sind gerade dabei, mit der ESRE zu experimentieren, und sehen ein großes Potenzial für die Bereitstellung nützlicher, KI-augmentierter Suchergebnisse für unsere Kunden.“

Chris Brown, Chief Product Officer, Relativity

Codebeispiele

Vektorsuche erstellen

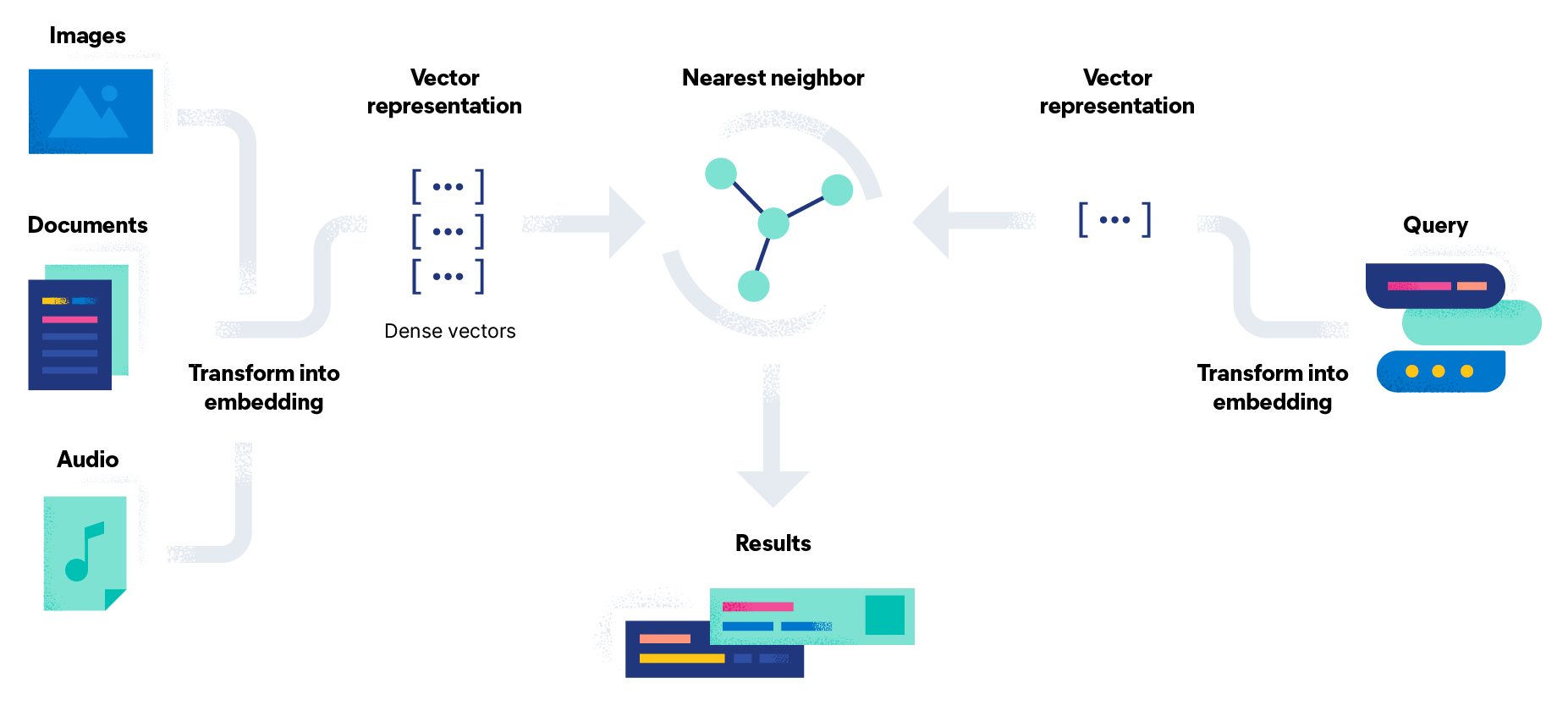

Mit nur einer einzigen API können Sie ein Einbettungsmodell importieren, Einbettungen generieren und umfangreiche Suchabfragen mit der Suche nach dem geschätzten nächsten Nachbarn schreiben.

docker run -it --rm elastic/eland \

eland_import_hub_model \

--cloud-id $CLOUD_ID \

-u <username> -p <password> \

--hub-model-id sentence-transformers/msmarco-MiniLM-L-12-v3 \

--task-type text_embedding \

--startHäufig gestellte Fragen

Was ist die Elasticsearch Relevance Engine?

Die Elasticsearch Relevance Engine enthält verschiedene Funktionen, mit denen Entwickler:innen KI-Suchanwendungen erstellen können, wie etwa:

- Branchenführende erweiterte Relevanz-Ranking-Funktionen, inklusive herkömmliche Schlüsselwortsuche mit BM25 als Basis für eine relevante Hybridsuche in allen Fachgebieten

- Umfassende Vektordatenbankfunktionen mit Speicherung und Abruf von Vektoren sowie der Fähigkeit, Einbettungen zu erstellen

- Elastic Learned Sparse Encoder, unser neues Machine-Learning-Modell für semantische Suchanwendungen für eine Reihe von Fachgebieten Hybrides Ranking (RRF) zur Kombination von vektor- und textgebundenen Suchfunktionen für optimale Suchrelevanz in einer Vielzahl von Fachgebieten

- Unterstützung für die Integration externer Transformationsmodelle wie etwa OpenAI GPT‑3 und OpenAI GPT‑4 über deren APIs

- Eine komplette Suite aus Dateningestions-Tools wie etwa Datenbank-Connectoren, Datenintegrationen von Drittanbietern, Web-Crawler und APIs zur Erstellung benutzerdefinierter Connectoren

- Entwicklungstools zur Erstellung von Suchanwendungen für alle Arten von Daten: Text, Bilder, Zeitreihen, Geodaten, Multimedia und vieles mehr

Was kann ich mit der Elasticsearch Relevance Engine erstellen?

Elasticsearch ist eine führende Suchtechnologie für Websites (z. B. Produktsuche und Discovery im E‑Commerce-Bereich) und interne Daten (z. B. Wissensdatenbanken für Kundenerfolge oder Enterprise Search). Mit ESRE bieten wir ein Toolkit zur Erstellung KI-gestützter Sucherlebnisse an. Ihre Nutzer:innen können Anfragen in natürlicher Sprache als Frage oder als Beschreibung der gesuchten Informationen eingeben. Kombinieren Sie diese auf natürlicher Sprache basierenden Funktionen mit Generative AI, um die Fähigkeiten dieses Modells mit Kontext aus Ihren eigenen privaten oder proprietären Daten zu erweitern.

Sind Elasticsearch und Elasticsearch Relevance Engine dasselbe?

Ja, die in der Elasticsearch Relevance Engine verfügbaren Funktionen werden über die _search-API in Elasticsearch entwickelt und integriert. Für ein reibungsloses Nutzungserlebnis können Entwickler:innen die Elastic-API oder andere vertraute Tools wie etwa Kibana nutzen, um mit den Funktionen der Elasticsearch Relevance Engine zusammen mit Elasticsearch zu interagieren.

Was ist der Elastic Learned Sparse Encoder?

Der Elastic Learned Sparse Encoder ist ein von Elastic entwickeltes Modell für extrem relevante semantische Suchfunktionen für eine Vielzahl von Fachgebieten. Dieses momentan nur auf Englisch verfügbare Machine-Learning-Modell erfasst die Beziehungen zwischen Bedeutungen und Wörtern für den Informationsabruf. Interessieren Sie sich für Benchmark-Tests mit unserem neuen Abrufmodell? Mehr erfahren Sie in diesem Blogpost.

Was ist eine Transformation, und ist der Elastic Learned Sparse Encoder ein Transformationsmodell?

Eine Transformation ist eine Deep-Neural-Network-Architektur und dient als Basis für LLMs (Large Language Models). Transformationen bestehen aus verschiedenen Komponenten und können Encoder, Decoder sowie zahlreiche „Deep“-Neural-Netzwerkebenen mit vielen Millionen (oder sogar Milliarden) an Parametern enthalten. Sie werden normalerweise mit sehr großen Textkorpora wie Daten im Internet trainiert und können für eine Vielzahl von NLP-Aufgaben (Natural Language Processing) justiert werden. Unser neues Abrufmodell verwendet zwar eine Transformationsarchitektur, besteht jedoch nur aus einem Encoder, der speziell für die semantische Suche in einer Vielzahl von Fachgebieten entwickelt wurde.

Wie kann ich die Elasticsearch Relevance Engine ausprobieren? Muss ich die Elasticsearch Relevance Engine separat kaufen?

Der komplette Funktionsumfang der Elasticsearch Relevance Engine ist ab Version 8.8 in den Platinum- und Enterprise-Tarifen von Elastic Enterprise Search enthalten. Sie können mit Einbettungen und der Vektorsuche experimentieren und das Abrufmodell ausprobieren. Sehen Sie sich eine Demo des Elastic Learned Sparse Encoders an. Falls Sie eine Elasticsearch-Lizenz haben, ist die Elasticsearch Relevance Engine bereits in Ihrem Kauf enthalten.