Kontextbezogene Erkenntnisse dank Elastic AI Assistant für Observability

Elastic® erweitert seinen Elastic AI Assistant, den offenen, generativen KI-Assistenten, der die Elasticsearch Relevance Engine™ (ESRE) nutzt, um die Observability-Analyse aufzuwerten und Nutzer:innen aller Kompetenzniveaus wichtige Funktionen an die Hand zu geben. Der interaktive Elastic AI Assistant (für Observability in der Phase „Technische Vorschau“) liefert SREs kontextbezogene Informationen und transformiert so die Erkennung und Behebung von Problemen und macht Schluss mit dem manuellen Suchen in Silos, um dort verstreute Daten aufzuspüren.

Der Elastic AI Assistant verbessert das Verständnis von Anwendungsfehlermeldungen, Log-Nachrichten und Alert-Analysen und liefert Vorschläge für optimale Code-Effizienz. Außerdem können SREs über die interaktive Chat-Benutzeroberfläche des Elastic AI Assistant chatten, alle relevanten Telemetriedaten an einem Ort visualisieren und gleichzeitig proprietäre Daten und Runbooks nutzen, um zusätzliche Kontextinformationen zu erhalten.

Der AI Assistant ist zwar für die Nutzung des LLM Ihrer Wahl – wie OpenAI oder Azure OpenAI – konfiguriert, bietet den Nutzer:innen aber auch die Möglichkeit, eigene Informationen, wie Runbooks, eine Liste früherer Sicherheitsvorfälle, Fallhistorien und mehr, bereitzustellen. Mit einem Inferenz-Prozessor auf Basis des Elastic Learned Sparse EncodeR (ELSER) erhält der Assistant Zugriff auf die wichtigsten Daten, um Fragen beantworten oder Aufgaben erledigen zu können.

Der AI Assistant lernt ständig dazu und je mehr er genutzt wird, desto umfassender wird seine Wissensdatenbank. SREs können dem Assistant den Umgang mit bestimmten Problemen beibringen, damit er die entsprechenden Szenarien in Zukunft unterstützen kann, etwa indem er Ausfallberichte erstellt, Runbooks aktualisiert und automatisierte Ursachenanalysen um zusätzliche Informationen erweitert. Mit der Kombination aus Elastic AI Assistant und Machine Learning können SREs Probleme schnell und proaktiv ermitteln und beheben, indem sie manuelle Datenabrufe aus den verschiedensten Silos eliminieren – so wird die AIOps-Arbeit enorm beschleunigt.

In diesem Blogpost beschäftigen wir uns mit einigen der ersten Features, die in der technischen Vorschau in 8.10 bereitstehen:

- Zugriff auf Chat-Funktionalität von jedem Elastic-Bildschirm aus

- Konkrete vordefinierte LLM-Abfragen zum Abruf zusätzlicher Kontextinformationen für die folgenden Zwecke:

- Analyse der Bedeutung einer Meldung in einem Log

- Ermittlung besserer Optionen für den Umgang mit Fehlermeldungen aus Diensten, die von Elastic APM verwaltet werden

- Identifizierung von zusätzlichem Kontext und des potenziellen Umgangs mit ihm bei Log-Alerts

- Gewinnung von Erkenntnissen darüber, wie sich Code mit Universal Profiling optimieren lässt

- Analyse der konkreten Prozesse, die in den in Elastic überwachten Hosts ablaufen

Zusätzlich können Sie sich das folgende Video ansehen, in dem unsere Features in diesem speziellen Szenario besprochen werden.

Elastic AI Assistant für Observability

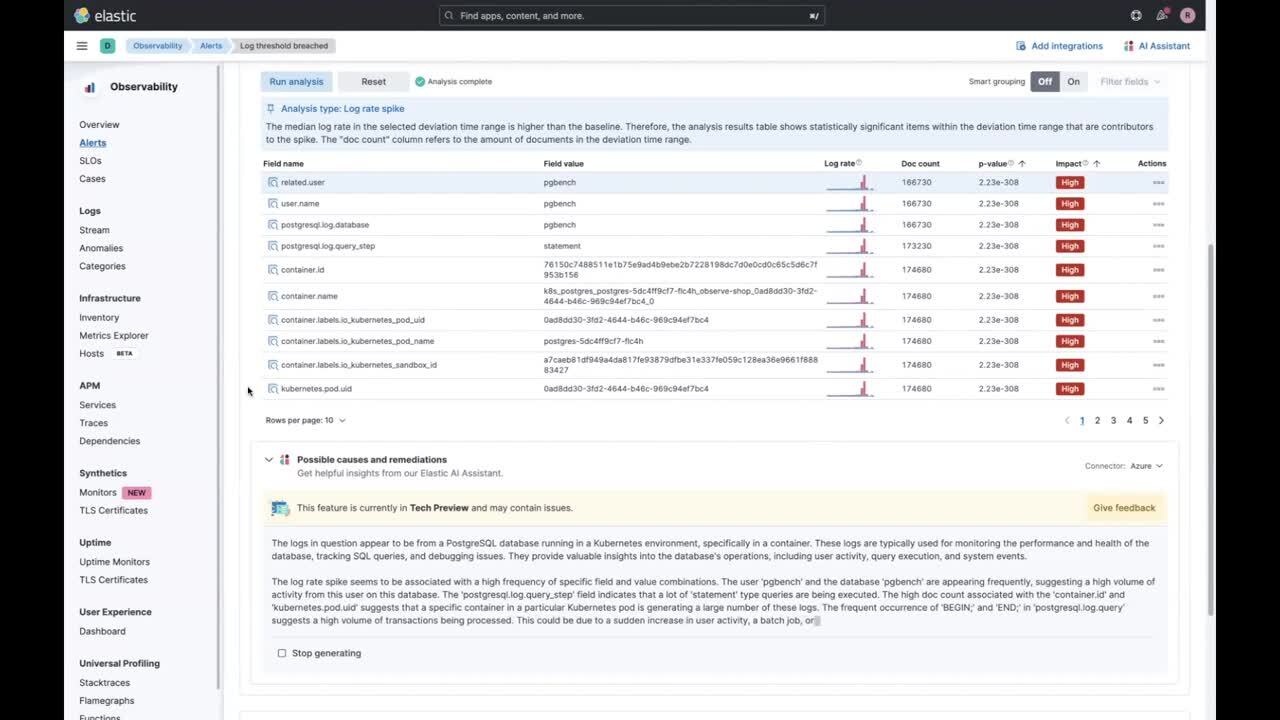

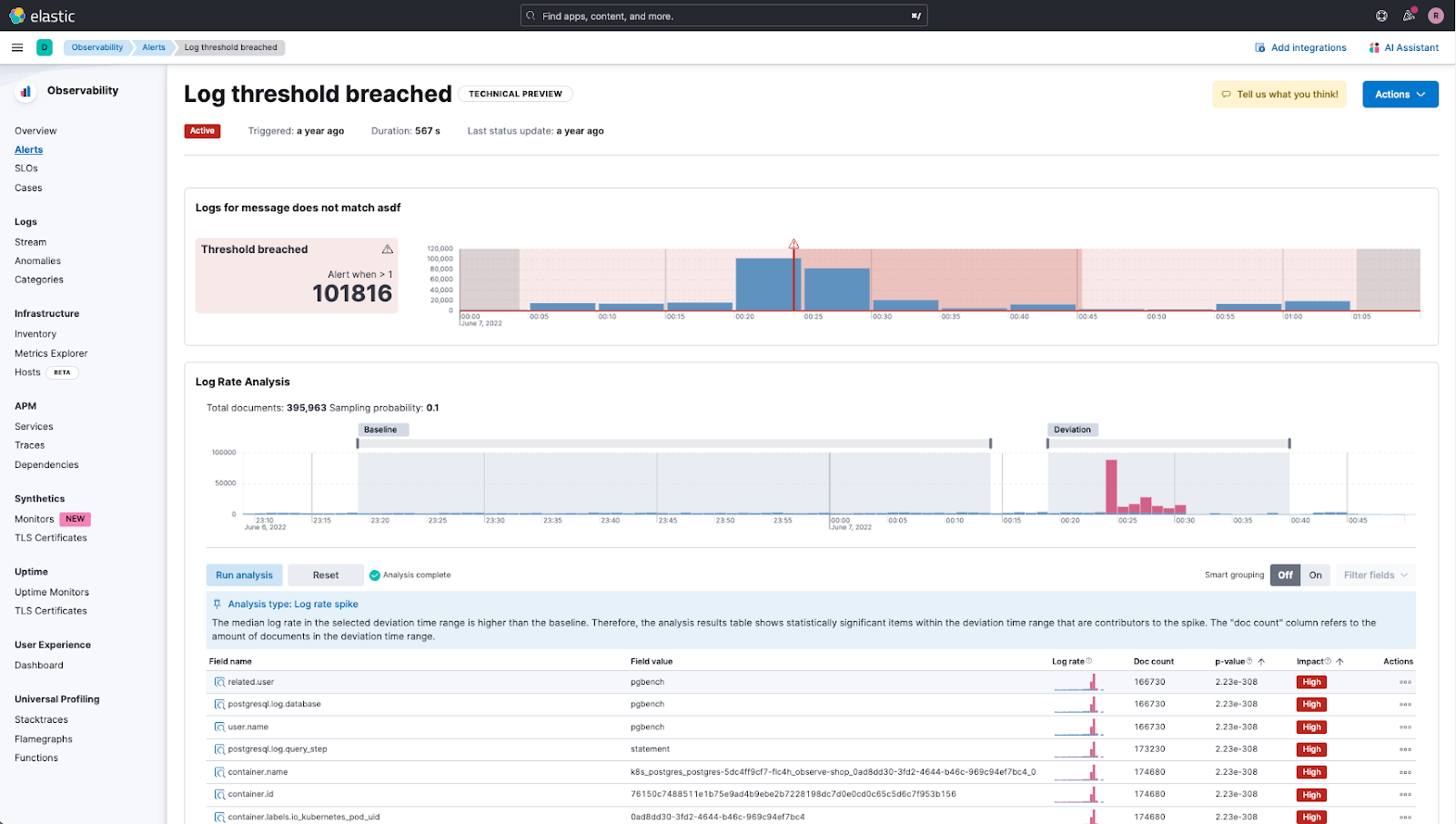

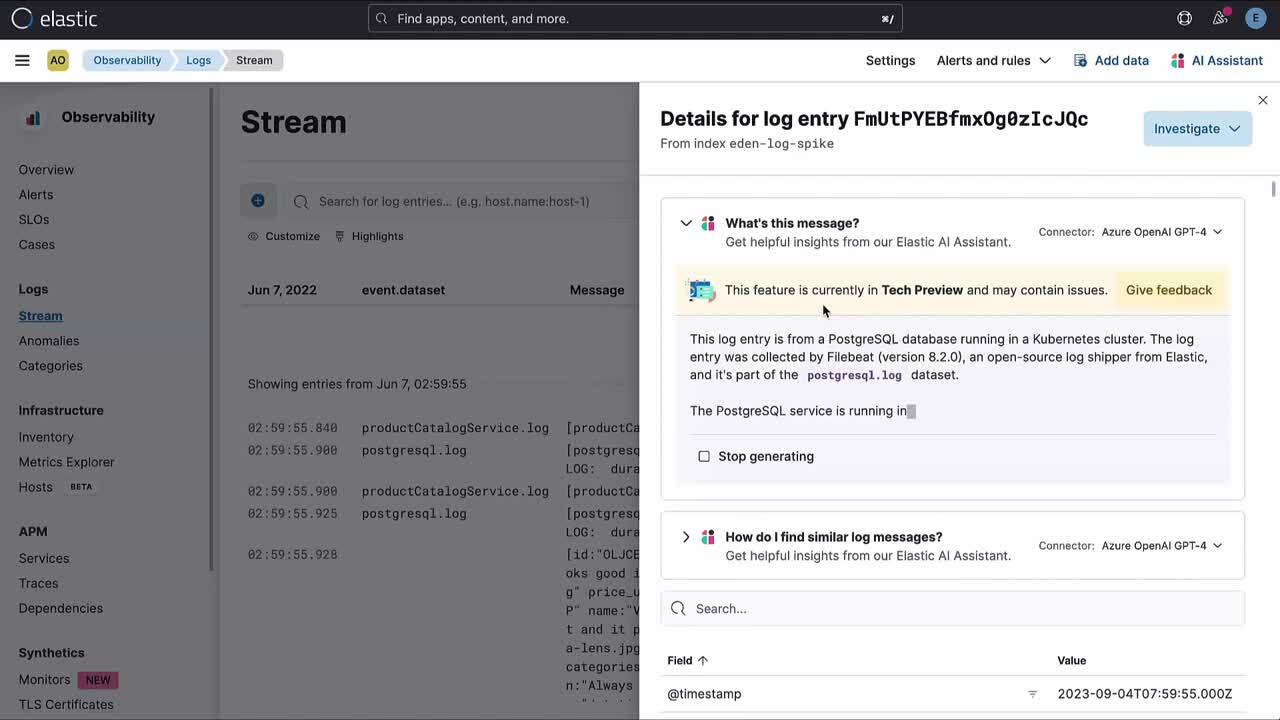

Als SRE kommt es vor, dass Sie einen Alert erhalten, der Sie darauf hinweist, dass bei einer Reihe von Logeinträgen ein Grenzwert überschritten wurde. In Elastic Observability erhalten Sie nicht nur diesen Alert, sondern zusätzlich auch Informationen über relevante Logspitzen in Echtzeit, damit Sie das Problem besser analysieren können.

Nutzung von AI Assistant für die Problemanalyse

Allerdings können Sie als SRE nicht immer jedes einzelne System unter Ihrer Aufsicht in- und auswendig kennen, sodass Sie unter Umständen bei der Logspitzenanalyse Hilfe benötigen. Hier kommt der AI Assistant ins Spiel.

Elastic erstellt einen Prompt, der an das LLM Ihrer Wahl gesendet wird, und Sie erhalten nicht nur die Beschreibung und den Kontext des Problems, sondern auch Empfehlungen für die weitere Vorgehensweise.

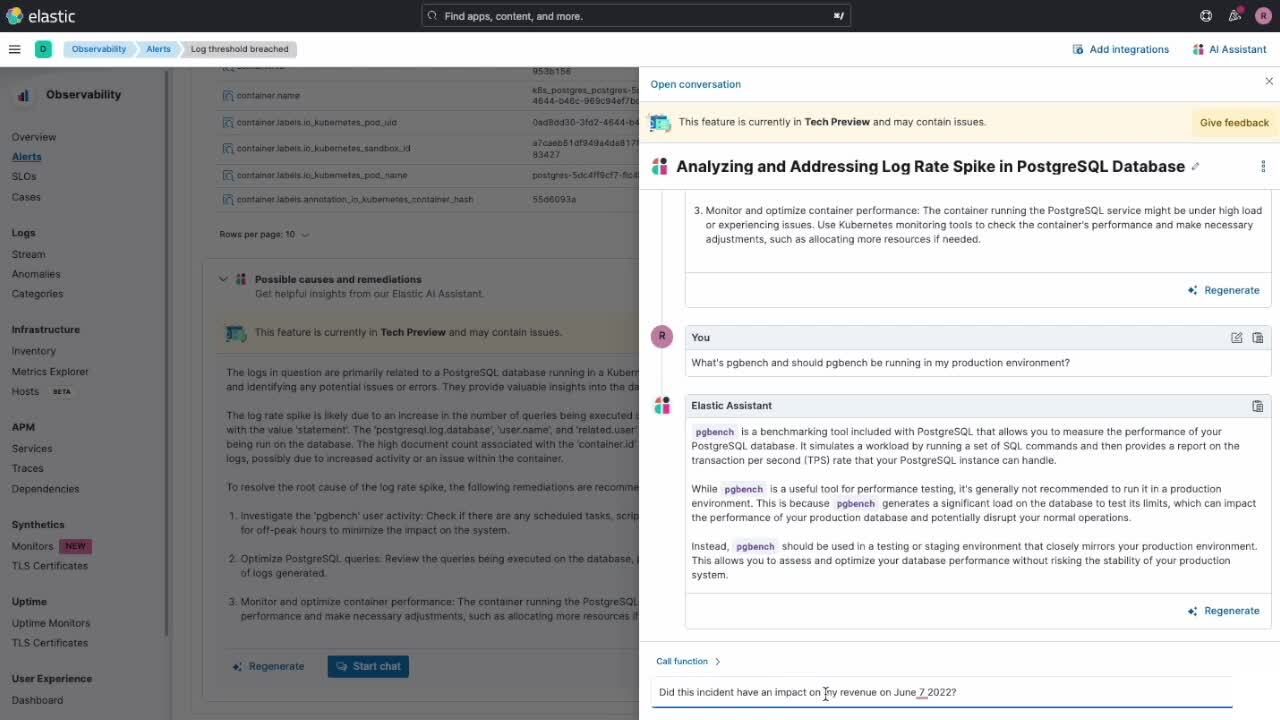

Zusätzlich können Sie einen Chat mit dem AI Assistant starten, um noch tiefer in die Materie einzudringen.

Wie im Clip oben zu sehen war, erhalten Sie nicht nur weitere Informationen über das Problem „pgbench“, sondern Sie können sich so auch interne Unternehmensinformationen besorgen und mit ihrer Hilfe untersuchen, wie sich das Problem auf Ihr Geschäft auswirkt. In diesem Fall haben wir Folgendes erfahren:

- wie sich die deutliche Veränderung beim Transaktionsdurchsatz auf unseren Umsatz auswirken könnte

- wie die Umsätze eingebrochen sind, als diese Logspitze aufgetreten ist

Beide Informationen verdanken wir der Nutzung von ELSER. Der Encoder hilft, zur Beantwortung konkreter Fragen unternehmensspezifische (private) Daten abzurufen, die für LLMs nicht zugänglich wären.

Chat-Benutzeroberfläche von AI Assistant

Was können Sie nun mit der neuen AI Assistant-Chat-Benutzeroberfläche anfangen? Mit der Chat-Funktionalität können Sie eine Unterhaltung mit dem Elastic AI Assistant beginnen. Dies kann für verschiedene Zwecke nützlich sein:

- Sie können so im Rahmen der Problemermittlung und Ursachenanalyse Anfragen in natürlicher Sprache stellen, wie „Gibt es heute irgendwelche Alerts, die mit diesem Dienst in Verbindung stehen?“ oder „Was sind das für Alerts?“.

- Der AI Assistant kann Schlussfolgerungen und Kontext bereitstellen und, dank ELSER, auf der Basis Ihrer eigenen privaten Daten sowie der Informationen im verwendeten LLM Empfehlungen geben.

- Sie können Antworten aus Abfragen und die Ergebnisse von Analysen analysieren, die vom Elastic AI Assistant durchgeführt wurden.

- Sie können sich während der gesamten Unterhaltung Informationen zusammenfassen bzw. bereits Erwähntes noch einmal präsentieren lassen.

- Sie können im Rahmen der Unterhaltung Lens-Visualisierungen generieren.

- Sie können über die Chat-Schnittstelle im Namen der Nutzerin oder des Nutzers Kibana®- und Elasticsearch®-APIs ausführen.

- Sie können mit spezifischen APM-Funktionen Ursachenanalysen betreiben, z. B. mit get_apm_timeseries, get_apm_service_summary, get_apm_error_docuements, get_apm_correlations, get_apm_downstream_dependencies usw.

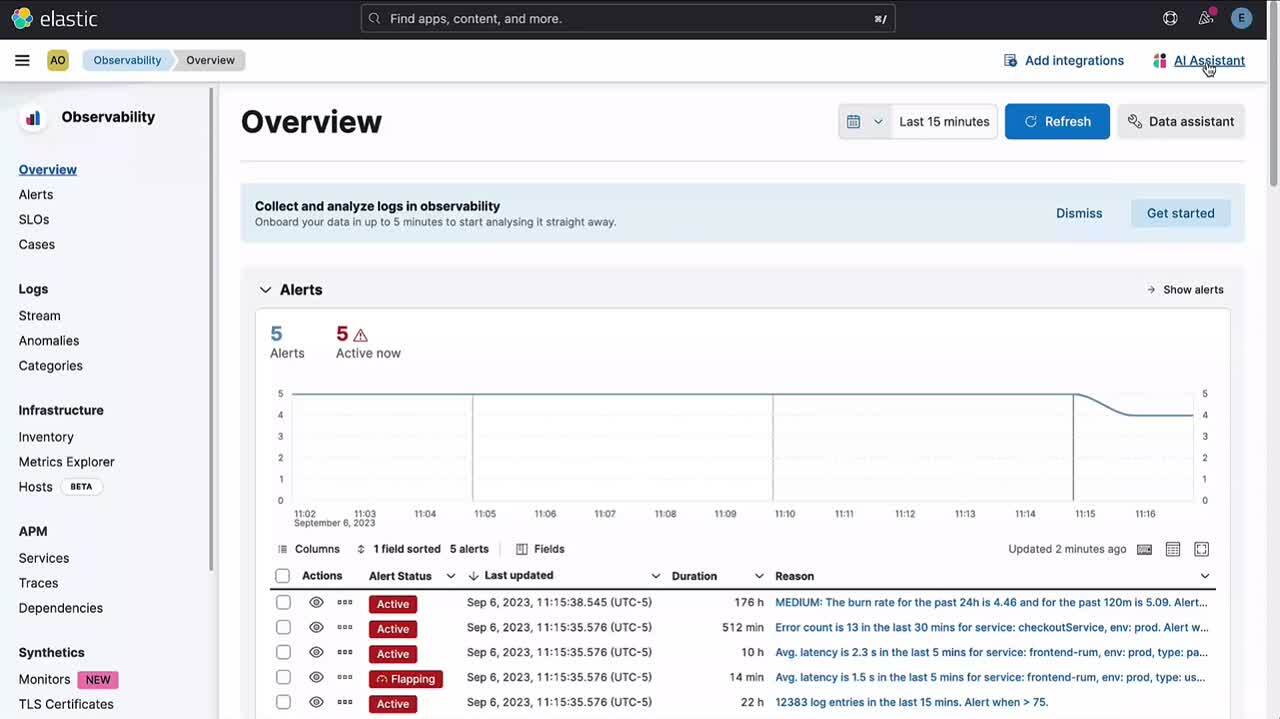

Andere Orte, die Zugriff auf den AI Assistant bieten

Auf die Chat-Funktionalität in Elastic AI Assistant für Observability kann zunächst an verschiedenen Orten in Elastic Observability 8.10 zugegriffen werden. In späteren Versionen werden weitere Orte hinzukommen.

- Alle Observability-Anwendungen verfügen im Aktionen-Menü am oberen Rand über eine Schaltfläche, über die der AI Assistant geöffnet und eine Unterhaltung gestartet werden kann:

- Nutzer:innen können auf bestehende Unterhaltungen zugreifen und neue erstellen, indem sie im AI Assistant auf Go to conversations klicken.

Die neue Chat-Funktionalität im Elastic AI Assistant für Observability erweitert den in Elastic Observability 8.9 eingeführten Funktionsumfang, weil sie es den Nutzer:innen erlaubt, eine Unterhaltung zu starten, die auf den bereits vom Elastic AI Assistant in APM, in Logs, von Hosts, in Alerts und in Profilen bereitgestellten Informationen beruht.

Dazu die folgenden Beispiele:

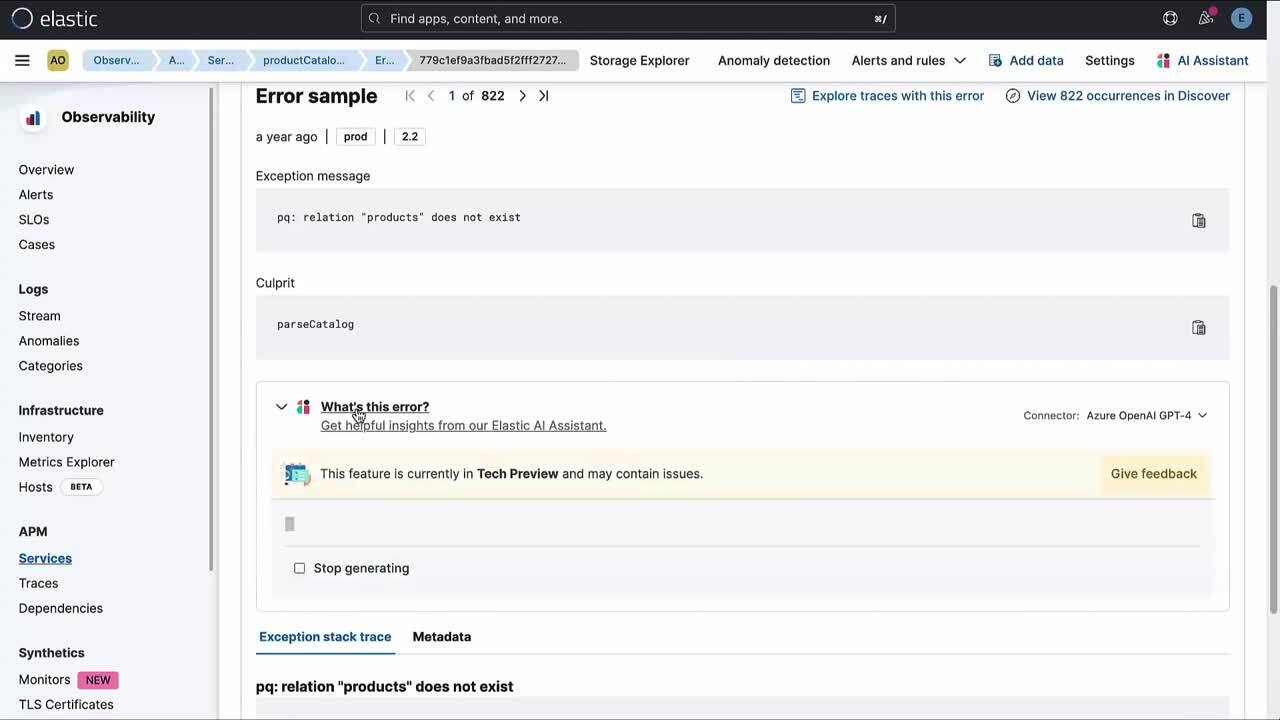

- In APM erklärt sie die Bedeutung einer konkreten Fehlermeldung oder Ausnahme und bietet Informationen zu häufigen Ursachen und möglichen Folgen. Außerdem können Sie sich mit einer Unterhaltung zusätzliche Erkenntnisse beschaffen.

- Beim Logging sieht sich der AI Assistant die Logdaten an und hilft Ihnen, mit Kontextinformationen die Meldungen besser zu verstehen. Zudem können Sie eine Unterhaltung starten, um den Sachverhalt eingehender zu untersuchen.

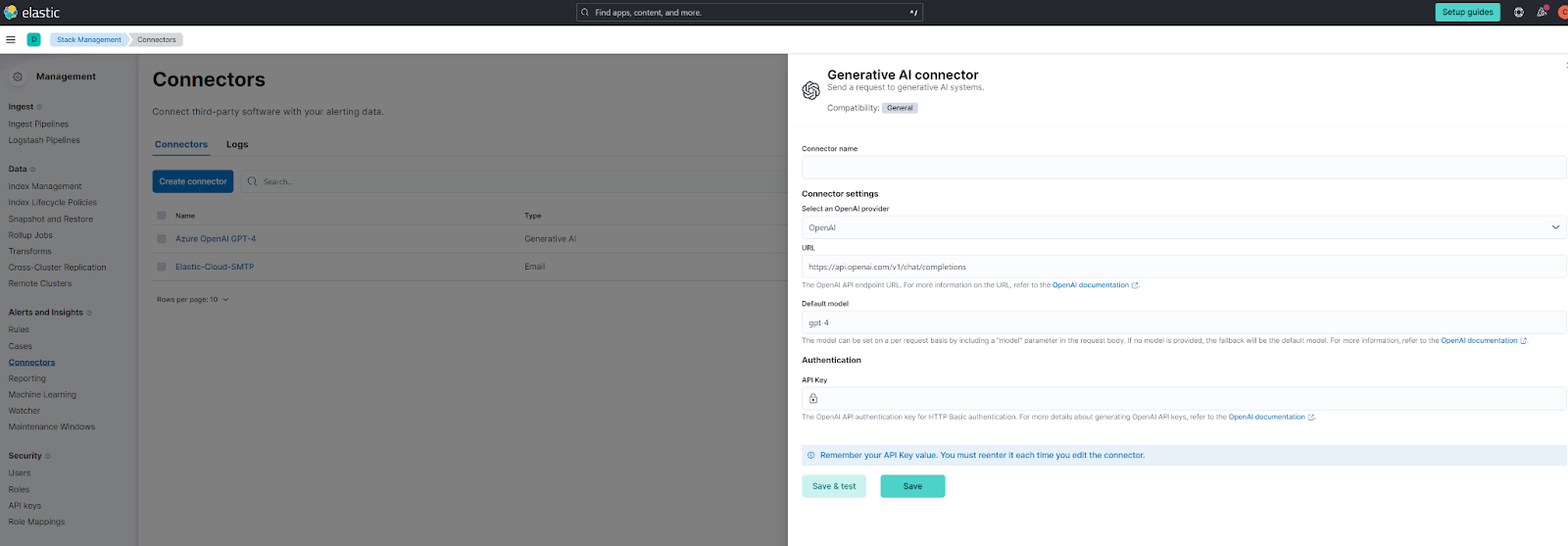

Konfigurieren des AI Assistant

Details dazu, wie Sie den Elastic AI Assistant konfigurieren können, finden Sie in der Elastic-Dokumentation.

Der AI Assistant ist Connector-basiert und unterstützt zunächst die Konfiguration für OpenAI und Azure OpenAI. Zu beachten ist, dass empfohlen wird, GPT‑4 zu verwenden, und dass Funktionsaufrufe unterstützt werden müssen. Wenn Sie OpenAI direkt nutzen, stehen diese Funktionen automatisch zur Verfügung. Bei Nutzung der Azure-Version sollten Sie eines der aktuelleren Modelle bereitstellen. Näheres entnehmen Sie bitte der Azure-Dokumentation.

Der AI Assistant kann zusätzlich mit yaml als vorkonfiguriertem Connector konfiguriert werden:

xpack.actions.preconfigured:

open-ai:

actionTypeId: .gen-ai

name: OpenAI

config:

apiUrl: https://api.openai.com/v1/chat/completions

apiProvider: OpenAI

secrets:

apiKey: <myApiKey>

azure-open-ai:

actionTypeId: .gen-ai

name: Azure OpenAI

config:

apiUrl: https://<resourceName>.openai.azure.com/openai/deployments/<deploymentName>/chat/completions?api-version=<apiVersion>

apiProvider: Azure OpenAI

secrets:

apiKey: <myApiKey>Das Feature kann nur mit einer Enterprise-Lizenz genutzt werden. Der Elastic AI Assistant für Observability befindet sich in der Phase „Technische Vorschau“ und wird als Enterprise-Feature lizenziert. Wenn Sie keine Elastic Enterprise-Lizenz haben, müssen Sie ein Upgrade auf Elastic AI Assistant für Observability vornehmen, um auf das Feature zugreifen zu können.

Ihr Feedback zählt! Nutzen Sie bitte das Feedback-Formular im Elastic AI Assistant, die Discuss-Foren (mit den Tags „AI Assistant“ oder „AIOps“) und/oder die Elastic-Community auf Slack (#observability-ai-assistant).

Zu guter Letzt möchten wir noch einmal darauf hinweisen, dass sich das Feature aktuell noch in der Phase „Technische Vorschau“ befindet. Aufgrund der Art und Weise, wie LLMs funktionieren, kann es zuweilen passieren, dass der Assistant nicht das tut, was von ihm erwartet wird. Er kann auch in eigentlich identischen Situationen unterschiedlich reagieren. Mitunter behauptet er auch, nicht helfen zu können, obwohl er die Antwort auf die gestellte Frage eigentlich kennen müsste.

Wir arbeiten daran, den Assistant fehlerfreier, vorhersehbarer und insgesamt besser zu machen – bleiben Sie also dran, es lohnt sich!

Jetzt ausprobieren

Mehr über diese Funktionen und alles rund um den Elastic AI Assistant erfahren Sie auf unserer Elastic AI Assistant-Seite oder in den Versionshinweisen.

Wenn Sie bereits Elastic Cloud-Kunde sind, können Sie direkt in der Elastic Cloud-Konsole auf viele dieser Features zugreifen. Nutzen Sie Elastic noch nicht in der Cloud? Jetzt kostenlos ausprobieren.

Die Entscheidung über die Veröffentlichung von Features oder Leistungsmerkmalen, die in diesem Blogpost beschrieben werden, oder über den Zeitpunkt ihrer Veröffentlichung liegt allein bei Elastic. Es ist möglich, dass nicht bereits verfügbare Features oder Leistungsmerkmale nicht rechtzeitig oder überhaupt nicht veröffentlicht werden.

In diesem Blogeintrag haben wir möglicherweise generative KI-Tools von Drittanbietern verwendet oder darauf Bezug genommen, die von ihren jeweiligen Eigentümern betrieben werden. Elastic hat keine Kontrolle über die Drittanbieter-Tools und übernimmt keine Verantwortung oder Haftung für ihre Inhalte, ihren Betrieb oder ihre Anwendung sowie für etwaige Verluste oder Schäden, die sich aus Ihrer Anwendung solcher Tools ergeben. Gehen Sie vorsichtig vor, wenn Sie KI-Tools mit persönlichen, sensiblen oder vertraulichen Daten verwenden. Alle Daten, die Sie eingeben, können für das Training von KI oder andere Zwecke verwendet werden. Es gibt keine Garantie dafür, dass Informationen, die Sie bereitstellen, sicher oder vertraulich behandelt werden. Setzen Sie sich vor Gebrauch mit den Datenschutzpraktiken und den Nutzungsbedingungen generativer KI-Tools auseinander.

Elastic, Elasticsearch, ESRE, Elasticsearch Relevance Engine und zugehörige Marken, Waren- und Dienstleistungszeichen sind Marken oder eingetragene Marken von Elastic N.V. in den USA und anderen Ländern. Alle weiteren Marken- oder Warenzeichen sind eingetragene Marken oder eingetragene Warenzeichen der jeweiligen Eigentümer.