Migration von Splunk zum Elastic Stack: Datenmigration

Als Splunk vor beinahe 20 Jahren das Licht der Welt erblickte, konnten viele Unternehmen zum ersten Mal das Potenzial ihrer Logdaten für die Gewinnung von Geschäftseinblicken nutzen, wobei die Abrechnung nach dem täglich ingestierten Datenvolumen erfolgte. In den letzten zwei Jahrzehnten haben die Menge und Vielfalt der von Systemen und Nutzern generierten Daten und das Tempo ihrer Generierung rasant zugenommen. Die Anforderungen von geschäftlicher und operativer Seite sind schnell über das hinausgewachsen, was für Compliance und einfache Berichte erforderlich ist. Für Entwicklungsmethodiken und das Monitoring gelten heute gänzlich andere Anforderungen und die immer größere Nachfrage nach Machine-Learning-Funktionen für Dateneinblicke setzt Echtzeitsuchen voraus.

Unternehmen kommen an ihre Datengrenzen

Für die Gewinnung von Echtzeiteinblicken in die Betriebsabläufe, für Machine-Learning-Zwecke und das schnelle Skalieren müssen Unternehmen heute in der Lage sein, in Millisekunden Petabytes an Daten zu durchsuchen. Da Splunk anhand der Menge der ingestierten Daten abrechnet, ist das Produkt mittlerweile für viele unerschwinglich geworden. Dies und die Probleme beim Skalieren der Technologie bringen viele Unternehmen an ihre Grenzen. Das geht so weit, dass sie es sich oftmals nicht mehr leisten können, ihren Systemen weitere Daten hinzuzufügen, sodass sie auf wertvolle Daten für Security- und Observability-Anwendungsfälle verzichten müssen. Verkompliziert wird die Lage noch dadurch, dass für die Premium-Anwendungen von Splunk ein anderes Preismodell gilt und einige dieser Anwendungen auf komplett anderen Plattformen und Architekturen aufbauen, was nicht nur die Kostenprognose, sondern auch die Verwaltung der Infrastruktur für diese völlig verschiedenen Tools erschwert. Auch die kürzlich verkündete Einstellung der Dauerlizenzen hat viele Unternehmen veranlasst, sich nach einer neuen Lösung umzusehen.

Der Anwendungsfall, für den Elastic ursprünglich entwickelt wurde, war die Suche – Elastic ist also seit jeher auf Tempo und Skalierbarkeit ausgerichtet. Tempo und Skalierbarkeit bilden auch die Grundprämisse für die wachsende Familie von Lösungsangeboten, die allesamt auf einem gemeinsamen Stack aufbauen. Das flexible, auf Open Source basierende Lizenzierungsmodell sowie eine faire, ressourcenbasierte Preisgestaltung für Premium-Angebote ist für immer mehr Unternehmen so überzeugend, dass sie sich für den Umstieg von Splunk auf Elastic entscheiden.

Eines der Schlüssel-Features von Elastic ist das Open-Source-basierte Lizenzierungsmodell, mit dem neue Nutzer einsteigen können, ohne zuvor eine Lizenz erwerben zu müssen. Die Lizenz bietet recht viele Freiheiten und erlaubt es Entwicklern sogar, Elasticsearch in ihr eigenes Angebot zu integrieren. Sobald Premium-Features wie Machine Learning, APM, Cluster-übergreifende Replikation, Endpoint Security oder Orchestrierungs-Tools benötigt werden, reicht ein einfaches Lizenz-Upgrade. Zusätzliche Tools werden genauso wenig benötigt wie separate Architekturen oder Extra-Hardware. Das Open-Source-Modell hilft auch, die Kosten im Griff zu halten, die mit der Verwaltung eigener Umgebungen für Entwicklung, Staging und Produktion verbunden sind.

Migration von Splunk-Daten auf Elastic in vier Schritten

Die einzigartigen Vorzüge von Elastic sind für viele Unternehmen Grund genug, Splunk den Rücken zu kehren. Dabei werden wir immer wieder gefragt, ob wir Best Practices für die Migration bereitstellen können. Natürlich ist es bei so einer Migration von einer Datenplattform auf eine andere niemals mit einem einfachen Knopfdruck getan, aber es gibt ein paar einfache Dinge, die man als Unternehmen beachten sollte.

Phase 1: Identifizieren von Datenquellen, die nicht in Splunk ingestiert werden

Als Erstes gilt es, sich einen Überblick darüber zu verschaffen, welche Daten wegen der Kosten (Lizenzierung) oder wegen technischer Beschränkungen nicht in Splunk erfasst werden. Das sind häufig Daten aus Quellen mit hohem Datenaufkommen, wie DNS, DHCP, Endpunkten und Anwendungslogs. Unternehmen, die mit dem Ingestieren von Daten aus diesen bislang brach liegenden Datenquellen beginnen, können so neue Anwendungsfälle entwickeln und gleichzeitig die ersten Schritte mit dem Elastic Stack wagen. Für den schnellen Einstieg können Sie die kostenlose Basic-Distribution des Elastic Stack herunterladen oder den Elasticsearch Service auf Elastic Cloud kostenlos testen.

Phase 2: Inventarisieren der Datenquellen, die von Splunk nach Elastic migriert werden sollen

Für eine angemessene Planung der Migration zu Elastic ist es wichtig, sich einen Überblick darüber zu verschaffen, welche Daten aktuell in Splunk ingestiert werden. Dies lässt sich beispielsweise anhand einer SPL-Abfrage bewerkstelligen:

| eventcount summarize=false index=* index=_* | dedup index | fields index | map maxsearches=100 search="|metadata type=sourcetypes index=\"$index$\" | eval index=\"$index$\"" | fields index sourcetype

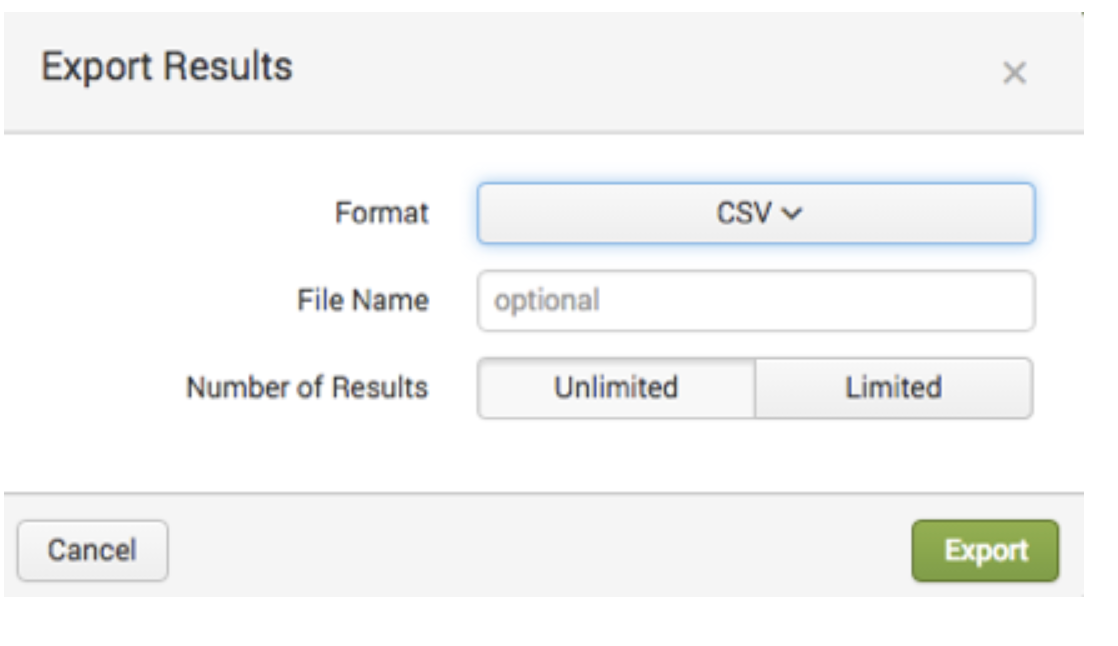

Die Liste der Datenquellen, die bei der Ausführung der Abfrage in der Suche-Anwendung von Splunk ausgegeben wird, kann in verschiedenen Formaten exportiert werden.

Phase 3: Migrieren bestehender Datenflüsse von Splunk zu Elastic

Elastic bietet mit Beats eine Familie von Daten-Shippern, die das Senden von Daten aus Tausenden von Systemen an Elastic ermöglichen. Viele Splunk-Nutzer dürften jedoch bereits Zugriff auf den Splunk-eigenen Universal Forwarder haben. Sie können den Splunk Universal Forwarder nutzen, um für die Migration eine Gabelung der Daten zum Elastic Stack einzurichten. Leider erschwert Splunk durch technische und lizenzrechtliche Beschränkungen das Senden von Daten über den Universal Forwarder an Drittsysteme. Daher ist es ratsam, sich in der Dokumentation und den Lizenzierungsbestimmungen über die beste Methode zu informieren. Später sollten Sie den Universal Forwarder durch Beats-Module ersetzen, um in den Genuss von mehr Flexibilität, Sicherheit und Zuverlässigkeit zu kommen. Das Elastic Consulting-Team verfügt über viel Erfahrung bei der Arbeit mit schwierigen und spezifischen Datenquellen und kann Ihnen bei Ihrem Migrationsprozess helfen.

Phase 4: Migrieren alter Daten von Splunk zu Elastic

Auch wenn die meisten Unternehmen lieber mit frischen Daten starten, gibt es doch häufig Anwendungsfälle, die eine Migration alter Daten in Splunk zu Elastic erforderlich machen. Dies kann auf verschiedene Art und Weise geschehen. Welche für Sie die richtige ist, hängt von der Datenmenge ab. Die einfachste Methode ist, die Daten von der Splunk-Benutzeroberfläche aus zu exportieren. Wie das geht, wird in der Splunk-Dokumentation beschrieben.

Sie können zum Exportieren von Daten auch die Splunk-API nutzen oder es über eine ODBC-Verbindung probieren. Die jeweils optimale Methode hängt vom Anwendungsfall, von der Datenmenge und vom Typ der Daten ab.

Good Migrations

Diese vier Schritte helfen Ihrem Unternehmen, die Migration von Daten von Splunk zu Elastic zu planen und auszuführen, entbinden Sie aber nicht von der Notwendigkeit, Ihr Team zu schulen. Zu diesem Zweck haben wir die Schulung „Kibana für Splunk-SPL-Nutzer“ im Angebot, die Ihrem Team hilft, die Umstellung zu meistern. Daneben bieten wir auch Consulting-Dienste zur Unterstützung des Migrationsprozesses an. Wenn es Sie interessiert, wie andere Unternehmen den Umstieg von Splunk zu Elastic geschafft haben und jetzt von einem besseren ROI, einem höheren Tempo und einer verbesserten Skalierbarkeit profitieren, lesen Sie die Erfolgsgeschichte des Fahrtdienstvermittlers Lyft. Außerdem empfehlen wir Ihnen, sich auf unserer Webseite zum Umstieg von Splunk auf Elastic umzusehen. Und wenn Sie Fragen haben, kontaktieren Sie uns. Wir helfen gern.